魔搭大模型平台-ModelScope

专用API

【更新时间: 2024.06.20】

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!

|

浏览次数

125

采购人数

0

试用次数

0

SLA: N/A

SLA: N/A

响应: N/A

响应: N/A

适用于个人&企业

适用于个人&企业

试用

收藏

×

完成

取消

×

书签名称

确定

|

- API详情

- 定价

- 使用指南

- 常见 FAQ

- 关于我们

- 相关推荐

什么是ModelScope的魔搭大模型平台?

什么是ModelScope的魔搭大模型平台接口?

ModelScope的魔搭大模型平台有哪些核心功能?

- 丰富的预训练SOTA模型

覆盖NLP、CV、Audio等多领域的具有竞争力的SOTA模型,更有行业领先的多模态大模型,全部免费开放下载以及使用。

- 多元开放的数据集

汇集行业和学术热门的公开数据集,更有阿里巴巴集团贡献的专业领域数据集等你来探索。

- 一行代码使用模型推理能力

提供基于模型的本地推理接口,以及线上模型推理预测服务,方便开发者快速验证与使用。

- 十行代码快速构建专属行业模型

十几行代码实现对预训练模型的微调训练(finetune),方便开发者基于行业数据集快速构建专属行业模型。

- 即开即用的在线开发平台

一键开启在线Notebook实训平台,集成官方镜像免除环境安装困扰,链接澎湃云端算力,体验便捷的交互式编程。

- 灵活的模型框架与部署方式

兼容主流AI框架,更好地实现模型迁移;多种模型训练与服务部署方式,提供更多自主可控的选择。

- 丰富的教学内容与技术资源

提供友好的优质的教程内容与开放的社区氛围,帮助开发者学习成长。(内容持续更新中,敬请关注)

ModelScope的魔搭大模型平台的核心优势是什么?

-

丰富的预训练模型库

- 海量模型:平台提供了大量预训练模型,涵盖计算机视觉、自然语言处理、语音识别等多个领域,用户可以根据需求选择合适的模型。

- 持续更新:模型库不断更新,及时引入最新的研究成果和技术,确保用户使用的是最先进的模型。

-

易用性

- 一站式平台:集模型开发、训练、部署和管理于一体,提供简洁明了的用户界面,方便开发者快速上手。

- 低代码/无代码:支持低代码或无代码的开发方式,即使没有深厚的编程基础,也能轻松构建AI应用。

- 零门槛在线开发环境:提供Notebook在线开发环境,无需安装任何本地环境,快速开始开发。

-

高效的模型训练

- 强大的计算资源:利用阿里云强大的计算资源,支持大规模分布式训练,加速模型训练过程。

- 自动调优:提供自动超参数调优功能,帮助开发者快速找到最佳模型配置,提高训练效率。

- 免费算力支持:长期免费提供CPU资源,初始提供100小时的免费GPU算力,降低开发成本。

-

灵活的部署方式

- 多样化部署:支持云端、边缘和本地多种部署方式,满足不同应用场景的需求。

- 便捷集成:提供丰富的API和SDK,方便将模型集成到现有系统和应用中,实现快速部署。

-

强大的数据管理

- 数据处理工具:提供数据预处理、清洗、标注等工具,帮助用户高效管理和处理数据。

- 数据安全:通过多重安全措施,确保数据在存储和传输过程中的安全性。

-

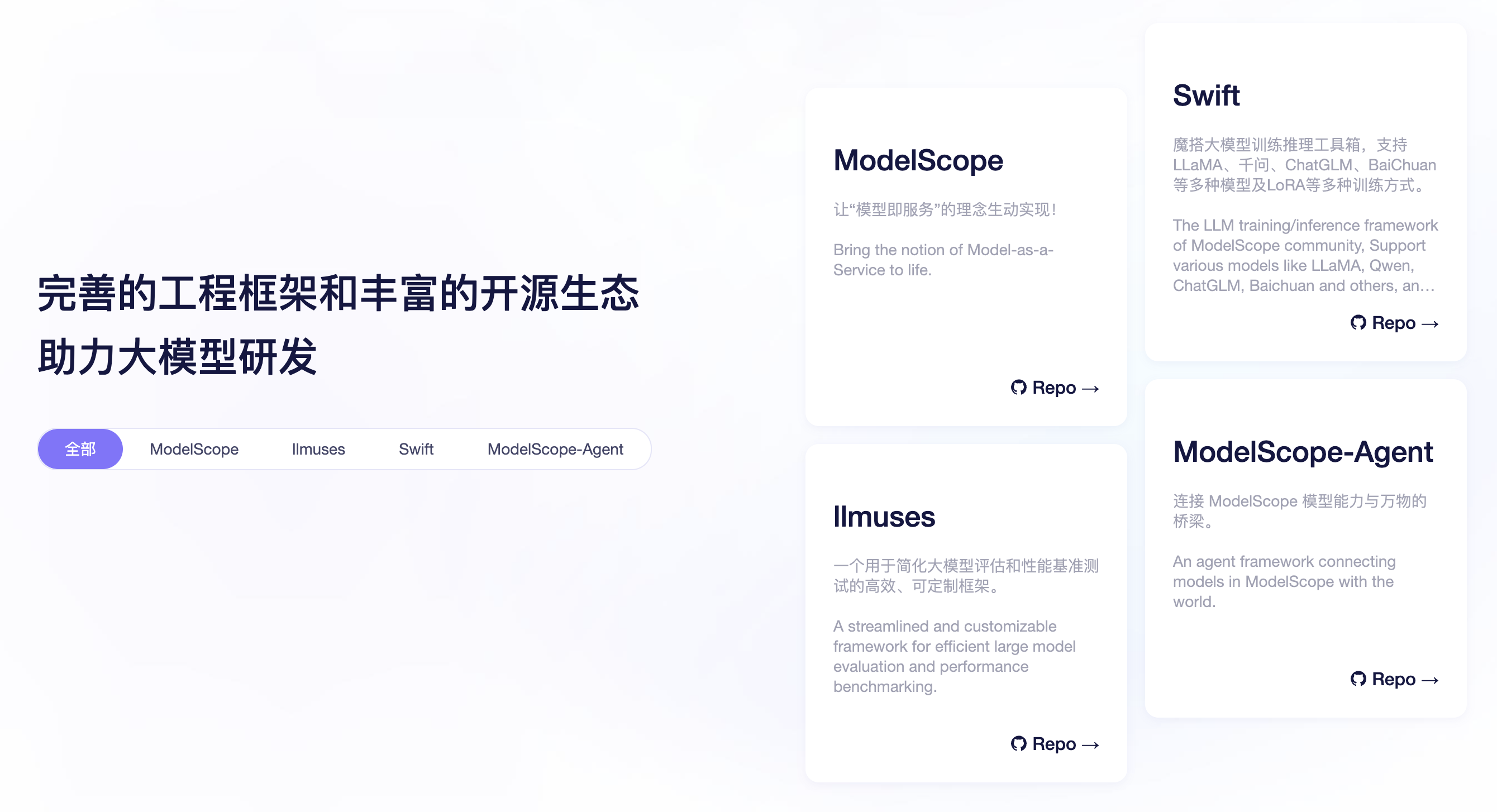

完善的工程框架和开源生态

- 助力大模型研发:提供完善的工程框架和工具链,支持大模型的研发和优化。

- 开源生态:丰富的开源项目和社区支持,促进技术交流和合作。

-

全面的支持与服务

- 技术支持:提供专业的技术支持团队,帮助用户解决在使用过程中的各种问题。

- 社区与生态:建立活跃的开发者社区,用户可以在社区中交流经验、分享成果,并获取最新的技术资讯。

-

模型即服务

- 模型即服务:通过ModelScope平台,将“模型即服务”(Model-as-a-Service)的理念生动实现,用户可以像使用服务一样方便地使用和管理AI模型。

-

成本效益

- 按需付费:灵活的计费模式,根据使用的资源量按需付费,帮助用户有效控制成本。

- 资源优化:通过资源调度和优化,最大化利用计算资源,提高性价比。

在哪些场景会用到ModelScope的魔搭大模型平台?

1.自然语言处理 (NLP):ModelScope允许开发人员使用各种NLP模型,如机器翻译,问答,文本摘要和文本分类。

2.计算机视觉:ModelScope允许开发人员使用各种计算机视觉模型,例如图像识别,物体检测和图像分类。

3.推荐系统:ModelScope允许开发人员使用各种推荐系统模型,例如个性化推荐,基于内容和基于关系的推荐。

4.时间序列预测:ModelScope允许开发人员使用各种时间序列预测模型,例如预测未来的销售量,交通流量或股票价格。

5.语音识别:ModelScope允许开发人员使用各种语音识别模型,例如语音转文本或文本转语音。

6.生物信息学:ModelScope允许开发人员使用各种生物信息学模型,例如基因序列分析,蛋白质折叠和药物设计。

7.金融:ModelScope允许开发人员使用各种金融模型,例如风险评估,证券定价和投资组合优化。

8.人工智能助手:ModelScope允许开发人员使用各种人工智能助手模型,例如自然语言理解,语音识别和自动问答。

新注册用户限时赠送100小时免费GPU算力哦!

包含100小时32GB显存GPU+长期免费CPU计算资源

如果你是新手,想快速体验产品, 请参阅本文快速开始。快速开始包含基础概念知识和环境安装指南,可帮助你快速启动并运行ModelScope Library;

如果你准备好环境,想要进一步探索ModelScope Library的模型使用,请参阅ModelScope Library教程。该模块将帮你获得平台使用所需的基础使用和教学指导;

如果你对特定的模型感兴趣,并想了解该模型的推理、训练等过程,请参阅模型介绍。该模块将进一步介绍针对特定模型的最佳实践说明;

如果你对特定的任务感兴趣,并想了解该任务的推理、训练、导出及可用模型等信息,请参阅各任务最佳实践。该模块将介绍针对特定任务的端到端使用说明;

如果你对**大模型(LLM)和AIGC(Stable Diffusion)**的训练推理感兴趣,请参考Swift使用指南,大模型训练与推理,文生图训练与推理。

如果你想成为社区的贡献者,请参阅贡献者指南。该模块介绍作为社区贡献者您所需要具备的基础知识、平台的设计规范和使用说明。我们非常欢迎您成为社区的贡献者分享您的内容,在成为贡献者之前,请您仔细阅读开源行为准则,共同为推进绿色社区助力!

详细入门文档: https://modelscope.cn/docs/%E5%BF%AB%E9%80%9F%E5%BC%80%E5%A7%8B

新注册用户限时赠送100小时免费GPU算力哦!

包含100小时32GB显存GPU+长期免费CPU计算资源

如果你是新手,想快速体验产品, 请参阅本文快速开始。快速开始包含基础概念知识和环境安装指南,可帮助你快速启动并运行ModelScope Library;

如果你准备好环境,想要进一步探索ModelScope Library的模型使用,请参阅ModelScope Library教程。该模块将帮你获得平台使用所需的基础使用和教学指导;

如果你对特定的模型感兴趣,并想了解该模型的推理、训练等过程,请参阅模型介绍。该模块将进一步介绍针对特定模型的最佳实践说明;

如果你对特定的任务感兴趣,并想了解该任务的推理、训练、导出及可用模型等信息,请参阅各任务最佳实践。该模块将介绍针对特定任务的端到端使用说明;

如果你对**大模型(LLM)和AIGC(Stable Diffusion)**的训练推理感兴趣,请参考Swift使用指南,大模型训练与推理,文生图训练与推理。

如果你想成为社区的贡献者,请参阅贡献者指南。该模块介绍作为社区贡献者您所需要具备的基础知识、平台的设计规范和使用说明。我们非常欢迎您成为社区的贡献者分享您的内容,在成为贡献者之前,请您仔细阅读开源行为准则,共同为推进绿色社区助力!

详细入门文档: https://modelscope.cn/docs/%E5%BF%AB%E9%80%9F%E5%BC%80%E5%A7%8B