AI人工智能发展历史

在过去的十年里,人工智能(AI)领域经历了翻天覆地的变化,特别是大规模语言模型的飞速发展,使得公众几乎将AI与这些庞大的模型划上了等号。为了深入理解这些技术之间的联系和差异,我们需要从AI的发展历史着手,探索不同技术的演进路径,以便对当前的热门技术如巨型语言模型、智能识别、计算机视觉、AI创作、AI代理、RAG等有一个基本的认识。

一、AI发展历史

回顾AI的发展历程,我们可以将其大致划分为六个主要阶段。尽管对于这一历史分期存在一些争议,但这并不影响我们对AI发展脉络的把握。这种分期方法主要是基于神经网络模型的演化来进行的。实际上,模型的发展与技术创新密切相关,并且与计算机的计算能力有着直接的联系。例如,在神经网络最初被提出时,许多学者对此表现出极大的兴趣,但由于当时计算能力的限制,AI的发展经历了一段漫长的停滞期。

.explinks.com/wp-content/uploads/2024/06/image-690.png)1、人工智能起步发展期:1943年—20世纪60年代

2、人工智能反思发展期:20世纪70年代

3、人工智能应用发展期:20世纪80年代

4、人工智能平稳发展期:20世纪90年代—2010年

5、人工智能蓬勃发展期:2011年-2018年

6、LLM繁荣发展期:2018年-2023年

1、AI发展历史起步发展期:1943年—20世纪60年代

自从人工智能(AI)这个概念被提出,它就逐渐分化为两大主要学派:符号主义和联结主义(神经网络),并取得了一系列重要的科学成果,例如机器证明定理、下棋程序和人机对话等,这些都推动了人工智能历史上的第一个发展高潮。

1943年,美国神经科学家沃伦·斯特·麦卡洛克和逻辑学家沃尔特·皮茨提出了神经元的数学模型,为现代人工智能学科的建立奠定了基础。

1950年,艾伦·图灵提出了著名的“图灵测试”,使得机器智能的概念开始被广泛认知。同年,克劳德·香农提出了计算机下棋的构想。

1956年,在达特茅斯学院的夏季研讨会上,“人工智能”这一术语被正式提出,标志着人工智能作为一个独立学科的诞生。

1957年,弗兰克·罗森布拉特在IBM-704计算机上实现了他发明的“感知机”模型,这是早期神经网络研究的一个重要里程碑。

1958年,大卫·考克斯提出了逻辑回归模型,这是一种线性分类模型,结构与感知机相似,但使用了Sigmoid激活函数,目的是最大化分类的准确性。

1959年,亚瑟·塞缪尔首次定义了机器学习:一个旨在让计算机能够自主学习而无需显式编程的研究领域。

1961年,伦纳德·乌尔和查尔斯·沃斯勒发表了一篇关于模式识别的论文,描述了他们尝试利用机器学习或自组织过程来设计模式识别程序。

1965年,I.J. 古德提出了“AI威胁论”,警告说机器的超级智能可能会超出人类的控制,这一观点后来被多位科学家进一步探讨。

1966年,麻省理工学院的约瑟夫·魏岑鲍姆开发了ELIZA程序,使得人与计算机之间的自然语言对话成为可能,ELIZA通过关键词匹配规则来生成回复。

1967年,托马斯等人提出了K最近邻(KNN)算法,这是一种基于实例最近邻数据的分类方法。

1968年,爱德华·费根鲍姆提出了首个专家系统DENDRAL,并定义了“知识库”这一概念。该系统在化学领域拥有丰富的知识,能够通过质谱数据推断分子结构,这标志着人工智能史上第二次浪潮的开始。

1969年,马文·明斯基在其著作《感知器》中提出了XOR问题,指出单层感知器无法解决XOR这类线性不可分问题,这一发现导致神经网络研究进入了一个长达十年的低谷期。

2、AI发展历史反思发展期:20世纪70年代

在人工智能的早期发展阶段,尽管取得了一些突破性的成果,但在尝试解决更复杂问题时,受限于当时的计算能力限制和理论发展的不足,许多预期的目标未能实现,导致人工智能领域经历了一个相对平静的时期。

1974年,哈佛大学的保罗·沃博斯在其博士论文中首次提出了利用误差反向传播(BP算法)来训练人工神经网络的理论。尽管这一时期的研究并未受到广泛关注,但BP算法的核心思想是利用误差的导数(梯度)来调整权重,以期逐步减少误差,最终使网络具备“万能近似”的能力。

1975年,马文·明斯基在论文《框架理论》中提出了知识表示的学习框架,这成为了人工智能研究的一个关键转折点。

1976年,兰德尔·戴维斯致力于开发和维护庞大的知识库,并提出通过集成面向对象的模型可以增强知识库的开发、维护和应用的一致性。同年,斯坦福大学的爱德华·肖特利夫等开发了首个用于诊断和治疗血液感染的医疗专家系统MYCIN。

同年,斯坦福大学的勒纳特发表了论文《启发式搜索在数学中的应用》,介绍了一个名为“AM”的程序,该程序利用大量启发式规则来探索新的数学概念,并重新发现了数百个数学中的标准概念和定理。

1977年,海斯·罗思等人开发的基于逻辑的机器学习系统取得了初步进展,尽管当时它只能学习单一概念,还未能在实际应用场景中广泛使用。

1979年,汉斯·贝利纳开发的计算机程序在双陆棋比赛中战胜了世界冠军,这一成就标志着人工智能发展的一个重要里程碑。随后,在罗德尼·布鲁克斯和其他人的努力下,基于行为的机器人学迅速崛起,成为人工智能的一个重要分支。同时,格瑞·特索罗开发的自学双陆棋程序也为后来的强化学习研究奠定了基础。

3、AI发展历史应用发展期:20世纪80年代

人工智能的发展进入了一个新的高峰期,这标志着其历史上又一个快速增长阶段。专家系统通过模仿人类专家的知识和经验来解决特定领域的问题,实现了人工智能从理论探索到实际应用、从一般推理策略的讨论到专门知识应用的重大转变。同时,机器学习(尤其是神经网络)探索了不同的学习策略和各种学习方法,并在众多实际应用中逐步恢复活力。

1980年,卡内基梅隆大学(CMU)举办了首届机器学习国际研讨会,这标志着机器学习研究在全球范围内的兴起。

同年,德鲁·麦迪蒙和乔恩·多伊尔提出了非单调逻辑,以及随后的机器人系统。

1980年,卡耐基梅隆大学为DEC公司开发了XCON专家系统,该系统每年为公司节省了四千万美元,取得了巨大成功。

1981年,R.P. Paul出版了第一本机器人学教科书《机器人操纵器:数学、编程和控制》,这标志着机器人学科的成熟。

1982年,大卫·马尔发表了他的代表作《视觉计算理论》,提出了计算机视觉的概念,并构建了系统的视觉理论,对认知科学产生了深远影响。

同年,约翰·霍普菲尔德发明了霍普菲尔德网络,这是最早的递归神经网络(RNN)的原型。霍普菲尔德神经网络模型是一种单层反馈神经网络,具有从输出到输入的反馈连接,它的出现极大地激发了神经网络领域的兴趣。

1983年,特伦斯·谢诺夫斯基和杰弗里·欣顿等人发明了玻尔兹曼机,也称为随机霍普菲尔德网络,这是一种无监督模型,用于对输入数据进行重构以提取数据特征进行预测分析。

1985年,朱迪亚·珀尔提出了贝叶斯网络,他以倡导人工智能的概率方法和发展贝叶斯网络而闻名,还因发展了一种基于结构模型的因果和反事实推理理论而受到赞誉。贝叶斯网络是一种模拟人类推理过程中因果关系的不确定性处理模型,如常见的朴素贝叶斯分类算法就是贝叶斯网络最基本的应用。

1986年,罗德尼·布鲁克斯发表了论文《移动机器人鲁棒分层控制系统》,这标志着基于行为的机器人学科的创立,机器人学界开始关注实际工程主题。

同年,杰弗里·欣顿等人提出了多层感知器(MLP)与反向传播(BP)训练相结合的理念,解决了单层感知器无法进行非线性分类的问题,开启了神经网络的新高潮。

同年,罗斯·昆兰提出了ID3决策树算法。决策树模型可视为多个规则的组合,与神经网络的黑盒模型不同,它具有良好的模型解释性。ID3算法的核心思想是通过自顶向下的贪心策略构建决策树,根据信息增益来选择特征进行划分。

1989年,乔治·西本科证明了“万能近似定理”,简单来说,多层前馈网络可以近似任意函数,其表达力与图灵机等价,从根本上消除了对神经网络表达力的质疑。

同年,扬·勒丘恩结合反向传播算法与权值共享的卷积神经层发明了卷积神经网络(CNN),并首次将CNN成功应用于美国邮局的手写字符识别系统中。CNN通常由输入层、卷积层、池化层和全连接层组成,卷积层负责提取图像中的局部特征,池化层用于降低参数量级,全连接层则输出结果。

4、AI发展历史平稳发展期:20世纪90年代—2010年

互联网技术的迅猛发展极大地推动了人工智能领域的创新研究,使得AI技术变得更加实用,人工智能的各个分支都取得了显著的进步。在2000年代初,由于专家系统需要编码大量明确的规则,这不仅降低了效率还增加了成本,因此人工智能研究的重点从基于知识系统转向了机器学习,这是AI发展史上的一个重大转变。

1995年,Cortes和Vapnik提出了支持向量机(SVM),它在处理小样本、非线性及高维模式识别问题时展现了显著的优势,并能扩展到函数拟合等其他机器学习问题。SVM是在感知机基础上的改进,基于统计学习理论的VC维理论和结构风险最小化原则,与感知机的主要区别在于SVM寻找的是最大化样本间隔的超平面,具有更强的泛化能力,并通过核函数处理线性不可分问题。

同年,Freund和Schapire提出了AdaBoost算法,这是一种Boosting集成学习方法,通过串行组合弱学习器来提升泛化性能。与Bagging方法不同,Boosting主要优化偏差。

1997年,IBM的深蓝超级计算机战胜了国际象棋世界冠军加里·卡斯帕罗夫,深蓝通过穷举所有可能的走法并执行深度搜索来实现智能。

同年,Sepp Hochreiter和Jürgen Schmidhuber提出了长短期记忆网络(LSTM),这是一种复杂的循环神经网络,通过引入遗忘门、输入门和输出门来解决长序列训练中的梯度消失问题。

1998年,蒂姆·伯纳斯-李提出了语义网的概念,目的是通过添加计算机可理解的语义元数据,使互联网成为一个基于语义链接的通用信息交换媒介。

2001年,John Lafferty提出了条件随机场模型(CRF),这是一种基于贝叶斯理论的判别式概率图模型,在自然语言处理任务中表现出色。

同年,布雷曼博士提出了随机森林算法,这是一种通过Bagging并行组合多个有差异的弱学习器来优化泛化性能的集成学习方法。

2003年,David Blei, Andrew Ng和Michael I. Jordan提出了LDA,这是一种无监督学习方法,用于推测文档的主题分布。

同年,Google发表了三篇大数据领域的奠基性论文,为大数据存储和分布式处理提供了理论基础。

2005年,波士顿动力公司推出了一款具有动力平衡的四足机器狗,能够适应复杂地形。

2006年,杰弗里·辛顿和他的学生鲁斯兰·萨拉赫丁诺夫正式提出了深度学习的概念,开启了深度学习在学术界和工业界的浪潮,辛顿也因此被誉为深度学习之父。深度学习使用多层隐藏层网络结构,通过大量的向量计算来学习数据的高阶表示。

2010年,Sinno Jialin Pan和Qiang Yang发表了关于迁移学习的调查文章。迁移学习是利用已有知识(如训练好的网络权重)来学习新知识以适应特定目标任务的方法,核心在于找到已有知识和新知识之间的相似性。

5、AI发展历史蓬勃发展期:2011年-2018年

随着大数据、云计算、互联网、物联网等信息技术的发展,泛在感知数据和图形处理器等计算平台推动以深度神经网络为代表的人工智能技术飞速发展,大幅跨越了科学与应用之间的技术鸿沟,诸如图像分类、语音识别、知识问答、人机对弈、无人驾驶等人工智能技术实现了重大的技术突破,迎来人工智能发展史上首次爆发式增长的新高潮,大批智能识别企业及应用由此诞生。

2011年,IBM Watson问答机器人参与Jeopardy回答测验比赛最终赢得了冠军。Waston是一个集自然语言处理、知识表示、自动推理及机器学习等技术实现的电脑问答(Q&A)系统。

2012年,Hinton和他的学生Alex Krizhevsky设计的AlexNet神经网络模型在ImageNet竞赛大获全胜,这是史上第一次有模型在 ImageNet 数据集表现如此出色,并引爆了神经网络的研究热情。

AlexNet是一个经典的CNN模型,在数据、算法及算力层面均有较大改进,创新地应用了Data Augmentation、ReLU、Dropout和LRN等方法,并使用GPU加速网络训练。

2012年,谷歌正式发布谷歌知识图谱Google Knowledge Graph),它是Google的一个从多种信息来源汇集的知识库,通过Knowledge Graph来在普通的字串搜索上叠一层相互之间的关系,协助使用者更快找到所需的资料的同时,也可以知识为基础的搜索更近一步,以提高Google搜索的质量。知识图谱是结构化的语义知识库,是符号主义思想的代表方法,用于以符号形式描述物理世界中的概念及其相互关系。其通用的组成单位是RDF三元组(实体-关系-实体),实体间通过关系相互联结,构成网状的知识结构。

2013年,Durk Kingma和Max Welling在ICLR上以文章《Auto-Encoding Variational Bayes》提出变分自编码器(Variational Auto-Encoder,VAE)。

VAE基本思路是将真实样本通过编码器网络变换成一个理想的数据分布,然后把数据分布再传递给解码器网络,构造出生成样本,模型训练学习的过程是使生成样本与真实样本足够接近。

2013年,Google的Tomas Mikolov 在《Efficient Estimation of Word Representation in Vector Space》提出经典的 Word2Vec模型用来学习单词分布式表示,因其简单高效引起了工业界和学术界极大的关注。

Word2Vec基本的思想是学习每个单词与邻近词的关系,从而将单词表示成低维稠密向量。通过这样的分布式表示可以学习到单词的语义信息,直观来看,语义相似的单词的距离相近。

Word2Vec网络结构是一个浅层神经网络(输入层-线性全连接隐藏层->输出层),按训练学习方式可分为CBOW模型(以一个词语作为输入,来预测它的邻近词)或Skip-gram模型 (以一个词语的邻近词作为输入,来预测这个词语)。

2014年,聊天程序“尤金·古斯特曼”(Eugene Goostman)在英国皇家学会举行的“2014图灵测试”大会上,首次“通过”了图灵测试。

2014年,Goodfellow及Bengio等人提出生成对抗网络(Generative Adversarial Network,GAN),被誉为近年来最酷炫的神经网络。

GAN是基于强化学习(RL)思路设计的,由生成网络(Generator, G)和判别网络(Discriminator, D)两部分组成, 生成网络构成一个映射函数G: Z→X(输入噪声z, 输出生成的伪造数据x), 判别网络判别输入是来自真实数据还是生成网络生成的数据。在这样训练的博弈过程中,提高两个模型的生成能力和判别能力。

2015年,为纪念人工智能概念提出60周年,深度学习三巨头LeCun、Bengio和Hinton(他们于2018年共同获得了图灵奖)推出了深度学习的联合综述《Deep learning》。

《Deep learning》文中指出深度学习就是一种特征学习方法,把原始数据通过一些简单的但是非线性的模型转变成为更高层次及抽象的表达,能够强化输入数据的区分能力。通过足够多的转换的组合,非常复杂的函数也可以被学习。

2015年,Microsoft Research的Kaiming He等人提出的残差网络(ResNet)在ImageNet大规模视觉识别竞赛中获得了图像分类和物体识别的优胜。

残差网络的主要贡献是发现了网络不恒等变换导致的“退化现象(Degradation)”,并针对退化现象引入了 “快捷连接(Shortcut connection)”,缓解了在深度神经网络中增加深度带来的梯度消失问题。

2015年,谷歌开源TensorFlow框架。它是一个基于数据流编程(dataflow programming)的符号数学系统,被广泛应用于各类机器学习(machine learning)算法的编程实现,其前身是谷歌的神经网络算法库DistBelief。

2015年,马斯克等人共同创建OpenAI。它是一个非营利的研究组织,使命是确保通用人工智能 (即一种高度自主且在大多数具有经济价值的工作上超越人类的系统)将为全人类带来福祉。其发布热门产品的如:OpenAI Gym,GPT等。

2016年,谷歌提出联邦学习方法,它在多个持有本地数据样本的分散式边缘设备或服务器上训练算法,而不交换其数据样本。

联邦学习保护隐私方面最重要的三大技术分别是: 差分隐私 ( Differential Privacy )、同态加密 ( Homomorphic Encryption )和 隐私保护集合交集 ( Private Set Intersection ),能够使多个参与者在不共享数据的情况下建立一个共同的、强大的机器学习模型,从而解决数据隐私、数据安全、数据访问权限和异构数据的访问等关键问题。

2016年,AlphaGo与围棋世界冠军、职业九段棋手李世石进行围棋人机大战,以4比1的总比分获胜。

AlphaGo是一款围棋人工智能程序,其主要工作原理是“深度学习”,由以下四个主要部分组成:策略网络(Policy Network)给定当前局面,预测并采样下一步的走棋;快速走子(Fast rollout)目标和策略网络一样,但在适当牺牲走棋质量的条件下,速度要比策略网络快1000倍;价值网络(Value Network)估算当前局面的胜率;蒙特卡洛树搜索(Monte Carlo Tree Search)树搜索估算每一种走法的胜率。

在2017年更新的AlphaGo Zero,在此前的版本的基础上,结合了强化学习进行了自我训练。它在下棋和游戏前完全不知道游戏规则,完全是通过自己的试验和摸索,洞悉棋局和游戏的规则,形成自己的决策。随着自我博弈的增加,神经网络逐渐调整,提升下法胜率。更为厉害的是,随着训练的深入,AlphaGo Zero还独立发现了游戏规则,并走出了新策略,为围棋这项古老游戏带来了新的见解。

2017年,中国香港的汉森机器人技术公司(Hanson Robotics)开发的类人机器人索菲亚,是历史上首个获得公民身份的一台机器人。索菲亚看起来就像人类女性,拥有橡胶皮肤,能够表现出超过62种自然的面部表情。其“大脑”中的算法能够理解语言、识别面部,并与人进行互动。

6、AI发展历史LLM繁荣发展期:2018年-2023年

这张图很好地展示了近年来大规模语言模型的发展,并突出了其中的一些最知名的模型。同一分支上的模型具有更紧密的关系。

这张图很好地展示了近年来大规模语言模型的发展,并突出了其中的一些最知名的模型。同一分支上的模型具有更紧密的关系。

- 基于变压器的模型以非灰色显示

- 蓝色分支中只有解码器的模型

- 粉色分支中只有编码器的模型

- 绿色的编码器-解码器模型分支

模型在时间轴上的垂直位置表示它们的发布日期。开源模型表示为实心方形,而闭源模型则用空心方形表示。

这些模型在其训练策略、模型架构和应用领域上存在差异。为了更清楚地了解LLM的格局,我们将它们分为两类:仅编码器或编码器-解码器语言模型以及仅解码器语言模型。在图1中,我们展示了语言模型的详细演化过程。从这个进化树中,我们得到一些有趣的观察结果:

a)仅解码器模型逐渐主导了LLM的发展。在LLM发展的早期阶段,仅解码器模型不如仅编码器和编码器-解码器模型受欢迎。然而,在2021年之后,随着具有改变游戏规则的LLM(例如GPT-3)的引入,仅解码器模型经历了显著的发展。与此同时,在BERT带来的最初爆炸性增长之后,仅编码器模型逐渐开始衰落。

b)OpenAI始终在LLM领域保持着领导地位,无论是当前还是未来。其他公司和机构在开发与GPT-3和当前的GPT-4相媲美的模型方面努力迎头赶上OpenAI。这种领导地位可以归因于OpenAI对技术道路的坚定承诺,即使最初并不被广泛认可。

c)Meta在开源LLM方面作出了重要贡献,并促进了LLM的研究。在考虑到对开源社区的贡献,特别是与LLM相关的贡献时,Meta凸显出作为最慷慨的商业公司之一,因为Meta开发的所有LLM都是开源的。

d)LLM呈现出趋向于封闭源的趋势。在LLM发展的早期阶段(2020年之前),大多数模型都是开源的。然而,随着GPT-3的引入,公司越来越倾向于封闭其模型,例如PaLM、LaMDA和GPT-4。因此,学术研究人员在LLM训练上进行实验变得更加困难。因此,基于API的研究可能会成为学术界主要的方法。

e)编码器-解码器模型仍然具有前景,因为这种架构仍在积极探索,而且其中大多数都是开源的。谷歌对开源编码器-解码器架构做出了重大贡献。然而,解码器模型的灵活性和多功能性似乎使得谷歌对此方向的坚持不太具有前景。

二、2000年以来重要的人工智能企业

1、波士顿动力公司(Boston Dynamics)

波士顿动力公司(英语:Boston Dynamics)创办与是一家美国的工程与机器人设计公司,此公司的著名产品包含在国防高等研究计划署(DARPA)出资下替美国军方开发的四足机器人:波士顿机械狗,以及DI-Guy,一套用于写实人类模拟的现成软件(COTS)。此公司早期曾和美国系统公司一同接受来自美国海军航空作战中心训练处(NAWCTSD)的一份合约,该合约的内容是要以DI-Guy人物的互动式3D电脑模拟,取代海军飞机弹射任务训练影片。

该公司由Marc Raibert和其合伙人一起创办。Marc Raibert是著名的机器人学家。其28岁毕业于MIT,随后在CMU担任过副教授,并且在那里建立了CMUleg实验室研究与机器人有关的控制和视觉处理相关的技术。在37岁时回到MIT的继续从事机器人相关的科研和教学工作。在1992年,其与合伙人一起创办了Boston Dynamics这家公司,开启了机器人研究的新纪元。

波士顿动力公司于 2005 年推出一款四足机器人——big Dog ,它被人们亲切地称为 “大狗”,也正是这款四足机器人让波士顿动力公司名声大噪。大狗抛开传统的轮式或履带式机器人,转而研究四足机器人,是因为四足机器人能够适应更多地形地貌,通过性能更强。同时,在波士顿动力公司发布的宣传视频中,Big Dog 在装载着重物的情况下,仍能对人类从其侧面的踢踹做出灵敏的反应,始终保持站立的姿态。

在2013年12月13日,波士顿动力公司被Google收购。2017年6月9日软银以不公开的条款收购谷歌母公司Alphabet旗下的波士顿动力公司。

2、IBM沃森挑战史上最强Jeopardy!

Watson是一种能够回答自然语言提出的问题的问答计算机系统,由主要研究员David Ferrucci领导的研究小组在IBM的DeepQA项目中开发。Watson以IBM的创始人兼第一任首席执行官工业家Thomas J. Watson的名字命名。

最初开发Watson计算机系统是为了回答测验节目 Jeopardy!中的问题,并且在2011年参与Jeopardy比赛与与冠军布拉德·鲁特(Brad Rutter)和肯·詹宁斯(Ken Jennings)竞争。最终赢得了胜利赢得一百万美元的冠军奖金。

3、谷歌自动驾驶汽车(Google self-driving car)

Google的自动驾驶技术开发始于2009年1月17日,一直在在该公司秘密的X实验室中进行,在2010年10月9日《纽约时报》透露其存在之后,当天晚些时候,谷歌通过正式宣布了自动驾驶汽车计划。该项目由斯坦福大学人工智能实验室(SAIL)的前负责人塞巴斯蒂安·特伦(Sebastian Thrun )和510系统公司和安东尼机器人公司的创始人安东尼·莱万多夫斯基(Anthony Levandowski)发起。

在Google工作之前,Thrun和包括Dmitri Dolgov,Anthony Levandowski和Mike Montemerlo在内的15位工程师共同为SAIL开展了名为VueTool的数字地图技术项目。许多团队成员在2005 DARPA大挑战赛上见面,Thrun和Levandowski都有团队竞争自动无人驾驶汽车挑战。在2007年,Google收购了整个VueTool团队,以帮助推进Google的街景技术。

作为街景服务开发的一部分,购买了100辆丰田普锐斯,并配备了莱康多夫斯基公司510 Systems开发的Topcon盒,数字地图硬件。2008年,街景小组启动了“地面真相”项目,目的是通过从卫星和街景中提取数据来创建准确的路线图。这为Google的自动驾驶汽车计划奠定了基础。

2014年5月下旬,Google展示了其无人驾驶汽车的新原型,该汽车无方向盘,油门踏板或制动踏板,并且100%自治。12月,他们展示了一个功能完备的原型,计划从2015年初开始在旧金山湾区道路上进行测试。这款车名Firefly,旨在用作实验平台和学习,而不是大量生产。

2015年,联合创始人Anthony Levandowski和CTO Chris Urmson离开了该项目。2015年8月,Google聘用了现代汽车前高管约翰·克拉夫奇克(John Krafcik)作为首席执行官。 2015年秋天,Google向总工程师纳撒尼尔·费尔菲尔德(Nathaniel Fairfield)的合法盲人朋友提供了“世界上第一个完全无人驾驶的公共道路上的骑行服务” 。这次乘车之旅由得克萨斯州奥斯汀市圣塔克拉拉谷盲中心的前首席执行官史蒂夫·马汉(Steve Mahan)乘车。这是公共道路上的第一个完全无人驾驶的汽车。它没有测试驾驶员或警察护送,也没有方向盘或地板踏板。截至2015年底,这辆汽车已实现超过100万英里的自驾里程。

4、OpenAI

OpenAI,由诸多硅谷大亨联合建立的人工智能非营利组织。2015年马斯克与其他硅谷科技大亨进行连续对话后,决定共同创建OpenAI,希望能够预防人工智能的灾难性影响,推动人工智能发挥积极作用。特斯拉电动汽车公司与美国太空技术探索公司SpaceX创始人马斯克、Y Combinator总裁阿尔特曼、天使投资人彼得·泰尔(Peter Thiel)以及其他硅谷巨头2014年12月份承诺向OpenAI注资10亿美元。

OpenAI的使命是确保通用人工智能 (Artificial General Intelligence, AGI),即一种高度自主且在大多数具有经济价值的工作上超越人类的系统,将为全人类带来福祉。不仅希望直接建造出安全的、符合共同利益的通用人工智能,而且愿意帮助其它研究机构共同建造出这样的通用人工智能以达成他们的使命。

三、AI发展历史关键人物图谱

发展初期:

发展初期:

1943年,美国神经科学家麦卡洛克(Warren McCulloch)和逻辑学家皮茨(Water Pitts)提出神经元的数学模型,这是现代人工智能学科的奠基石之一。

1950年,艾伦·麦席森·图灵(Alan Mathison Turing)提出“图灵测试”(测试机器是否能表现出与人无法区分的智能),让机器产生智能这一想法开始进入人们的视野。

1957年,弗兰克·罗森布拉特(Frank Rosenblatt)在一台IBM-704计算机上模拟实现了一种他发明的叫做“感知机”(Perceptron)的神经网络模型。

1969年,“符号主义”代表人物马文·明斯基(Marvin Minsky)的著作《感知器》提出对XOR线性不可分的问题

高潮期:

2012年,Hinton和他的学生Alex Krizhevsky设计的AlexNet深度卷积神经网络模型在ImageNet竞赛大获全胜,标志着深度学习时代的来临。

2013年,Google的Tomas Mikolov 在《Efficient Estimation of Word Representation in Vector Space》提出经典的 Word2Vec模型用来学习单词分布式表示。

2014年,Goodfellow及Bengio等人提出生成对抗网络(Generative Adversarial Network,GAN),被誉为近年来最酷炫的神经网络。

2018年,谷歌提出了Transformer模型。Transformer凭借其自注意力机制和encoder-decoder架构,在机器翻译、NLP等任务中取得了显著成效。随后的BERT、GPT系列模型更是将Transformer推向了巅峰,引领了自然语言处理领域的变革。

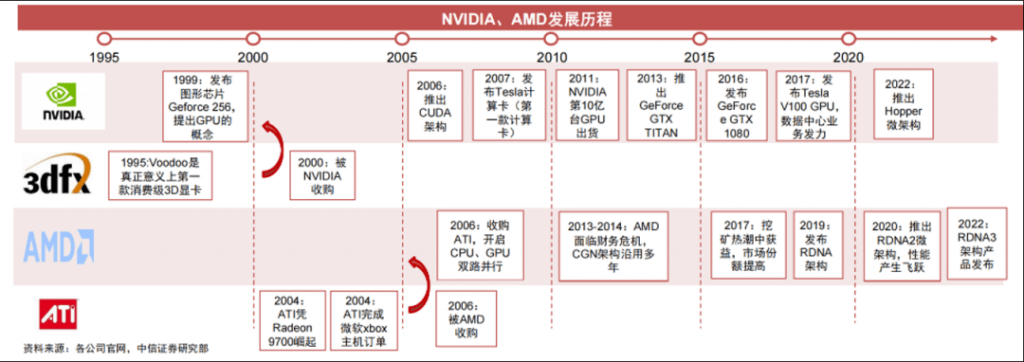

四、AI发展历史LLM繁荣的计算核心:GPU

GPU的定位是并行计算芯片,主要是将其中非常复杂的数学和几何计算抽出,变成一个超高密度、能够并行计算的方式。最初专用于图形处理,后渐渐用于高密度通用计算,包括AI计算。

GPU 的发展源于80年代,IBM是GPU理念的创始者,但它并未坚持。所以真正意义上的第一款GPU是英伟达在1999年发布的Geforce 256,并正式提出一个响亮的名字“Graphics Processing Unit”,这就是GPU的来源。

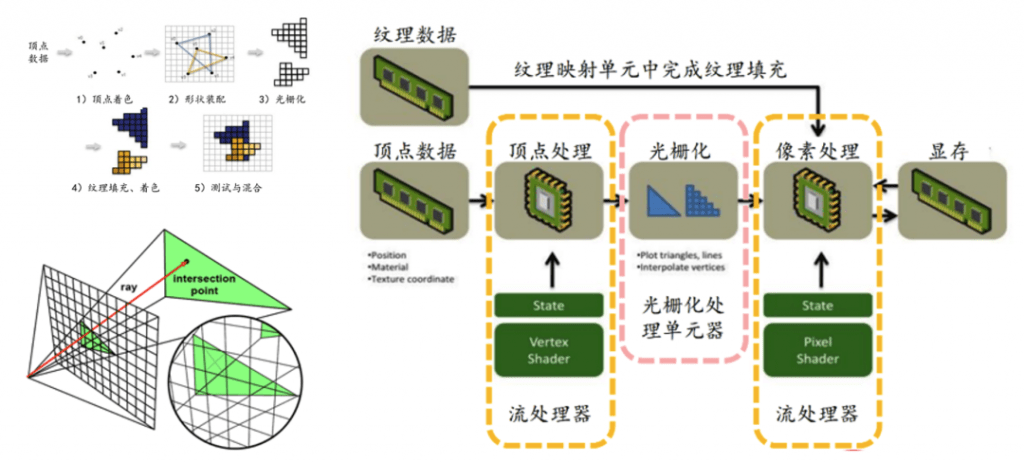

GPU早期是为了用于图形渲染

GPU早期是为了用于图形渲染

GPU早期一般为了3D渲染而设计。从计算机图形学的角度,GPU将三维事件的点阵通过矩阵变化投影到二维平面上,这个过程叫做光栅化,最终在显示器上结果。GPU的能力基本上是顶点处理、光栅化、像素处理等,这个过程包含大量的矩阵计算,刚好利用了GPU的并行性。

GPU走向了通用计算

GPU走向了通用计算

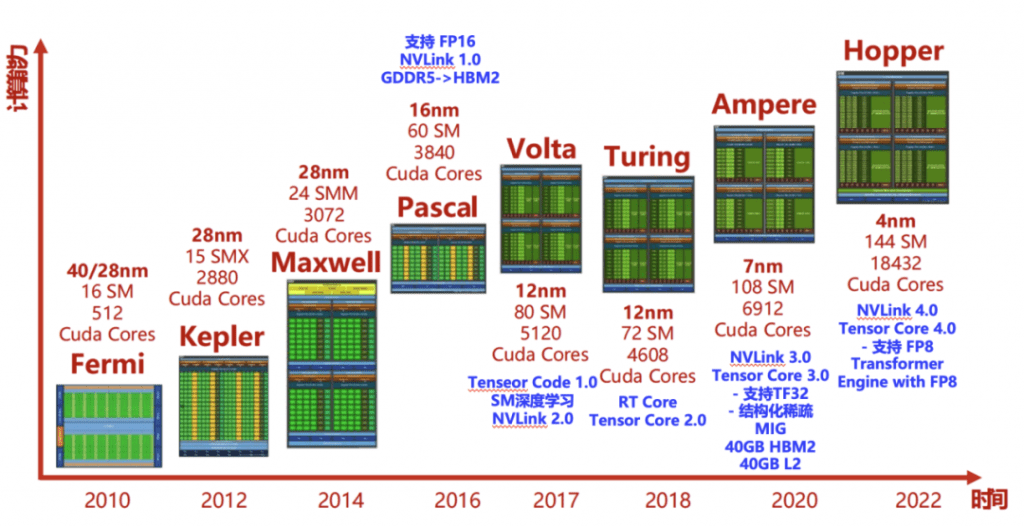

2003年,GPGPU(General Purpose computing on GPU)的概念被首次提出来。GPU不再以图形的3D加速为唯一目的,而是能够用于任意并行的通用计算,例如科学计算、数据分析、基因、云游戏、AIGC等。

随着2007年英伟达推出 CUDA 1.0版本,使其旗下所有 GPU 芯片都适应 CUDA 架构,CUDA生态和价格也是英伟达的最核心竞争力,也是英伟达万亿市值的关键因素之一。英伟达投入了一万以上的工程师在发展这个体系,基本上把人工智能里的大部分场景都做了深度优化。英伟达长期投入CUDA生态建设,为开发者服务,建立好了一系列的开源生态。

随着2007年英伟达推出 CUDA 1.0版本,使其旗下所有 GPU 芯片都适应 CUDA 架构,CUDA生态和价格也是英伟达的最核心竞争力,也是英伟达万亿市值的关键因素之一。英伟达投入了一万以上的工程师在发展这个体系,基本上把人工智能里的大部分场景都做了深度优化。英伟达长期投入CUDA生态建设,为开发者服务,建立好了一系列的开源生态。

五、AI发展历史英文视频资料

AbriefhistoryofAI

https://www.voanews.com/a/history-of-ai/7466123.html

其他AI相关参考资料:

参考资料

转载自:四张图片道清AI大模型的发展史(1943-2023)

AI发展历史

一文读懂GPU的过去、现在和未来

AI芯片战争:英伟达是科技之巅?