| 定价页 | 暂无 |

| 免费方式 | N/A |

| 定价方式 | 商务咨询 |

| 采购渠道 | 官网 |

| API适用国家/地区 | 美国 |

| 支持语言 | N/A |

for API 服务商

评分 43/100

5

for是什么公司

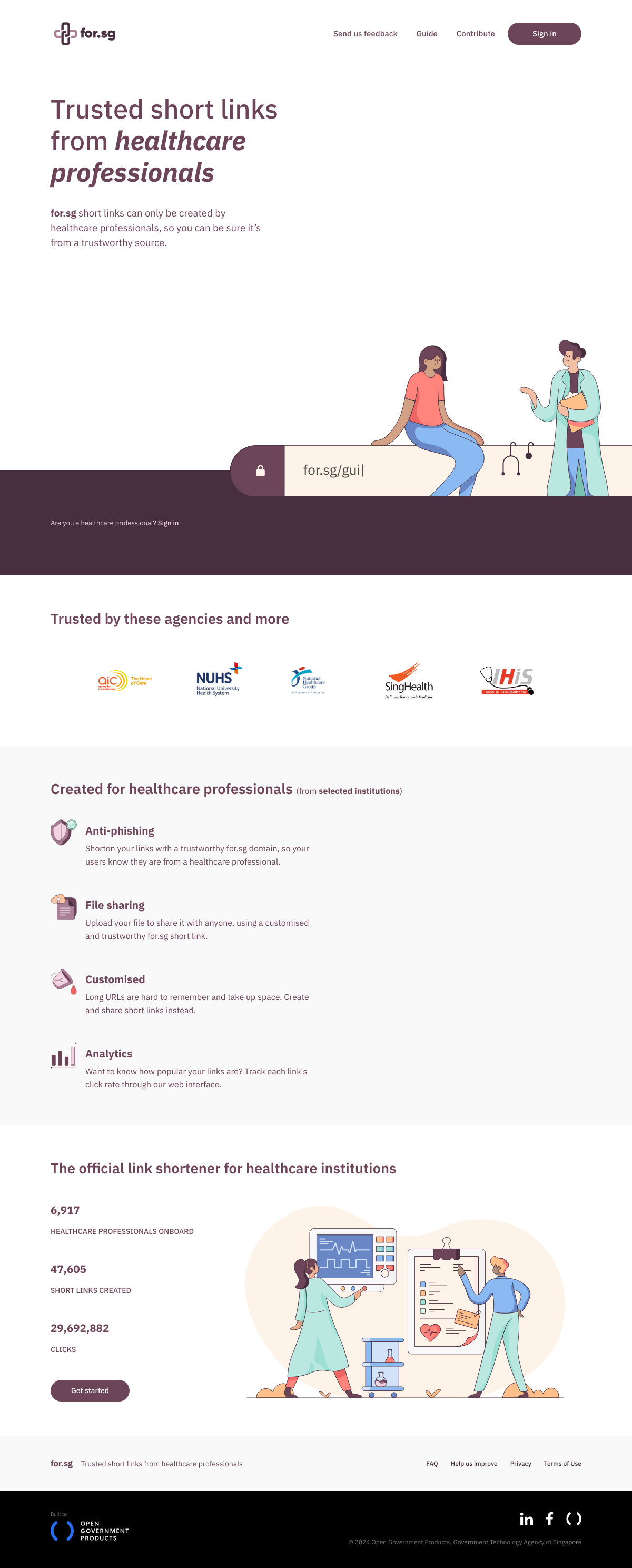

更多for.sg是一个专为医疗专业人士设计的可信短链接服务平台。它提供防钓鱼链接、文件共享、自定义链接和链接点击率分析等功能,确保用户能够安全、便捷地获取来自医疗专业人士的可靠信息。

for的API接口(产品与功能)

API产品信息

ForSG的API文档提供了如何生成访问API以获取/创建/更新短链接的Bearer Token的指南。

核心功能

| 功能模块 | 服务详情 |

|---|---|

| Bearer Token认证 | 使用Bearer Token进行HTTP认证,以安全访问ForSG的API。 |

| API Key生成 | 在ForSG导航栏点击'API Integration',生成API Key并复制Token。 |

| API请求 | 所有API请求必须通过HTTPS进行,未认证的请求将失败。 |

| 错误代码 | API使用常规错误代码指示请求的成功或失败。 |

| 速率限制 | ForSG默认支持每秒5个请求的速率限制,超出限制将被暂时阻止。 |

使用场景

- 短链接生成:开发者可以通过ForSG的API快速生成短链接,用于简化URL并跟踪点击量。

- API管理:IT管理员可以利用API Dashboard管理API Keys,包括测试和生产环境的密钥。

- 错误处理:开发者可以根据API返回的错误代码快速定位问题,优化请求。

- 请求限制:开发者可以根据ForSG的速率限制调整请求频率,避免被暂时阻止。

for API的价格(API免费方式与收费标准)

在选择API服务商时,综合评估以下维度,选择最适合自己需求的API服务商,确保技术兼容性和成本效益。

for API Key怎么获取(API调用与对接教程)

Airbyte官方API与Terraform Provider的推出优化了用户体验,通过简化操作流程和基础设施即代码(IaC)方式提升开发效率,支持在Airbyte Cloud上管理大型部署和ELT工作流程。

本文详细介绍了使用Keras API和TensorFlow微调Hugging Face Transformer模型的完整流程,包括安装transformers库、数据标记化、数据集预处理以及模型构建与训练。通过DistilBERT模型进行二分类任务,涵盖标记化、数据分割和优化器设置等关键步骤,帮助读者将预训练模型应用于自定义分类任务。

本文分析威胁行为者如何利用Telegram API实施凭证窃取攻击,通过钓鱼邮件和Cloudflare服务托管恶意页面,详细解析攻击技术如URL处理和表单提交机制,帮助用户理解威胁并采取防护措施。

Salesforce API 是 Salesforce 平台提供的一组接口,允许开发者与 Salesforce 数据进行交互。通过这些 API,开发者可以访问、修改和集成 Salesforce 数据,以满足企业的特定需求。Salesforce 提供了多种 API,包括 REST API、SOAP API、Bulk API 和 Streaming API,每种 API 都有其独特的功能和使用场景。这些 API 的开发和演变反映了 Salesforce 平台在适应不同集成需求和技术标准方面的持续进步。