使用NestJS和Prisma构建REST API:身份验证

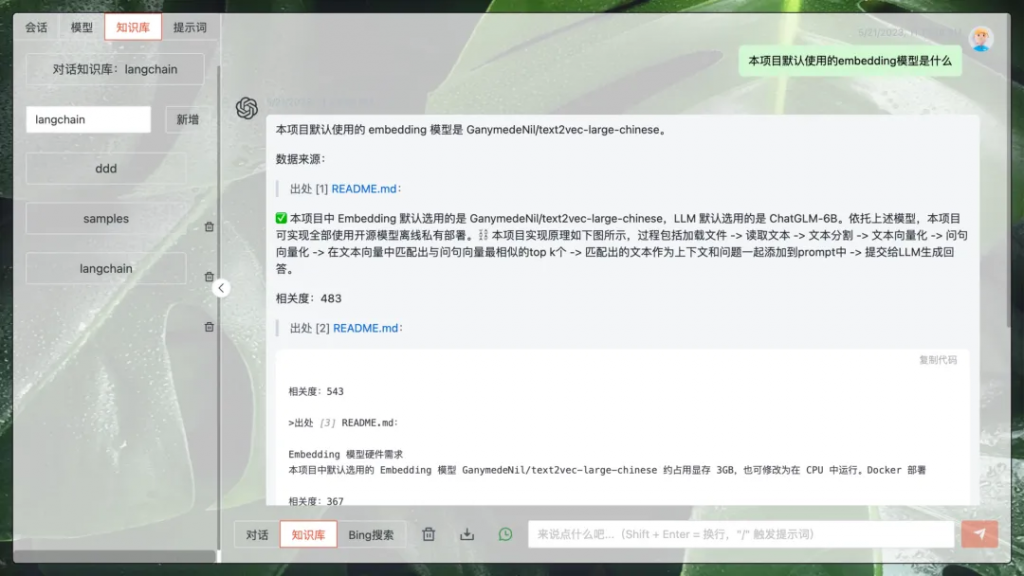

受GanymedeNil的项目document.ai和AlexZhangji创建的ChatGLM-6B Pull Request启发,建立了全流程可使用开源模型实现的本地知识库问答应用。现已支持使用ChatGLM-6B等大语言模型直接接入,或通过fastchat api形式接入Vicuna, Alpaca, LLaMA, Koala, RWKV等模型。今天分享中Embedding默认选用的是GanymedeNil/text2vec-large-chinese,LLM默认选用的是ChatGLM-6B。依托上述模型,本项目可实现全部使用开源模型离线私有部署。

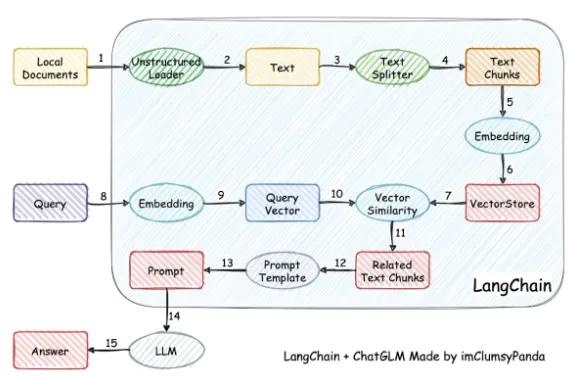

实现原理如下图所示,过程包括加载文件 -> 读取文本 -> 文本分割 -> 文本向量化 -> 问句向量化 -> 在文本向量中匹配出与问句向量最相似的top k个 -> 匹配出的文本作为上下文和问题一起添加到prompt中 -> 提交给LLM生成回答。

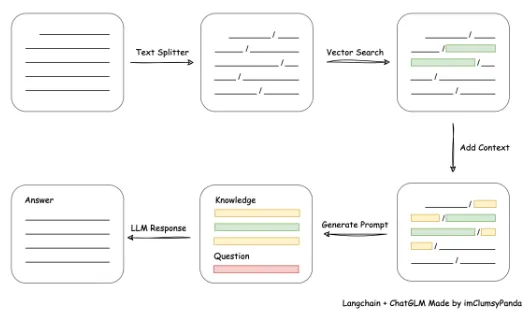

从文档处理角度来看,实现流程如下:

本项目未涉及微调、训练过程,但可利用微调或训练对本项目效果进行优化。核心部分代码为:

执行初始化

init_cfg(LLM_MODEL, EMBEDDING_MODEL, LLM_HISTORY_LEN)

# 使用 ChatGLM 的 readme 进行测试

vector_store = init_knowledge_vector_store("/home/mw/project/test_chatglm_readme.md")中vector_store的初始化可以传递 txt、docx、md 格式文件,或者包含md文件的目录。更多知识库加载方式可以参考langchain文档,通过修改 init_knowledge_vector_store 方法进行兼容。

官方注:ModelWhale GPU机型需要从云厂商拉取算力资源,耗时5~10min,且会预扣半小时资源价格的鲸币。如果资源未启动成功,预扣费用会在关闭编程页面后五分钟内退回,无需紧张,如遇问题欢迎提报工单,客服会及时处理。

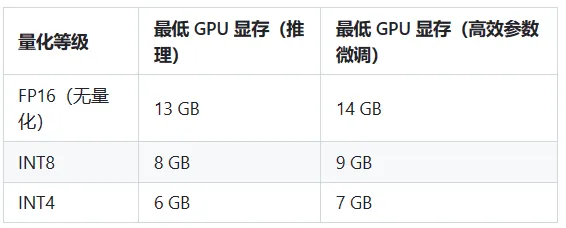

注:如未将模型下载至本地,请执行前检查$HOME/.cache/huggingface/文件夹剩余空间,模型文件下载至本地需要15GB存储空间。

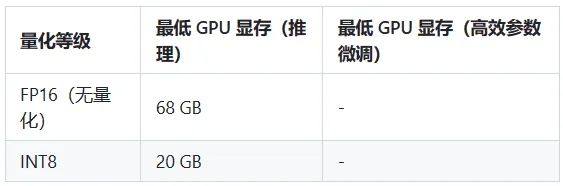

注:如未将模型下载至本地,请执行前检查$HOME/.cache/huggingface/文件夹剩余空间,模型文件下载至本地需要70GB存储空间

为了能让容器使用主机GPU资源,需要在主机上安装 NVIDIA Container Toolkit。具体安装步骤如下:

sudo apt-get update

sudo apt-get install -y nvidia-container-toolkit-base

sudo systemctl daemon-reload

sudo systemctl restart docker安装完成后,可以使用以下命令编译镜像和启动容器:

docker build -f Dockerfile-cuda -t chatglm-cuda:latest .

docker run --gpus all -d --name chatglm -p 7860:7860 chatglm-cuda:latest

#若要使用离线模型,请配置好模型路径,然后此repo挂载到Container

docker run --gpus all -d --name chatglm -p 7860:7860 -v ~/github/langchain-ChatGLM:/chatGLM chatglm-cuda:latest软件需求

本项目已在 Python 3.8.1 – 3.10,CUDA 11.7 环境下完成测试。已在 Windows、ARM 架构的 macOS、Linux 系统中完成测试。

vue前端需要node18环境

从本地加载模型

请参考 THUDM/ChatGLM-6B#从本地加载模型

环境检查

# 首先,确信你的机器安装了 Python 3.8 及以上版本

$ python --version

Python 3.8.13

# 如果低于这个版本,可使用conda安装环境

$ conda create -p /your_path/env_name python=3.8

# 激活环境

$ source activate /your_path/env_name

$ pip3 install --upgrade pip

# 关闭环境

$ source deactivate /your_path/env_name

# 删除环境

$ conda env remove -p /your_path/env_name项目依赖

# 拉取仓库

$ git clone https://github.com/imClumsyPanda/langchain-ChatGLM.git

# 进入目录

$ cd langchain-ChatGLM

# 项目中 pdf 加载由先前的 detectron2 替换为使用 paddleocr,如果之前有安装过 detectron2 需要先完成卸载避免引发 tools 冲突

$ pip uninstall detectron2

# 检查paddleocr依赖,linux环境下paddleocr依赖libX11,libXext

$ yum install libX11

$ yum install libXext

# 安装依赖

$ pip install -r requirements.txt

# 验证paddleocr是否成功,首次运行会下载约18M模型到~/.paddleocr

$ python loader/image_loader.py在开始执行 Web UI 或命令行交互前,请先检查 configs/model_config.py 中的各项模型参数设计是否符合需求。

如需通过 fastchat 以 api 形式调用 llm,请参考 fastchat 调用实现

注:鉴于环境部署过程中可能遇到问题,建议首先测试命令行脚本。建议命令行脚本测试可正常运行后再运行 Web UI。

执行 cli_demo.py 脚本体验命令行交互:

$ python cli_demo.py或执行 webui.py 脚本体验 Web 交互

$ python webui.py或执行 api.py 利用 fastapi 部署 API

$ python api.py或成功部署 API 后,执行以下脚本体验基于 VUE 的前端页面

$ cd views

$ pnpm i

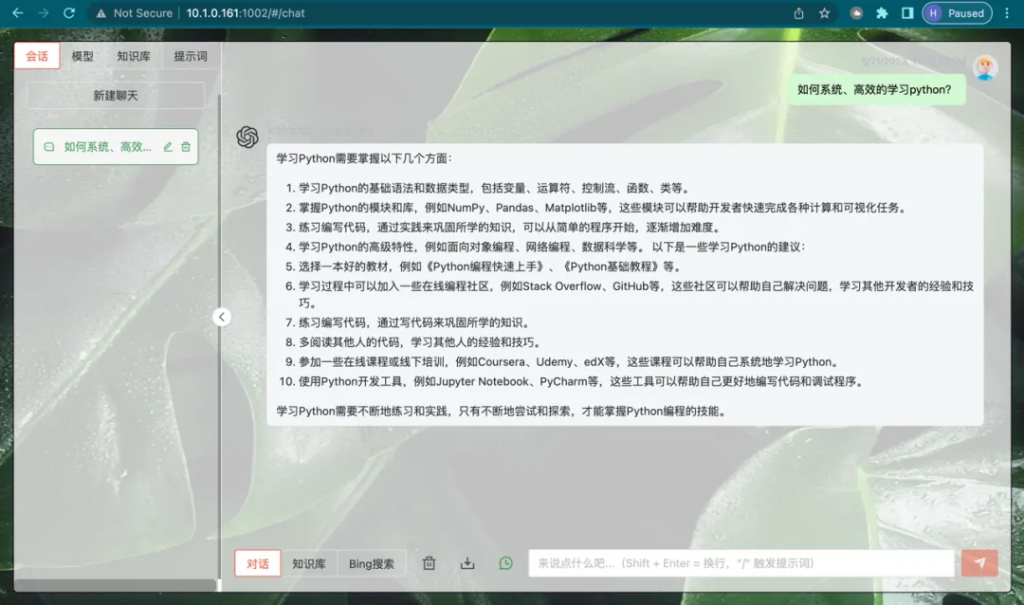

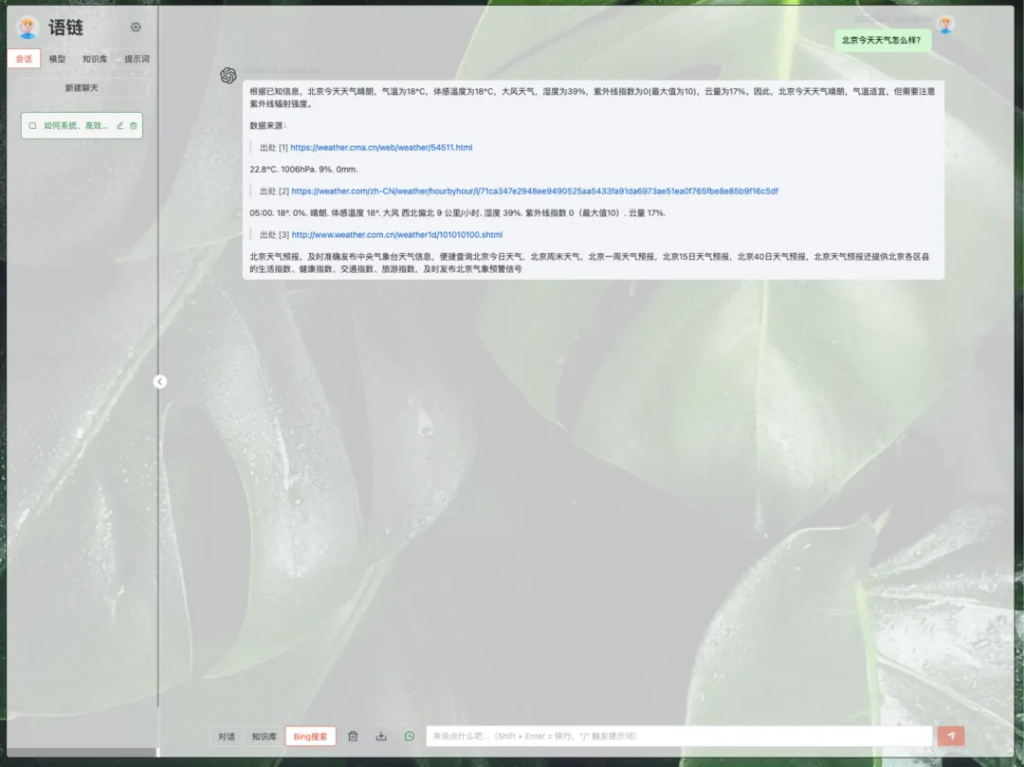

$ npm run devVUE 前端界面如下图所示:

知识问答界面

bing搜索界面

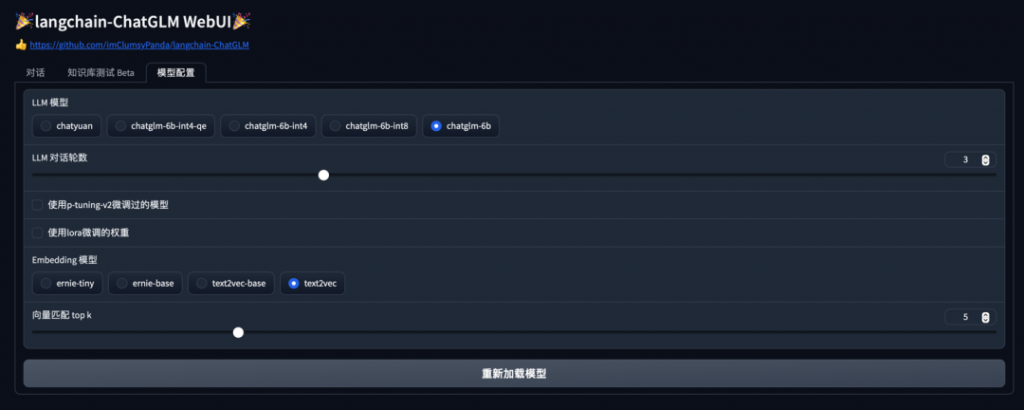

WebUI 界面如下图所示:

知识库测试Beta Tab界面

模型配置Tab界面

Web UI 可以实现如下功能:

本文章转载微信公众号@计算机视觉研究院