XGBoost、LightGBM与CatBoost算法比较:性能与应用全面解析

近年来,机器学习中的Boosting算法因其在结构化数据上的卓越表现而备受关注。其中,XGBoost、LightGBM和CatBoost三种算法各具特色。本文将从多角度对这三种算法进行详细比较,包括算法结构、参数设置、分类变量处理等方面,并通过实际案例探讨其在不同数据集上的表现。

1. XGBoost、LightGBM与CatBoost的基本概述

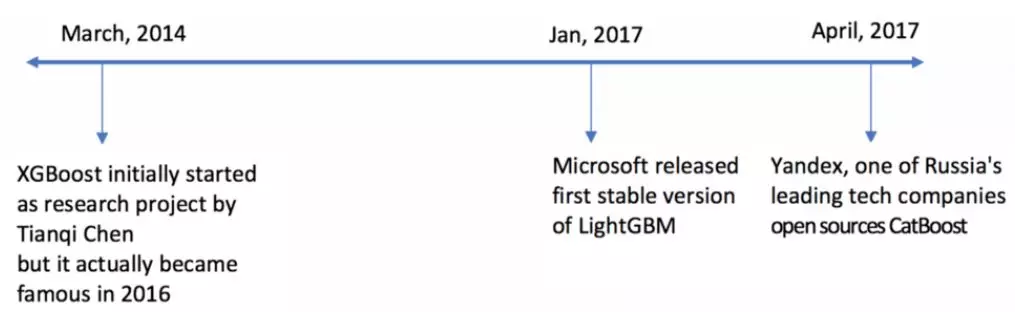

1.1 XGBoost简介

XGBoost是Gradient Boosting算法的扩展版本,以其高效的计算速度和良好的准确性而闻名。其采用的二阶梯度提升方法能够在提高预测准确度的同时控制模型的复杂度。此外,XGBoost支持并行计算,这使得其在大数据集上具有显著的优势。

1.2 LightGBM简介

LightGBM由微软推出,主要针对大规模数据集进行了优化。其采用的基于直方图的算法以及GOSS(Gradient-based One-Side Sampling)技术,使得LightGBM在保证模型精度的同时大幅提升了训练速度,且内存占用更少。

1.3 CatBoost简介

CatBoost由Yandex公司开发,专注于解决类别型变量处理问题。其独特的对称树结构和高效的特征编码方法,使得CatBoost在处理高维类别特征时具有显著的效果。同时,CatBoost通过目标编码和随机排列等方式有效降低了过拟合风险。

2. 算法结构与差异

2.1 树的生成策略

XGBoost采用按层生长的Level-wise策略,这种策略虽然能够更好地控制过拟合,但在计算资源上消耗较大。与之相对,LightGBM使用Leaf-wise策略,通过选择分裂增益最大的叶子进行分裂,能够更快地生成深度更深的决策树。CatBoost则使用对称树结构,其决策树是完全二叉树,保证了树的平衡性。

2.2 特征处理与编码

对于特征处理,LightGBM和CatBoost都能够自动识别并处理类别型变量,而XGBoost则需要将类别特征手动编码为数值型数据。CatBoost的特征编码更为复杂和精细,能够对高维度类别特征进行有效编码,减少信息损失。

3. 性能与调参

3.1 性能比较

在实际应用中,三种算法的性能表现因数据集的不同而异。通常情况下,LightGBM在大规模数据集上的训练速度较快,而CatBoost在处理高维类别数据时更具优势。XGBoost则在数据量适中的情况下表现出色。

3.2 调参技巧

调参是提升模型性能的关键。XGBoost的参数调节包括树的深度、学习率、最小子节点权重等。LightGBM的调参则需关注叶子数、学习率、最大深度等。CatBoost的调参相对复杂,需要针对特征进行独热编码和目标编码的参数优化。

4. 实际案例分析

4.1 Kaggle航班延误数据集应用

在Kaggle的航班延误数据集中,我们分别应用了XGBoost、LightGBM和CatBoost进行预测。数据集包含500多万条记录,我们取样1%进行模型训练和测试。

import pandas as pd

from sklearn.model_selection import train_test_split

flights = pd.read_csv('flights.csv')

flights = flights.sample(frac=0.01, random_state=10)

flights['ARRIVAL_DELAY'] = (flights['ARRIVAL_DELAY']>10)*1

cat_cols = ['AIRLINE', 'FLIGHT_NUMBER', 'DESTINATION_AIRPORT', 'ORIGIN_AIRPORT']

for item in cat_cols:

flights[item] = flights[item].astype('category').cat.codes + 1

X_train, X_test, y_train, y_test = train_test_split(flights.drop(['ARRIVAL_DELAY'], axis=1), flights['ARRIVAL_DELAY'], random_state=10, test_size=0.3)4.2 模型训练与结果

分别训练XGBoost、LightGBM和CatBoost模型,比较其在测试集上的AUC(Area Under Curve)表现。

import xgboost as xgb

from sklearn.metrics import roc_auc_score

params = {'max_depth': 5, 'eta': 0.1, 'objective': 'binary:logistic'}

dtrain = xgb.DMatrix(X_train, label=y_train)

model_xgb = xgb.train(params, dtrain, num_boost_round=100)5. 结论与建议

通过上述分析,我们可以得出以下结论:

- 在训练速度方面,LightGBM表现最佳,尤其在大数据集上。

- CatBoost在处理类别型变量时有显著优势,适合高维度数据。

- XGBoost的准确性在三者中依旧保持较高水平,但计算资源消耗较大。

FAQ

-

问:XGBoost与LightGBM有何不同?

- 答:两者在树的生成策略和特征处理上存在显著差异,LightGBM使用Leaf-wise增长策略,更适合大数据集。

-

问:如何选择合适的Boosting算法?

- 答:选择算法时应考虑数据集的规模、特征类型以及计算资源等因素,具体选择需结合实际应用场景。

-

问:Boosting算法如何避免过拟合?

- 答:通过调节模型参数如学习率、树的深度、正则化参数等,可以有效控制模型的复杂度,减少过拟合风险。

通过本文的详细比较与分析,相信您对XGBoost、LightGBM和CatBoost三种算法有了更全面的认识。在实际应用中,合理选择与调节参数将有助于提升模型的预测性能。

最新文章

- 函数调用与工具使用入门 – Apideck

- 什么是API测试?其优势、类型及最佳实践

- API 安全策略和基础指南

- 如何在Python、PHP、Ruby中使用今日头条热搜榜API

- 如何获取文心一言 API Key 密钥(分步指南)

- 2025 ComfyUI 稳定扩散流水线|拖拽式节点化+API 集成教程

- Flask-Limiter:为 API 添加访问速率限制的 Python 扩展!

- OpenAI o1原理逆向工程图解

- 性别预测API:如何让名字背后的性别信息一目了然?

- 小红书AI文章风格转换:违禁词替换与内容优化技巧指南

- REST API 设计:过滤、排序和分页

- 如何获取 Coze开放平台 API 密钥(分步指南)