Dropout加在哪里:深入探讨神经网络中的Dropout应用

文章目录

什么是Dropout正则化

Dropout正则化是一种有效的防止神经网络过拟合的方法。其基本原理是在训练过程中随机忽略一部分神经元,即这些神经元被“dropped out”。这种方法在正向传播时忽略了部分神经元对下游的影响,并在反向传播时不更新这些神经元的权重。通过这种方式,网络在训练时会形成多个不同的独立子网络,从而提高模型的泛化能力,减少过拟合的风险。

Dropout的应用场景

Dropout最常被应用于全连接层。由于全连接层的参数量较大,容易导致过拟合,因此在全连接层使用Dropout可以有效提高模型的泛化能力。然而,在卷积层中,由于参数量相对较少,通常不容易过拟合,因此较少应用Dropout。不过,在某些特定的实验中,卷积层也会尝试加入Dropout以增强模型的鲁棒性。

在卷积层中使用Dropout

尽管卷积层参数较少,但在某些情况下,使用Dropout仍然可以带来性能的提升。例如,研究表明,在某些复杂数据集上,例如CIFAR-10,加入Dropout可以提升模型的准确性。这是因为Dropout在卷积层中可以为高层的全连接层提供噪声输入,从而减少过拟合。

Dropout在全连接层的位置

激活函数后的Dropout

在全连接层中,Dropout通常放在激活函数之后。这是因为在某些激活函数(如ReLU)中,输入为零的情况会导致输出也为零,从而使Dropout的效果不明显。因此,将Dropout放在激活函数之后,可以确保所有的神经元都在激活后被随机忽略,从而增强模型的泛化能力。

from keras.models import Sequential

from keras.layers import Dense, Dropout

model = Sequential()

model.add(Dense(128, activation='relu', input_dim=64))

model.add(Dropout(0.5))

model.add(Dense(64, activation='relu'))

model.add(Dense(10, activation='softmax'))Dropout在输入层的应用

在输入层使用Dropout可以被视作数据扩增的一种方式。通过随机忽略部分输入特征,模型可以学习到更为鲁棒的特征表示。这种方法在某些情况下可以有效提高模型的性能,特别是在输入数据存在噪声时。

输入层Dropout的代码示例

以下是一个在输入层应用Dropout的简单示例:

model = Sequential()

model.add(Dropout(0.2, input_shape=(60,)))

model.add(Dense(60, activation='relu'))

model.add(Dense(30, activation='relu'))

model.add(Dense(1, activation='sigmoid'))Dropout的最佳实践

-

选择合适的Dropout概率:一般来说,Dropout概率不宜过高,通常建议在20%到50%之间。过低的概率可能达不到正则化效果,而过高的概率则可能导致欠拟合。

-

大网络结构:更大的网络结构可以更好地从Dropout中获益,因为大的网络更有可能学习到多种独立的特征表示。

-

各层均使用Dropout:在网络的每一层都使用Dropout,包括输入层,这样可以更全面地防止过拟合。

-

提高学习率和动量:由于Dropout会增加训练的复杂性,可以适当提高学习率和动量以加速训练过程。

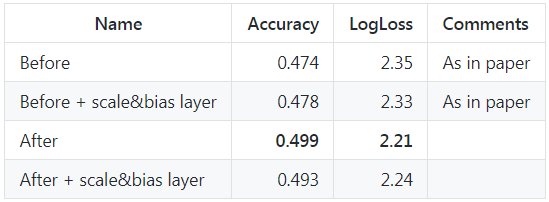

Dropout的实验与效果分析

在不同的数据集和网络结构上,Dropout的效果可能有所不同。以下是一个简单的实验对比:

不使用Dropout的基线模型

def create_baseline():

model = Sequential()

model.add(Dense(60, input_dim=60, activation='relu'))

model.add(Dense(30, activation='relu'))

model.add(Dense(1, activation='sigmoid'))

model.compile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy'])

return model在没有使用Dropout的情况下,基线模型的准确率为82.68%。

使用Dropout后的模型

def create_model_with_dropout():

model = Sequential()

model.add(Dense(60, input_dim=60, activation='relu'))

model.add(Dropout(0.5))

model.add(Dense(30, activation='relu'))

model.add(Dropout(0.5))

model.add(Dense(1, activation='sigmoid'))

model.compile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy'])

return model加入Dropout后,模型的准确率提高到了86.04%。

Dropout的常见误区

误区一:Dropout只能用于全连接层

虽然Dropout最常用于全连接层,但它同样可以应用于卷积层和输入层,只是需要根据具体的网络结构和数据集进行调节。

误区二:Dropout概率越高效果越好

过高的Dropout概率会导致模型欠拟合,因此需要在实验中找到一个合适的平衡点。

FAQ

问:Dropout是否适用于所有类型的神经网络?

答:Dropout主要用于深度神经网络中的全连接层,但在某些情况下也可以应用于卷积层和输入层,需要根据具体情况调整。

问:如何选择合适的Dropout概率?

答:通常从20%开始尝试,逐步调整至50%。具体的选择应基于实验结果和模型的表现。

问:Dropout是否会影响模型的训练时间?

答:由于Dropout增加了训练的复杂性,可能会导致训练时间延长。然而,适当调整学习率和动量可以缓解这一问题。

问:如何在Keras中实现Dropout?

答:Keras中可以通过Dropout层来实现,具体用法是在模型中添加Dropout层并指定概率。例如:model.add(Dropout(0.5))。

问:Dropout能否替代其他正则化方法?

答:Dropout是一种有效的正则化方法,但不能完全替代其他方法。通常需要结合权重正则化、数据扩增等多种方法共同使用。

通过对Dropout的深入理解和合理应用,可以显著提升神经网络的性能和鲁棒性。

热门API

- 1. AI文本生成

- 2. AI图片生成_文生图

- 3. AI图片生成_图生图

- 4. AI图像编辑

- 5. AI视频生成_文生视频

- 6. AI视频生成_图生视频

- 7. AI语音合成_文生语音

- 8. AI文本生成(中国)

最新文章

- 从C#实例看API安全最佳实践

- API管理:它是什么,为什么重要?

- 如何使用免费文字转拼音API:python集成案例

- 如何免费使用 DeepSeek AI:API 密钥、本地部署与 RAG 应用实战指南

- 探索宝可梦的世界:PokeAPI如何让开发者大展拳脚

- Java 快速开发框架 magic-api

- 金山文档 API开放平台访问token分步指南

- 产品经理必备的API技术知识

- 用WhatsApp API发OTP验证码最全指南

- Web API与REST API的区别?

- 保护JavaScript客户端到API服务的通信

- PHP cURL带身份验证API调用指南(REST GET/POST 全流程)