大模型RAG技术:从入门到实践

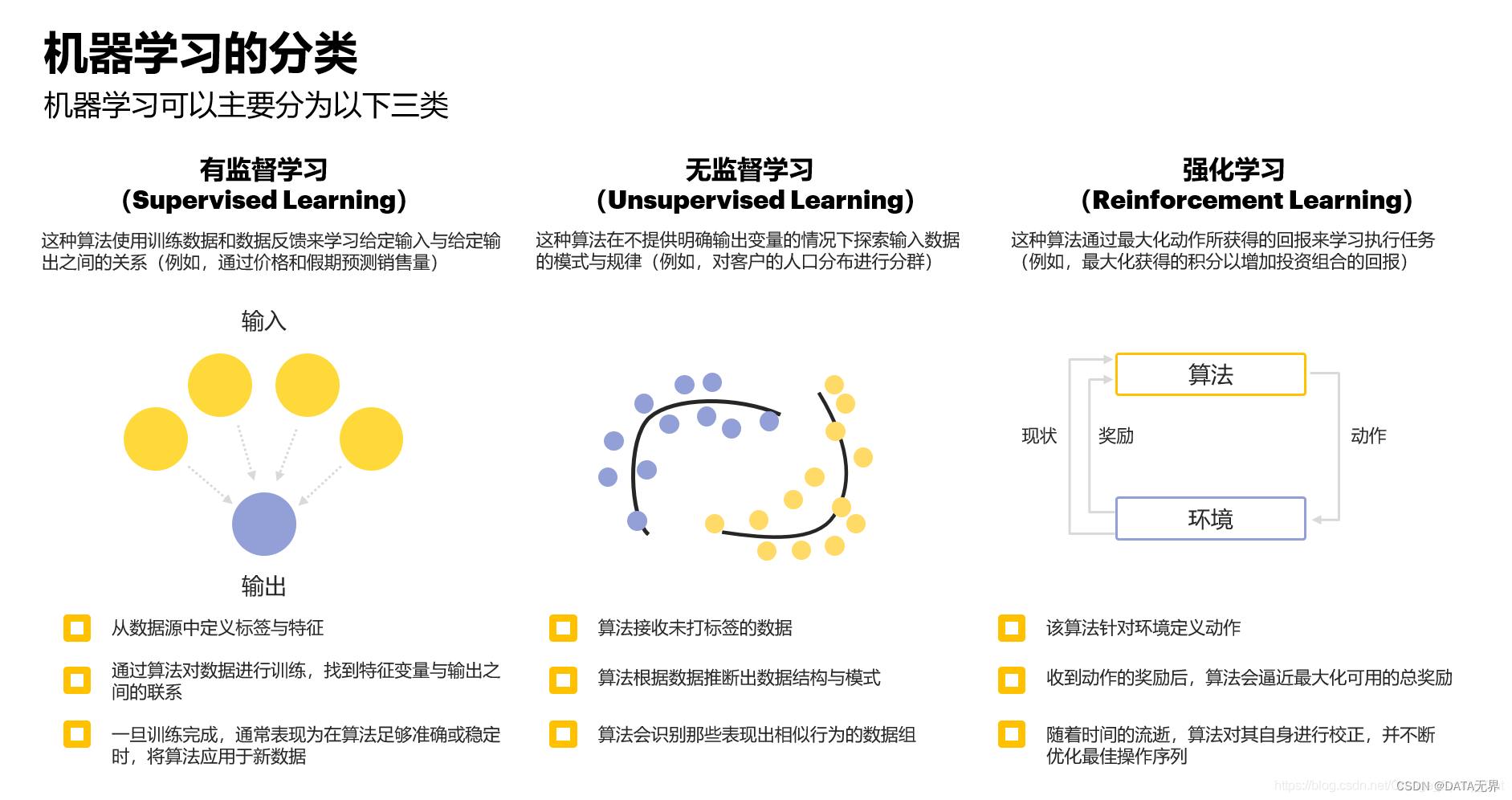

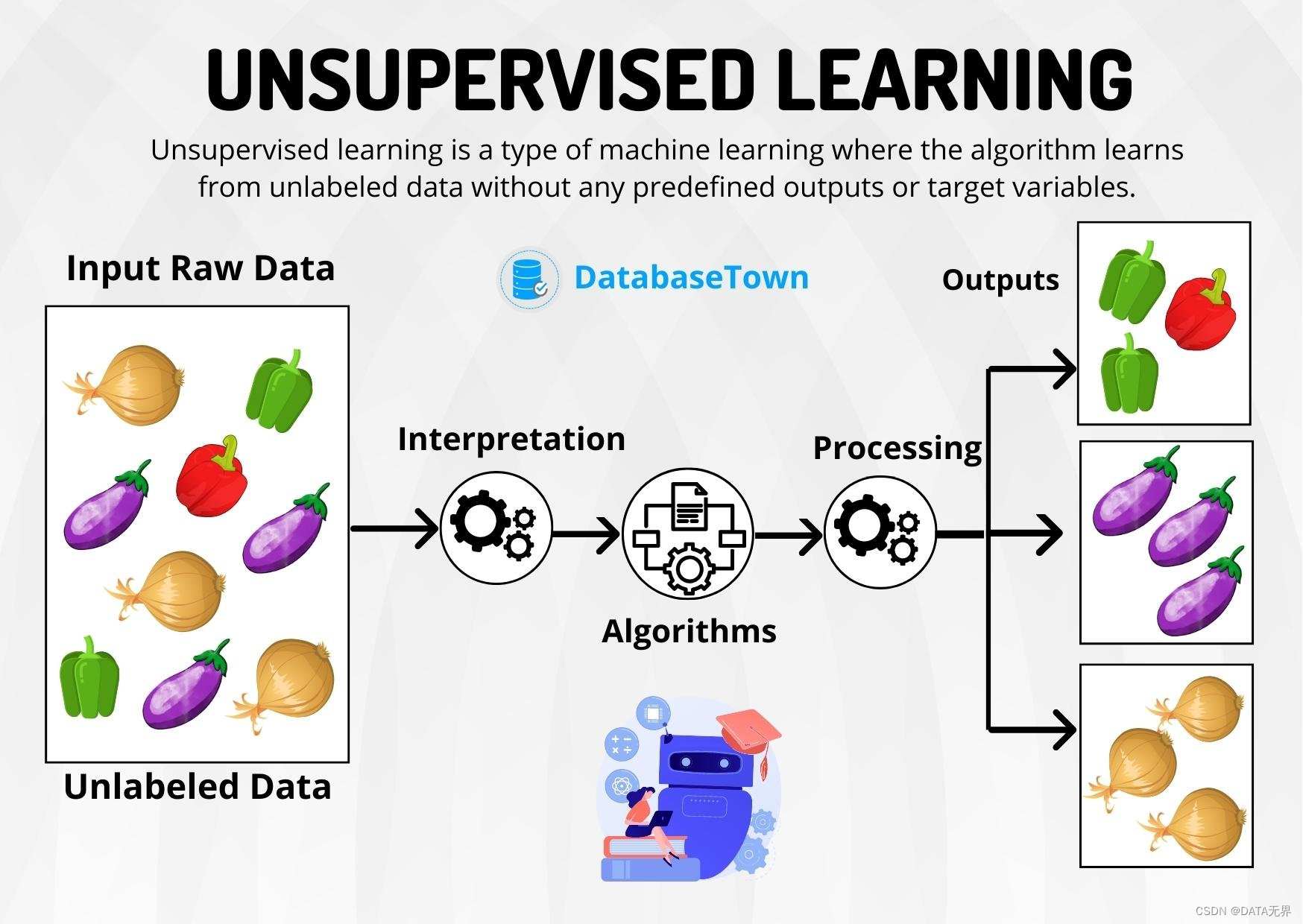

无监督训练,也称为无监督学习,是机器学习的一种方法,其特点是不需要预先标记的训练数据。与有监督学习不同,无监督学习算法从未标记的数据中寻找内在结构和模式。这种方法能够发现数据的相似性和差异性,广泛应用于探索性数据分析、客户细分、图像识别等领域。

无监督学习的主要任务包括聚类、降维和密度估计。通过分析数据的统计特征,无监督学习可以自主发现隐藏的模式和结构,不依赖于人工标注的目标值。这种“自主学习”的范式使得无监督学习在许多应用场景中具有独特的优势。

无监督学习的核心在于通过数据的统计特征、相似度等进行分析和挖掘,然后利用密度估计、聚类和降维等技术来捕获和发现数据隐藏的内在结构和模式。

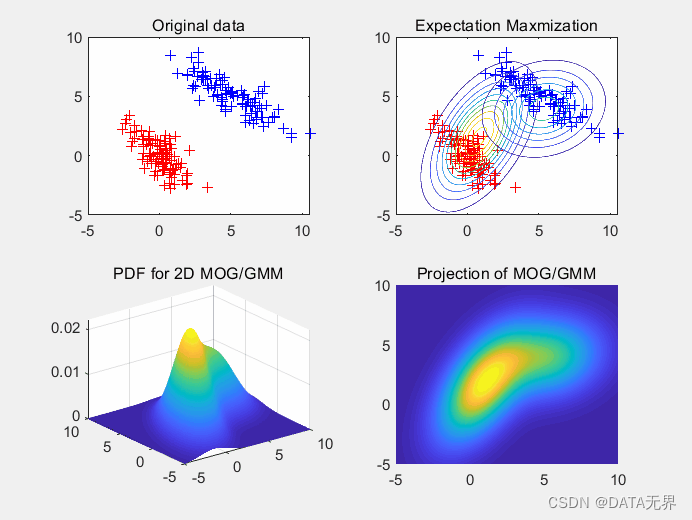

密度估计是无监督学习中的一个基本问题,旨在估计样本数据的概率密度函数,以刻画数据的整体分布特征。常用的方法有核密度估计、高斯混合模型等。掌握了数据分布后,就能发现异常数据点,检测新观测值等。

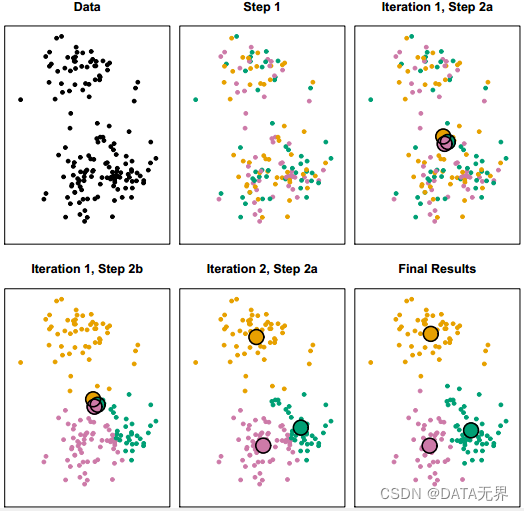

聚类是将数据集中的样本划分为若干个类别的过程,使同一类别内的样本相似度较高,不同类别之间的样本相似度较低。常见的聚类算法包括K均值聚类、层次聚类、DBSCAN等。聚类分析有助于发现数据的内在组织结构。

降维技术通过数学上的投影等方式将高维数据映射到一个低维空间,保留数据的原始结构和特征关系,简化后续处理。主成分分析(PCA)、t-SNE等是常用的无监督降维方法。

K-Means是最常用和最简单的聚类算法之一。它是一种基于中心点的聚类方法,将样本分配给最近的K个中心点所对应的簇。K-Means算法的核心步骤包括初始化中心点、分配样本到最近的中心点所在的簇、更新中心点位置,以最小化簇内样本间的平方和。

层次聚类通过逐步合并或分裂簇来构建层次化的聚类树状结构。主要分为凝聚层次聚类和分裂层次聚类。此算法的优势在于不需要预先指定聚类数目,适用于小型数据集的聚类任务。

GMM假设数据服从由多个高斯分布混合而成的概率分布模型。通过期望最大化(EM)算法估计每个高斯分布的参数,广泛应用于聚类、密度估计等任务。

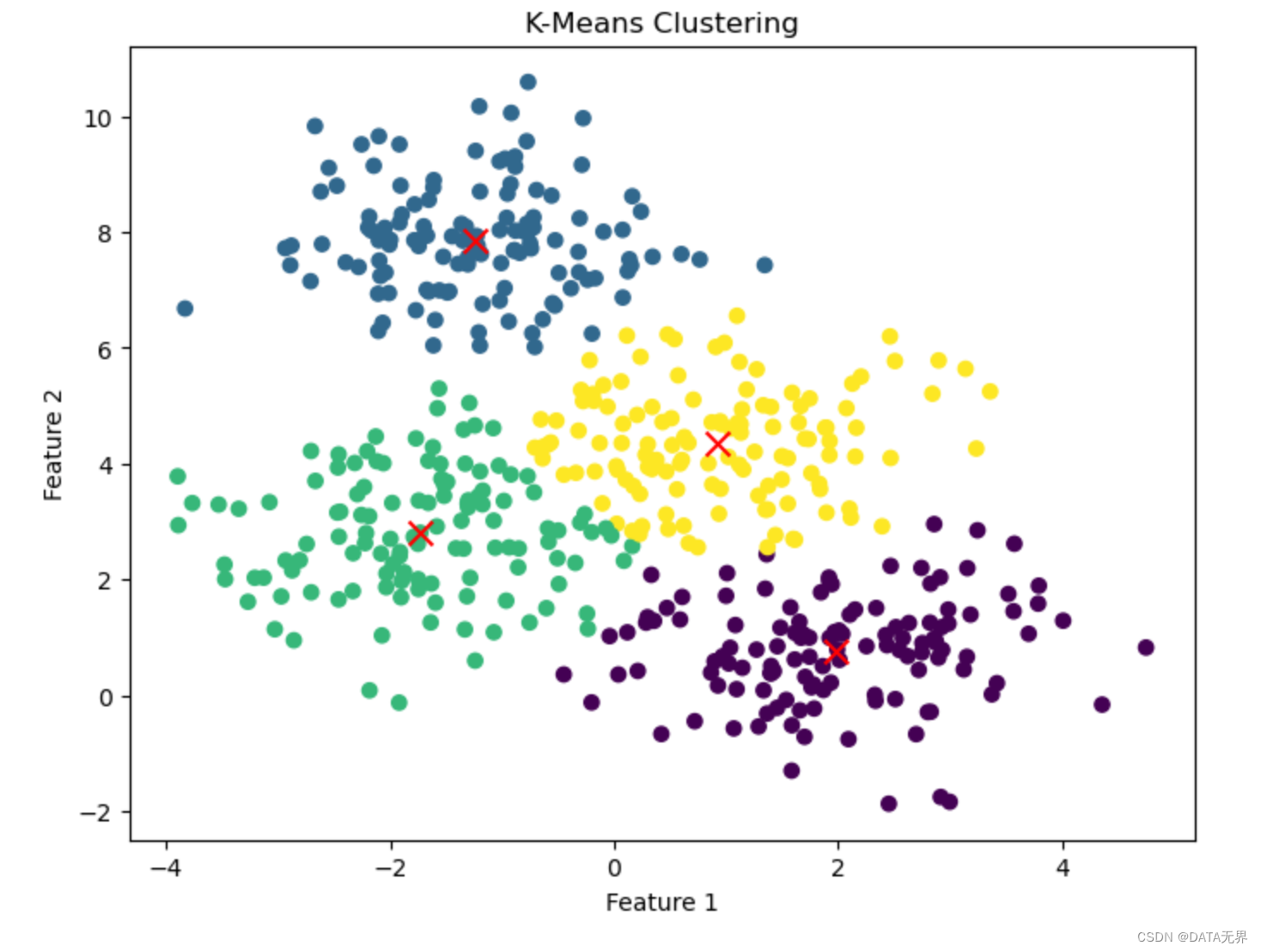

下面通过一个基于Python的K-Means聚类算法实例,更直观地理解无监督学习。

import numpy as np

import matplotlib.pyplot as plt

from sklearn.cluster import KMeans

from sklearn.datasets import make_blobs

X, y = make_blobs(n_samples=500, centers=4, n_features=2, random_state=0)

kmeans = KMeans(n_clusters=4, random_state=0)

kmeans.fit(X)

labels = kmeans.predict(X)

plt.figure(figsize=(8, 6))

plt.scatter(X[:, 0], X[:, 1], c=labels, cmap='viridis')

plt.scatter(kmeans.cluster_centers_[:,0], kmeans.cluster_centers_[:,1], marker='x', c='red', s=100)

plt.title('K-Means Clustering')

plt.xlabel('Feature 1')

plt.ylabel('Feature 2')

plt.show()

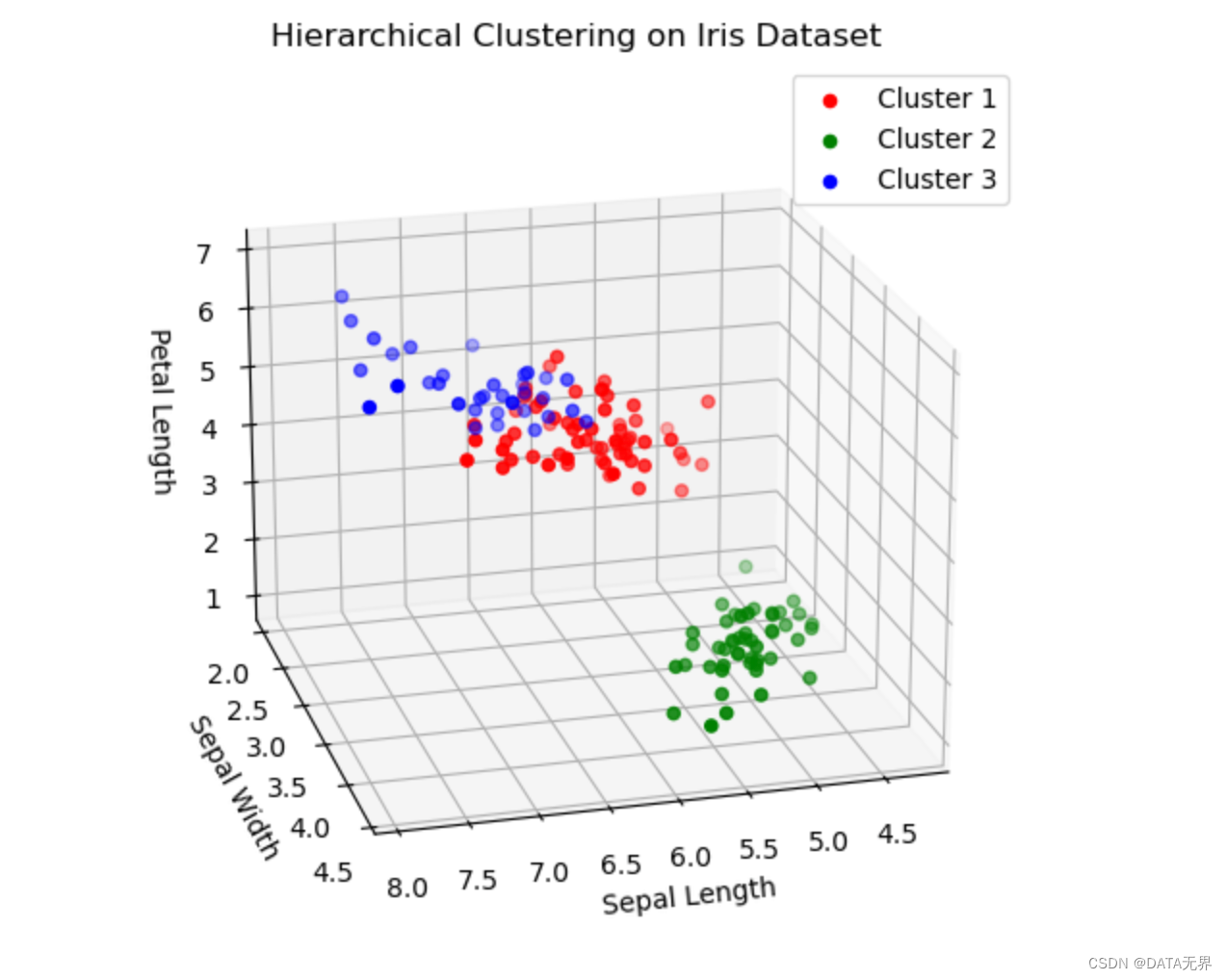

我们使用SciPy库中的层次聚类模块,实现一个基于Ward’s最小方差准则的聚类算法。

import numpy as np

from sklearn.datasets import load_iris

from sklearn.cluster import AgglomerativeClustering

import matplotlib.pyplot as plt

from mpl_toolkits.mplot3d import Axes3D

iris = load_iris()

X = iris.data

clustering = AgglomerativeClustering(n_clusters=3, linkage='ward')

clustering.fit(X)

labels = clustering.labels_

fig = plt.figure(figsize=(8, 6))

ax = fig.add_subplot(111, projection='3d')

for label in set(labels):

data = X[labels == label]

ax.scatter(data[:, 0], data[:, 1], data[:, 2], label=f'Cluster {label+1}')

ax.legend()

ax.set_xlabel('Sepal Length')

ax.set_ylabel('Sepal Width')

ax.set_zlabel('Petal Length')

ax.set_title('Hierarchical Clustering on Iris Dataset')

ax.view_init(30, 30)

plt.show()

无监督学习在生物信息学、金融、网络安全、推荐系统等领域应用广泛。其强大的自动学习能力使其成为构建通用人工智能的关键技术之一。在未来,无监督学习将继续促进数据分析和决策的智能化。

问:无监督学习与有监督学习的主要区别是什么?

问:无监督学习的典型应用场景有哪些?

问:无监督学习的主要挑战是什么?