Node.js 后端开发指南:搭建、优化与部署

Transformer作为一种机器学习模型,尤其是深度学习模型,已经引起了广泛的关注和应用。它的核心优势在于能够处理序列到序列的问题,例如语言翻译、文本摘要等。本文将深入探讨Transformer的工作原理、优势以及应用场景,同时提供实际代码示例和FAQ,帮助读者全面理解这一技术。

Transformer模型的核心在于其能够处理序列数据,并在不同的任务中进行有效的转换。

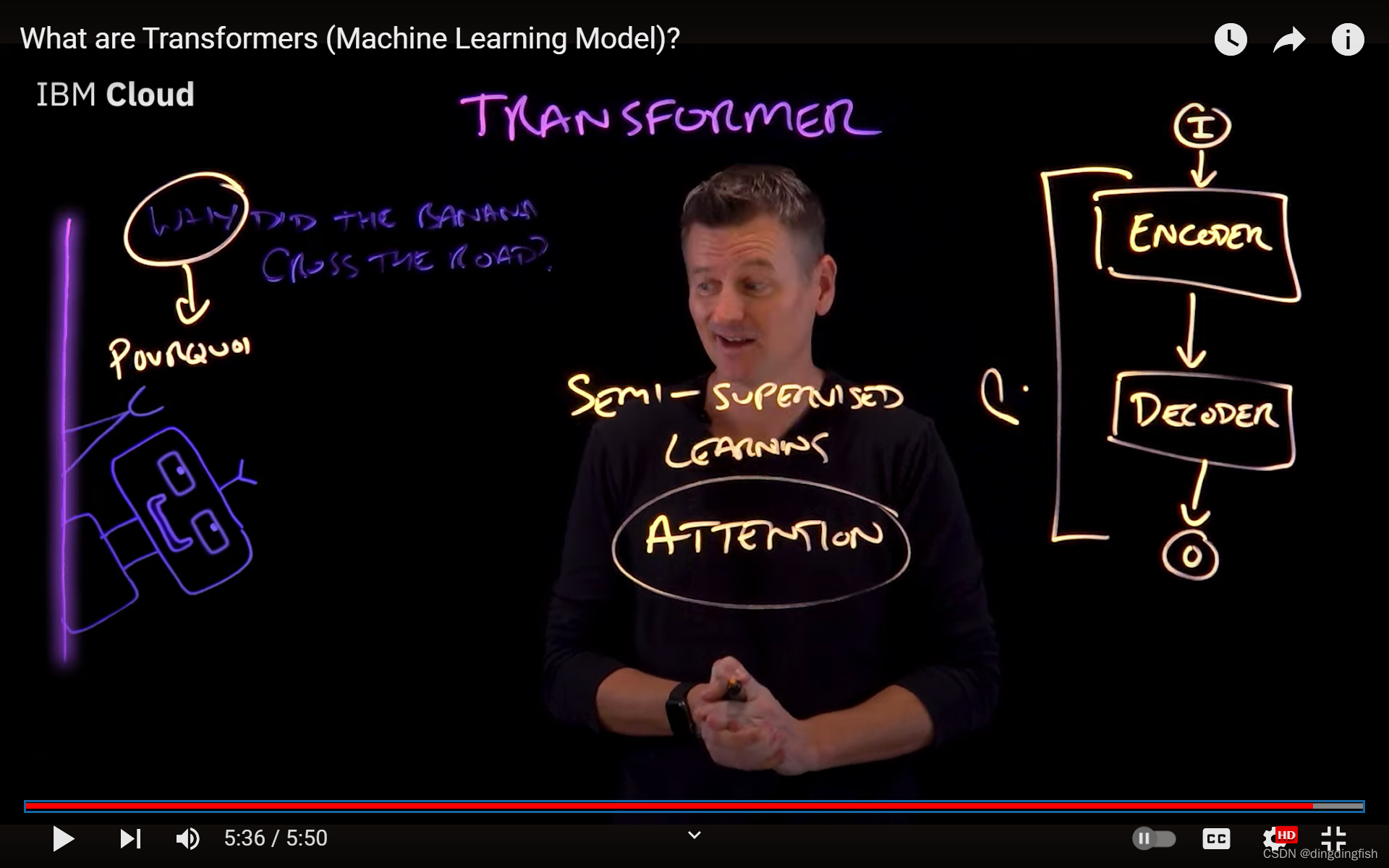

编码器(Encoder)和解码器(Decoder)是Transformer模型中的两个主要部分。编码器负责处理输入序列,而解码器则基于编码器的输出生成目标序列。具体来说,编码器会对输入的每个标记(Token)进行编码,生成一系列的上下文向量,这些向量能够捕捉输入序列中各部分之间的关系。解码器则利用这些上下文向量,结合自身的编码状态,生成输出序列。

input_seq = [“Hello”, “World”]

output_seq = [“你好”, “世界”]

encoded_seq = encoder(input_seq)

decoded_seq = decoder(encoded_seq)在序列到序列的学习中,Transformer模型能够捕捉输入序列中单词之间的依赖关系,并预测输出序列中的下一个单词。这种学习机制使得Transformer在处理语言翻译等任务时表现出色。

Transformer模型引入了注意力机制(Attention Mechanism),这使得模型能够更好地理解输入序列中的上下文信息。

def attention(query, key, value):

# 计算注意力得分

scores = np.dot(query, key.T) / np.sqrt(key.shape[-1])

attention_weights = softmax(scores, axis=-1)

output = np.dot(attention_weights, value)

return output通过注意力机制,Transformer能够识别序列中每个单词的重要性,并据此分配不同的权重,这有助于模型更好地理解和处理复杂的语言结构。

与循环神经网络(RNN)相比,Transformer的一个显著优势是其并行处理能力。由于Transformer不依赖于序列的顺序处理,它可以同时处理整个序列,大大提高了训练效率。

Transformer模型在语言翻译领域表现出色,能够实现高质量的自动翻译。

def translate(input_text, model):

# 使用模型进行翻译

output_text = model(input_text)

return output_text在语言翻译中,Transformer需要处理不同语言之间的结构差异和语义变化。通过注意力机制和编码器-解码器架构,Transformer能够有效地解决这些问题。

Transformer还可以用于文档摘要,将长篇文章压缩为简短的摘要。

def summarize(document, model):

# 使用模型生成摘要

summary = model(document)

return summary在文档摘要任务中,Transformer需要识别文章中的关键信息,并生成包含这些信息的简短摘要。这要求模型具备强大的语义理解和压缩能力。

答:Transformer模型主要由编码器和解码器组成,编码器负责处理输入序列,解码器则基于编码器的输出生成目标序列。

答:注意力机制使Transformer能够识别序列中每个单词的重要性,并据此分配不同的权重,有助于模型更好地理解和处理复杂的语言结构。

答:Transformer模型通过注意力机制和编码器-解码器架构,能够有效地处理不同语言之间的结构差异和语义变化,实现高质量的自动翻译。

答:在文档摘要任务中,Transformer需要识别文章中的关键信息,并生成包含这些信息的简短摘要,这要求模型具备强大的语义理解和压缩能力。

答:Transformer模型不依赖于序列的顺序处理,可以同时处理整个序列,大大提高了训练效率,这是其并行处理能力的表现。