Phenaki API 价格:探索最新技术与市场趋势

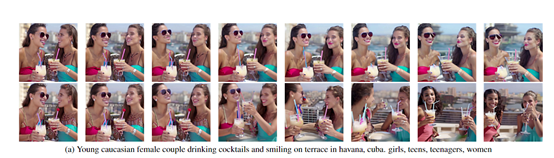

StreamingT2V 由 Picsart AI Research、德克萨斯大学和 SHI 实验室共同研发,旨在通过文本生成高质量的长视频。这一技术突破了传统视频生成模型的局限,以其独特的自回归技术框架,实现了视频长度的无限扩展,并在动作一致性和视频清晰度方面表现出色。研究显示,StreamingT2V 的生成视频不仅在时间一致性上优越,还能保持高质量的视觉效果。

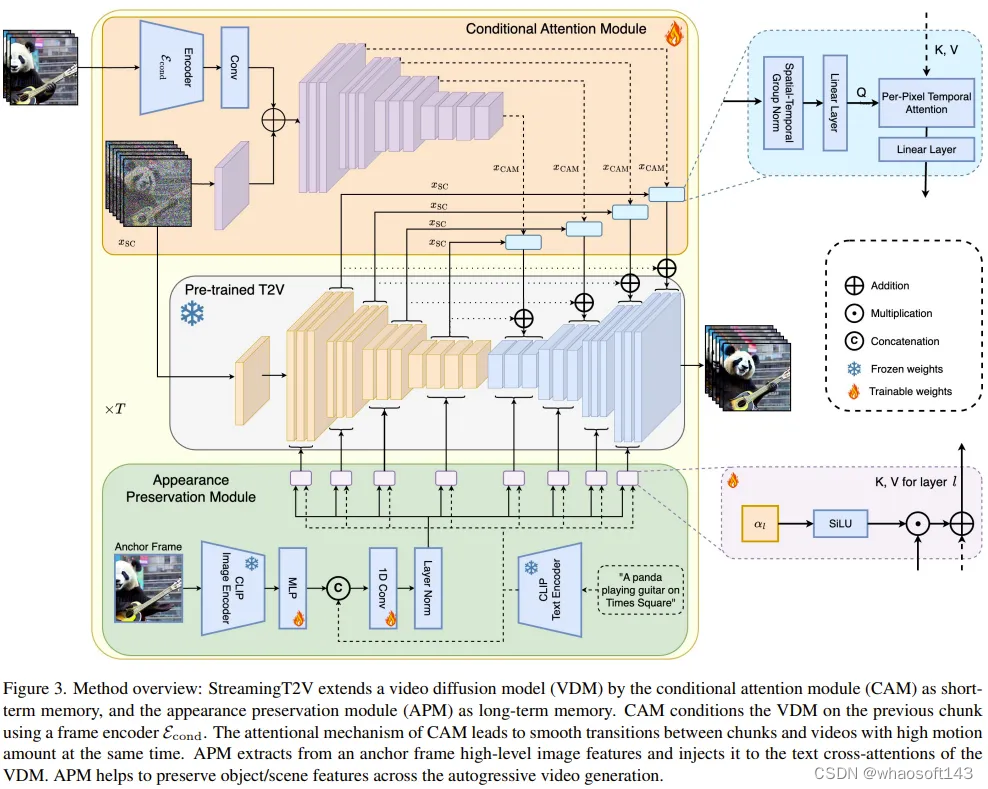

StreamingT2V 采用了一种创新的自回归技术框架,主要由条件注意力模块、外观保持模块和随机混合模块构成。通过这些模块的协同作用,StreamingT2V 能够实现视频的自然过渡和高质量生成。

条件注意力模块充当了短期记忆,通过从前一个视频块中提取特征信息,并将其注入到当前视频块的生成中,确保了视频之间的流畅过渡。这一模块特别适用于动作频繁的视频场景,能够使得视频看起来更加自然流畅。

外观保持模块作为长期记忆,专注于从视频的关键帧中提取重要的视觉特征,并贯穿整个视频生成过程,确保视频中的对象或场景保持一致性和连贯性。

随机混合模块在增强视频分辨率的过程中起到了关键作用。通过将低分辨率视频划分为多个重叠的视频块,并利用高分辨率视频模型进行增强,该模块能够显著提升视频的清晰度和视觉效果。

StreamingT2V 的工作流程可以划分为三个阶段:初始化阶段、流式生成阶段和流式优化阶段。每个阶段都对视频生成的不同方面进行优化和提升。

在初始化阶段,研究人员使用预训练的文本到视频模型生成视频的前 16 帧。这些帧作为视频的起始段落,为后续的生成过程奠定基础。

这一阶段通过自回归技术生成视频的后续帧。每个新帧的生成都会参考前一帧,从而确保视频内容的连贯性和一致性。

在流式优化阶段,研究人员对生成的长视频进行进一步优化。通过高分辨率的文本到短视频模型以及随机混合技术,提升视频的画质和动态效果。

StreamingT2V 的推出为 AI 视频生成领域带来了新的可能。其在娱乐、教育、培训等领域的应用潜力巨大,能够生成多样化、高质量的视频内容,满足用户的不同需求。

在娱乐领域,StreamingT2V 可以用于生成各种风格的视频作品,为创作者提供了更多的创作自由和可能性。

通过生成逼真的教学视频和模拟场景,StreamingT2V 能够为教育和培训提供直观、生动的学习体验,提高教学效果和学习效率。

StreamingT2V 计划开源,这将为研究者和开发者提供一个先进的技术框架,进一步推动 AI 视频生成技术的发展。

StreamingT2V 的代码结构清晰,模块化设计便于开发者理解和使用。其核心模块包括条件注意力模块、外观保持模块和随机混合模块。

各模块之间通过特定的接口进行数据传递和协作,以确保生成过程的连贯性和一致性。

尽管 StreamingT2V 在长视频生成方面表现出色,但仍然面临着一些挑战,包括视频质量的进一步提升和多样化。

StreamingT2V 的优势在于其创新的自回归框架和模块化设计,使得视频生成更加高效和灵活。

在视频质量和多样性方面,StreamingT2V 需要不断优化和升级,以应对日益增长的市场需求和技术竞争。

随着技术的不断进步,StreamingT2V 有望在更多领域获得应用,为用户带来更加丰富的视觉体验。

未来,随着算法的优化和硬件性能的提升,StreamingT2V 将不断提高视频生成效果,满足更多应用场景的需求。

随着视频生成技术的普及,StreamingT2V 将在市场中占据重要地位,并推动整个行业的发展。

StreamingT2V 采用了创新的自回归技术框架,能够生成长度可扩展且动作一致的视频,与其他技术相比,其在时间一致性和视觉效果上具有显著优势。

StreamingT2V 的开源代码即将发布,用户可以通过 GitHub 上的项目页面获取相关资源和文档。

StreamingT2V 能够生成逼真的教学视频和模拟场景,为教育提供直观的学习体验,提高教学效果和学生的参与度。

StreamingT2V 可应用于娱乐、教育、培训、模拟等多个领域,生成高质量的视频内容,满足不同用户的需求。

未来,StreamingT2V 将通过技术迭代和创新,进一步提升视频生成质量和多样性,拓展更多应用场景,推动视频生成技术的发展。