如何调用 Minimax 的 API

文生视频技术发展迅速,特别是随着StreamingT2V的推出,视频生成的长度和连贯性达到了新的高度。StreamingT2V以其创新的自回归技术框架和高效的模块组合,为我们展示了一个未来的视频生成蓝图。本文将深入探讨StreamingT2V的微调方法及其相关技术,揭示其在视频生成中的应用和潜力。

StreamingT2V是由Picsart AI Research、德克萨斯大学和SHI实验室共同开发的一种新的视频生成技术。它突破了传统短视频生成的限制,能够生成更加连贯和延长的视频。

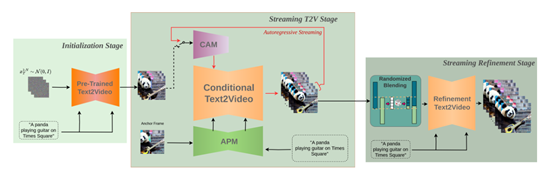

条件注意力模块(CAM)是StreamingT2V的核心组件之一,它负责处理短期记忆。通过从前一个视频段中提取特征,CAM确保了视频帧之间的连续性和流畅性。尤其在动作频繁的场景中,CAM能够有效地保持视频的自然过渡,使得视频看起来更加流畅。

外观保持模块(APM)则负责长期记忆,它从视频中的关键帧中提取重要的视觉特征,并确保这些特征在整个视频生成过程中保持一致性。这一模块能够保证视频中的对象和场景在不同片段中保持统一的视觉效果。

自回归技术是StreamingT2V视频生成的基础,其主要通过参考已生成的帧来生成新的帧,从而确保视频内容的连贯性。自回归技术不仅提高了视频的生成质量,还降低了生成长视频的计算成本。

为了进一步提高视频的质量,研究人员使用高分辨率的文生视频模型对生成的视频块进行自回归增强。通过在输入视频块中添加噪声,再使用扩散模型进行去噪,这种方法有效提高了视频的清晰度和视觉效果。

随机混合方法是StreamingT2V的一项创新,用于解决视频块之间的过渡不匹配问题。通过对重叠视频块中的帧进行随机混合,该方法能够有效避免视频在过渡处出现不自然的冻结和重复效果。

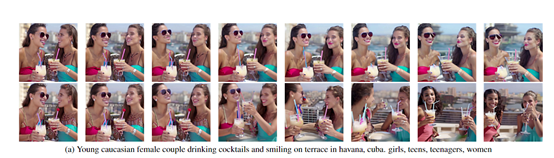

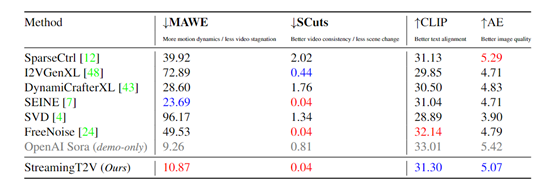

在评估过程中,StreamingT2V在时间一致性、文本对齐和每帧质量上表现优异。与其他模型相比,StreamingT2V不仅在各项评估指标上取得了领先,还在无缝视频块过渡和运动一致性方面表现出色。

随着StreamingT2V的不断发展,微调方法将进一步提升视频生成的多样性和复杂性。这种微调不仅可以提高视频的视觉效果,还能满足不同场景和应用的需求。

通过StreamingT2V的持续发展,我们将看到一个更加丰富多彩的视频生成世界,其应用将覆盖从娱乐到教育的各个领域。