如何调用 Minimax 的 API

Stable Video Diffusion 是由 Stability AI 推出的创新型视频生成技术,它基于图像模型 Stable Diffusion 发展而来,旨在通过简单的图片输入生成流畅的视频内容。这一技术的发布标志着视频生成的一个新纪元,为创意工作者和开发者提供了全新的工具。

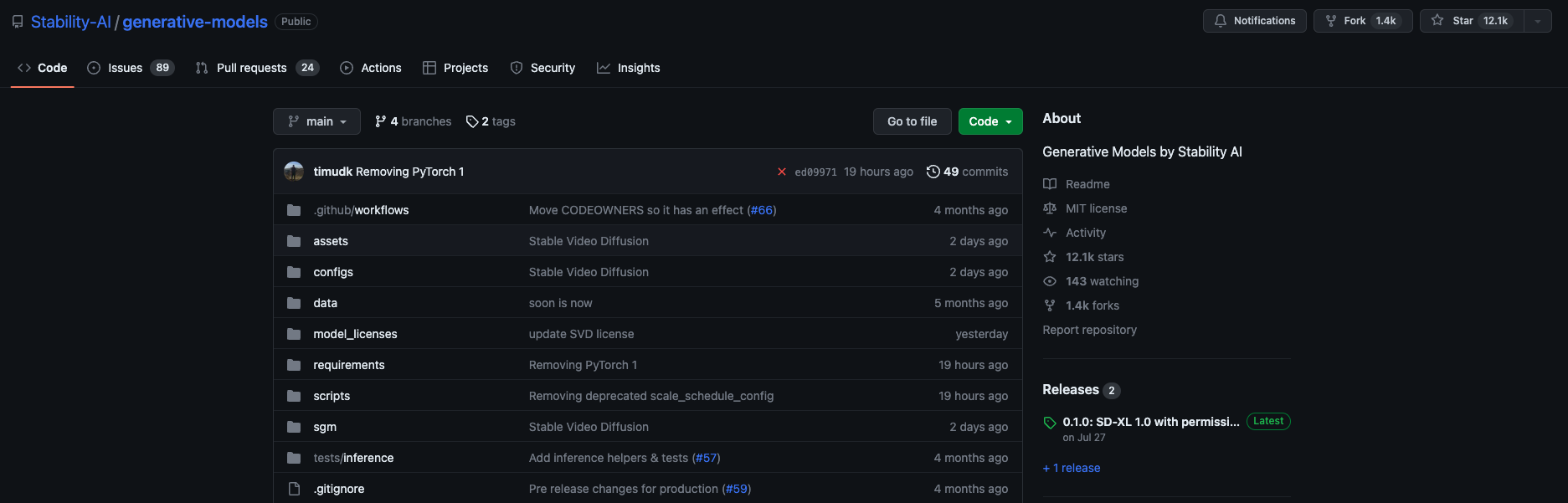

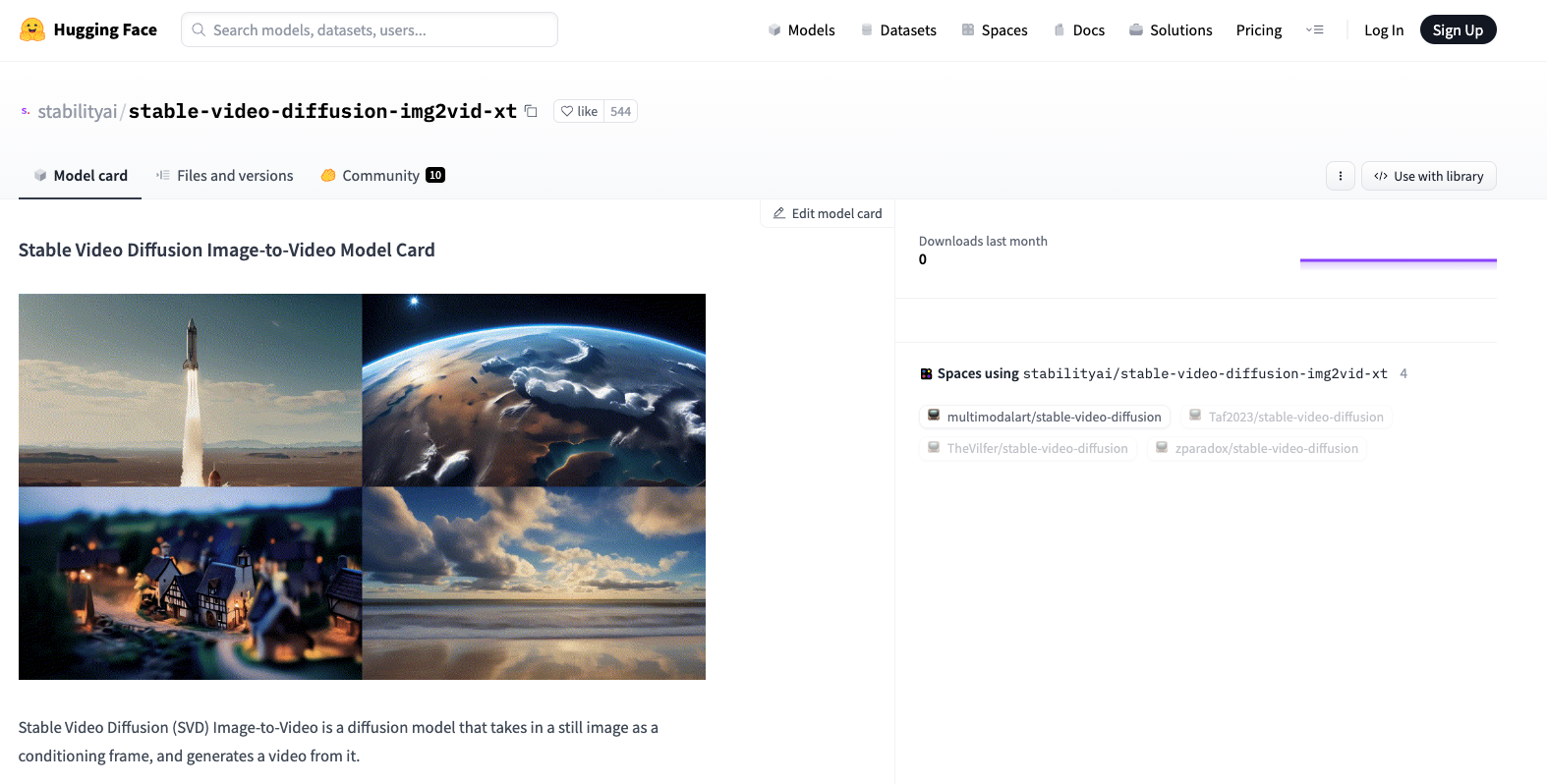

Stability AI 已经在 GitHub 上开源了该技术的代码,并在 Hugging Face 提供了模型的权重文件。这使得开发者可以在本地机器上运行并优化模型,进一步满足个性化需求。

在当今快速发展的数字化环境中,API 的申请和使用变得越来越重要。Stable Video Diffusion API 的推出,为开发者和企业提供了便捷的接口来访问其强大的视频生成功能,简化了从图片到视频的转换过程。

其背后的技术依托于深度学习和扩散模型,通过逐步噪声添加和去除的方法,模型能够从静态图像生成动态视频。这种转换不仅为创作者提供了新的表达方式,也为商业应用提供了更多可能。

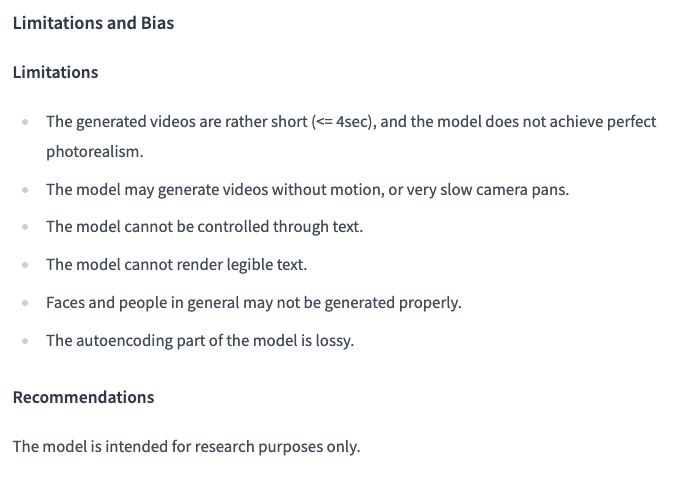

尽管该技术在视频生成领域取得了显著进展,但仍然存在一些局限性需要注意:

这些局限性部分是由于模型自编码时的损耗引起的,未来的版本可能会通过优化算法和增加数据集来改善这些问题。

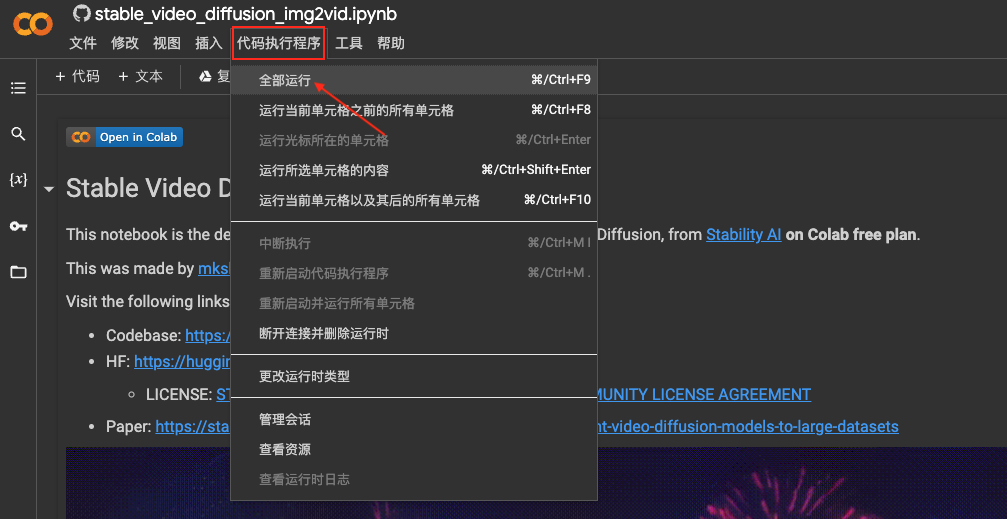

申请 Stable Video Diffusion API 的过程相对简单,开发者可以通过访问 Stability AI 的官方网站提交申请,并获得相应的 API 密钥。以下是使用 API 的基本步骤:

pip install torch torchvision访问 Stability AI 官网申请 API 密钥。拥有密钥后,开发者可以在 API 请求中使用它来验证身份。

import requests

url = 'https://api.stability.ai/v1/video'

headers = {'Authorization': 'Bearer YOUR_API_KEY'}

files = {'file': open('image.jpg', 'rb')}

response = requests.post(url, headers=headers, files=files)

video_output = response.json()['video_url']

Stable Video Diffusion 的应用范围广泛,从创意设计到企业广告,它都能发挥重要作用。例如,通过将风景图片转换为视频,可以为旅游宣传提供生动的视觉素材。

假设我们有一张美丽的山景图片,使用 Stable Video Diffusion,可以将其转换为一个动态的视频片段,展示云层和阳光的变化。

python generate_video.py --input_folder input_images --output_video output_video.mp4Stable Video Diffusion 技术的未来发展方向包括提升视频的清晰度、增加生成长度以及改善文本控制等功能。这需要不断优化模型算法和扩展数据集以满足日益增长的市场需求。

答:可以尝试增加输入图片的分辨率,并调整生成参数中的噪声水平来优化视频的清晰度。

答:目前 API 支持批量处理,但具体性能可能会受限于服务器资源。

答:确保 API 请求中包含正确的 API 密钥,并检查密钥的有效期和权限范围。

答:目前,Stable Video Diffusion 主要用于研究目的,商业化应用需获得 Stability AI 的授权。

答:可以使用更高性能的计算设备,或者通过优化输入数据和参数配置来提升生成速度。

通过以上内容,我们详细探讨了 Stable Video Diffusion 的申请、使用及其在视频生成领域的应用潜力。相信随着技术的不断进步,它将在更多领域展现出其强大的影响力。