Optuna使用详解与案例分析

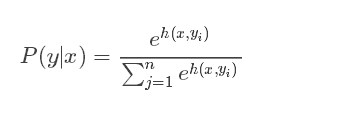

Softmax函数,作为机器学习和深度学习中的核心组件,对于多分类问题的处理至关重要。本文将深入探讨Softmax函数的定义、计算方法、数值稳定性问题及其解决方案,并探讨其在PyTorch框架中的应用。

Softmax函数是一种将实数向量压缩到(0,1)区间内的K维向量的方法,其中所有元素的和为1。这个特性使得Softmax在多分类问题中,作为输出层的概率分布估计,得到了广泛的应用。

Softmax函数实际上是有限项离散概率分布的梯度对数归一化。这个性质使得Softmax函数在多项逻辑回归、多项线性判别分析等多种基于概率的多分类问题方法中都有着广泛的应用。

对于二分类任务,我们通常使用Sigmoid函数。但是,当任务拓展到多分类时,Softmax函数就显得尤为重要。它能够将一个N维向量映射到另一个N维向量,其中每一维对应一个分类结果的概率。

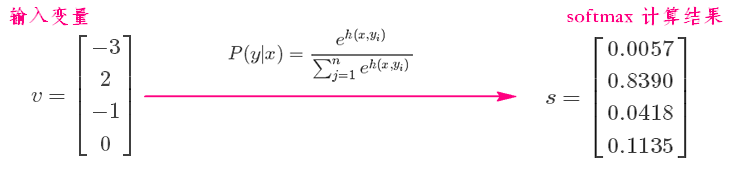

Softmax函数的输出表征了不同类别之间的相对概率。例如,对于一个包含三个类别的分类问题,Softmax函数可以清晰地展示每个类别的概率分布。

在实际应用中,Softmax函数的代码实现相对简单。以下是一个使用NumPy库实现Softmax函数的例子。

import numpy as np

def softmax(x):

"""Compute softmax values for each sets of scores in x."""

e_x = np.exp(x)

return e_x / e_x.sum()

if __name__ == '__main__':

x = np.array([-3, 2, -1, 0])

res = softmax(x)

print(res) # [0.0056533 0.83902451 0.04177257 0.11354962]Softmax函数在使用指数函数时,很容易遇到数值溢出的问题。为了解决这个问题,我们可以采用一些技巧,比如从每个指数中减去最大的值,从而避免指数函数的数值溢出。

import numpy as np

def softmax(x):

"""Compute softmax values for each sets of scores in x."""

exps = np.exp(x - np.max(x))

return exps / np.sum(exps)在PyTorch框架中,nn.CrossEntropyLoss()已经集成了Softmax函数。这意味着在使用nn.CrossEntropyLoss()作为损失函数时,网络的最后一层不需要也不能再加Softmax层。

nn.CrossEntropyLoss()作为损失函数时,不需要在网络的最后一层额外添加Softmax层,因为nn.CrossEntropyLoss()已经集成了Softmax函数。