AI视频剪辑工具:解锁创作的无限可能

Sigmoid函数,以其独特的S形曲线和在逻辑回归、人工神经网络等领域的广泛应用而闻名。本文深入探讨Sigmoid函数的数学特性、在逻辑回归中的应用、以及为何Sigmoid函数成为机器学习中的优选。

Sigmoid函数的数学表达式为:

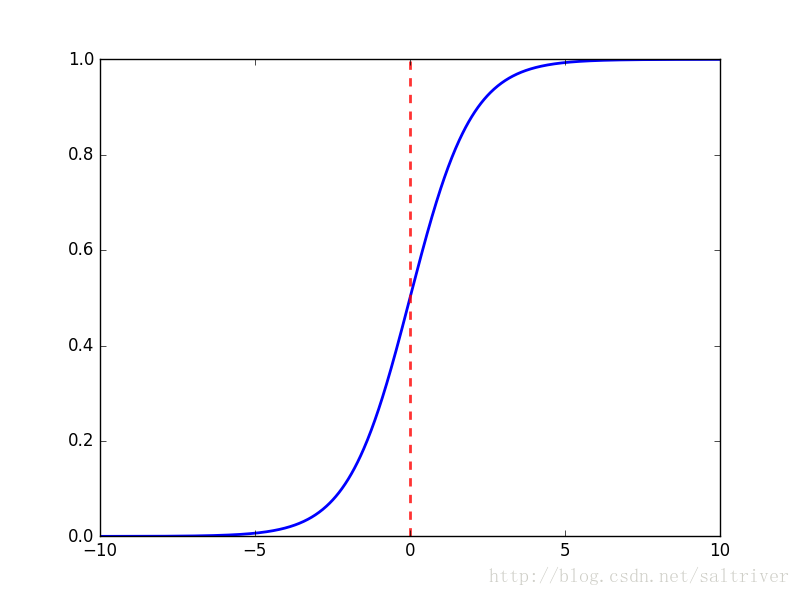

f(x) = 1 / (1 + e^(-x))这个函数以其优美的S形曲线而著称,其图像如下所示:

Sigmoid函数连续、光滑、严格单调,以(0,0.5)为中心对称,是一个非常良好的阈值函数。

Sigmoid函数的值域限制在(0,1)之间,这与概率值的范围相对应,使得Sigmoid函数能够与概率分布联系起来。

逻辑回归(LR)模型是一个二分类模型,它通过Sigmoid函数将线性组合的特征映射到概率空间。Sigmoid函数在此扮演了将线性模型的输出转换为概率预测的关键角色。

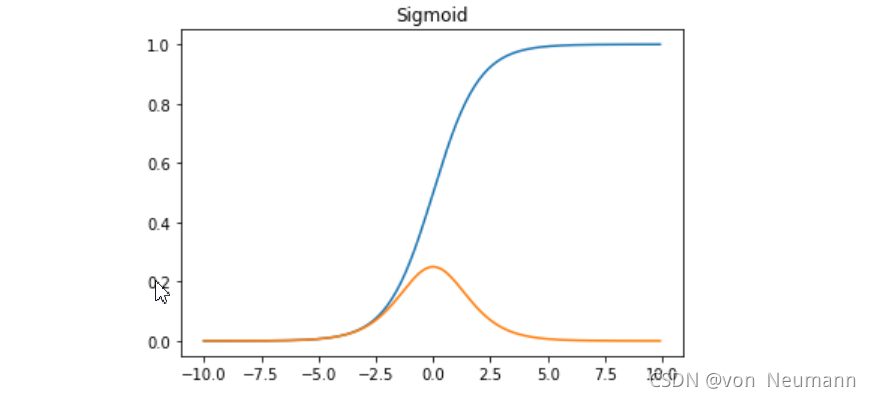

Sigmoid函数的导数是其本身的函数,即:

f'(x) = f(x) * (1 - f(x))这种性质使得在优化过程中计算梯度变得非常方便,节省了计算时间。

Sigmoid函数的输出可以直接解释为概率,这为模型的解释性和结果的理解提供了极大的便利。

Sigmoid函数因其数学上的处理便利性和推导特性,成为逻辑回归模型的首选。它不仅满足LR模型对函数的两个基本要求——取值范围在0~1之间,且在0.5处中心对称——还因其单调性和可微性,成为连接线性模型和概率预测的理想选择。

正态分布解释和最大熵解释提供了Sigmoid函数选择的另一种视角。正态分布因其普遍性,在未知概率分布形式时成为首选。Sigmoid函数因其与正态分布积分形式的相似性,成为计算上更优的替代。最大熵解释则从信息论的角度,解释了在给定假设下,为何Sigmoid函数能够提供最均匀的分布。

通过图像,我们可以直观地看到Sigmoid函数的形状及其导数的变化,这有助于我们更好地理解其在模型中的应用和影响。

通过上述分析,我们可以看到Sigmoid函数在机器学习中的重要性和应用。虽然它有其局限性,但在适当的场景下,Sigmoid函数仍然是一个强大的工具。