PixVerse V3 API Key 获取:全面指南与实践

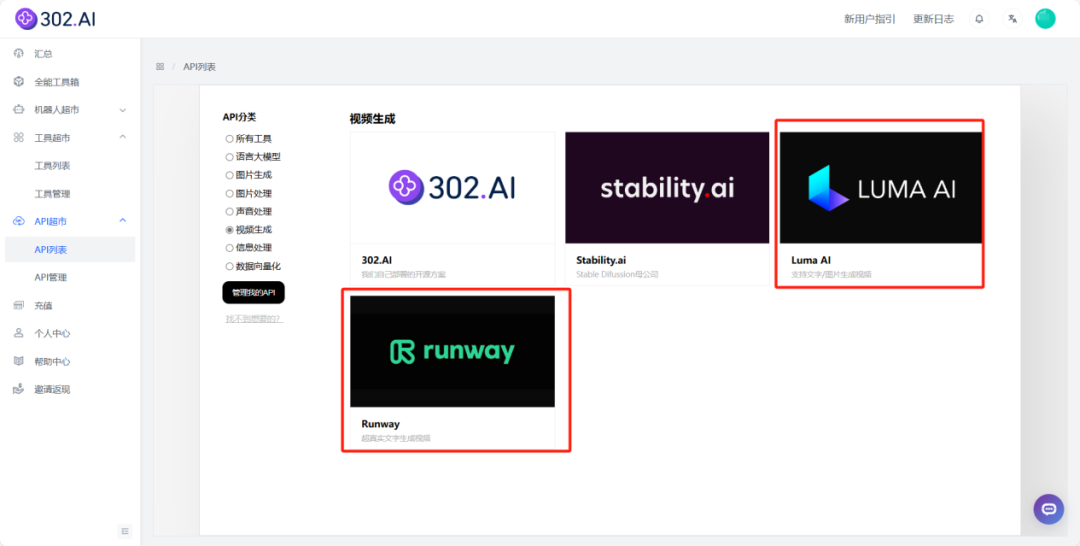

RunwayML 是一个强大的多功能平台,旨在为创作者提供简单易用的 AI 工具。其核心功能之一是 RunwayML API,这是一种强大的工具,可以帮助开发者通过 API 接口轻松集成和调用 AI 模型。这些模型可以用于各种应用场景,包括生成、编辑和增强视频内容。RunwayML API 的最大优势在于其灵活性和易用性,允许用户通过简洁的 API 调用来实现复杂的 AI 操作。

RunwayML API 设计良好,支持多种编程语言和框架,使其易于集成到现有的开发环境中。通过提供详尽的 API 文档和在线调试功能,开发者可以快速上手并实现自己的创意。此外,RunwayML API 还支持按需付费模式,用户可以根据自己的使用情况灵活选择支付方式,避免不必要的开支。

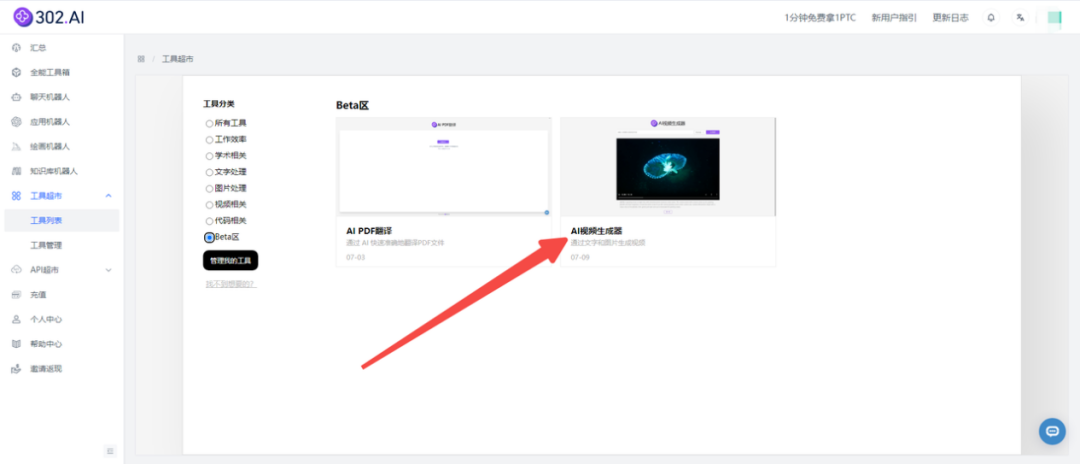

文生视频是一种利用 AI 技术从文本生成视频的创新技术。其核心在于使用自然语言处理和计算机视觉技术,将文本描述转化为动态的视频内容。这种技术的应用场景广泛,包括广告制作、教育视频、娱乐内容等。

在文生视频的生成过程中,AI 模型会分析输入的文本描述,并结合预训练的视觉数据生成视频。生成的视频不仅需要满足文本描述的内容要求,还需保持视觉上的连贯性和流畅性。随着科技的发展,文生视频技术的生成效果已越来越逼近真人拍摄的视频,无论是在画质还是在细节处理上都有了显著的提升。

通过结合 RunwayML API 和文生视频技术,开发者可以在应用程序中实现自动化视频生成功能。这种结合为用户提供了一种极其便利的方式来创造视频内容,特别是在需要快速生成大量视频的场景中,如社交媒体内容更新和广告制作。

使用 RunwayML API,用户只需提供简单的文本描述,即可调用 AI 模型生成高质量的视频。这种自动化流程不仅节省了大量的人力和时间成本,还提高了创作效率,与传统视频制作方法相比具有不可忽视的优势。

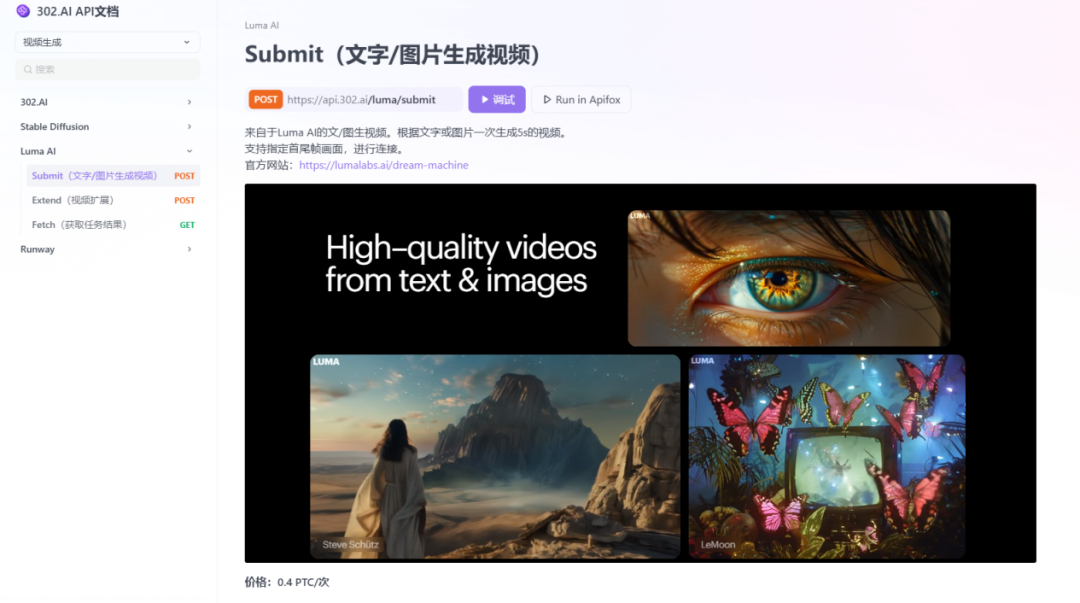

使用 RunwayML API 生成视频的过程相对简单,通常包括以下几个步骤:

准备文本描述:首先,用户需要根据需求撰写详细的文本描述,描述中应包括视频的主题、场景和风格等信息。

调用 RunwayML API:使用编程语言(如 Python)调用 RunwayML API,发送文本描述请求视频生成。

接收和处理视频:API 返回生成的视频之后,用户可以对其进行进一步的编辑或增强,以满足具体的应用需求。

以下是一个简单的 Python 代码示例,展示如何使用 RunwayML API 生成视频:

import requests

api_url = "https://api.runwayml.com/v1/models/video-generation"

headers = {

"Authorization": "Bearer YOUR_ACCESS_TOKEN",

"Content-Type": "application/json"

}

data = {

"description": "在黄昏时分的森林背景中,静静燃烧的篝火"

}

response = requests.post(api_url, headers=headers, json=data)

if response.status_code == 200:

video_url = response.json().get("video_url")

print(f"生成的视频URL: {video_url}")

else:

print("视频生成失败", response.json())在 AI 视频生成领域,除了 RunwayML,还有其他几款知名模型,如 Sora、Pika 和 StableVideo。这些模型各有优劣,适用于不同的应用场景。

Sora 是 OpenAI 开发的一款视频生成模型,其特点是可以生成时长更长且画质更高的视频。Sora 采用了 Transformer 架构,与传统的扩散模型相比,能够更好地保持视频的连贯性和细节。

Pika 和 StableVideo 也是 AI 视频生成的热门选择。Pika 专注于视频的快速生成,而 StableVideo 则以其稳定性和可靠性著称。这两款模型在生成短视频方面表现出色,适合需要快速输出的场景。

RunwayML API 的应用场景非常广泛,其灵活性和强大的功能使其在多个领域得到了广泛应用。例如:

广告制作:通过快速生成高质量的视频广告,帮助企业在短时间内推出新产品或促销活动。

教育视频:自动生成教育视频,减少教师的工作量,提高课程制作效率。

社交媒体:为社交媒体平台提供源源不断的视频内容,满足用户的多样化需求。

随着 AI 技术的不断进步,文生视频和 AI 视频生成的未来充满了可能性。未来的发展方向包括:

RunwayML API 是一个提供 AI 模型调用的接口,用户可以通过该接口生成、编辑和增强视频内容。

使用 RunwayML API 生成视频需要准备好文本描述,通过 API 调用生成,然后接收和处理生成的视频。

文生视频可用于广告制作、教育视频和社交媒体内容生成等多个领域。

RunwayML API 提供了灵活的付费模式、易用的接口和强大的视频生成能力,是创作者和开发者的不二选择。

其他模型如 Sora、Pika 和 StableVideo 各有特点,Sora 专注长视频生成,Pika 和 StableVideo 适合快速生成短视频。