DeepSeek Janus-Pro 应用代码与图片链接实践

大模型技术近年来在人工智能领域显示出了巨大的潜力,尤其是在自然语言处理和计算机视觉任务中。随着技术的不断进步,大模型正在逐步应用于更复杂的场景,比如文本生成、图像生成以及多模态任务。AltDiffusion作为其中的一个重要模型,凭借其在文本到图像生成中的出色表现,成为了业界关注的焦点。基于AltDiffusion的RAG系统,通过结合多模态信息处理技术,能够实现更加智能化的内容生成和信息检索。

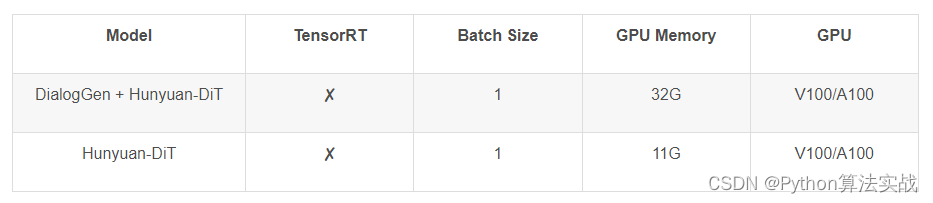

混元DiT是一种基于Diffusion transformer的模型,专注于文本到图像的生成。这个模型的设计初衷是为了能够在中英文语境中均具备细粒度的理解能力。它通过优化的Transformer结构、文本编码器和位置编码,建立了完整的数据管道,从而能够高效地进行模型优化迭代。混元DiT的优势在于其强大的多轮对话能力和细粒度的语义理解,这使得它能够根据用户的上下文生成符合需求的图像。

要运行混元DiT模型,首先需要确保你的环境中安装了Python 3.10及以上版本,以及PyTorch 2.0及以上版本。这些版本的依赖确保了模型能够在最新的技术优化下运行,从而提供最佳的性能和效率。

克隆代码到本地:

git clone https://github.com/tencent/HunyuanDiT

cd HunyuanDiT

pip install loguru==0.7.2下载模型:

git clone https://www.modelscope.cn/modelscope/HunyuanDiT.git下载依赖的clip-vit-large-patch14-336模型:

git clone https://www.modelscope.cn/AI-ModelScope/clip-vit-large-patch14-336.git ./openai/clip-vit-large-patch14-336修改代码并运行推理接口:

python sample_t2i.py --prompt "渔舟唱晚"

混元DiT在处理中文prompt时展现了强大的能力。通过测试,我们发现该模型对成语、古诗等的出图效果稳定且高分辨率。尤其是在单张图中包含多个实体时,模型依然能够保持良好的出图质量。这显示了混元DiT在中文理解和表达上的优势。

在技术领域,分享和交流至关重要。我们成立了算法面试和技术交流群,提供相关资料、技术交流和答疑。通过加入我们的交流群,用户可以与超过2000名群友进行交流,获取志同道合的朋友和专业的技术支持。

NNI和AdaNet是分别由微软和谷歌发布的开源工具包,主要用于自动化机器学习和神经网络架构的优化。它们的出现极大地简化了机器学习项目中的超参数调整和模型优化过程,使得开发者能够更加专注于模型的创新和应用。

Vicuna-13B和Yi系列模型是近年来广受欢迎的开源对话模型。它们在多个行业中得到了广泛应用,尤其是在客户服务、教育和金融行业中。凭借强大的对话生成能力和多语言处理能力,这些模型成为了行业中不可或缺的工具。

BERT模型以其卓越的双向上下文处理能力而著称,在各种自然语言处理任务中表现出色。然而,其模型较大,需要较多的计算资源和时间进行训练。与之相比,GPT模型则以其强大的生成能力闻名,尤其在对话系统和摘要生成任务中表现突出。

RoBERTa是对BERT模型的优化版本,特别关注大规模数据和超参数调优。它在各种NLP任务上展现了惊人的性能和泛化能力,但同样需要大量的计算资源进行训练和微调。

国内的开源大模型如讯飞星火、文心一言和ChatGLM等,正在不断推动人工智能技术的发展。这些模型不仅具备强大的语言理解和生成能力,还在多模态任务中展现出色。例如,文心一言具备听懂复杂提示词和代码理解的能力,而ChatGLM则支持多轮对话和多模态能力。

为了更好地掌握大模型技术,可以从系统设计入手,逐步学习提示词工程、平台应用开发和知识库应用开发等内容。此外,借助成熟的大模型平台,开发者可以更快地构建适合自己领域的应用。

丰富的学习资源对于大模型的掌握至关重要。通过观看视频教程和阅读技术文档,开发者可以深入理解大模型的原理和应用场景,从而在实际项目中灵活运用这些技术。

问:什么是AltDiffusion?

问:如何安装混元DiT模型?

问:大模型在实际应用中有哪些优势?

问:如何选择适合的开源大模型?

问:大模型如何支持多语言处理?