PixverseAI互动功能(HUG)在AI拥抱视频生成中的应用

Qwen2.5-Max 是一种新型大型 Mixture-of-Expert (MoE) 模型,旨在通过超大规模的数据和模型规模的扩展,提升模型的智能水平。本文将深入探讨 Qwen2.5-Max 的性能、使用方法及未来发展方向,并提供相关的下载地址信息和图文详解。

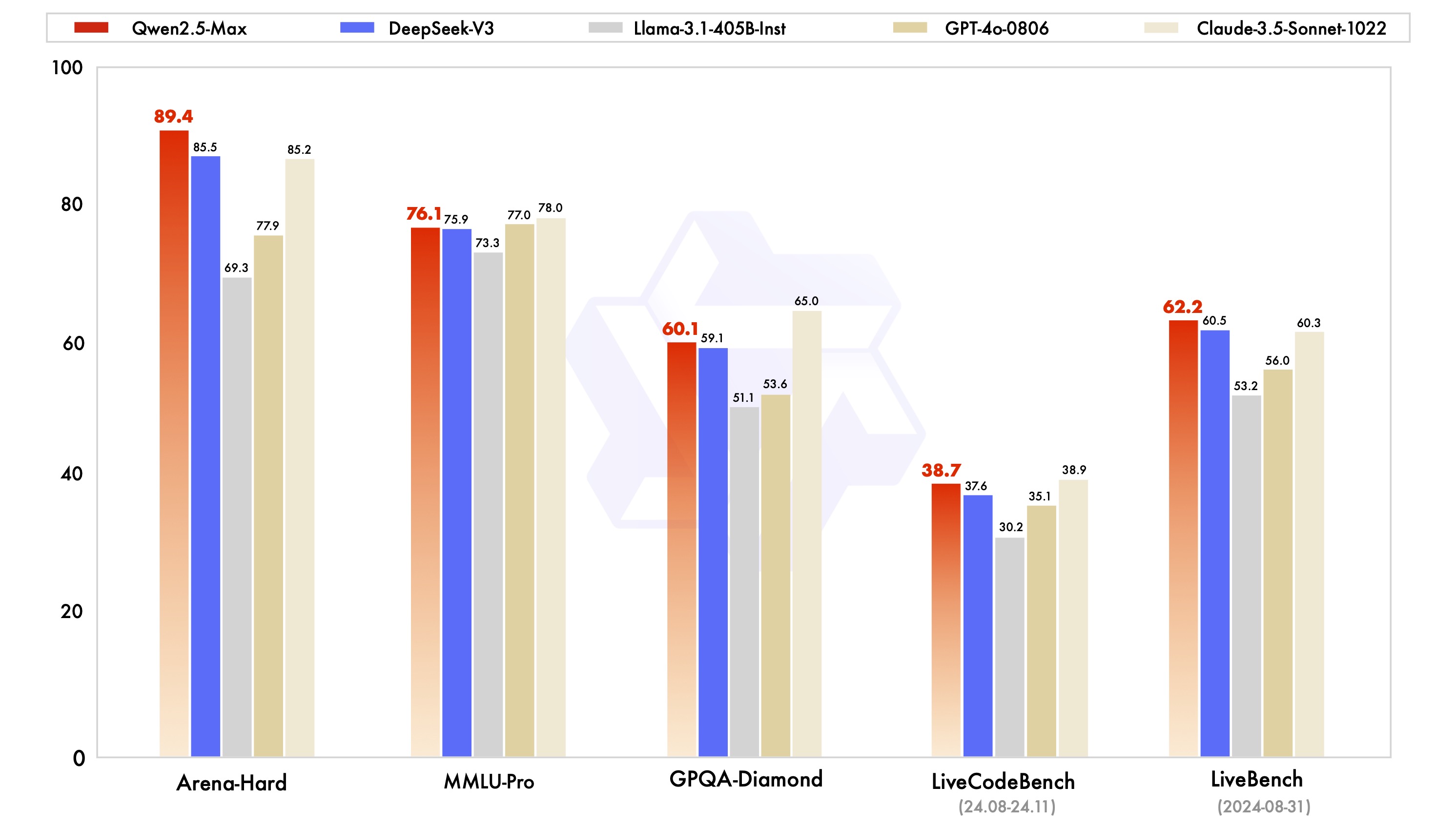

Qwen2.5-Max 在多个基准测试中表现出色,这些基准测试包括 MMLU-Pro、LiveCodeBench、LiveBench 和 Arena-Hard。这些测试旨在评估模型在大学水平的问题解决能力、编码能力、综合能力以及对人类偏好的近似程度。

在 Arena-Hard、LiveBench、LiveCodeBench 和 GPQA-Diamond 等基准测试中,Qwen2.5-Max 超越了 DeepSeek V3,并且在 MMLU-Pro 等其他测试中也展现了强劲的竞争力。值得注意的是,这些测试不仅检验了模型的知识储备和应用能力,还考察了其在实际任务中的表现。

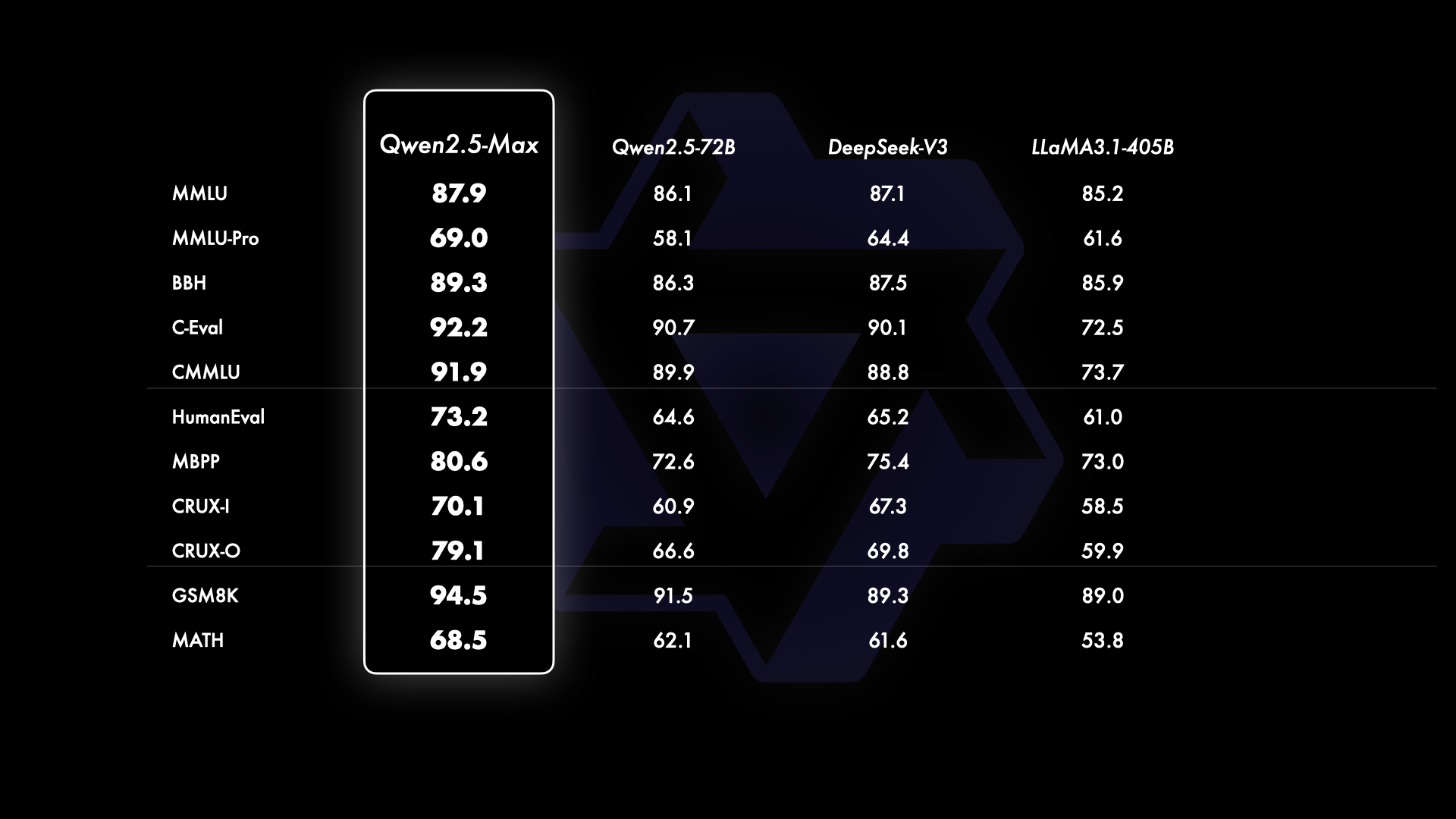

在与其他顶尖模型的比较中,Qwen2.5-Max 展现了显著的性能优势。尤其是在无法访问 GPT-4o 和 Claude-3.5-Sonnet 等专有模型的情况下,Qwen2.5-Max 依然在与 DeepSeek V3、Llama-3.1-405B 和 Qwen2.5-72B 等开源模型的对比中脱颖而出。

Qwen2.5-Max 已经在 Qwen Chat 平台上上线,用户可以直接与模型对话、进行搜索或其他操作。同时,其 API 也已开放,用户可以通过注册阿里云账户并激活 Model Studio 服务来获取 API 密钥。

要使用 Qwen2.5-Max 的 API,用户需要首先注册一个阿里云账户,然后在控制台中创建一个 API 密钥。Qwen 的 API 兼容 OpenAI API,用户可以直接按照常见的 OpenAI API 使用方法进行操作。

from openai import OpenAI

import os

client = OpenAI(

api_key=os.getenv("API_KEY"),

base_url="https://dashscope-intl.aliyuncs.com/compatible-mode/v1",

)

completion = client.chat.completions.create(

model="qwen-max-2025-01-25",

messages=[

{'role': 'system', 'content': 'You are a helpful assistant.'},

{'role': 'user', 'content': 'Which number is larger, 9.11 or 9.8?'}

]

)

print(completion.choices[0].message)用户可以通过访问阿里云的 Model Studio 页面获取 Qwen2.5-Max 的下载地址。该页面提供了所有必要的文档和下载链接,确保用户可以顺利下载和部署模型。

Qwen2.5-Max 的开发不仅展示了在模型智能方面的进步,也体现了我们在前沿研究方面的不懈努力。我们致力于通过规模化的强化学习,提升大语言模型的思考和推理能力。

数据和模型规模的扩展是提升模型性能的关键因素。在未来的开发中,我们将继续探索这些技术的潜力,以实现超越人类智能的目标。

通过应用大规模的强化学习,我们希望让模型能够探索未知的知识领域,并在复杂的任务中取得突破。这一努力将为人类理解和应用知识带来新的可能性。

Qwen2.5-Max 可以在 Qwen Chat 平台上使用,同时其 API 可用于各种应用开发,支持与 OpenAI API 兼容的操作环境。

用户可以通过访问阿里云 Model Studio 的官方页面获取 Qwen2.5-Max 的下载地址和相关文档。

Qwen2.5-Max 的开发目标是通过大规模的模型和数据扩展,提升模型的智能水平,并通过强化学习技术,增强其思考和推理能力。

是的,使用 Qwen2.5-Max 的 API 需要一定的编程技能,特别是在 Python 环境下进行 API 调用和集成开发。

Qwen2.5-Max 的主要竞争优势在于其在多个基准测试中的卓越表现,以及其在大规模数据处理和模型智能方面的领先能力。