JSON 文件在线打开指南

Qwen接口是一种面向大型语言模型(LLM)的高吞吐量和内存高效的推理和服务引擎。它为开发者提供了一种便捷的方式来部署和管理大规模模型,同时支持多种功能,如流式输出、联网搜索和长文档解读等。

Qwen接口的设计目标是为了优化大模型的推理效率,降低内存占用,并提供强大的API接口来支持各种应用场景。这些接口在开放平台上发布,用户可以通过多种方式进行访问和集成。项目的开源性质使得开发者可以自由使用和改进,从而提升自己的应用开发能力。

Qwen接口的流式输出功能允许实时生成文本,这在创作领域有着广泛的应用。用户可以利用这一特性来满足各种创作需求,无论是生成文章、故事,还是其他类型的文本内容。通过对模型的优化,Qwen接口能够在短时间内提供高质量的文本输出。

这种流式输出不仅提高了文本生成的速度,还保证了输出内容的连贯性和逻辑性。开发者可以通过API调用来实现这一功能,并根据自己的实际需要进行定制化开发。

在应用场景方面,流式输出可以用于在线客服、智能助手等需要实时响应的应用中。通过Qwen接口,开发者能够轻松实现这些功能,并根据业务需求进行灵活调整。

Qwen接口通过整合搜索引擎,实现了联网搜索功能。用户可以在不离开应用的情况下获取海量信息,满足多种信息获取需求。这一功能的实现,使得Qwen接口在信息检索和知识获取方面具有显著优势。

联网搜索功能可以被集成到各种应用中,如新闻聚合器、知识库系统等,帮助用户在短时间内获取所需的信息。此外,Qwen接口的联网搜索功能还支持多种搜索策略,用户可以根据需要进行选择。

Qwen接口还提供了长文档解读功能,帮助用户快速理解长篇文章的要点。通过智能分析和总结技术,Qwen接口能够自动提取文中的关键信息,并生成简明的摘要。

这种长文档解读功能适用于需要处理大量文档的场景,如法律分析、学术研究等。使用这一功能,用户可以大大提高信息处理的效率,并获得更准确的结果。

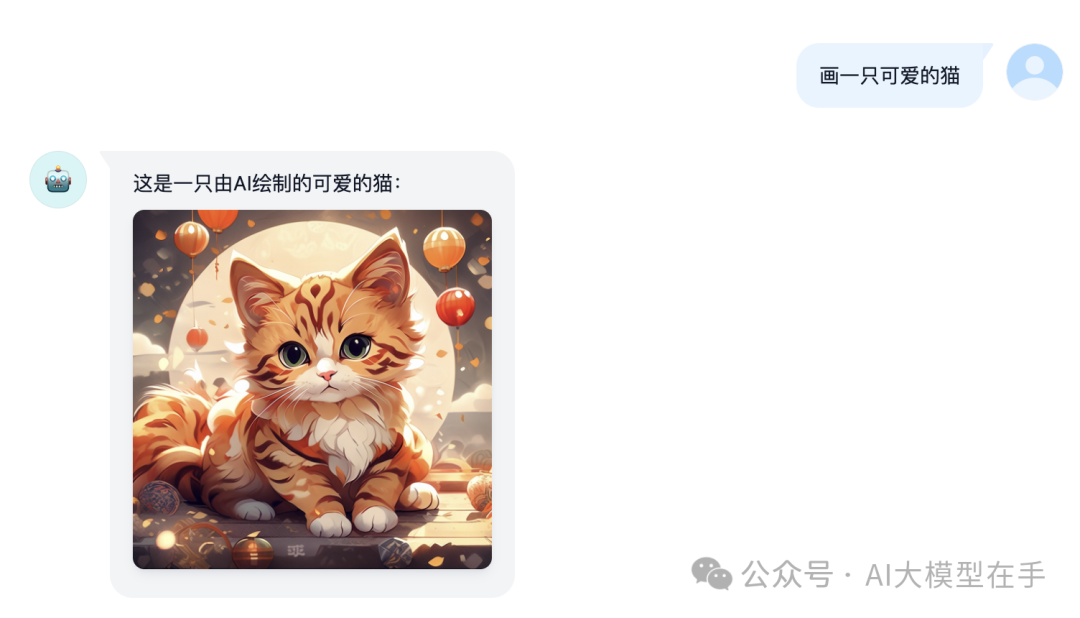

Qwen接口的图像解析功能可以从图像中提取信息,帮助用户在视觉数据中洞察先机。通过先进的图像分析技术,Qwen接口可以识别图像中的对象、文字等,并将其转化为结构化数据。

这一功能在各类需要处理图像数据的应用中有着广泛应用,如图像搜索、智能监控等。用户可以通过API接口调用这一功能,并根据实际需要进行定制化开发。

Qwen接口支持多轮对话功能,使用户能够与模型进行自然流畅的对话交流。这一功能的实现,极大地提升了用户体验,并为智能助手、聊天机器人等应用提供了技术基础。

通过多轮对话功能,用户可以与模型进行复杂的交互,获得更为详尽的回答。这一功能在客户服务、教育咨询等领域有着广泛应用。

Qwen接口支持多路token,帮助用户解除并发限制,提高应用的并发处理能力。这一功能在需要同时处理大量请求的应用中尤为重要,如在线客服、实时监控等。

通过多路token支持,用户可以更高效地分配资源,确保应用在高负载情况下仍能稳定运行。开发者可以根据需求灵活配置这一功能,提升应用的整体性能。

Qwen接口自动清理会话痕迹,保护用户隐私安全。这一功能对于需要处理敏感信息的应用至关重要,如医疗咨询、金融服务等。

通过隐私保护功能,用户可以放心地在应用中进行交互,而不必担心信息泄露。Qwen接口在隐私保护方面的设计,充分考虑了用户的安全需求,为应用的广泛使用提供了保障。

Qwen接口支持多种部署方式,包括本地部署、Docker部署等。用户可以根据自身条件选择合适的部署方案,快速将Qwen接口集成到自己的应用中。

本地部署适合于开发和测试阶段,用户可以在自己的机器上运行服务,而无需依赖外部环境。Docker部署则适用于生产环境,通过容器化技术,用户可以轻松地在各种平台上运行Qwen接口。

docker run -it -d --init --name qwen-free-api -p 8000:8000 -e TZ=Asia/Shanghai vinlic/qwen-free-api:latestQwen接口的零配置部署特性,使得用户可以在最短时间内实现功能上线。这一特性对于初创企业和开发团队尤为重要,能够帮助他们快速验证产品概念,并在市场中占据先机。

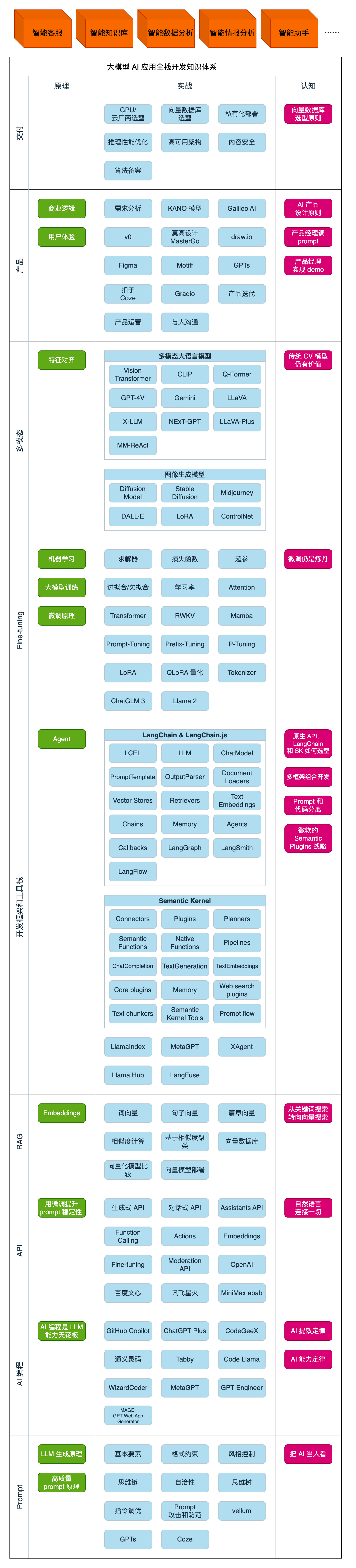

学习大模型AI是一个不断进步的过程,Qwen接口为学习者提供了丰富的资源和工具。通过使用Qwen接口,用户可以深入了解大模型AI的工作原理,并基于此开发出更为复杂的应用。

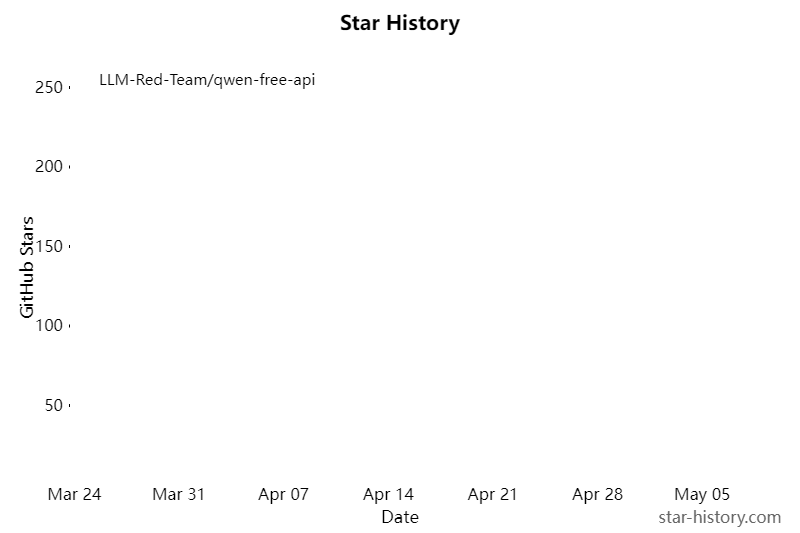

Qwen接口的开源社区为学习者提供了交流和分享的平台,用户可以在这里找到相关的文档、教程和示例代码,帮助他们更好地掌握大模型AI的技术。

随着AI技术的迅速发展,掌握大模型AI的能力已成为个人职业发展的重要竞争力。通过学习和使用Qwen接口,用户可以在技术领域保持领先,提升自身的价值和市场竞争力。

答:Qwen接口提供了流式输出、联网搜索、长文档解读、图像解析、多轮对话等功能,支持多路token和隐私保护,适用于多种应用场景。

答:Qwen接口支持多种部署方式,如本地部署和Docker部署。用户可以根据实际需求选择合适的部署方案,快速实现应用的上线。

答:Qwen接口通过自动清理会话痕迹来保护用户隐私。用户可以放心使用接口进行信息交互,而不必担心信息泄露。

答:Qwen接口的开源社区为用户提供了丰富的文档、教程和示例代码,帮助用户更好地掌握和使用接口技术。

答:通过学习和使用Qwen接口,用户可以深入掌握大模型AI技术,提高在技术领域的竞争力,并在职业发展中占据优势。