OneAPI接口调用的实操指南

OneAPI的基本概念

OneAPI是一个接口管理和分发系统,旨在通过标准的OpenAI API格式访问多种大模型,如OpenAI ChatGPT、Anthropic Claude、Google PaLM2、百度文心一言等。它提供了一种统一的方式管理和调用不同模型的API,使得开发者可以在一个平台上灵活调配资源。

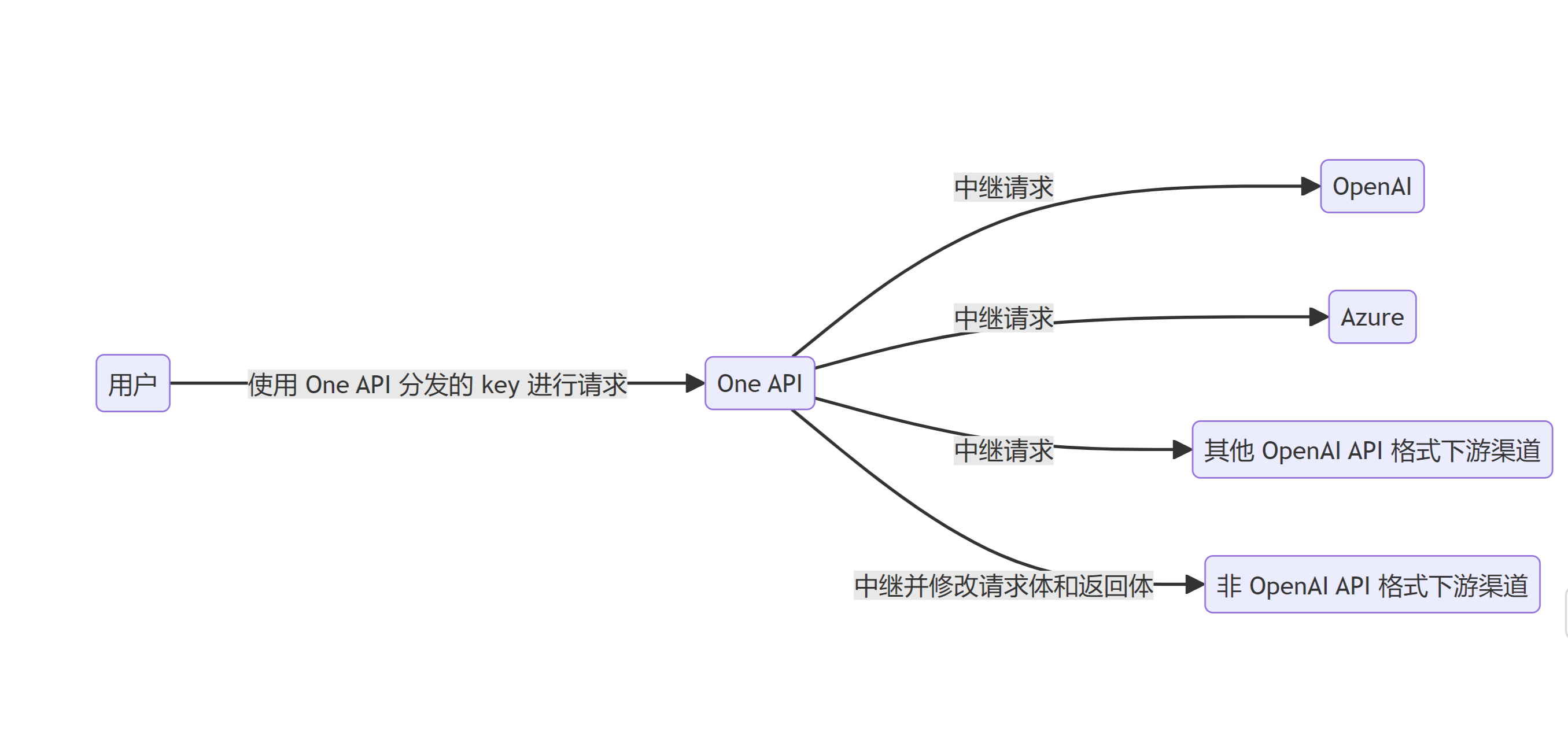

OneAPI的工作原理

OneAPI的工作原理涉及在渠道页面添加API Key,然后在令牌页面创建访问令牌。客户端使用令牌访问OneAPI,根据请求中的model参数匹配对应的渠道,并将请求转发给真正的服务地址。这样,OneAPI实现了请求的中继和分发功能。通过这种方式,可以轻松管理和调用多个大模型。

安装OneAPI

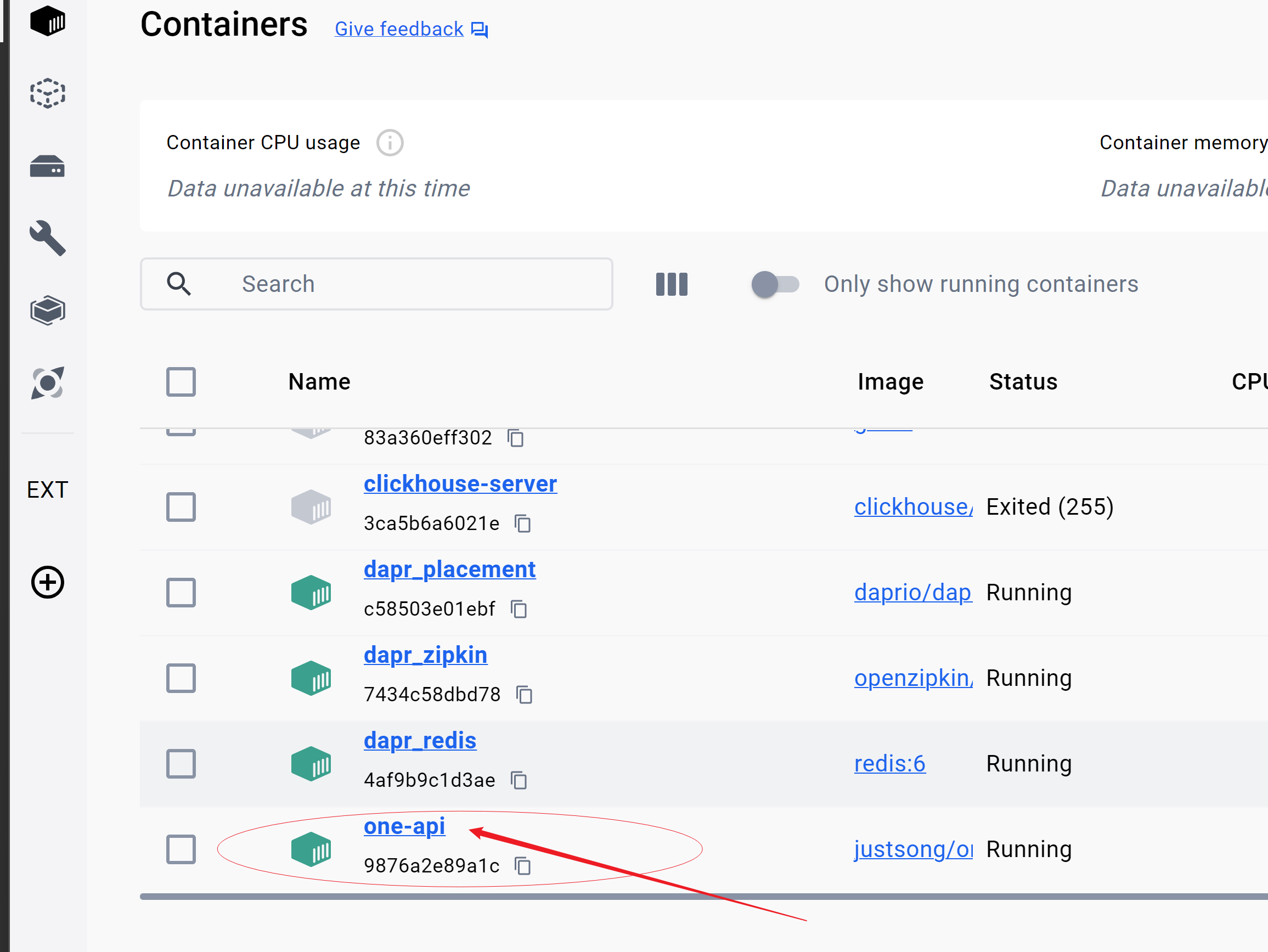

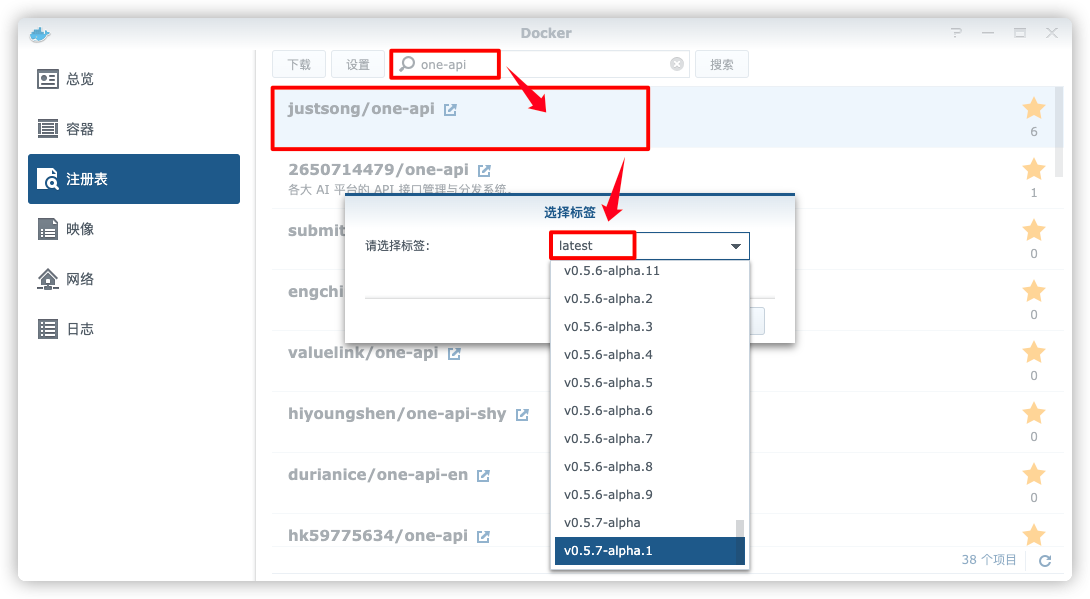

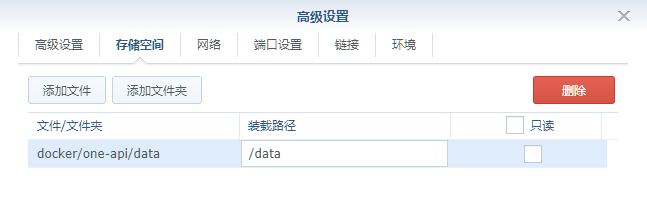

安装OneAPI可以通过Docker进行,适合在本地环境或服务器上快速部署。首先需要从Docker注册表中拉取OneAPI的镜像,随后运行容器。以下是使用SQLite数据库的部署命令:

docker run --name one-api -d --restart always -p 3000:3000 -e TZ=Asia/Shanghai -v /path/to/data:/data justsong/one-api确保宿主机的端口3000未被占用,映射的数据卷用于存放数据库和日志信息。安装成功后,可以通过浏览器访问http://localhost:3000/进行后续配置。

使用命令行安装

对于熟悉命令行的用户,可以通过Docker CLI进行安装。首先,在指定路径创建数据目录,然后使用以下命令运行容器:

mkdir -p /volume1/docker/one-api/data

cd /volume1/docker/one-api

docker run -d

--restart always

--name one-api

-p 3033:3000

-v $(pwd)/data:/data

-e TZ=Asia/Shanghai

justsong/one-api此方法可以快速启动并运行OneAPI服务。

配置OneAPI

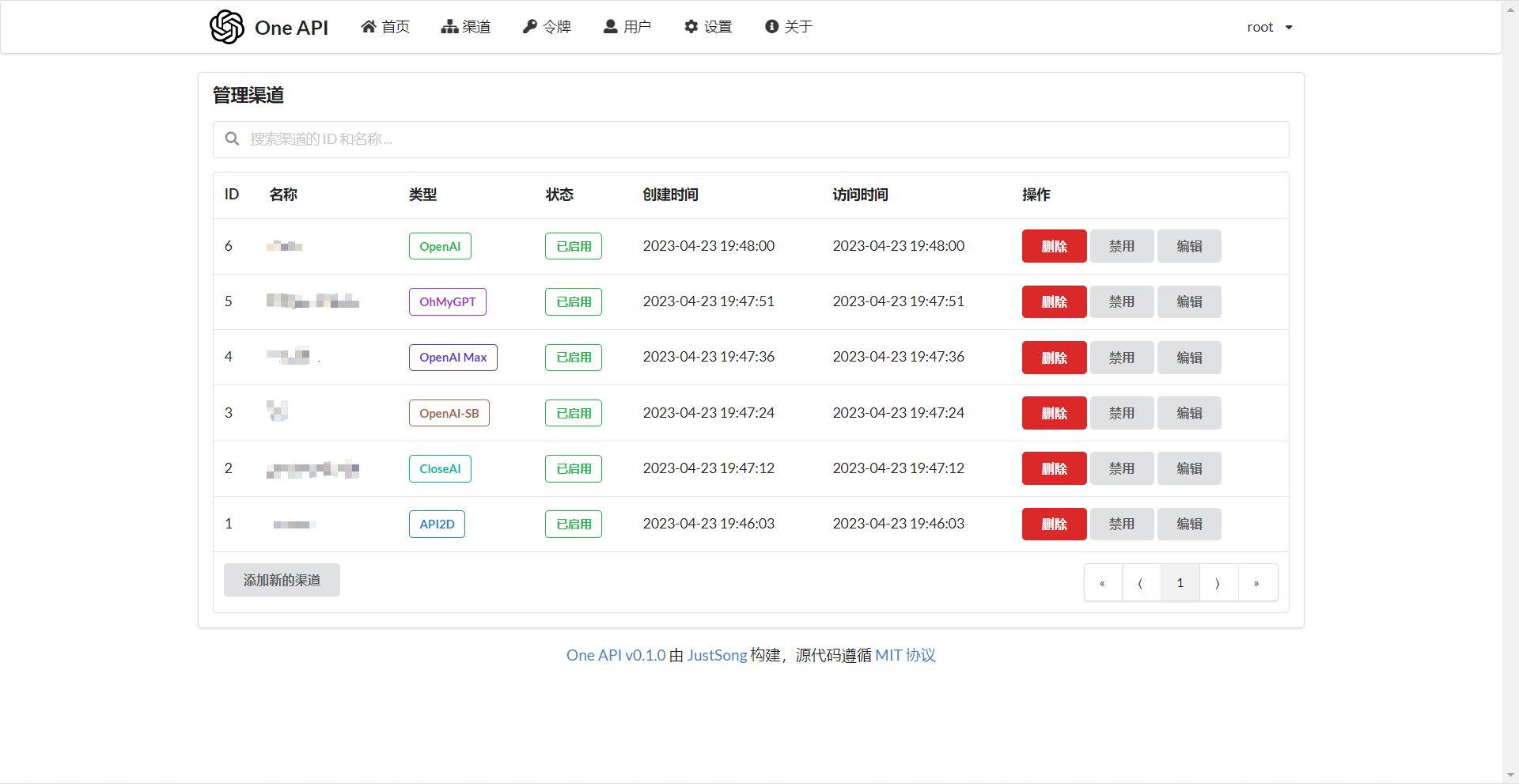

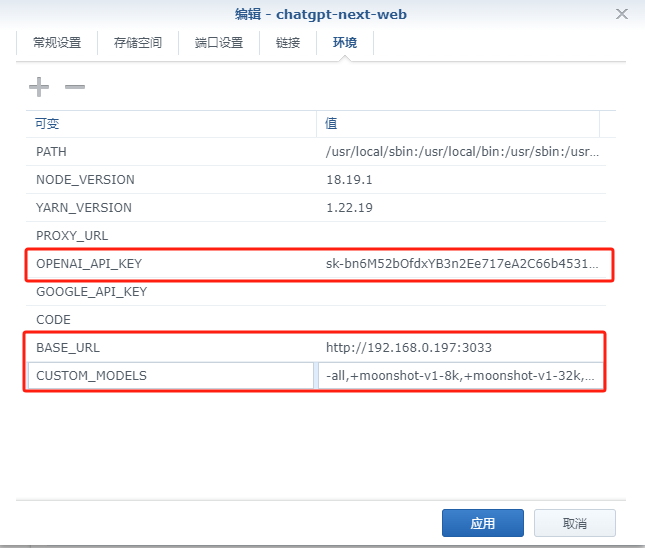

在成功安装OneAPI后,下一步是配置渠道。通过添加新的渠道,用户可以配置不同厂商的大模型,如讯飞星火、Moonshot AI等。在配置页面输入模型类型、名称、密钥等信息并保存。随后,可以通过测试功能验证配置是否成功。

创建和管理令牌

为了使用OneAPI进行二次分发,需要创建访问令牌。令牌用于控制访问权限、使用额度和时限等。创建时可以设置模型的可访问范围和其他限制条件。创建完成后,可以在令牌页面查看和管理。

调用OneAPI接口

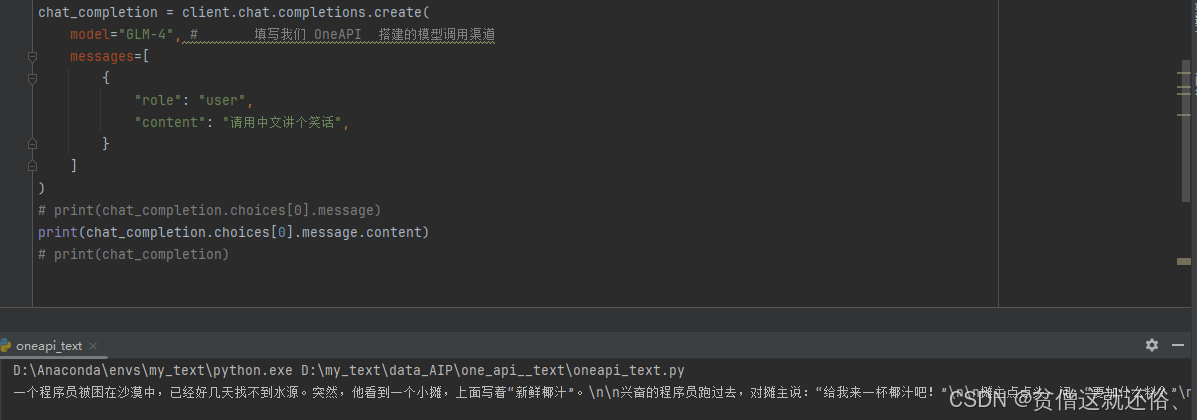

OneAPI支持通过客户端调用接口,实现与大模型的交互。以下是使用Python调用OneAPI的示例代码:

from openai import OpenAI

client = OpenAI(

api_key="your_api_key", # 填写OneAPI生成的令牌

base_url="http://your_ip_address/v1"

)

chat_completion = client.chat.completions.create(

model="GLM-4",

messages=[

{

"role": "user",

"content": "请用中文讲个笑话",

}

]

)

print(chat_completion.choices[0].message.content)此代码展示了如何通过API Key和模型名称,使用OneAPI接口进行调用,并获取返回结果。

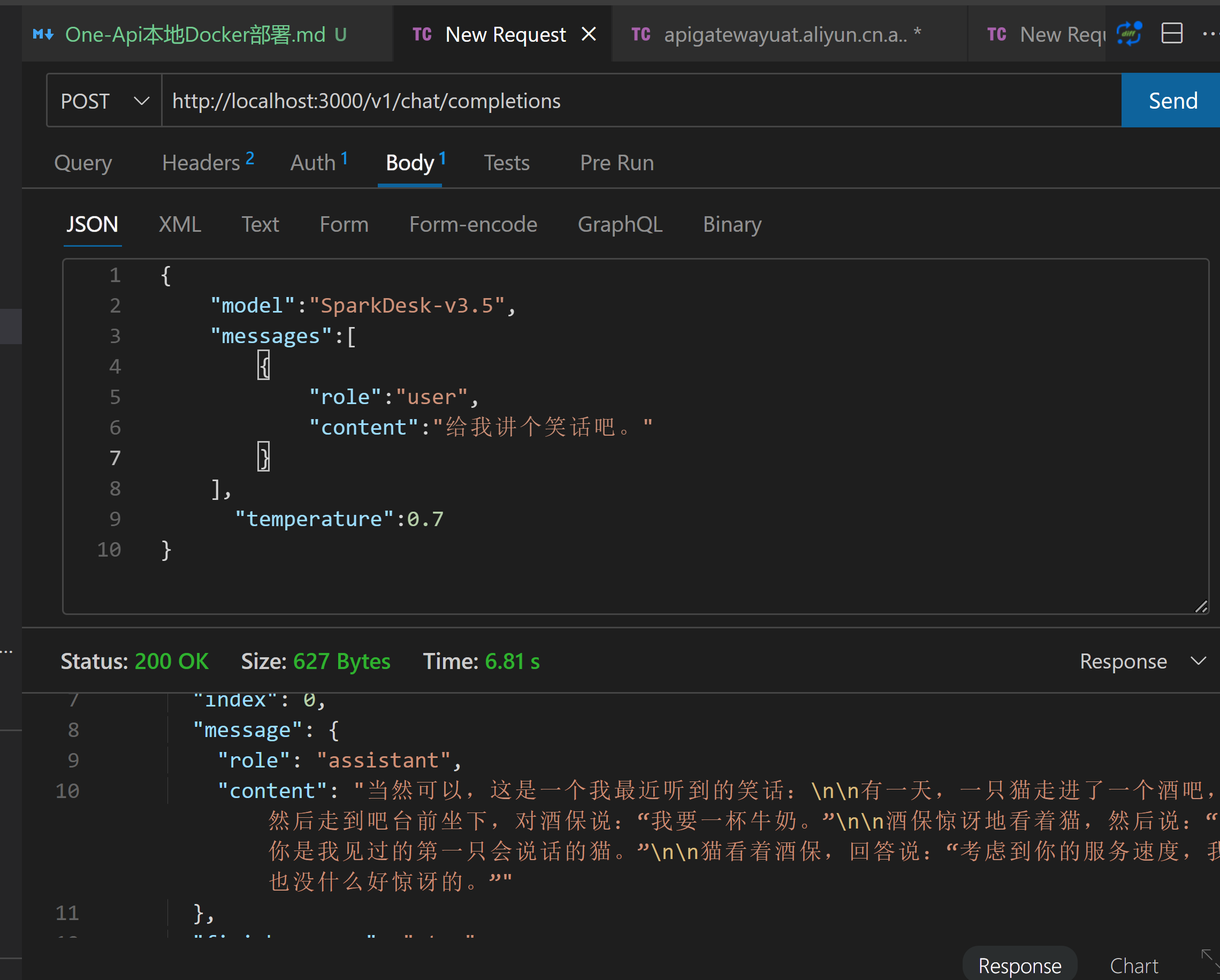

测试接口调用

在接口测试工具中验证接口调用,可以通过设置请求头和请求体来测试接口的响应。例如,访问接口地址http://localhost:3000/v1/chat/completions,设置请求头Authorization: Bearer {OneApiToken},并发送请求体以验证响应结果。

应用场景与优势

OneAPI的应用场景广泛,适用于需要调用多种大模型的开发环境,如AI文本生成、语音识别、图像识别等。其优势在于提供了统一的接口管理和分发,简化了不同模型的调用和管理流程,降低了开发和运维的复杂度。同时,OneAPI支持多种模型的灵活配置和访问控制,为企业和开发者提供了便捷高效的解决方案。

未来展望

随着AI技术的不断发展,OneAPI将继续扩展支持的模型类型和功能,提供更丰富的API调用选项和管理能力。未来,OneAPI可能会集成更多的分析工具和可视化功能,帮助用户更好地理解和优化API使用。同时,随着更多企业开始使用大模型,OneAPI的市场需求将进一步提升,为更多开发者和企业提供高效的接口管理服务。

FAQ

-

问:如何安装OneAPI?

- 答:可以通过Docker拉取镜像并运行容器,或者使用命令行进行安装,具体步骤详见安装章节。

-

问:OneAPI支持哪些大模型?

- 答:OneAPI支持包括OpenAI、Anthropic Claude、Google PaLM2等多种大模型,详细列表请参考OneAPI的官方文档。

-

问:如何测试OneAPI接口调用?

- 答:可以使用接口测试工具,通过设置请求头和请求体,访问接口地址并验证响应结果。

-

问:OneAPI的优势是什么?

- 答:OneAPI提供统一的接口管理和分发,简化了多模型调用和管理流程,支持灵活配置和访问控制。

-

问:未来OneAPI会有哪些发展?

- 答:OneAPI将扩展支持的模型类型和功能,可能集成更多分析工具和可视化功能,提升API使用的便捷性和效率。

热门API

- 1. AI文本生成

- 2. AI图片生成_文生图

- 3. AI图片生成_图生图

- 4. AI图像编辑

- 5. AI视频生成_文生视频

- 6. AI视频生成_图生视频

- 7. AI语音合成_文生语音

- 8. AI文本生成(中国)

最新文章

- Python调用免费翻译API实现Excel文件批量翻译

- 为开源项目 go-gin-api 增加 WebSocket 模块

- AI编程的风险,如何毁掉你的 API?

- 使用预约调度API的运输管理

- Claude 免费用户频繁被限流?实用应对策略推荐

- 如何获取谷歌新闻 API Key 密钥(分步指南)

- API 目录 – 什么是 API 目录?

- 用NestJS和Prisma: Authentication构建一个REST API

- DeepSeek – Anakin.ai 的 Reason 模型 API 价格是多少?

- 19个API安全最佳实践,助您实现安全

- 如何免费调用Kimi API实现项目集成

- 探索 Zomato API 的潜力