SQL注入攻击深度解析与防护策略

本文旨在为读者提供一个全面的指南,介绍如何在Ollama平台上一键部署Qwen2模型,包括安装、配置、运行和优化等关键步骤。通过本文,AI爱好者和开发者可以轻松掌握大型语言模型的本地部署技术。

Ollama是一个开源项目,旨在让用户能够轻松地在其本地计算机上运行大型语言模型(LLM)。它支持多种LLM,提供了类似OpenAI的API接口和聊天界面,方便用户部署和使用最新版本的GPT模型。Ollama支持热加载模型文件,无需重新启动即可切换不同的模型。

Ollama以其用户友好的界面和强大的功能,简化了大型语言模型的本地部署和运行过程。无论是对于AI领域的新手还是资深开发者,Ollama都是一个不可多得的工具。

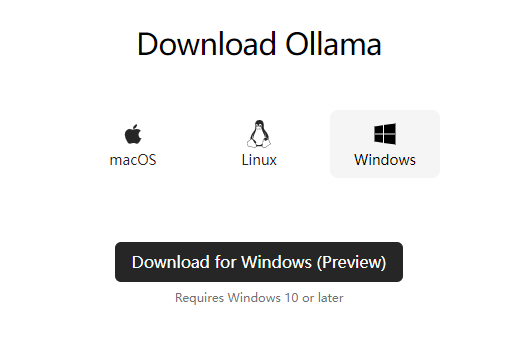

要开始使用Ollama,首先需要访问其官方网站,并下载适合您操作系统的版本。

官方网站提供了Windows、MacOS和Linux版本的下载链接。选择相应的版本进行下载。

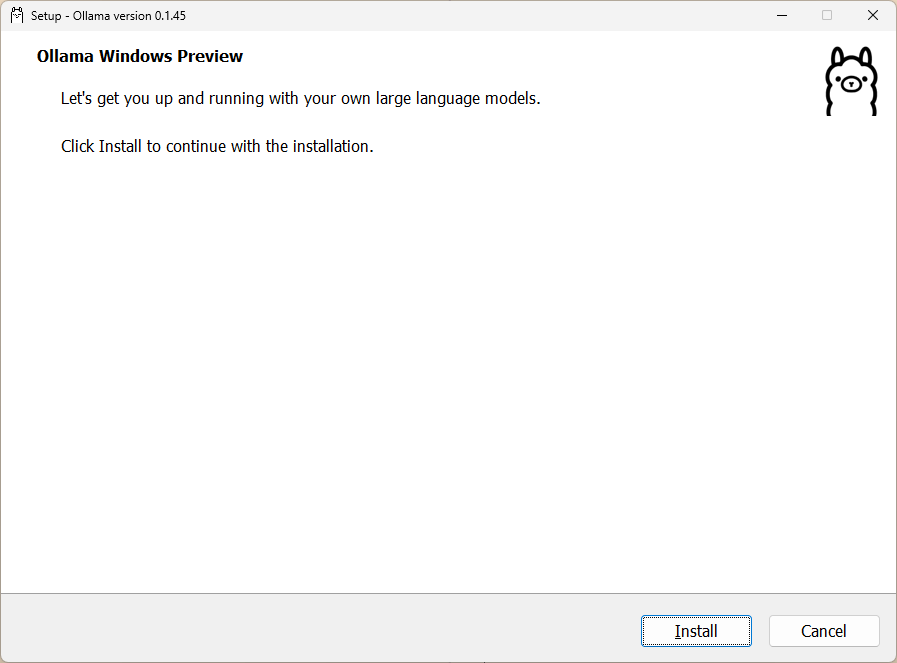

下载完成后,运行安装程序或解压缩文件到您选择的目录。对于Linux用户,还可以通过命令行进行安装。

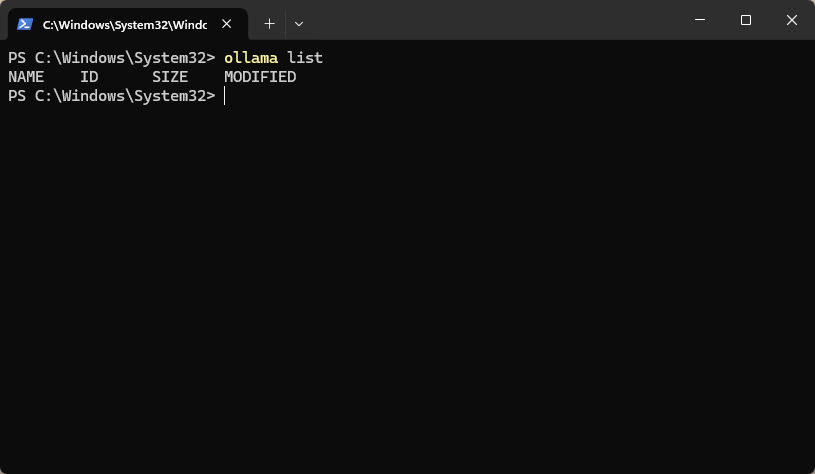

安装完成后,可以通过运行ollama list命令来验证Ollama是否正确安装。

ollama list

Ollama提供了一系列的命令,用于管理模型和运行服务。以下是一些常用命令的示例:

ollama serve 启动ollama

ollama create 从模型文件创建模型

ollama show 显示模型信息

ollama run 运行模型

ollama pull 从注册表中拉取模型

ollama push 将模型推送到注册表

ollama list 列出模型

ollama cp 复制模型

ollama rm 删除模型

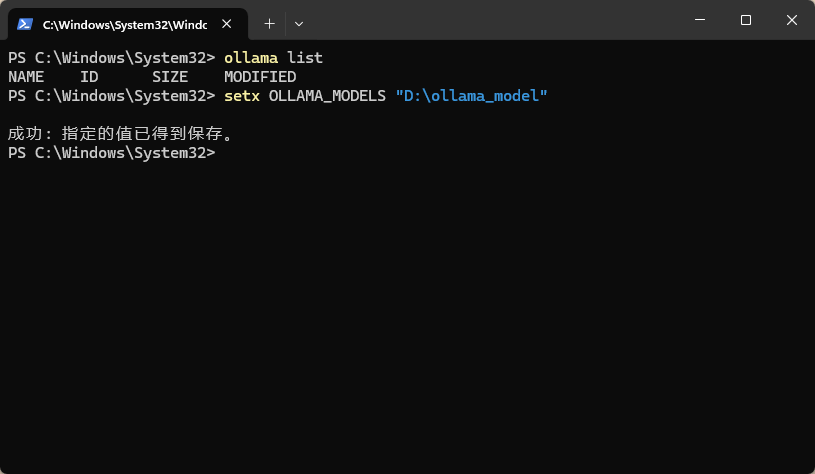

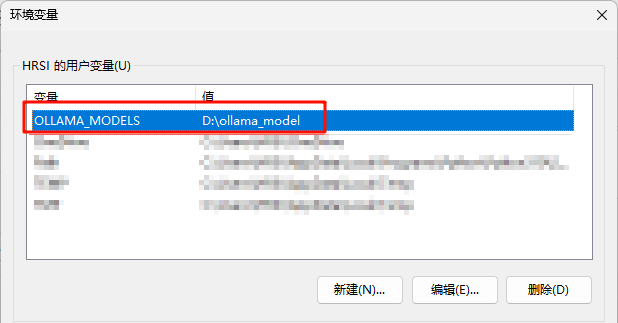

ollama help 获取有关任何命令的帮助信息默认情况下,模型保存在C盘的用户目录下。如果需要更改路径,可以通过设置环境变量OLLAMA_MODELS来实现。

setx OLLAMA_MODELS "D:ollama_model"

更改后,可以在电脑的环境变量中查看是否设置成功。

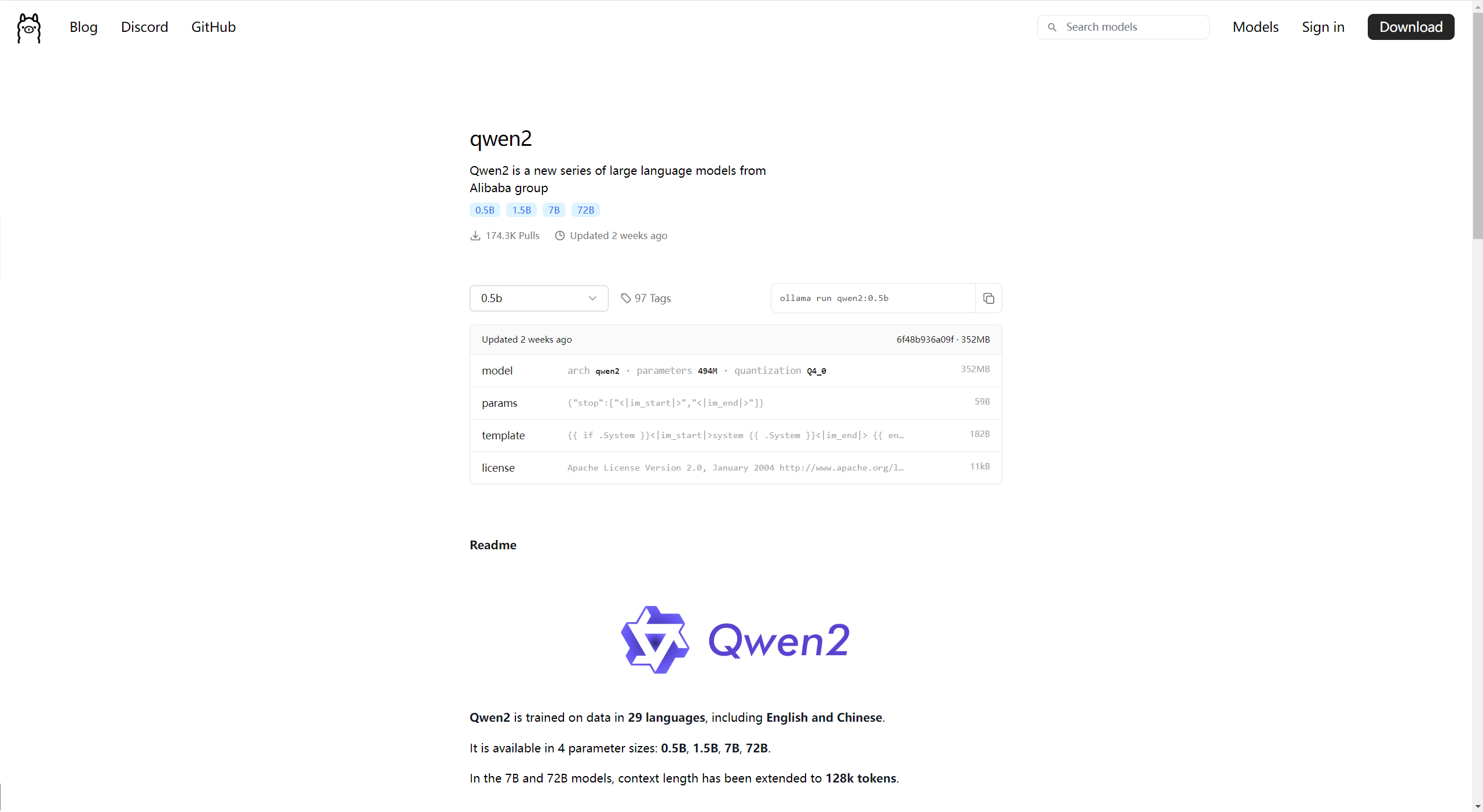

在Ollama的模型库中,可以找到并选择需要的模型。例如,我们可以选择Qwen2模型,并查看其参数量和模型介绍。

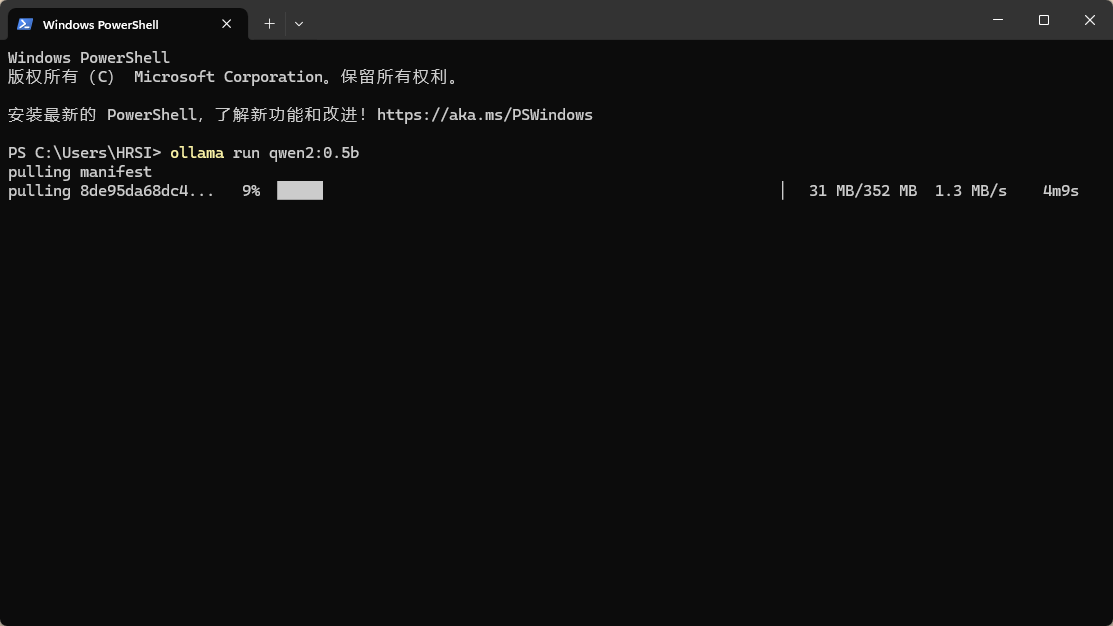

选择好模型后,可以使用如下命令下载并运行Qwen2模型:

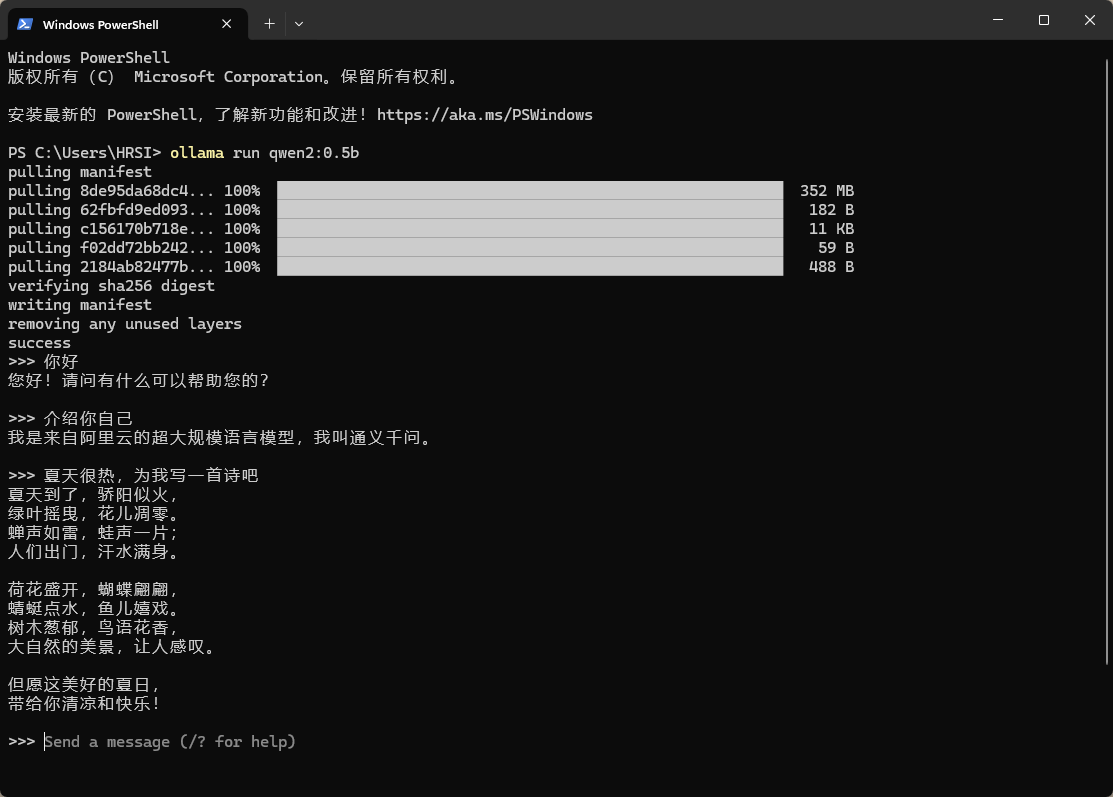

ollama run qwen2:0.5b

部署完成后,可以直接在终端与Qwen2模型进行交流,测试其性能和响应。

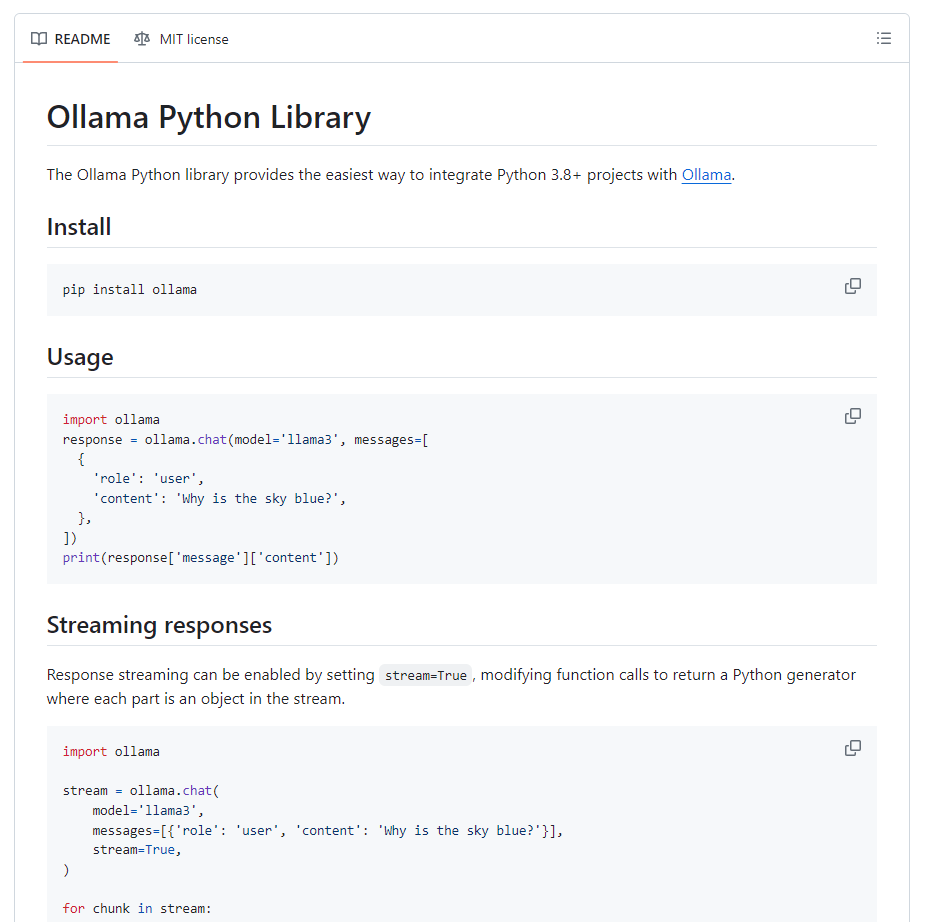

对于希望在Python项目中使用Ollama的用户,可以访问Ollama的GitHub页面,获取详细的教程和文档。

问:Ollama支持哪些操作系统?

问:如何更改Ollama的模型保存路径?

OLLAMA_MODELS来更改模型保存路径。问:如何在Ollama中运行Qwen2模型?

ollama run qwen2:0.5b命令下载并运行。问:Ollama提供哪些常用命令?

serve、create、show、run、pull、push、list、cp、rm和help在内的多个常用命令。问:如何使用Python调用Ollama?

通过本文的介绍,相信读者已经对如何在Ollama平台上部署Qwen2模型有了全面的了解。Ollama平台以其简洁的操作界面和强大的功能,为大型语言模型的本地部署提供了便捷的解决方案。希望本文能为您的AI之路提供有益的帮助和启发。