Google语音识别技术详解与实践应用

本文将深入探讨NAG外汇平台如何通过提供低点差和迅捷的交易服务来优化交易体验,以及深度学习领域中的优化算法发展历程,特别是NAG算法的应用与优势。

NAG外汇平台致力于打造一个公平、透明的外汇交易环境。我们的目标是为客户提供最佳的交易体验,帮助他们在外汇市场中建立财富。

在外汇交易中,低点差意味着更低的成本和更高的利润空间。NAG外汇平台通过先进的技术,为交易者提供低点差和迅捷的交易服务,确保每一笔交易都能以市场价格快速成交。

NAG外汇平台采用全自动交易系统,无任何人工干预,保证了交易的公正性和透明性。

def execute_trade(order_details):

# 根据市场价格自动执行订单

market_price = get_market_price(order_details['symbol'])

order_details['executed_price'] = market_price

return order_details深度学习优化算法是机器学习领域中的重要组成部分,它们帮助模型更有效地学习数据中的模式。

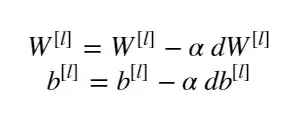

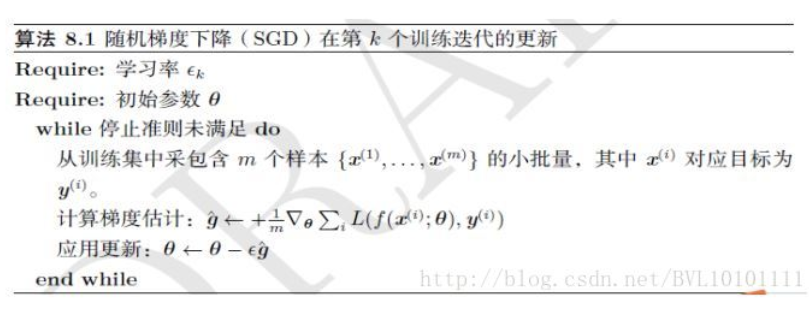

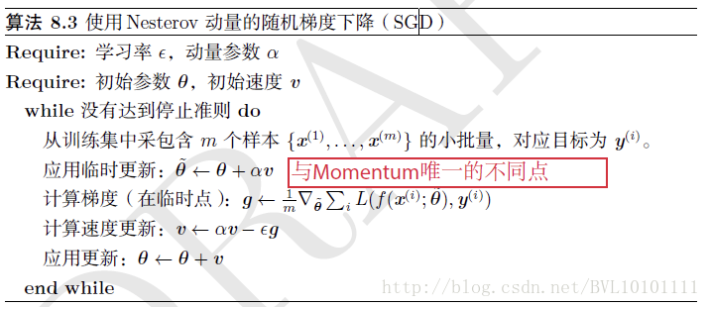

随机梯度下降(SGD)是最基础的优化算法,随后发展出了带动量的SGD(SGDM),进一步提高了优化效率。NAG算法在此基础上引入了Nesterov动量,进一步提升了优化性能。

SGDM通过引入动量,减少了优化过程中的震荡,加快了收敛速度。

def update_with_momentum(parameters, grads, v, beta, learning_rate):

# 使用动量更新参数

v['dW'] = beta * v['dW'] + (1 - beta) * grads['dW']

parameters['W'] -= learning_rate * v['dW']

return parameters, vNAG算法通过预测未来的梯度方向,提前调整步长,从而更有效地指导当前的梯度更新。

NAG算法在许多情况下都能取得比SGD和SGDM更好的优化效果,特别是在复杂的深度学习模型中。

Adam算法是目前最流行的优化算法之一,它结合了动量和RMSprop的优点。

Adam算法通过计算梯度的一阶矩和二阶矩,动态调整每个参数的学习率。

def update_with_adam(parameters, grads, v, s, t, learning_rate, beta1, beta2, epsilon):

# 使用Adam算法更新参数

v['dW'] = beta1 * v['dW'] + (1 - beta1) * grads['dW']

s['dW'] = beta2 * s['dW'] + (1 - beta2) * (grads['dW'])**2

corrected_v = v['dW'] / (1 - beta1**t)

corrected_s = s['dW'] / (1 - beta2**t)

parameters['W'] -= learning_rate * corrected_v / (np.sqrt(corrected_s) + epsilon)

return parameters, v, s答:NAG外汇平台采用全自动交易系统,无任何人工干预,确保每一笔交易都能以市场价格快速成交。

答:NAG算法通过预测未来的梯度方向,提前调整步长,从而更有效地指导当前的梯度更新,尤其在复杂的深度学习模型中表现出色。

答:Adam算法结合了动量和RMSprop的优点,通过计算梯度的一阶矩和二阶矩,动态调整每个参数的学习率,使得训练过程更加高效和稳定。