大模型RAG技术:从入门到实践

模型微调(Fine-tuning)是指在预训练的大型语言模型基础上,通过特定领域的数据集进行进一步的训练,以适应特定任务或领域。模型微调的核心在于利用已有模型的通用知识,通过特定领域的数据来优化模型在该领域的表现。这种方法不仅可以提升模型的性能,还能节省大量的计算资源和时间。

大模型在通用任务上表现出色,但在特定领域或任务上可能无法达到预期效果。通过微调,可以使模型适应这些特定场景,从而提高其准确性和可用性。这对于需要专业知识的领域尤其重要,如医学、法律等。

微调的基本原理是通过调整模型的部分参数,使其更好地适应新的数据集和任务。与从头训练模型相比,微调能够更高效地利用已有的模型结构和权重,从而快速实现优化。

在进行模型微调之前,需要经过几个关键步骤。这些步骤包括数据准备、模型选择、参数设置和微调流程。

数据准备是微调过程的基础。首先需要选择与目标任务相关的数据集,并对其进行清洗、分词和编码等预处理操作。高质量的数据是微调成功的前提。

根据任务的需求,选择一个合适的预训练模型,如BERT、GPT-3等。这些模型提供了强大的语言理解能力,是微调的良好基础。

微调过程中,超参数的设置至关重要。学习率、训练轮次(epochs)和批量大小(batch size)等超参数需要根据具体任务进行调整,以确保模型的有效性和性能。

微调流程包括加载预训练模型、修改模型结构、选择损失函数和优化器,以及进行训练。通过这些步骤,模型逐渐适应新的数据集和任务。

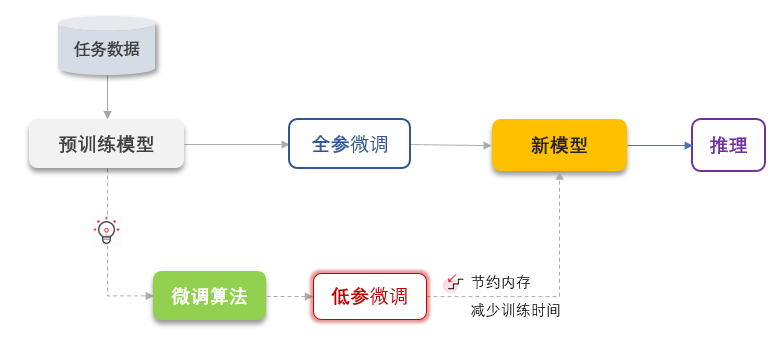

根据微调对模型参数的调整程度,可以分为全量微调和参数高效微调(PEFT)。

全量微调是指对模型的所有参数进行调整,以适应新任务。虽然计算资源需求较大,但能充分利用模型的表达能力,适用于任务与预训练模型差异较大的情况。

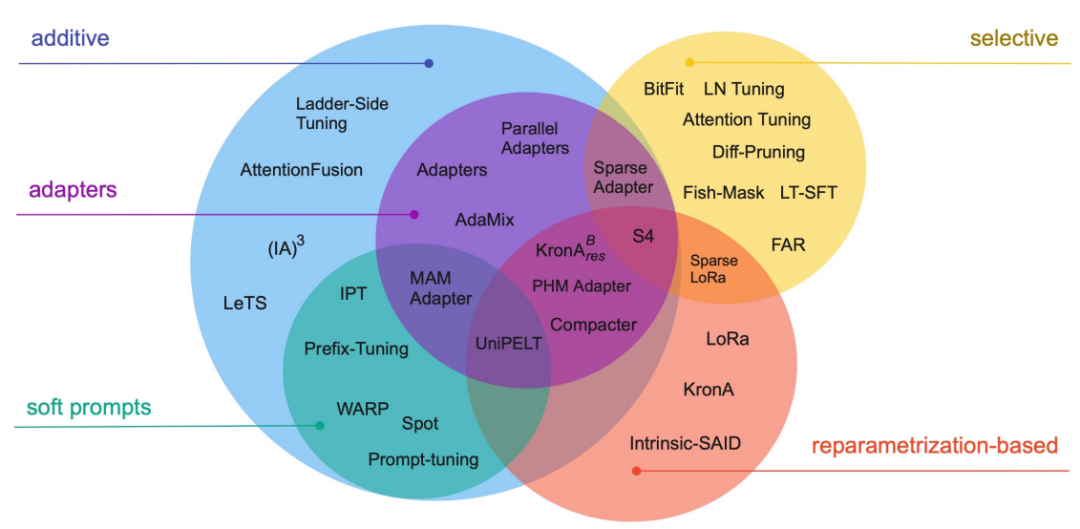

PEFT旨在通过最小化微调参数数量,实现高效的迁移学习。它仅更新模型中的部分参数,显著降低训练时间和成本,适用于计算资源有限的情况。常见的PEFT方法包括Prefix Tuning、Prompt Tuning等。

在微调过程中,选择合适的工具和平台可以大大提高效率。Hugging Face是一个广受欢迎的微调平台,提供丰富的预训练模型和工具。

Hugging Face支持与TensorFlow、PyTorch等主流框架的兼容,提供了便捷的微调工具和丰富的文档,帮助用户快速上手。此外,活跃的社区支持也是其一大优势,用户可以在社区中互助和分享经验。

选择微调平台时,需要考虑平台的模型库、支持的任务类型、社区活跃度和文档丰富程度等因素。对于初学者,选择一个易于使用且有丰富资源的平台是非常重要的。

模型微调在许多领域展现了其强大的应用潜力,包括自然语言处理、图像识别、语音识别等。

在自然语言处理任务中,微调可以帮助模型更好地理解和生成特定领域的语言,例如法律文档的分析和医疗诊断的文本生成。

在图像识别任务中,通过微调预训练的视觉模型,可以提高模型对特定物体或场景的识别准确性。

通过微调语音模型,能够提升其在特定口音或语言下的识别能力,为多语言语音识别系统提供支持。

尽管微调是一种高效的模型优化方法,但在实际操作中仍然会遇到一些挑战。

微调需要充足的高质量数据,数据不足可能导致模型过拟合或欠拟合。解决方案包括数据增强、使用迁移学习以及从相似任务中借用数据等。

选择合适的超参数是微调成功的关键。可以通过网格搜索、随机搜索或贝叶斯优化等方法来自动调整超参数,以获得最佳性能。

微调过程可能需要大量计算资源,尤其是全量微调。可以通过使用参数高效微调方法或云计算平台来缓解资源不足的问题。

随着人工智能技术的不断进步,模型微调也在不断演变和发展。

未来,自动化微调技术将进一步简化微调过程,使得非专业人士也能轻松进行模型优化。这将大大降低微调的进入门槛。

多任务微调是一种新兴的技术,旨在通过同时优化多个相关任务来提高模型的泛化能力和效率。未来,这种方法有望在更多应用场景中发挥作用。

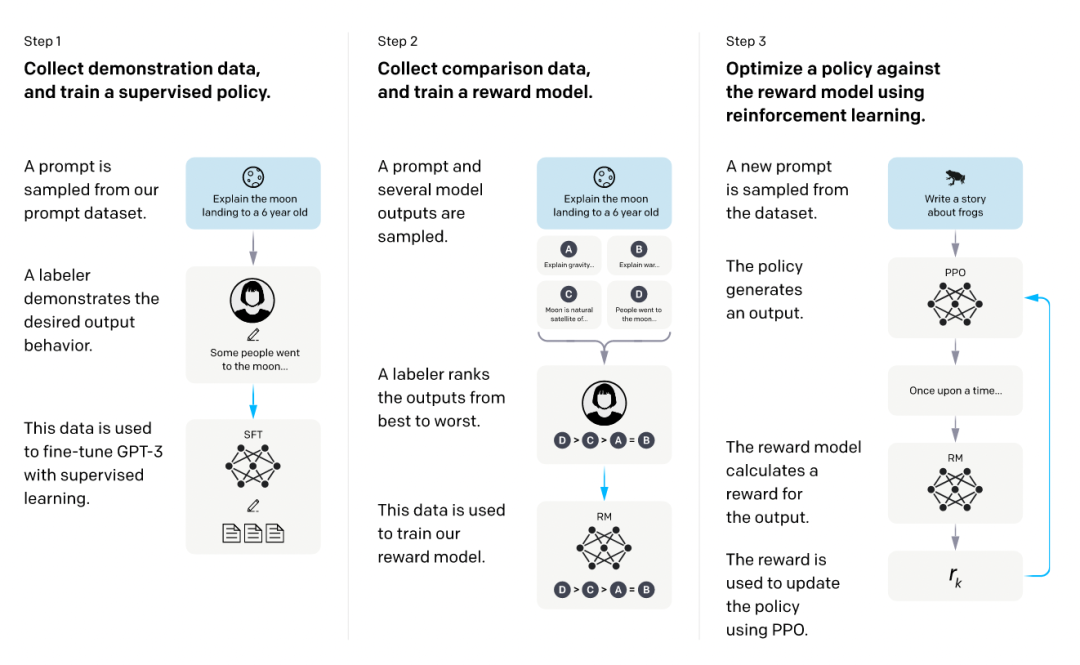

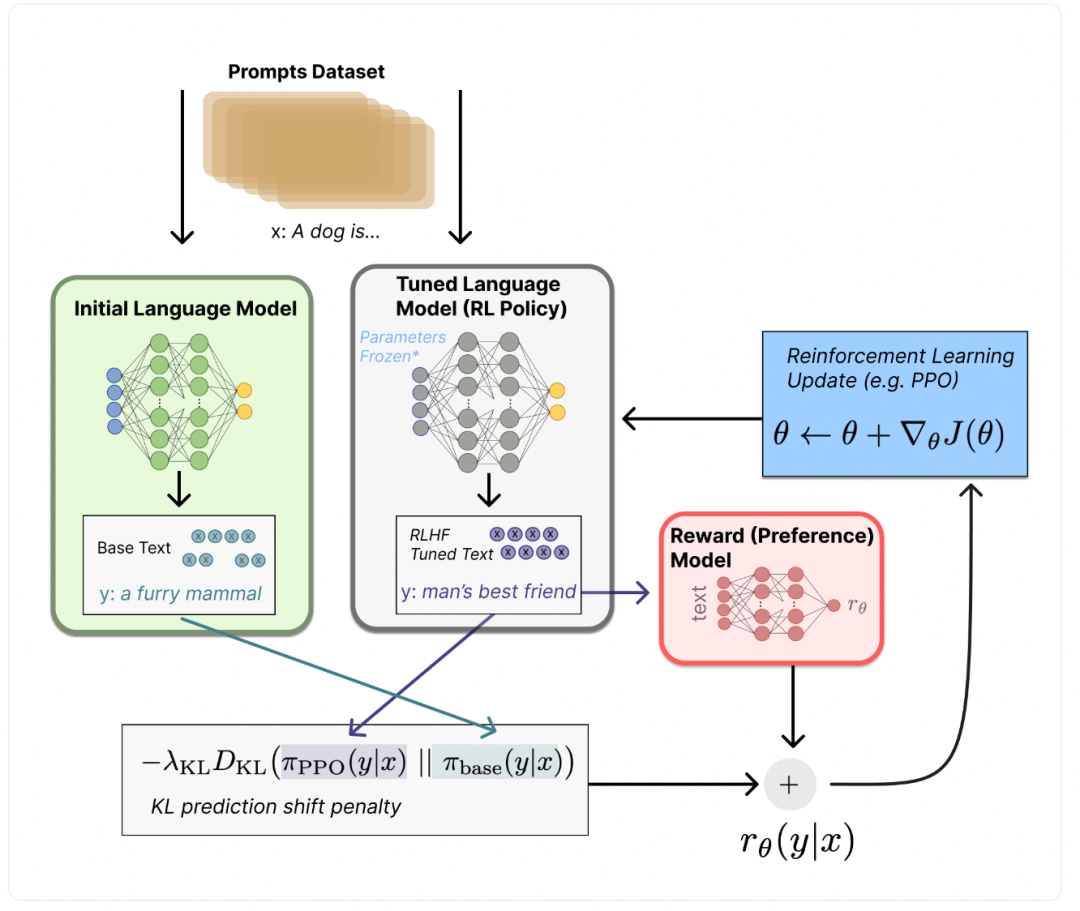

微调与强化学习的结合将为模型优化带来新的可能性,通过人类反馈和策略优化来提升模型的智能水平和适应性。

模型微调是提升大模型性能的关键步骤,通过合理的数据准备、模型选择、参数设置和工具使用,可以大大提高模型在特定任务上的表现。尽管微调面临一些挑战,但不断发展的技术和工具正在帮助我们克服这些困难。未来,随着自动化微调、多任务微调和强化学习的结合,模型微调将会变得更加高效和智能。