基于Qwen2.5的本地知识库实现

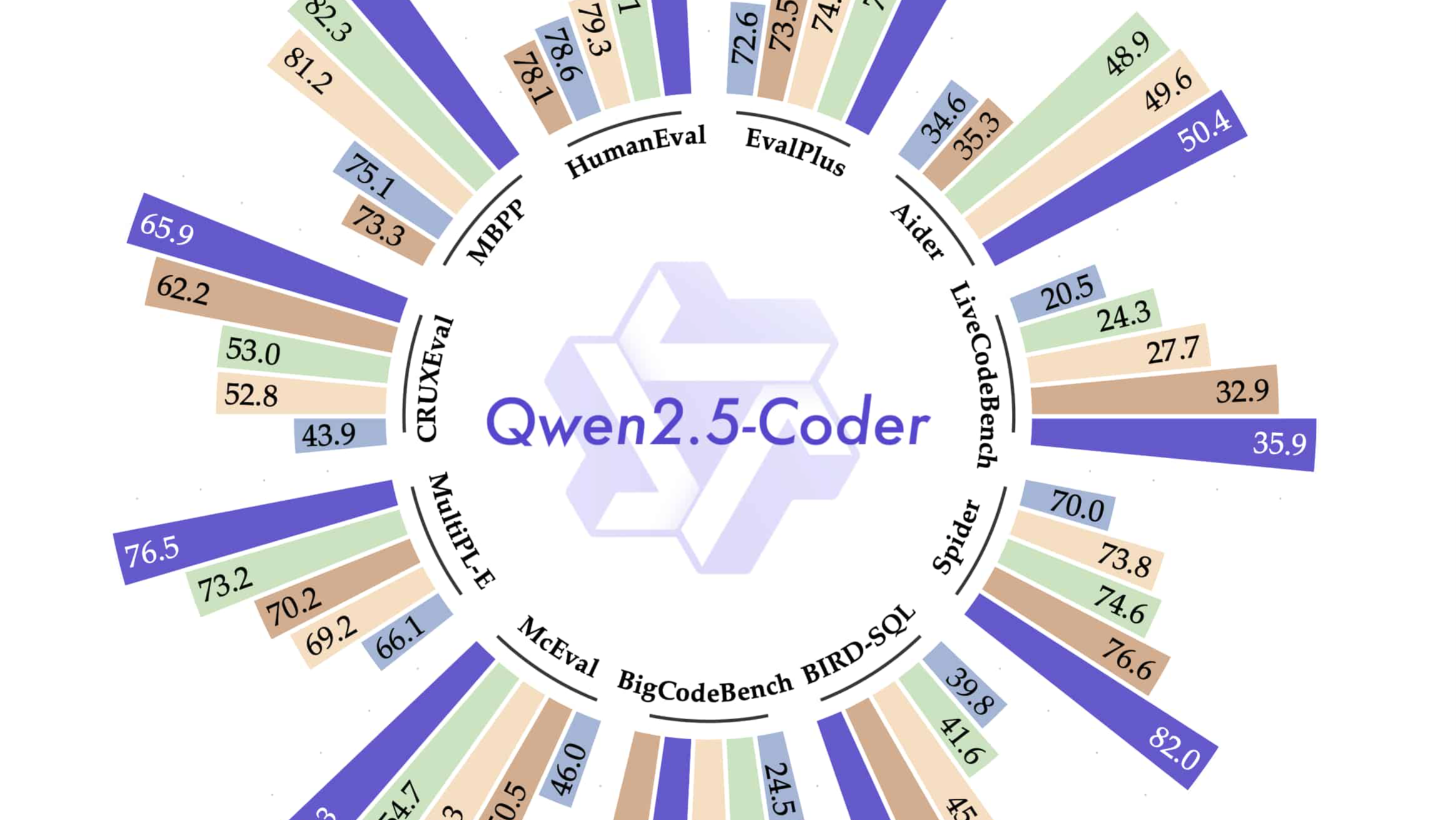

什么是Qwen2.5?

在当今复杂的信息技术领域,Qwen2.5代表着一种突破性的语言模型技术。Qwen2.5是由阿里巴巴推出的一系列大模型中的一员,以其出色的推理能力和广泛的应用场景而著称。Qwen2.5不仅仅是一种语言模型,更是一个可以在多种应用中提供支持的工具,从文本生成到复杂的编程任务。

Qwen2.5模型中的“Coder”版本尤其突出,专为编程任务优化,能够理解和生成代码。这种能力使其成为开发人员的得力助手,尤其是在代码生成、错误检测和修复等方面表现出色。Qwen2.5的多语言支持和大规模参数版本让它在全球各个领域中都能发挥重要作用。

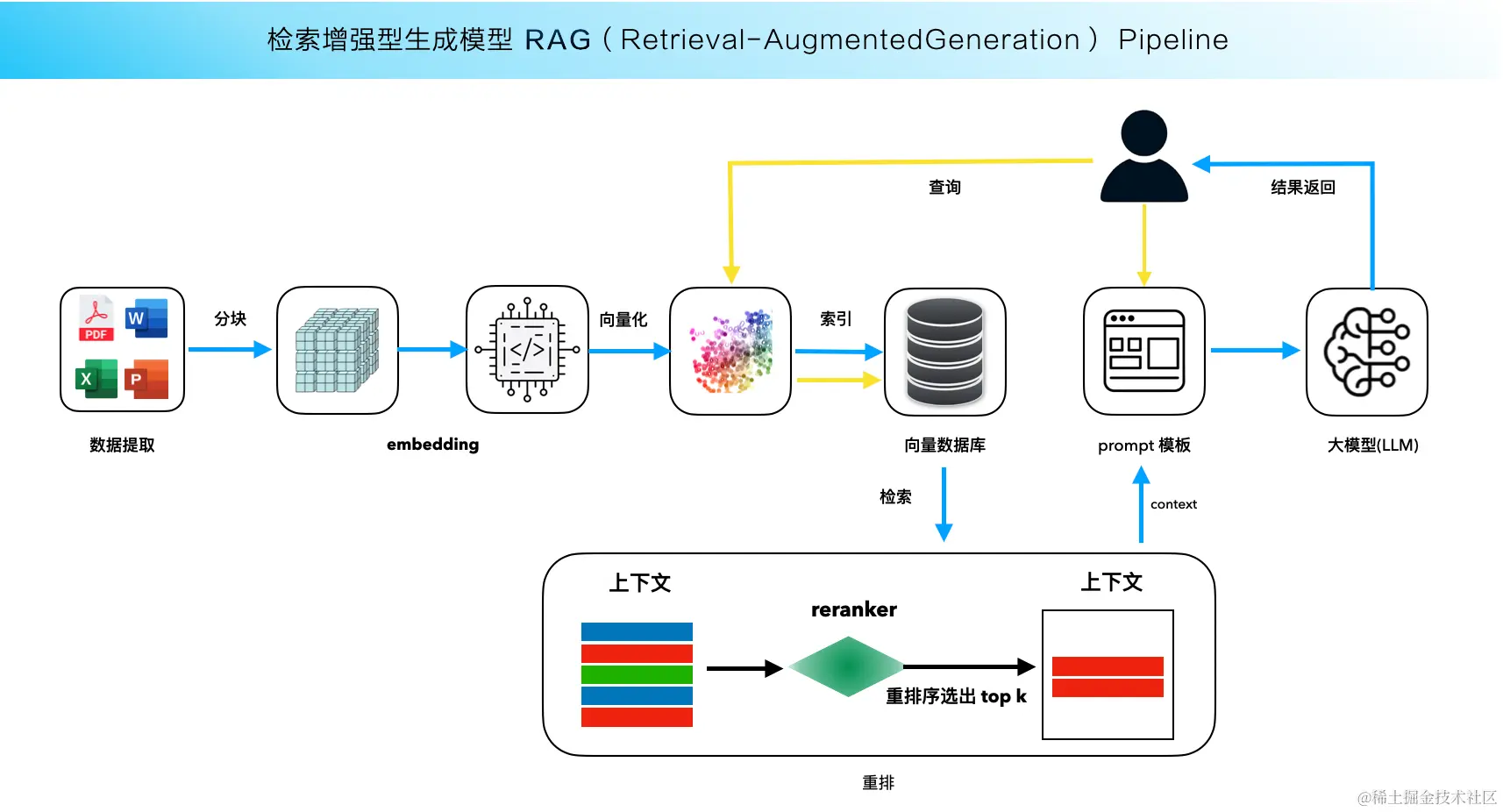

RAG技术的应用

RAG(RAG技术在处理开放域问题时,能够克服传统模型的信息容量限制和时效性不足,为用户提供更为精准的答案。

在RAG的框架下,一个大型语言模型如Qwen2.5可以被理解为一个可以随时查询的“超级知识库”。这种架构不仅扩大了模型的知识范围,还增强了其在特定领域的准确性和时效性。对于需要实时信息和专业化知识的应用场景,如医疗咨询、法律意见等,RAG提供了理想的解决方案。

Ollama与本地模型部署

Ollama是一个强大的工具,专门为大型语言模型(LLM)提供支持。它并不是一个LLM,而是一个能够在本地环境中运行、测试和部署这些模型的平台。Ollama的使用极大地方便了开发人员,尤其是在需要快速迭代和测试模型的情况下。

通过Ollama,用户可以在本地机器上轻松部署Qwen2.5等大模型。其安装过程简便,只需通过命令行即可完成模型下载和运行。Ollama还支持多种操作系统,如Windows、Mac和Linux,使得它在不同的开发环境中都能被广泛应用。

ollama install

ollama run qwen2.5-coder:7b

AnythingLLM的整合

AnythingLLM是一个框架,旨在将语言模型与本地知识库相结合,创建一个个性化的问答系统。它支持多种数据格式的输入,包括PDF和Word文档,甚至是网页链接,极大地丰富了知识库的内容来源。

在部署过程中,用户可以选择不同的模型和向量数据库来优化性能。AnythingLLM的易用性使其成为构建本地知识库的理想选择,特别是在需要频繁更新和管理大量数据的场景中。

实现步骤

部署环境准备

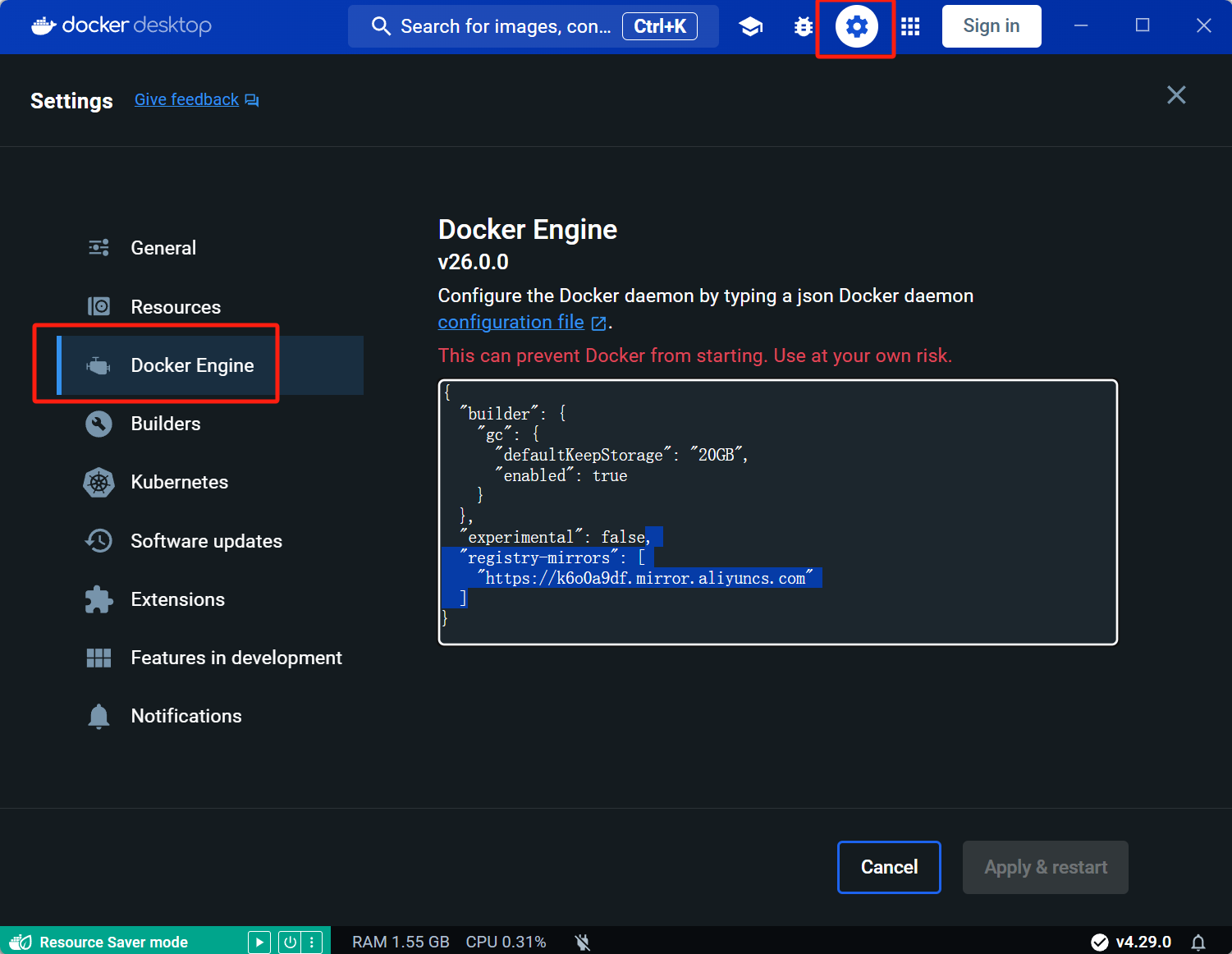

在开始搭建本地知识库之前,确保你的开发环境已准备就绪。这里以Windows系统为例,首先需要启用虚拟化功能,如Hyper-V和WSL子系统。这些功能为Docker的顺利运行提供了必要的支持。接下来,安装并配置Docker,确保镜像源的设置能够加速下载。

启动和配置AnythingLLM

完成环境准备后,可以启动AnythingLLM框架。首先,下载相关的Docker镜像,然后通过命令行启动框架。此时,你需要配置模型的API地址和所使用的大模型类型,这里选择使用Ollama提供的Qwen2.5。

docker pull mintplexlabs/anythingllm

$env:STORAGE_LOCATION="$HOMEDocumentsanythingllm";

docker run -d -p 3001:3001

--cap-add SYS_ADMIN

-v "$env:STORAGE_LOCATION:/app/server/storage"

mintplexlabs/anythingllm;上传和管理数据

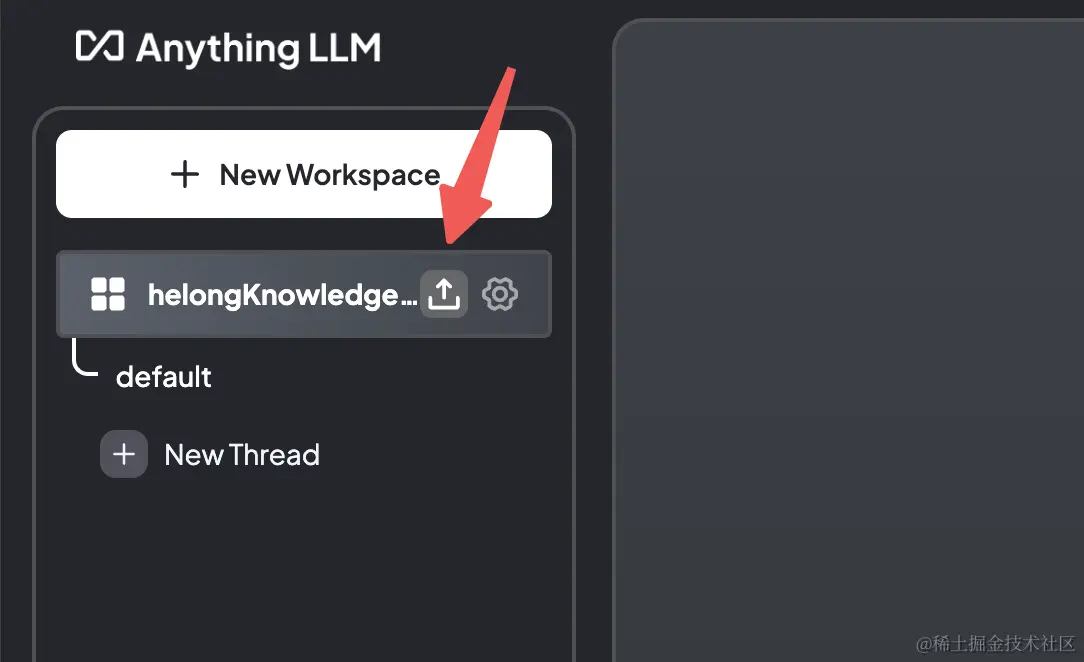

在AnythingLLM的工作界面中,你可以创建一个新的工作区并上传你的数据。支持的格式包括txt、pdf和docx等。上传完成后,系统将自动进行向量化处理,并将数据存储到向量数据库中。

FAQ

问:如何选择合适的LLM模型?

答:选择模型时,应根据应用场景的具体需求考虑模型的语言支持、参数规模和推理能力。对于需要复杂推理和代码生成的场景,Qwen2.5-Coder是一个不错的选择。

问:什么是RAG技术的主要优势?

答:RAG技术的主要优势在于其灵活性和准确性。通过动态接入外部资源,RAG能够提供实时更新的信息,提升问答系统的准确性和相关性。

问:如何确保本地知识库的数据安全?

答:通过在本地部署知识库系统,数据不需要上传到第三方服务器,极大地降低了数据泄露的风险。同时,定期更新和备份数据也是确保数据安全的重要措施。

问:Ollama支持哪些操作系统?

答:Ollama支持Windows、Mac和Linux操作系统,这使得开发人员可以在各种环境中轻松部署和测试模型。

问:如何使用AnythingLLM进行数据管理?

答:AnythingLLM提供了简单的界面来管理数据。用户可以上传多种格式的文件,并通过向量化处理将其纳入知识库中,方便后续的检索和问答。

最新文章

- 小红书AI文章风格转换:违禁词替换与内容优化技巧指南

- REST API 设计:过滤、排序和分页

- 认证与授权API对比:OAuth vs JWT

- 如何获取 Coze开放平台 API 密钥(分步指南)

- 首次构建 API 时的 10 个错误状态代码以及如何修复它们

- 当中医遇上AI:贝业斯如何革新中医诊断

- 如何使用OAuth作用域为您的API添加细粒度权限

- LLM API:2025年的应用场景、工具与最佳实践 – Orq.ai

- API密钥——什么是API Key 密钥?

- 华为 UCM 推理技术加持:2025 工业设备秒级监控高并发 API 零门槛实战

- 使用JSON注入攻击API

- 思维链提示工程实战:如何通过API构建复杂推理的AI提示词系统