Phenaki API 价格:探索最新技术与市场趋势

语音合成技术的发展为众多应用场景提供了便利,从无障碍设备到电子书阅读,再到在线教育和导航系统,语音合成已经融入了我们的日常生活。本篇文章将深入探讨如何通过 Java 调用 WaveNet API,实现高质量的语音合成功能,并在过程中探讨相关的技术细节和应用场景。

语音合成技术在现代技术应用中扮演着重要角色。以下是一些常见的应用场景:

无障碍设备:语音合成技术帮助视力障碍或阅读困难的人群理解文本内容,通过将文字转为语音,使得他们可以轻松获取信息。

电子书阅读:将电子书中的文本内容转换为语音,使得用户可以在做其他事情时,边听边学习。

在线教育:教师可以将教学内容转化为语音,方便学生反复听课,提高学习效果。

导航系统:通过语音合成,导航系统可以为用户提供实时的语音指引,提升驾驶安全性。

语音广告:广告商可以将广告文本转化为语音,以吸引更多受众。

电话系统:例如电话银行、电话销售等,通过语音合成技术提供自动语音服务。

游戏娱乐:在电子游戏中,语音合成可以为角色配音,增加游戏的沉浸感。

为了实现高质量的语音合成,Google 提供了 WaveNet API,这是一个强大的语音合成工具。通过 Java 调用 WaveNet API,开发者可以利用其先进的深度学习模型生成自然流畅的语音。

WaveNet 是由 DeepMind 开发的一种深度神经网络架构,设计用于生成更为自然的语音合成。与传统的语音合成技术相比,WaveNet 通过直接生成语音波形,可以模拟人类说话的自然语调和声音细节。

WaveNet 通过学习大量的语音数据,能够生成高质量的语音波形。其核心是通过卷积神经网络(CNN)对语音样本进行建模。WaveNet 的关键在于其能够生成每一个音频样本,而不是像传统系统那样依赖于预录制的音频片段。

通过 Java 调用 WaveNet API,开发者可以在应用程序中集成语音合成功能。以下是一些基本步骤:

API 注册与认证:开发者需要在 Google Cloud Platform 上注册并获取 API 密钥。

环境配置:确保系统中安装了 JDK 和必要的库。

代码实现:使用 Java 编写代码,调用 WaveNet API,传入文本数据以合成语音。

结果处理:获取 API 返回的音频数据,并将其保存为所需格式。

为了更好地理解如何在 Java 中调用 WaveNet API,我们将详细讲解以下步骤。

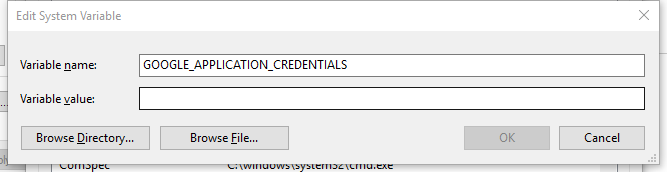

在调用 API 之前,我们需要进行一些基础的环境配置。

安装 JDK:确保系统中安装了 Java 开发工具包。

获取 API 密钥:在 Google Cloud Platform 控制台中创建项目,并启用 Text-to-Speech API,获取 API 密钥用于认证。

安装必要的库:使用 Maven 或 Gradle 导入 Google Cloud Client Library。

com.google.cloud

google-cloud-texttospeech

1.0.0

在环境配置完成后,我们可以开始集成 WaveNet API。

创建 TextToSpeechClient 实例:通过实例化 Google Cloud 的 TextToSpeechClient 来调用 API。

构建请求对象:设置语音合成所需的文本和配置参数,比如语言代码和语音属性。

调用 WaveNet API:使用 client 对象调用 synthesizeSpeech 方法,传入请求对象。

处理响应:获取返回的 Synthesized Speech,并将音频内容写入文件。

import com.google.cloud.texttospeech.v1.TextToSpeechClient;

import com.google.cloud.texttospeech.v1.SynthesisInput;

import com.google.cloud.texttospeech.v1.VoiceSelectionParams;

import com.google.cloud.texttospeech.v1.AudioConfig;

import com.google.cloud.texttospeech.v1.AudioEncoding;

import com.google.protobuf.ByteString;

import java.io.FileOutputStream;

import java.io.OutputStream;

public class WaveNetSynthesizer {

public static void main(String[] args) {

try (TextToSpeechClient textToSpeechClient = TextToSpeechClient.create()) {

SynthesisInput input = SynthesisInput.newBuilder().setText("Hello, World!").build();

VoiceSelectionParams voice = VoiceSelectionParams.newBuilder()

.setLanguageCode("en-US")

.setName("en-US-Wavenet-D")

.build();

AudioConfig audioConfig = AudioConfig.newBuilder().setAudioEncoding(AudioEncoding.MP3).build();

com.google.cloud.texttospeech.v1.SynthesizeSpeechResponse response =

textToSpeechClient.synthesizeSpeech(input, voice, audioConfig);

ByteString audioContents = response.getAudioContent();

try (OutputStream out = new FileOutputStream("output.mp3")) {

out.write(audioContents.toByteArray());

}

} catch (Exception e) {

e.printStackTrace();

}

}

}

高质量语音合成:WaveNet 能够生成更为自然的语音,极大地改善了用户体验。

灵活性:支持多种语言和语音样式,能够满足不同应用场景的需求。

易于集成:通过丰富的 API 和文档,开发者可以轻松集成到现有项目中。

学习曲线:对于新手开发者而言,API 的使用需要一定的学习。

成本:调用 API 可能涉及到一定的费用,需根据项目预算进行合理规划。

响应时间:网络延迟可能影响语音合成的实时性,需在设计时考虑优化。

Google Cloud 提供了便捷的服务来使用 WaveNet API,我们可以通过以下步骤来实现。

开通 Google Cloud 账户:访问 Google Cloud 网站,注册并开通账户。

启用 API:在 Google Cloud 控制台中,启用 Cloud Text-to-Speech API。

生成 API 密钥:创建项目并生成 API 密钥,用于后续的 API 调用。

除了 Java,我们还可以使用 Python 来调用 WaveNet API,这对于快速开发和测试非常有帮助。

from google.cloud import texttospeech

def synthesize_text(text):

client = texttospeech.TextToSpeechClient()

input_text = texttospeech.SynthesisInput(text=text)

voice = texttospeech.VoiceSelectionParams(

language_code='en-US',

ssml_gender=texttospeech.SsmlVoiceGender.FEMALE)

audio_config = texttospeech.AudioConfig(

audio_encoding=texttospeech.AudioEncoding.MP3)

response = client.synthesize_speech(

input=input_text, voice=voice, audio_config=audio_config)

with open('output.mp3', 'wb') as out:

out.write(response.audio_content)

print('Audio content written to file "output.mp3"')随着 AI 技术的不断进步,语音合成将会发展得更加智能和自然。

AI 模型将会更加智能,能够理解上下文语义,从而生成更为连贯和自然的语音。

语音合成技术将会应用到更多的场景中,如智能家居、虚拟助手、自动驾驶等。

未来的技术将支持更个性化的语音合成,能够模仿特定人物的声音或生成用户定制的语音特征。

问:如何开始使用 WaveNet API?

问:WaveNet API 支持哪些语言?

问:可以在本地运行 WaveNet 模型吗?

问:使用 WaveNet API 是否需要付费?

问:如何提高语音合成的质量?