文心一言写代码:代码生成力的探索

Mistral AI 是人工智能领域的新生力量,凭借其创新的模型和快速的开发周期迅速崭露头角。仅在不到一年的时间里,他们就开发并发布了多个重要的 AI 模型。在预算有限的情况下,Mistral AI 通过高效的资源管理和技术创新,成功开发出参数为 70 亿的开源模型,与行业巨头的昂贵项目形成鲜明对比。

Mistral AI 的成功在于其对市场需求的精准把握和技术创新的不断突破。以下是其主要关注点:

Mistral AI 的战略优势在于其对本地部署的开放性。这种灵活性使得需要数据安全和隐私保护的客户受益匪浅,尤其是金融和政府领域的客户。通过与 Azure 的合作,他们的模型也变得更加易于获取和使用。

Mistral AI 的模型不仅在性能上表现卓越,还通过其平台 La Plateforme 和 Azure 提供了极大的可访问性。用户可以通过直观的界面和灵活的 API 访问这些模型,满足多种使用场景的需求。

在 AI 领域,基准测试是评估模型性能的重要手段。Mistral AI 的模型在多个基准测试中表现优异,尤其是在自然语言理解和生成任务中。值得注意的是,基准测试虽然重要,但并不能完全反映模型的实际能力。

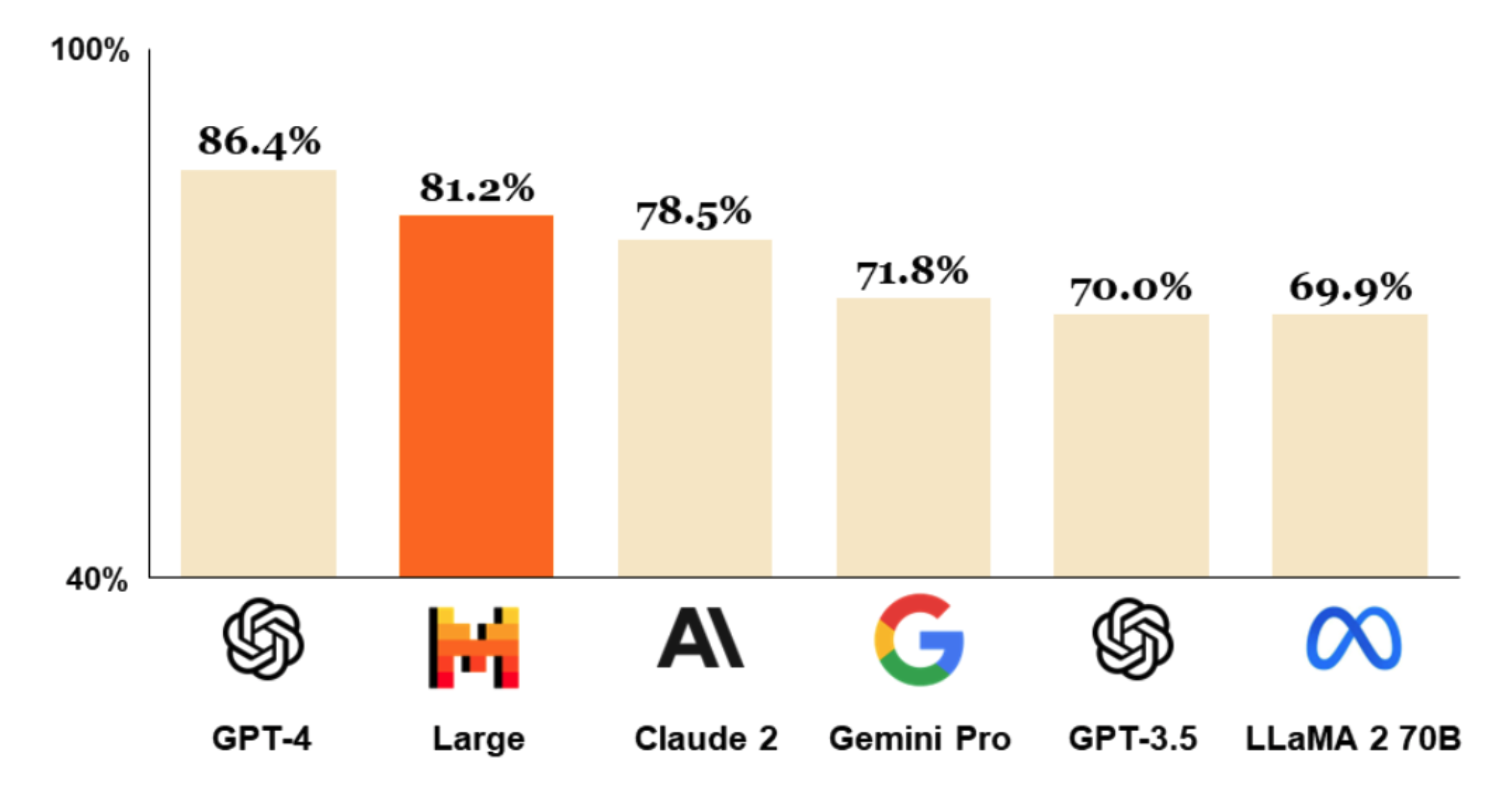

在 MMLU 基准测试中,Mistral AI 的最新模型表现仅次于 GPT-4。然而,其他如 Gemini Ultra 和 Gemini Pro 1.5 的模型在综合测试中表现更为优异。这反映出 AI 领域中基准测试的局限性。

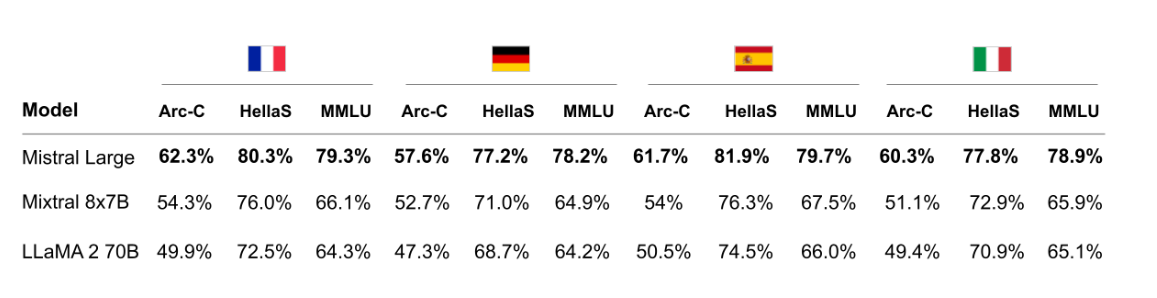

Mistral AI 模型的多语言能力是其一大亮点。尽管主要集中在西欧语言,Mistral AI 仍在语言多样性上取得了显著进展,与以英语为中心的模型相比有明显优势。

Mistral AI 的 32k 上下文窗口为复杂和细致的交互提供了支持。虽然不是业内首创,但相较于更小的上下文窗口,这一改进显著提升了模型的实用性和灵活性。

Mistral AI 模型能够精确地遵循用户指令,这不仅提升了用户体验,还为开发者提供了更大的自由度来定制管理策略。

Mistral AI 的模型在推理方面表现出色,尤其是在 GSM 8K 等复杂场景中。其支持本地函数调用的能力展示了模型在直观和上下文感知 AI 交互中的潜力。

为了评估 Mistral Large 的性能,我们使用 LangChain 进行 API 调用。首先需要设置环境变量,并通过以下代码片段进行集成:

import os

os.environ["MISTRAL_API_KEY"] = 'your_api_key_here'接着,我们使用 LangChain 的工具与 Mistral Large 进行交互。以下是基本的 API 调用示例:

from langchain_core.messages import HumanMessage

from langchain_mistralai.chat_models import ChatMistralAI

chat = ChatMistralAI(

model="mistral-large-latest",

temperature=0.7,

max_tokens=128,

)

messages = [HumanMessage(content="Hello, how can I help you?")]

response = chat.invoke(messages)

print(response.content)Mistral Large 的响应风格独特,与 OpenAI 和其他模型相比具有明显的差异性。通过类比和具体指令的测试提示,显示了其在遵循系统提示和产生多样化响应方面的出色表现。

以下代码展示了如何生成基于指令的响应:

generate('Write a short email to introduce Mistral Large',

system_prompt="You are Mistral Large, a large language model trained by Mistral. Write out your reasoning step-by-step to be sure you get the right answers!",

max_length=512)在创意写作和代码生成任务中,Mistral Large 展现了强大的能力,尤其是在 GSM 8K 问题上,表现与 GPT-4 相当。

Mistral Medium 与 Mistral Large 在逻辑和推理能力上存在差异。虽然 Medium 在某些情况下表现出色,但 Large 在更广泛的数据集上进行了增强训练,因而在复杂任务中更加可靠。

Mistral Medium 在 GSM 8K 问题中展示了不同但有效的推理模式,这证明了其训练方法的高效。

Mistral Large 在函数调用方面表现出色。以下是模拟餐厅场景的函数调用示例:

def take_away_order(food_items: str) -> str:

return f"您的{food_items}已经在路上了!"

def online_booking(day: str, time: str) -> str:

return f"您的预订已安排在{day}的{time}。无需重新确认,请准时到达"为模型创建 JSON Schema 是必不可少的,它定义了需要处理的参数。以下是 JSON Schema 的示例:

tools = [

{

"type": "function",

"function": {

"name": "take_away_order",

"description": "为您想要取走和外带的食物下订单",

"parameters": {

"type": "object",

"properties": {

"food_items": {

"type": "string",

"description": "您想要订购的食物",

}

},

"required": ["food_items"],

},

},

},

{

"type": "function",

"function": {

"name": "online_booking",

"description": "在餐厅预订午餐或晚餐",

"parameters": {

"type": "object",

"properties": {

"day": {

"type": "string",

"description": "您想要在餐厅用餐的日期",

},

"time": {

"type": "string",

"description": "您想要预订午餐或晚餐的时间",

}

},

"required": ["day", "time"],

},

},

}

]通过以下代码,我们可以观察模型如何处理对话,并识别何时调用函数:

import functools

names_to_functions = {

'take_away_order': functools.partial(take_away_order),

'online_booking': functools.partial(online_booking)

}

messages = [

ChatMessage(role="user", content="您好,我可以下一个外卖订单,30 分钟后取走吗?")

]Mistral Large 在处理需要多个参数的复杂对话时表现出色,展示了其在用户交互中的适应性。

Mistral Large 代表了大型语言模型领域的重大进步,尤其是在实际应用和函数调用方面。其自然流畅的对话和复杂任务的执行能力,证明了其设计的复杂性和功能的强大。

答:Mistral Large 在某些方面如推理和多语言支持上表现出色,特别是在函数调用方面,与 GPT-4 相比具有竞争力。

答:可以通过设置环境变量和使用 LangChain 等工具进行 API 集成,具体步骤可参考本文的相关章节。

答:是的,Mistral Large 支持多种欧洲语言,虽然在亚洲语言方面的支持较少,但在西欧语言中表现优异。

答:Mistral AI 在有限的预算下开发出高质量模型,展示了极高的成本效益,是其一大竞争优势。

答:Mistral Large 的 32k 上下文窗口支持更细致的交互,虽然不是首创,但相较于更小的窗口,这一改进显著提升了模型的实用性。