LLM的预训练任务有哪些

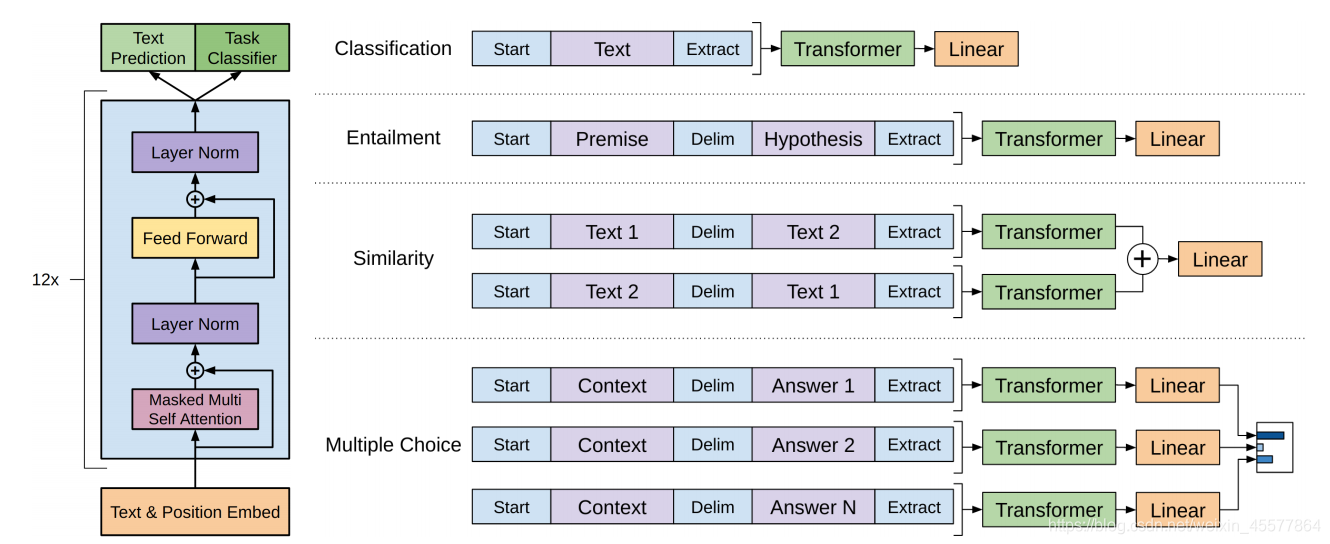

GPT模型,即生成式预训练模型,是一种通过无监督预训练和有监督精调过程来处理自然语言处理任务的架构。其核心结构由12个Transformer Decoder的block堆叠而成。这种结构使得GPT模型在理解和生成自然语言方面表现出色。下图展示了GPT模型的整体结构:

在GPT模型中,预训练阶段采用无监督学习,通过大量文本数据进行语言模型的训练,然后在特定任务上通过有监督学习进行微调。这种两阶段训练方法使得GPT模型能够在多个自然语言处理任务上取得卓越的表现。

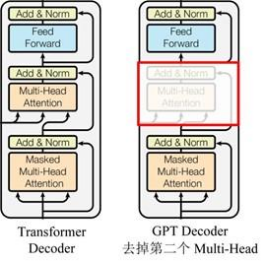

GPT使用了Transformer的Decoder结构,并对其进行了改进。原本的Decoder包含了两个Multi-Head Attention结构,而GPT只保留了Mask Multi-Head Attention。这一改动使得模型能够更高效地处理自然语言生成任务,如下图所示:

在这个结构中,Transformer的优势在于其强大的特征提取能力。与传统的RNN相比,Transformer能够捕捉更长距离的依赖关系,从而提高模型的语言理解能力。

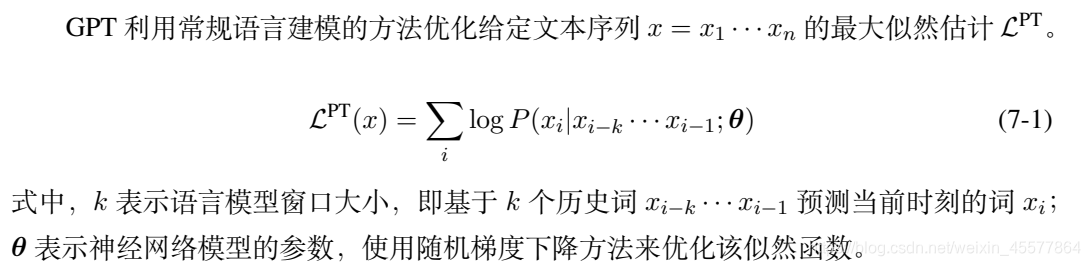

在预训练阶段,GPT通过大量无标签的文本数据进行语言模型训练。其目标是最大化给定句子中每个单词的条件概率,如下图所示:

在这个过程中,GPT使用多层Transformer的Decoder来处理输入文本,并计算每个词的概率分布。这种方法有效地捕捉了文本中的语义信息,为后续的微调阶段提供了坚实的基础。

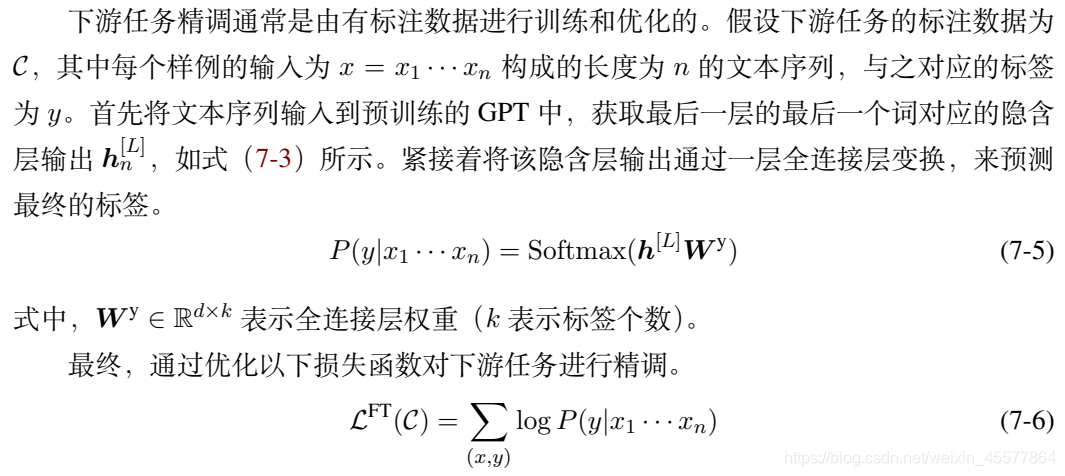

在下游任务中,GPT通过有监督学习进行微调。微调阶段的目标是根据特定任务的需求调整预训练模型的参数,从而提高模型在该任务上的表现。下图展示了微调阶段的过程:

在实际应用中,GPT可以被用于多种自然语言处理任务,包括文本分类、情感分析和问答系统等。在微调过程中,GPT通过结合任务特定的数据和标签来优化模型,从而提升其在特定任务上的性能。

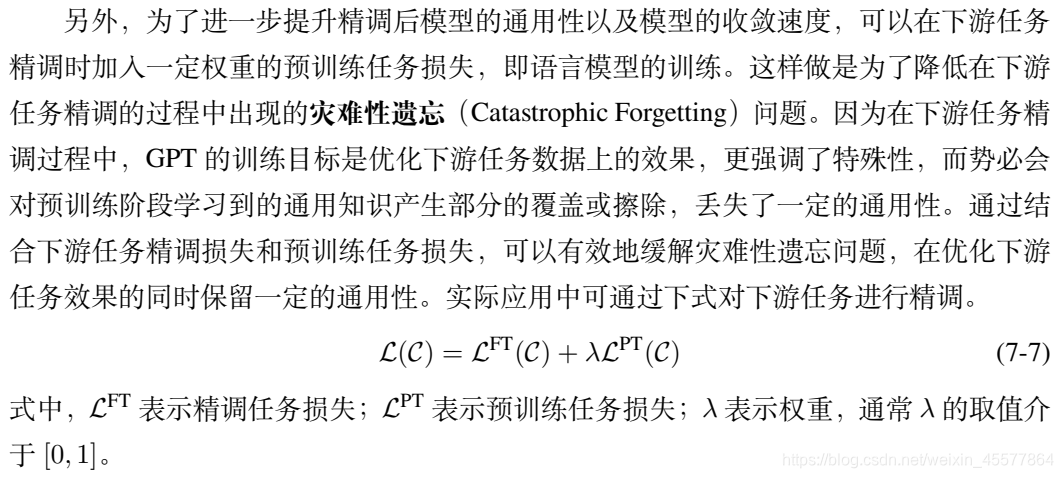

GPT的损失函数是上游任务和下游任务损失的线性组合。在预训练阶段,损失函数主要关注语言模型的准确性,而在微调阶段,损失函数会根据具体任务进行调整。下图展示了损失函数的计算过程:

这种损失函数设计使得GPT模型能够有效地在不同任务之间共享知识,从而提高整体性能和泛化能力。

GPT的计算过程包括以下几个步骤:

在实际应用中,GPT的计算过程包括Embedding、Transformer block和输出层等多个步骤,这些步骤紧密结合,共同实现了GPT模型的强大语言处理能力。

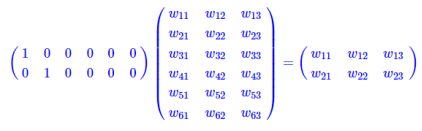

在GPT中,Embedding层是输入处理的关键步骤之一。Embedding层将输入的one-hot编码转换为低维的词向量表示。这种查表操作大大降低了计算复杂度,使得模型能够高效地处理大规模文本数据。下图展示了Embedding层的结构:

通过将高维的one-hot编码转换为低维的词向量,GPT能够更好地捕捉词语之间的语义关系,为后续的Transformer计算提供了丰富的语义信息。

答:GPT模型采用了Transformer结构,能够捕捉更长距离的依赖关系,并通过预训练和微调两个阶段大幅提升了模型的泛化能力和任务适应性。

答:GPT模型通过自回归方式生成文本,即根据已生成的文本预测下一个单词,逐步生成完整的句子或段落。

答:GPT模型在处理长文本时可能会面临上下文丢失的问题,此外,模型的计算资源需求较高,对硬件和软件环境有一定要求。

答:可以通过调整模型的超参数、增加训练数据量以及采用更高效的并行计算策略来优化GPT模型的性能。

答:GPT模型支持多种下游任务,包括文本分类、情感分析、机器翻译和问答系统等。