中文命名实体识别(Named Entity Recognition, NER)初探

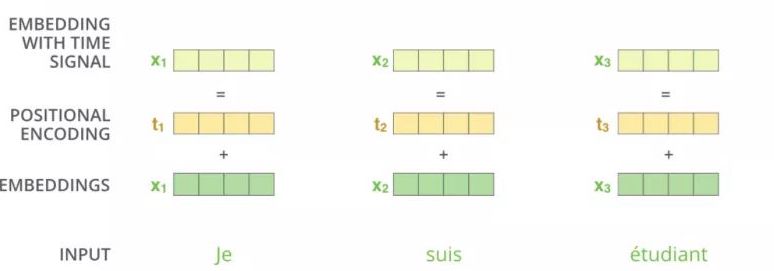

位置编码是Transformer架构中一个关键的组成部分,用于在不使用RNN的情况下捕捉序列数据中的顺序信息。由于Transformer模型本身是无序的,因此需要位置编码来为每个输入向量提供位置信息,从而帮助模型学习到序列的顺序依赖关系。

位置编码通常通过一种可学习的方式进行初始化,并在训练过程中不断更新。最常见的实现方法是使用正弦和余弦函数生成固定的编码,或使用可学习的编码向量。Pytorch中的位置编码实现提供了高效且灵活的方式来进行这种编码。

在Pytorch中,位置编码的实现可以通过继承nn.Module类来创建一个自定义的模块。这个模块需要在初始化时生成位置编码矩阵,并在前向传播时将编码加到输入的嵌入向量中。

以下是一个简单的Pytorch位置编码实现示例:

class PositionalEncoding(nn.Module):

def __init__(self, dim, dropout, max_len=5000):

super(PositionalEncoding, self).__init__()

if dim % 2 != 0:

raise ValueError("Cannot use sin/cos positional encoding with odd dim (got dim={:d})".format(dim))

pe = torch.zeros(max_len, dim) # max_len 是解码器生成句子的最长的长度,假设是 10

position = torch.arange(0, max_len).unsqueeze(1)

div_term = torch.exp((torch.arange(0, dim, 2, dtype=torch.float) * -(math.log(10000.0) / dim)))

pe[:, 0::2] = torch.sin(position.float() * div_term)

pe[:, 1::2] = torch.cos(position.float() * div_term)

pe = pe.unsqueeze(1)

self.register_buffer('pe', pe)

self.drop_out = nn.Dropout(p=dropout)

self.dim = dim

def forward(self, emb, step=None):

emb = emb * math.sqrt(self.dim)

if step is None:

emb = emb + self.pe[:emb.size(0)]

else:

emb = emb + self.pe[step]

emb = self.drop_out(emb)

return emb这个代码片段展示了如何在Pytorch中实现位置编码,其中包括初始化编码矩阵,定义前向传播过程,并使用sin和cos函数生成编码。

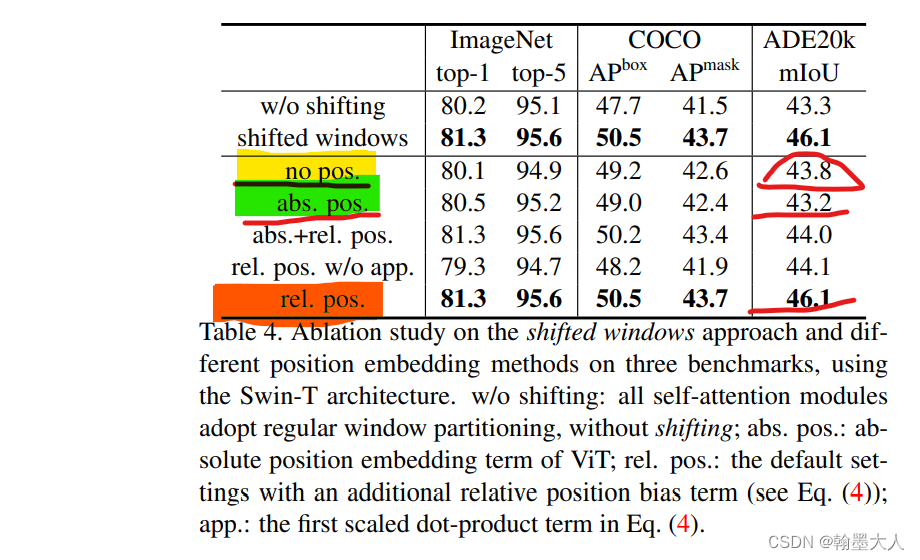

在VisionTransformer中,位置编码被设计为可学习的。这意味着在训练过程中,模型可以调整位置编码以优化性能。下面是一个实现可学习绝对位置编码的代码示例:

self.pos_embed = nn.Parameter(torch.zeros(1, num_patches + self.num_tokens, embed_dim))

def forward_features(self, x):

# [B, C, H, W] -> [B, num_patches, embed_dim]

x = self.patch_embed(x) # [B, 196, 768]

# [1, 1, 768] -> [B, 1, 768]

cls_token = self.cls_token.expand(x.shape[0], -1, -1)

if self.dist_token is None:

x = torch.cat((cls_token, x), dim=1) # [B, 197, 768]

else:

x = torch.cat((cls_token, self.dist_token.expand(x.shape[0], -1, -1), x), dim=1)

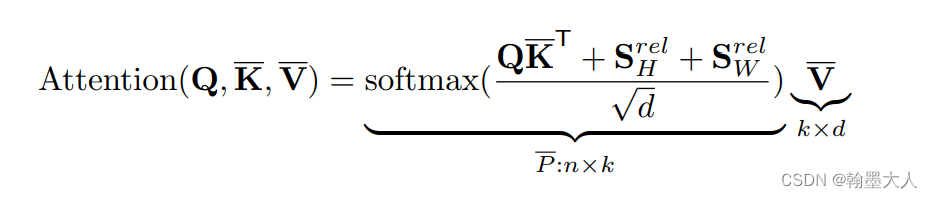

x = self.pos_drop(x + self.pos_embed)相对位置编码是一种改进的编码方法,能够捕捉序列中元素之间的相对位置信息。在SwinTransformer中,相对位置编码被广泛应用于图像处理任务。

以下代码展示了如何在Pytorch中实现相对位置编码:

class RelativePositionBias(nn.Module):

def __init__(self, num_heads, h, w): # (4,16,16)

super().__init__()

self.num_heads = num_heads #4

self.h = h #16

self.w = w #16

self.relative_position_bias_table = nn.Parameter(

torch.randn((2 * h - 1) * (2 * w - 1), num_heads) * 0.02) # (961,4)

coords_h = torch.arange(self.h) # [0,16]

coords_w = torch.arange(self.w) # [0,16]

coords = torch.stack(torch.meshgrid([coords_h, coords_w])) # (2, 16, 16)

coords_flatten = torch.flatten(coords, 1) # (2, 256)

relative_coords = coords_flatten[:, :, None] - coords_flatten[:, None, :] #(2,256,256)

relative_coords = relative_coords.permute(1, 2, 0).contiguous() #(256,256,2)

relative_coords[:, :, 0] += self.h - 1 #(256,256,2)

relative_coords[:, :, 1] += self.w - 1

relative_coords[:, :, 0] *= 2 * self.h - 1

relative_position_index = relative_coords.sum(-1) # (256, 256)

self.register_buffer("relative_position_index", relative_position_index)

def forward(self, H, W):

relative_position_bias = self.relative_position_bias_table[self.relative_position_index.view(-1)].view(self.h,self.w,self.h * self.w,-1) # h, w, hw, nH (16,16,256,4)

relative_position_bias_expand_h = torch.repeat_interleave(relative_position_bias, H // self.h,dim=0) # (在dim=0维度重复7次)->(112,16,256,4)

relative_position_bias_expanded = torch.repeat_interleave(relative_position_bias_expand_h, W // self.w,dim=1) # HW, hw, nH #(在dim=1维度重复7次)

relative_position_bias_expanded = relative_position_bias_expanded.view(H * W, self.h * self.w,

self.num_heads).permute(2, 0,1).contiguous().unsqueeze(0)

return relative_position_bias_expanded相对位置编码在捕捉序列的相对位置信息方面具有显著优势,尤其是在处理长序列或大尺寸图像时。相较于绝对位置编码,相对位置编码可以更好地泛化到不同的输入尺寸和不同的任务场景。

尽管相对位置编码带来了许多性能上的提升,但其实现也面临一些挑战。主要问题在于计算复杂度的增加,以及如何有效地在不同任务中调整编码参数。

位置编码在许多自然语言处理和计算机视觉任务中都有广泛应用。具体来说,在机器翻译、文本摘要、语义分割等任务中,位置编码都发挥了重要作用。

通过本文的讨论,我们了解到位置编码在Transformer模型中的重要性,以及Pytorch中实现位置编码的几种方法。位置编码不仅增强了模型捕捉序列顺序信息的能力,还为复杂任务提供了更好的泛化性能。

问:位置编码在Transformer中有什么作用?

问:Pytorch中如何实现位置编码?

问:相对位置编码有哪些优势?

问:位置编码在计算机视觉任务中的应用是什么?