Hunyuan Video API 价格:详解与比较

文章目录

腾讯混元最近推出的Hunyuan-Large模型,以其强大的功能和开源的优势,迅速成为业内关注的焦点。本文将详细探讨该模型的规格、费用结构、性能评测,以及其在国内外ChatGPT类语言大模型中的价格对比,帮助您更好地理解和应用Hunyuan Video API。

Hunyuan-Large模型规格

Hunyuan-Large是目前业界已开源的最大MoE(Mixture of Experts)模型之一。它拥有3890亿总参数和520亿激活参数,最大上下文长度达到128K。当前API版本暂时支持32K上下文。这些规格意味着Hunyuan-Large可以处理更复杂和大规模的数据集,为用户提供更高效的计算能力和更准确的结果。

模型的技术特点

Hunyuan-Large的设计结合了最新的深度学习技术,使其能够在多任务环境中表现出色。其3890亿的总参数量,使其能够在处理大规模数据时,依然保持高效的计算能力。此外,该模型的520亿激活参数能够动态选择最合适的专家网络进行处理,从而提高响应速度和准确性。

应用场景

Hunyuan-Large模型广泛应用于自然语言处理、计算机视觉和其他需要大规模模型计算的领域。在这些应用中,Hunyuan-Large通过其强大的参数优势和高效的计算能力,能够显著提升模型的表现和用户体验。

Hunyuan-Large模型费用结构

Hunyuan-Large的使用费用分为输入和输出费用,分别为4元/百万tokens和12元/百万tokens。这种费用结构为用户提供了一种灵活的使用方式,可以根据实际需求调整成本。

输入费用的计算

输入费用是指用户在调用API时,输入数据所产生的费用。以百万tokens为单位,每百万tokens为4元。这一费用结构适合需要大量数据输入的应用场景。

输出费用的计算

输出费用指的是API返回结果时所产生的费用。同样以百万tokens为单位,每百万tokens为12元。这一费用结构适合需要高频次调用API获取结果的场景。

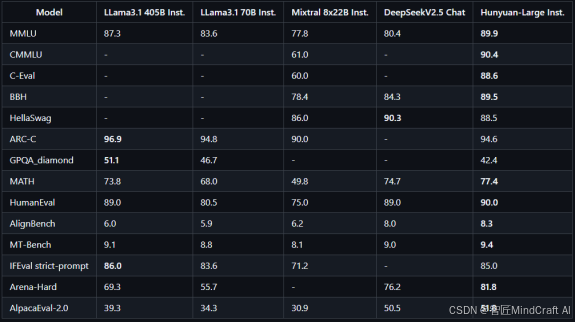

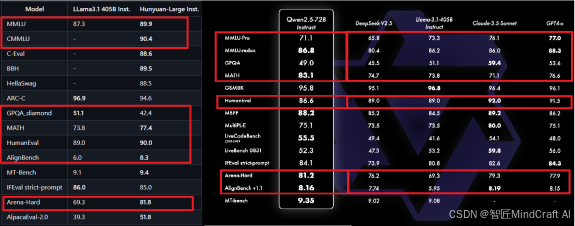

Hunyuan-Large模型性能评测

在多项性能评测中,Hunyuan-Large表现出色,尤其在与Llama3.1-405B和Qwen2.5 72B的对比中,Hunyuan-Large在综合性能上领先。尽管在数学能力上略逊于Qwen2.5 72B,但其整体表现仍然优于Llama3.1、GPT-4o和Claude3.5 Sonnet。

性能评测指标

Hunyuan-Large在多个关键指标上表现优异,包括自然语言处理、图像识别和多任务学习能力等。这些指标不仅显示了模型在各个方面的能力,也为选择适合应用场景的模型提供了数据支持。

与其他模型的比较

在与其他开源模型的对比中,Hunyuan-Large的表现尤其突出。在大多数通用任务中,其性能都超过了Llama3.1和GPT-4o,这使得它成为大规模应用的理想选择。

Hunyuan-Large模型的使用方式

用户可以通过PC客户端和手机小程序使用Hunyuan-Large模型。这种多平台支持的方式,使得用户可以根据需要选择最适合的使用方式,确保模型的易用性和便捷性。

PC客户端的使用

PC客户端提供了完整的功能接口,用户可以在本地环境中进行模型调用和结果处理。这种使用方式适合需要大量计算和结果分析的场景。

手机小程序的使用

手机小程序则提供了更加便捷的使用方式,适合移动办公和随时随地调用API的需求。用户可以通过简单的操作,完成模型调用和结果获取。

Hunyuan-Large模型API的使用

通过登录开发者平台,用户可以访问接口文档,并在LLM调用页面参考调用代码,选择hunyuan-large进行调用。这一过程简单高效,确保用户能够快速上手使用。

API调用过程

API调用过程简单明了,用户只需按照接口文档中的指引,输入相应的参数,即可完成模型调用。这种简化的调用方式,降低了技术门槛,使得即使是非技术人员也能轻松使用。

调用代码示例

以下是一个简单的调用代码示例,帮助用户快速理解和应用Hunyuan-Large模型:

import requests

url = "https://api.tencentcloud.com/v2/index.php"

params = {

"Action": "Invoke",

"Model": "hunyuan-large",

"Input": "Your input data here"

}

response = requests.post(url, data=params)

print(response.json())国内外各ChatGPT类语言大模型API价格对比

在大模型时代,各大厂商纷纷推出自己的语言大模型,并提供相应的API服务。以下是对国内外主要ChatGPT类语言大模型的价格进行的汇总和比较。

国内外模型价格概述

2024年初,国内外的IT公司推出了多款类ChatGPT语言大模型,如ChatGPT、Gmini、PaLM、Clude、Ernie、ChatGLM、Qwen、Hunyuan、星火、Minimax和Baichuan。这些模型在价格和功能上各具特色,为用户提供了多种选择。

OpenAI的GPT模型

OpenAI的GPT模型在全球范围内广受欢迎,其官方定价策略也备受关注。微软的定价相对便宜,这主要得益于其大规模集群的优势和边际成本的降低。

GPT-4和GPT-4-Turbo定价

GPT-4和其变种GPT-4-Turbo的定价策略为用户提供了不同的选择。GPT-4-Turbo通过优化的计算架构,提供了更高效的计算能力和更低的使用成本。

谷歌的Gmini-PaLM2

谷歌的Gmini-PaLM2模型在价格上与市场上的其他模型相比,具有一定的竞争力。尽管在营销上面临挑战,但其技术实力仍然不可小觑。

亚马逊的Clude模型

亚马逊提供的Clude模型定价策略独特,用户可以选择按需调用API或租赁独享模型。这样的灵活性为不同需求的用户提供了更多选择。

百度的Ernie模型

百度的Ernie模型在深度学习时代积累了丰富的经验,其在大模型领域的ALL in AI战略也为其提供了强大的技术支持。

清华的ChatGLM模型

清华大学的ChatGLM模型以其强大的性能和低廉的价格,吸引了大量用户。ChatGLM-Turbo作为其变种,提供了更高的性价比。

阿里的Qwen模型

阿里的Qwen模型在开源方面表现出色,尽管市场反应平平,但其技术实力仍然值得关注。

腾讯的Hunyuan模型

腾讯的Hunyuan模型以其灵活的API调用方式和强大的性能,成为市场上备受瞩目的选择。其价格策略也为用户提供了高性价比的解决方案。

讯飞的星火模型

讯飞的星火模型尽管在价格上较高,但其在特定应用领域的表现仍然值得关注。

Minimax和Baichuan模型

Minimax和Baichuan虽然是市场上的新进入者,但其独特的市场定位和灵活的价格策略,使其在竞争激烈的市场中逐渐获得一席之地。

结论

通过对Hunyuan-Large模型的深入分析,我们可以看到其在技术规格、费用结构、性能评测和使用方式上的优势。同时,与其他国内外模型的价格对比,Hunyuan-Large在性价比和灵活性上也表现出色。随着大模型时代的到来,选择合适的模型和API服务,将为企业和个人带来巨大的价值。

FAQ

-

问:Hunyuan-Large模型支持哪些应用场景?

- 答:Hunyuan-Large模型广泛应用于自然语言处理、计算机视觉和多任务学习等领域,适合需要大规模数据处理的场景。

-

问:如何计算Hunyuan-Large的API使用费用?

- 答:API使用费用分为输入和输出费用,分别为4元/百万tokens和12元/百万tokens。根据使用的tokens数量计算总费用。

-

问:Hunyuan-Large的API调用是否复杂?

- 答:Hunyuan-Large的API调用过程简单明了,用户可以通过开发者平台访问接口文档,并按照指引完成调用,适合各类用户使用。

-

问:国内外其他语言大模型的价格如何?

- 答:国内外其他语言大模型的价格各有差异,用户可以根据自身需求选择适合的模型。OpenAI、谷歌、亚马逊、百度等均提供不同的价格策略。

-

问:Hunyuan-Large在性能上有何优势?

- 答:Hunyuan-Large在多项性能评测中表现出色,尤其在自然语言处理和图像识别等领域,表现优于大多数同类模型。

最新文章

- 小红书AI文章风格转换:违禁词替换与内容优化技巧指南

- REST API 设计:过滤、排序和分页

- 认证与授权API对比:OAuth vs JWT

- 如何获取 Coze开放平台 API 密钥(分步指南)

- 首次构建 API 时的 10 个错误状态代码以及如何修复它们

- 当中医遇上AI:贝业斯如何革新中医诊断

- 如何使用OAuth作用域为您的API添加细粒度权限

- LLM API:2025年的应用场景、工具与最佳实践 – Orq.ai

- API密钥——什么是API Key 密钥?

- 华为 UCM 推理技术加持:2025 工业设备秒级监控高并发 API 零门槛实战

- 使用JSON注入攻击API

- 思维链提示工程实战:如何通过API构建复杂推理的AI提示词系统