实时航班追踪背后的技术:在线飞机追踪器的工作原理

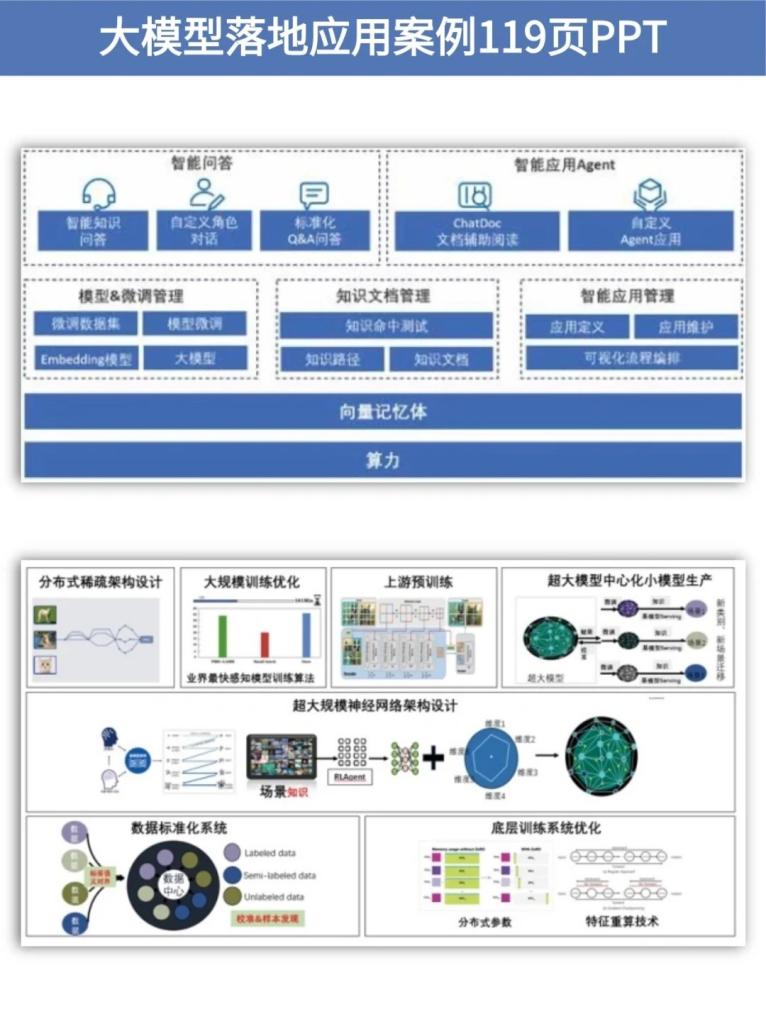

大型语言模型(LLMs)如OpenAI的GPT-4和谷歌的PaLM正在推动人工智能领域的快速发展。然而,很多公司和个人仍然依赖于这些大公司提供的模型,而缺乏自主训练的能力。在本文中,我们将深入探讨如何从零开始训练自己的LLMs,包括所需的基础设施、数据处理、模型训练和部署等关键步骤。

在许多情况下,通用的LLM无法完全满足特定的需求。通过训练自己的模型,可以根据特定的使用场景进行定制。例如,某些行业可能需要特定术语和上下文的理解,这些细节在通用模型中可能没有涵盖。我们可以通过调整训练数据和参数来满足这些特定需求。

依赖于少数AI供应商会限制创新和成本控制。通过训练自己的模型,企业可以减少对外部模型的依赖,从而更好地控制数据隐私和安全。此外,拥有自己的模型还可以为开源社区做出贡献,增强行业的合作与发展。

虽然训练LLM的成本很高,但对于一些特定应用,定制模型可能更具成本效益。通过优化模型和基础设施的使用,可以在降低成本的同时提高性能,这对于中小企业尤其重要。

训练LLM需要大量的数据,数据的质量和多样性是关键。首先需要收集大量的文本数据,这些数据可以来自书籍、文章、网站等。确保数据的多样性和代表性,以便模型能够适应不同的应用场景。

在进行模型训练之前,数据需要进行清洗和预处理。包括去除重复数据、去除个人敏感信息(PII)、格式化文本、清洗无用字符等。这些步骤确保数据的质量和一致性,提高模型的训练效果。

在数据预处理后,接下来是分词和词汇训练。分词是将文本分割成词或子词的过程,词汇训练则是建立一个模型使用的词汇表。定制的词汇表可以提高模型的理解和生成能力,加速训练过程。

目前,有多种框架可用于训练LLM,如TensorFlow、PyTorch、Hugging Face Transformers等。选择合适的框架取决于团队的技术熟练程度和项目需求。PyTorch以其灵活性和易用性获得广泛应用。

训练LLM需要强大的计算资源。通常需要GPU或TPU来加速训练过程。NVIDIA的Tesla V100和谷歌的TPU是常用的选择。确保安装最新的CUDA和cuDNN库以及所选框架的依赖项。

评估LLM的性能需要使用多种指标,如困惑度(Perplexity)、BLEU分数、ROUGE指标等。这些指标帮助评估模型的语言能力、生成质量和语义理解,确保模型在实际应用中的有效性。

根据评估结果,对模型进行优化是提升性能的关键。可以通过调整模型超参数、增加训练数据、改进数据预处理等方式进行优化。定期评估和迭代有助于持续提升模型质量。

一旦模型训练完成,需要将其部署到生产环境中。部署时需要考虑模型的响应速度和稳定性,可以使用NVIDIA的FasterTransformer和Triton Server来加速推理过程。

使用Kubernetes等工具可以实现根据需求自动扩展模型。这样不仅提高了资源利用率,还能在需求变化时快速调整部署规模,保障服务稳定性。

训练自己的LLMs是一项复杂但有价值的任务。通过定制化训练,可以满足特定需求,降低成本,并增强数据隐私和安全。尽管挑战重重,但随着技术的发展,训练自己模型的门槛正在逐渐降低。未来,更多的企业和个人将能够掌握这项技术。

问:训练自己的LLM需要多大的数据集?

问:如何选择合适的训练框架?

问:如何确保数据的安全性和隐私?

问:训练LLM的主要成本是什么?

问:如何优化模型的推理速度?