LLM的预训练任务有哪些

GPT4All 是一种强大的本地化 GPT 模型解决方案,适用于需要高隐私性和离线访问的用户。为了使用 GPT4All,首先需要从官方网站下载软件包。官方网站提供的下载链接为 GPT4All。

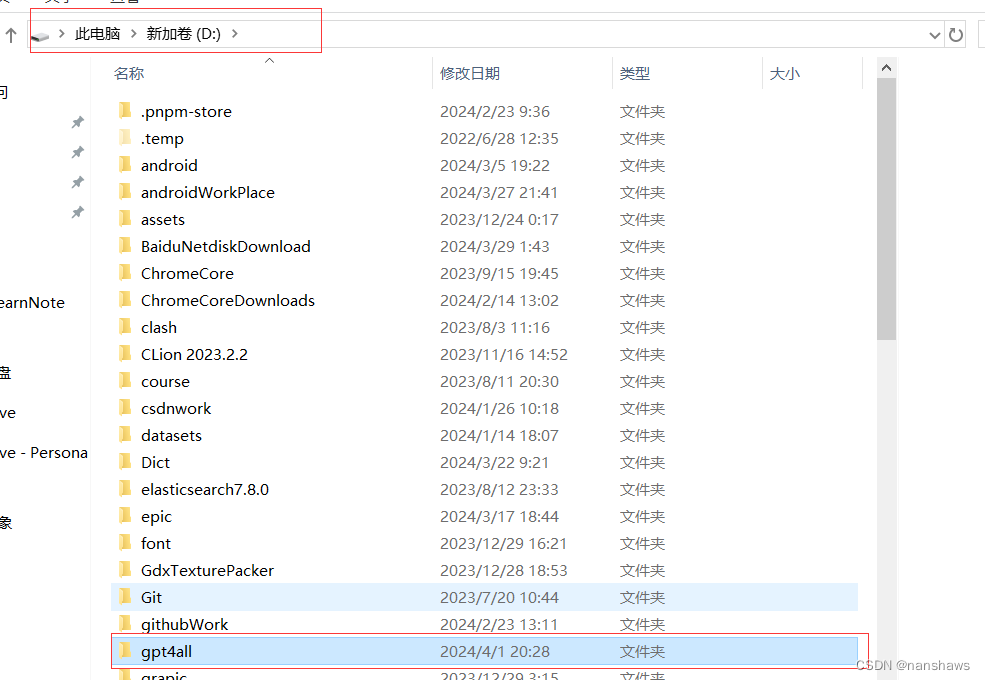

下载完成后,您需要将安装目录更改到您指定的路径。这可以通过安装向导完成,确保选择一个有足够存储空间的磁盘,以便后续下载模型。

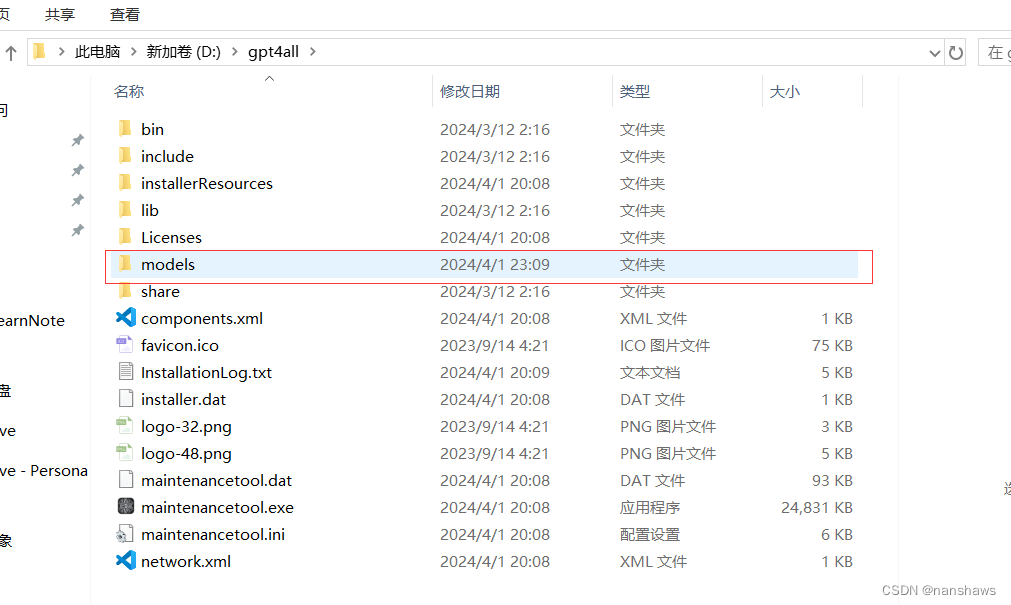

在安装完成后,您需要在 GPT4All 的安装目录下创建一个名为 models 的文件夹以存储模型文件。这一步骤非常关键,因为 GPT4All 会默认在此文件夹中查找模型文件。

下载模型的过程中,网络连接不稳定可能导致下载失败。这是最常见的问题,特别是对于大模型文件来说,下载时间较长会增加失败的概率。确保您的网络连接稳定,并尝试使用下载工具以支持断点续传。

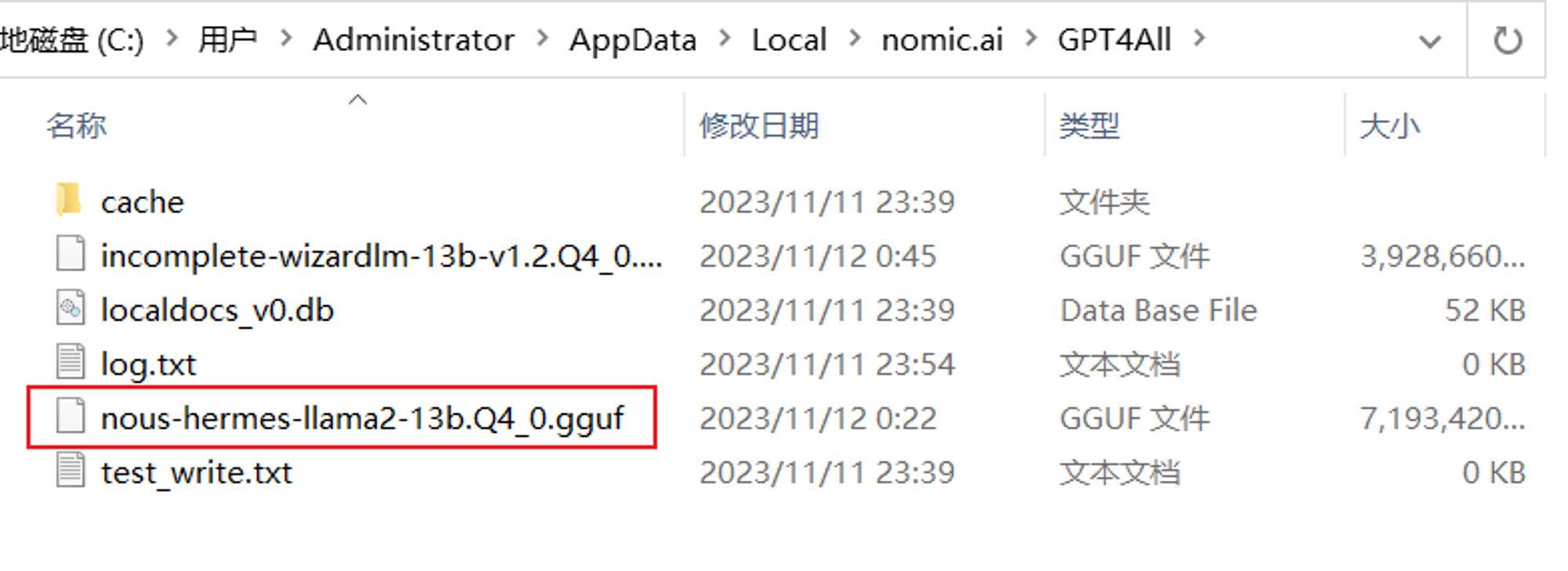

GPT4All 目前仅支持 gguf 格式的模型文件。因此,在下载模型时,请确认所下载的文件格式正确。对于不兼容的格式,您可以参考这篇文章了解更多:大模型文件格式区别和转换方式。

在某些操作系统中,权限设置可能会阻止文件的下载和保存。确保您对安装目录和模型文件夹具有写权限。您可以通过右键点击文件夹,选择“属性”来检查和修改权限设置。

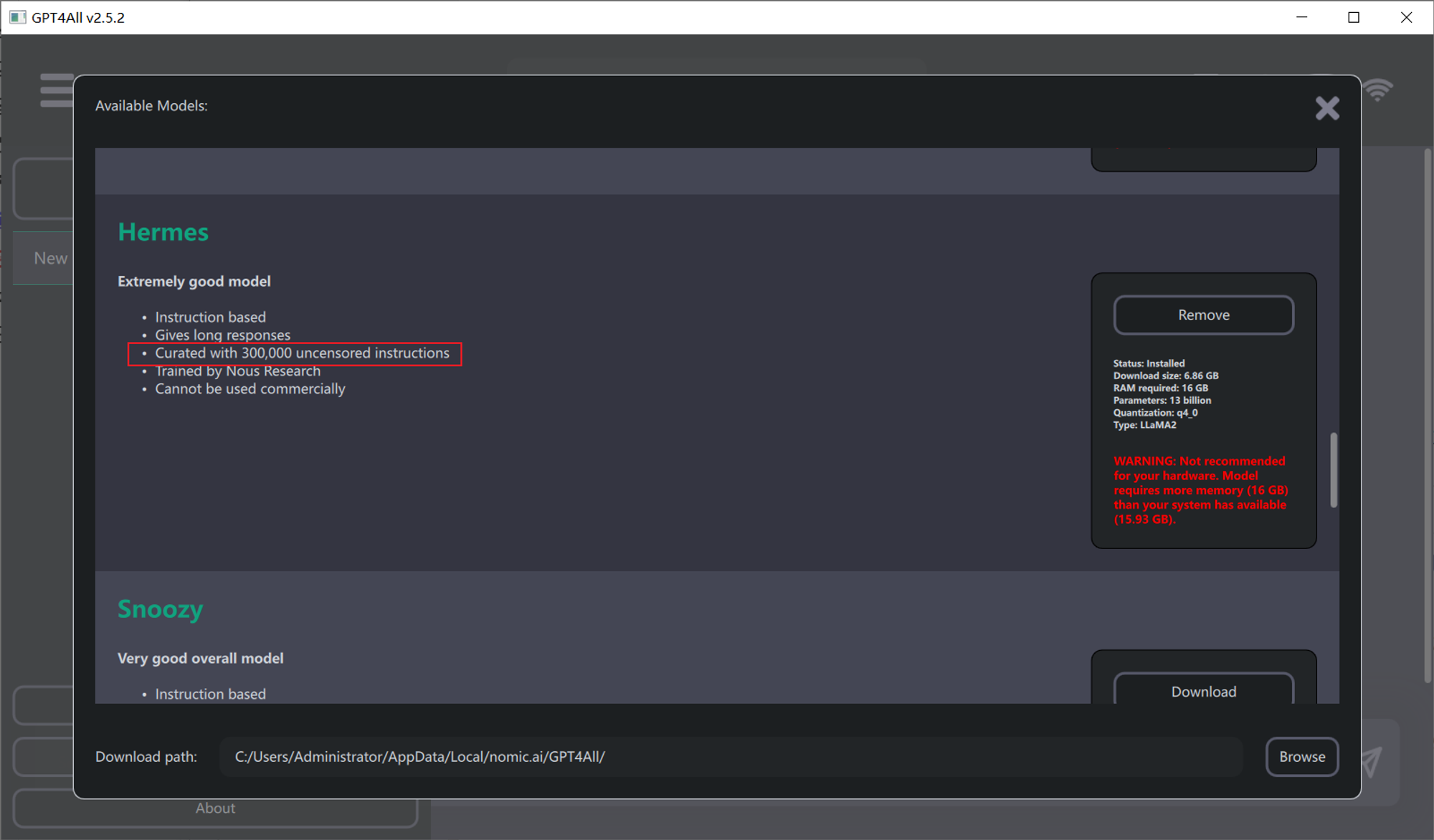

通过 GPT4All 客户端软件直接下载模型是最简单的方法。启动软件后,进入模型下载界面。选择所需的模型进行下载,建议选择较大容量的模型以获得更好的性能。推荐下载 Hermes 模型,因为它没有使用限制。

确保下载的模型文件正确存放于 C:/Users/Administrator/AppData/Local/nomic.ai/GPT4All/ 目录下。如果您在官网下载模型,也请将其移动到此目录中。

GPT4All 除了可以通过客户端使用外,也支持通过 Python 进行调用。此功能对开发者而言非常重要,因为它可以轻松集成到现有的自动化流程中。

首先,您需要安装 gpt4all Python 包。在您的命令提示符或终端中运行以下命令:

pip install gpt4all下载完模型后,您可以使用以下代码段来进行模型调用:

from gpt4all import GPT4All

model = GPT4All(model_name='gpt4all-falcon-q4_0.gguf',

model_path=r'C:/Users/Administrator/AppData/Local/nomic.ai/GPT4All/',

device='cpu',

allow_download=False)

with model.chat_session():

response1 = model.generate(prompt='write me a short poem of data scientist', temp=0, max_token=200)

print(response1)model_name: 您下载的模型文件名。model_path: 模型文件存储路径。device: 使用的设备,可以选择 cpu 或 nvidia。问:为什么下载模型会失败?

gguf,并检查权限设置。问:如何确保下载的模型文件格式正确?

gguf。如果不兼容,需进行格式转换。问:如何通过Python调用GPT4All模型?

gpt4all Python 包,并下载对应的模型文件。然后通过 GPT4All 类进行模型初始化和调用。问:在安装过程中需要注意哪些事项?

models 文件夹以存储模型文件。确保对相关目录具有写权限。问:下载模型后如何测试其功能?

通过以上步骤和指导,相信您能够顺利下载并使用 GPT4All 模型,享受高效、私密的本地化 GPT 服务。