如何调用 Minimax 的 API

生成对抗网络(GAN)一直以来是图像生成领域的热门话题,然而随着技术的发展,新的模型如扩散模型和自回归模型逐渐占据了主导地位。但GAN仍然有其独特的优势和潜力,特别是在高效图像合成和潜在空间编辑方面。近日,一种名为GigaGAN的新型GAN架构被提出,旨在进一步扩大GAN的规模和性能,为文本到图像生成带来新的突破。

GigaGAN是由POSTECH、卡耐基梅隆大学和Adobe研究院联合开发的一种新型生成对抗网络架构。它通过引入多种技术创新,使得GAN在大规模数据集上的表现得到了显著提升。GigaGAN不仅在速度上远超传统的扩散模型,如Stable Diffusion,还在高分辨率图像生成和潜在空间操作上表现出色。

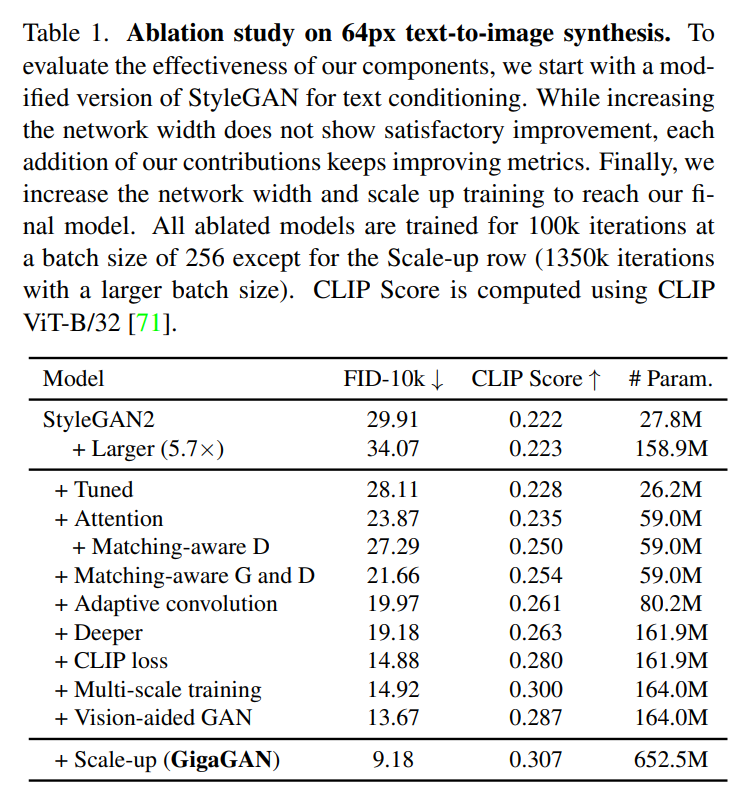

GigaGAN通过多尺度训练策略来提高模型的稳定性和性能。这种策略允许GAN生成器在低分辨率块中更有效地利用参数,从而实现更好的图像-文本对齐和图像质量。多尺度训练还帮助GigaGAN在LAION2B-en等大型数据集上实现了稳定和可扩展的训练。

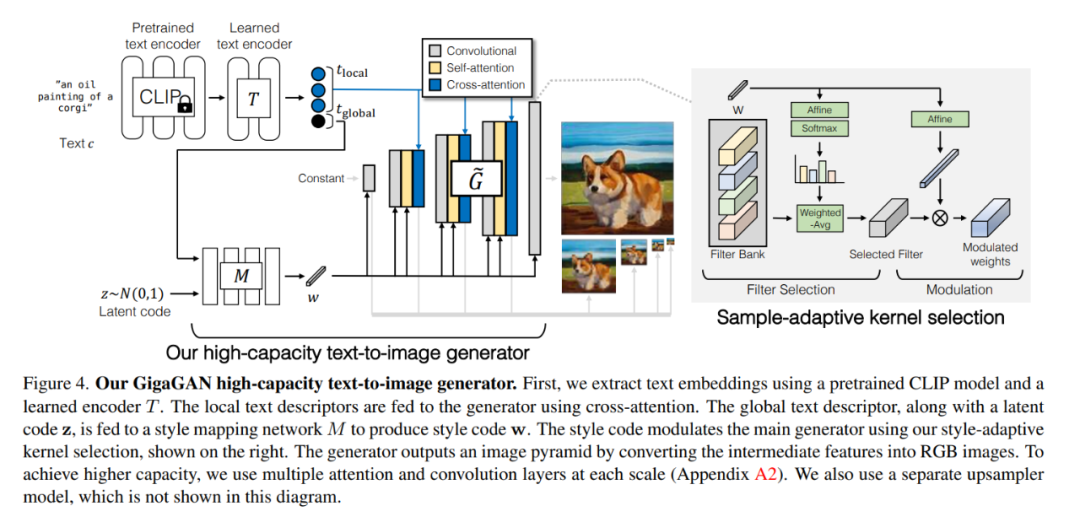

GigaGAN的生成器由文本编码分支、样式映射网络和多尺度综合网络组成,并辅以稳定注意力和自适应核选择。通过引入样本自适应核选择算法,GigaGAN可以根据输入文本条件动态选择卷积滤波器,提高生成图像的质量和细节。

GigaGAN的判别器采用多尺度输入输出机制,增强了对不同分辨率图像的处理能力。这种机制使得判别器能够在多个尺度上进行独立预测,从而提高了GAN的判别精度和训练效率。

在一系列实验中,GigaGAN在不同任务中都表现出色。其在文本-图像合成、超分辨率任务和潜在空间操作等方面的性能均优于传统GAN和一些扩散模型。值得注意的是,GigaGAN可以在0.13秒内生成512像素的图像,并在3.66秒内合成4k分辨率的图像。

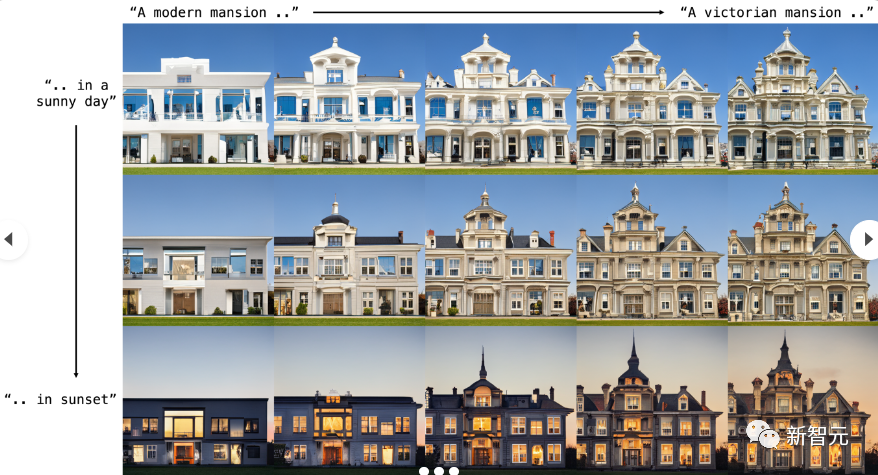

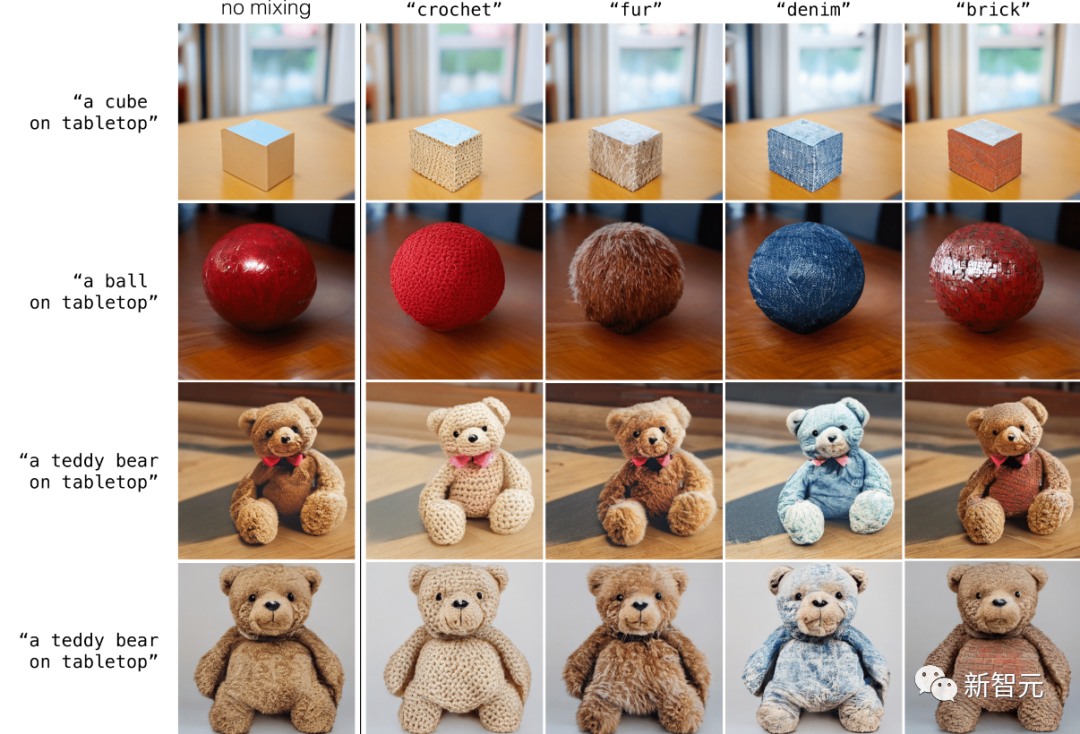

GigaGAN支持在不同提示之间进行平滑插值,这使得它在风格混合、prompt插值和prompt混合等应用中具有很大的潜力。在图像编辑应用中,GigaGAN能够在保持图像质量的同时实现复杂的样式转换。

借助其独特的潜在空间结构,GigaGAN可以实现解耦提示混合。这种功能允许用户将一个样本的粗样式与另一个样本的精细样式结合,从而实现更为复杂和细致的图像合成效果。

import torch

from gigagan_pytorch import GigaGAN, ImageDataset

gan = GigaGAN(

generator = dict(

style_network = dict(

dim = 64,

depth = 4

),

image_size = 256,

unconditional = True

),

discriminator = dict(

dim_capacity = 16,

image_size = 256,

unconditional = True

),

amp = True

).cuda()

dataset = ImageDataset(

folder = '/path/to/your/data',

image_size = 256

)

dataloader = dataset.get_dataloader(batch_size = 1)

gan.set_dataloader(dataloader)

gan(steps = 100, grad_accum_every = 8)

images = gan.generate(batch_size = 4) # (4, 3, 256, 256)GigaGAN通过引入多尺度训练和自适应核选择等多项技术创新,提升了生成质量和效率。相比传统GAN,GigaGAN在大规模数据集上的表现更为出色,并且能够在高分辨率图像生成和潜在空间操作中提供更多功能。

GigaGAN在文本到图像合成、风格混合、prompt插值和图像编辑等领域具有广泛的应用前景。其高效的生成速度和优异的图像质量使其在实际应用中拥有显著的优势。

使用GigaGAN进行高分辨率图像生成,只需通过其提供的API设置相应的生成参数,并将输入低分辨率图像进行上采样。GigaGAN的生成器会自动处理输入数据,输出高质量的图像结果。

GigaGAN在图像生成速度和资源效率上优于扩散模型,同时在潜在空间操作和图像编辑功能上提供了更多的灵活性。因此,对于需要快速生成高质量图像的应用场景,选择GigaGAN是一个更为高效的解决方案。

虽然GigaGAN主要用于图像生成,但其核心技术也可以应用于其他领域,如视频生成和三维模型生成。这些领域同样需要高效的生成能力和灵活的潜在空间操作。