文心一言写代码:代码生成力的探索

随着OpenAI对中国地区的封禁,许多企业开始考虑切换到国产大模型。这一事件背后或许与美国财政部针对中国AI产业的禁令有关,使得企业在选择AI服务时,更加倾向于本土化的解决方案。

这一政策变化促使中国市场更为关注本土AI模型的开发和应用,推动了国产大模型的崛起和发展。

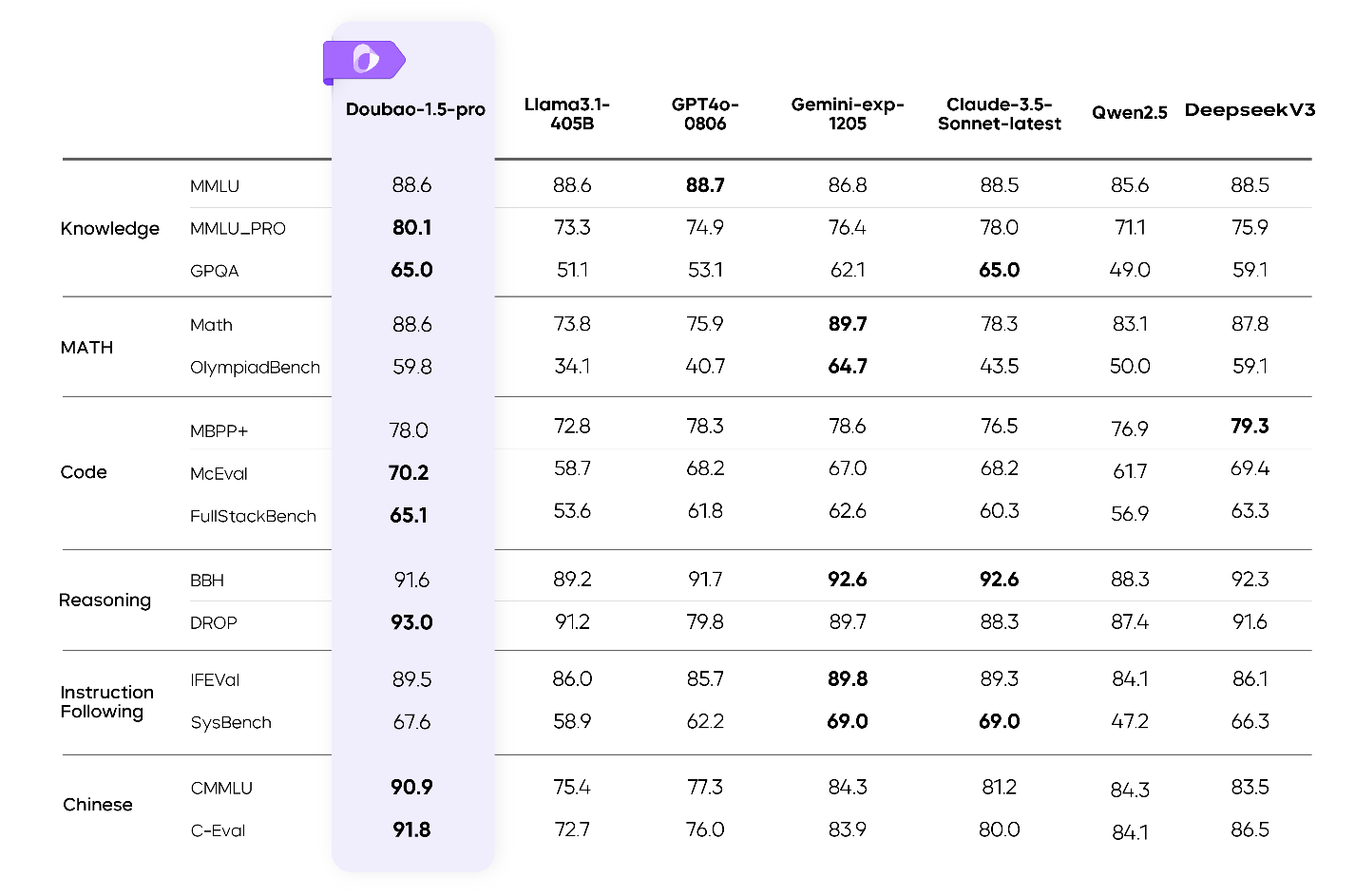

SuperCLUE 发布的「大模型跑分排行榜」显示,中国在全球前22名的大模型中占据了16个席位,这一数据表明,国产大模型不仅数量多,而且在性能上也具备了与国际大厂竞争的实力。

值得注意的是,百川智能的Baichuan3、清华智谱的GLM-4、阿里巴巴的通义千问2.1等国内大模型在性能指标上表现优异,成为了企业考虑替代方案的重要选项。

从容大模型1.5在多模态能力、训练效率和推理成本上都有显著的提升。其综合性能不仅在多项公开评测中表现优异,而且在实际应用中也展示出强大的竞争力。

从容大模型1.5的多模态能力不仅包括文本,还扩展到视觉和语音处理,使其能够在更复杂的场景中得心应手。

通过自有数据的训练和混合专家(MoE)架构的应用,从容大模型实现了低成本下的高性能,这对于需要处理海量数据和多模态信息的企业来说,提供了极具吸引力的解决方案。

在训练和推理效率方面,从容大模型1.5通过稀疏MoE架构,仅用较小参数激活,就能达到甚至超过许多大规模稠密模型的性能。

import numpy as np

class SparseMoE:

def __init__(self, num_experts):

self.num_experts = num_experts

self.experts = [self._create_expert() for _ in range(num_experts)]

def _create_expert(self):

return lambda x: x * np.random.rand(1)

def forward(self, x):

selected_expert = np.random.choice(self.experts)

return selected_expert(x)这种设计不仅提升了模型的性能,还显著降低了推理成本,使得从容大模型在实际应用中更具性价比。

相比于国际大厂的API价格,从容大模型的定价策略更为亲民,提供了多种套餐选择,满足企业的不同需求。

通过与其他国产大模型的价格对比可以看出,从容大模型在性价比方面具有显著优势,使其成为企业在选择AI服务时的理想选择。

从容大模型提供的API价格具有透明性,企业可以根据自身需求选择合适的套餐,避免不必要的开支。

这种灵活的定价策略不仅降低了企业的成本压力,也为其在数字化转型中提供了更多的可能性。

豆包大模型凭借其持续进化的能力和火山引擎的支持,正在逐步渗透到汽车、手机等多个行业。

火山引擎作为字节跳动旗下的云服务平台,不仅降低了豆包大模型的使用门槛,还通过技术支持加速了AI技术在各领域的应用。

火山引擎为豆包大模型提供了强大的计算能力和稳定的服务支持,使其在各类应用场景中能够快速部署和运行。

这不仅提升了豆包大模型的市场竞争力,也为AI技术的普及和应用提供了坚实的基础。

随着国产大模型的不断发展和政策的推动,中国的AI产业正在迎来新的发展机遇。从容大模型1.5以其出色的性能和合理的价格,成为企业数字化转型的重要工具。

未来,随着技术的不断进步和应用场景的扩展,国产大模型将在更多领域发挥重要作用,推动中国AI产业的持续发展。

问:为什么OpenAI会封禁中国的API调用?

问:国产大模型的性能如何?

问:从容大模型1.5的定价策略有何优势?

问:豆包大模型的多模态能力有哪些应用?

问:火山引擎如何支持豆包大模型的发展?