大模型RAG技术:从入门到实践

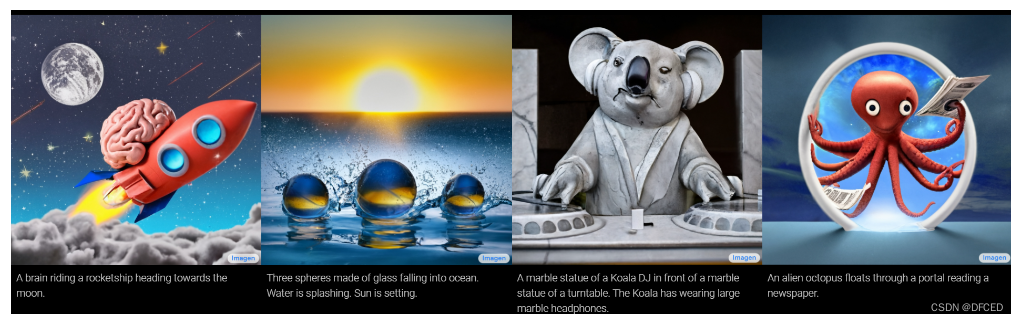

扩散模型理论在生成式AI中日益受到关注,其通过逐步添加和去噪高斯噪声来生成数据,与GAN和VAE等模型相比,具有无对抗性和高维隐空间的优势。本文详细解析了扩散模型在图像生成中的基本原理和实现方法,结合最新的研究成果,如DALL·E 2和Imagen,阐述了扩散模型在AI+艺术领域的应用潜力。

扩散模型(Diffusion Models)在生成模型领域的重要性日益增长。尽管最初未受到广泛关注,但随着OpenAI的DALL·E 2和Google的Imagen的成功应用,扩散模型逐渐走入大众视野。这些模型通过扩散过程生成高质量图像,展示了其在图像合成方面的潜力。

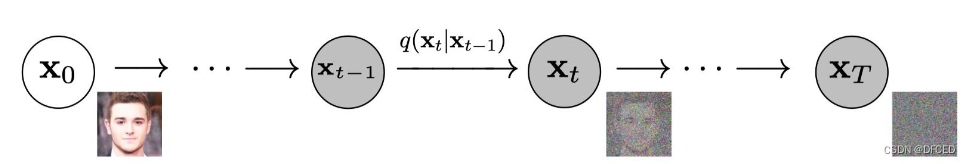

扩散模型的核心是通过添加噪声的方式破坏数据,然后逆向去噪以恢复数据。其过程可以视为一种马尔可夫链,逐渐将图像转换为纯噪声,最后通过逆过程生成新图像。

与GAN和VAE等生成模型不同,扩散模型依赖固定的过程来学习,隐变量空间的维度较高,这使得模型在生成复杂图像时表现出色。此外,扩散模型的训练过程相对不需要对抗性训练,避免了GAN中常见的调试难题。

生成对抗网络(GAN)通过生成器和判别器的对抗过程实现数据生成。虽然GAN在生成逼真图像方面表现优异,但对抗过程使得训练不稳定。扩散模型则通过固定的噪声添加和去噪过程,提供了一种更为稳定的生成方法。

变分自编码器(VAE)通过生成隐变量z来实现数据生成。与VAE相比,扩散模型通过马尔可夫链和高斯噪声,提供了更高维度的隐空间,这使得其在复杂数据的生成上具有优势。

Flow-based Models通过可逆的变换实现数据生成,与扩散模型的固定过程不同。扩散模型通过连续添加噪声,再逆向去噪,提供了一种新颖的数据生成方式。

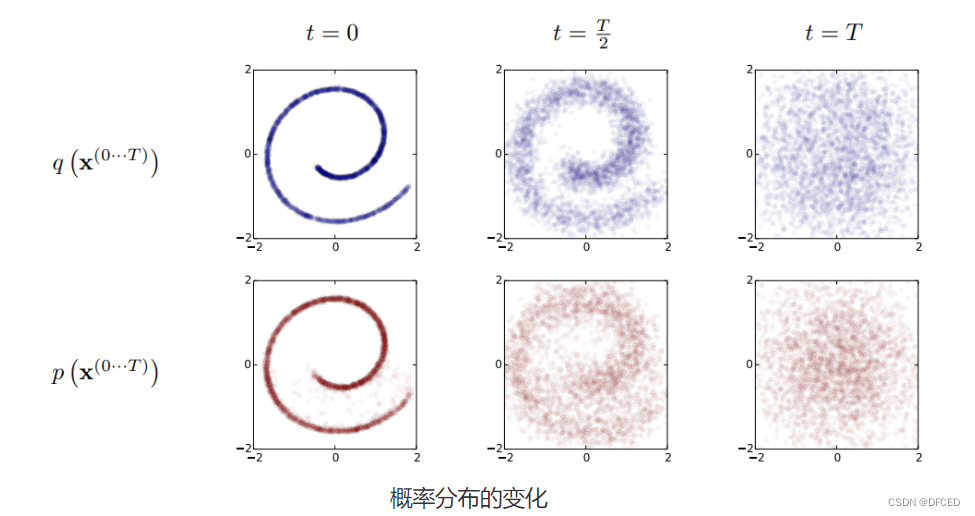

生成模型本质上是一组概率分布。扩散模型通过噪声扰动,将数据从有序的分布转变为无序的噪声分布,然后逆向恢复。这种过程可以直观地理解为从噪声中构建数据样本。

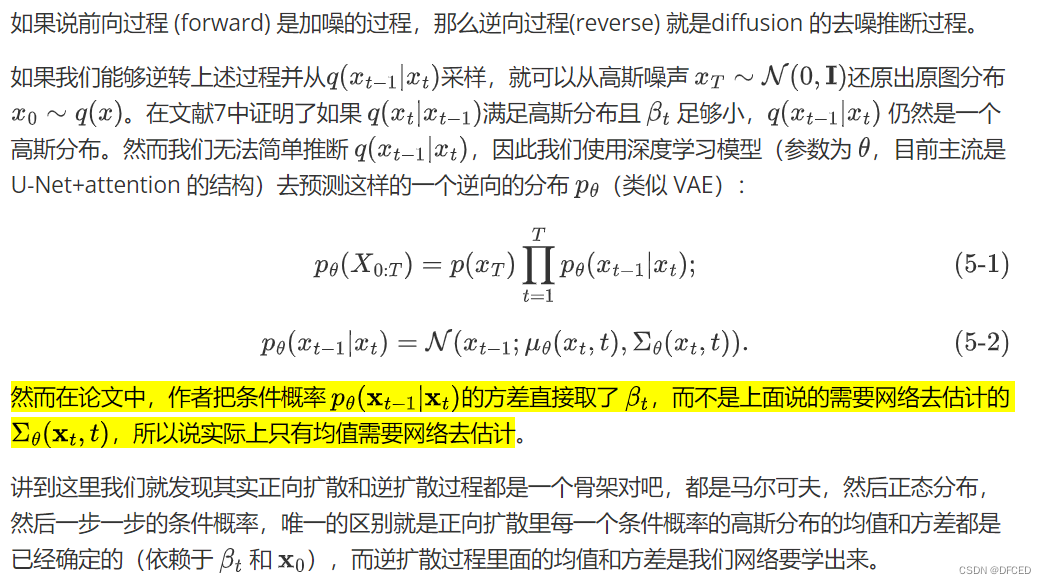

在扩散过程中,数据不断被噪声化,直到形成纯噪声。逆扩散过程则是从噪声逐步去噪,恢复至原始数据或生成新的数据。

通过扩散模型,我们可以从噪声分布中采样,生成高质量的图像。这一过程不仅适用于图像生成,还可扩展至其他领域,如文本和音频生成。

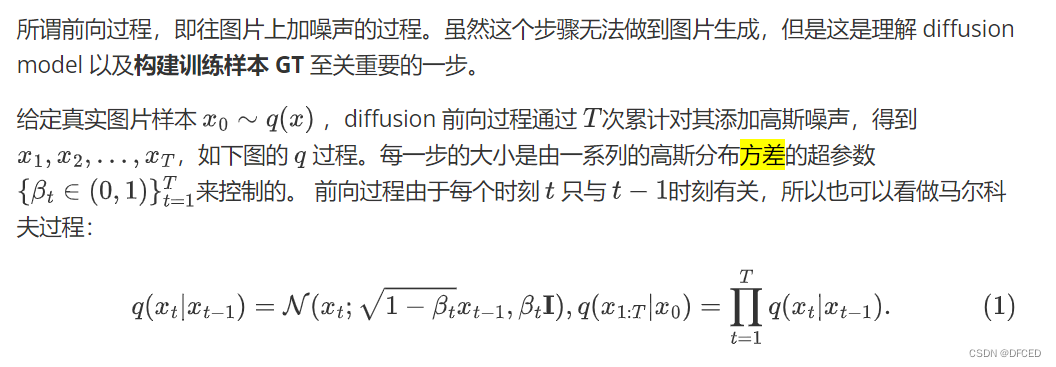

扩散模型采用马尔可夫链进行数据映射。在每个时间步中,噪声逐步添加到数据中,形成后验概率。这一过程在模型训练中尤为关键。

后验概率在贝叶斯统计中用于描述条件概率,而马尔可夫链强调无记忆性。这些概念构成了扩散模型的理论基础,指导模型在噪声和数据之间进行有效转换。

通过训练逆扩散过程,扩散模型能够从噪声中生成逼真的图像。与GAN不同,扩散模型不依赖对抗性训练,提供了一种更为稳定和可控的生成方式。

在正向扩散过程中,数据逐步被高斯噪声扰动。这一过程可以通过马尔可夫链的方式进行描述,每一步都将数据推向完全噪声化的状态。

正向过程的目标是将数据转换为标准的高斯噪声分布。通过这一过程,扩散模型能够有效地学习数据的内在结构,为逆向生成奠定基础。

import torch

import torch.nn as nn

class DiffusionModel(nn.Module):

def __init__(self):

super(DiffusionModel, self).__init__()

# 初始化模型参数

def forward(self, x):

# 实现正向扩散过程

return x逆扩散过程旨在从纯噪声中恢复数据。通过学习噪声的逆向转换,扩散模型能够生成与训练数据相似的新样本。

在逆扩散过程中,模型逐步去除噪声,恢复数据的细节。这一过程依赖于对正向过程的有效学习,确保生成结果的质量。

逆扩散过程的训练通常涉及大量的数据迭代和优化,确保模型能够准确地从噪声中恢复数据。

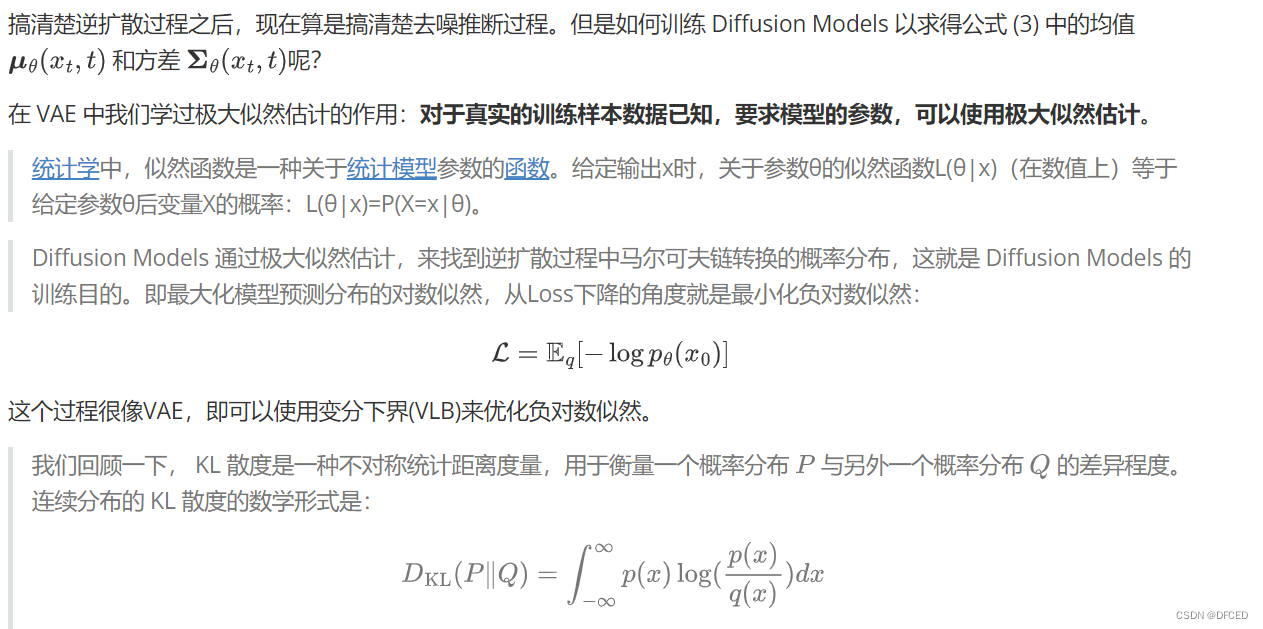

扩散模型的训练损失通常涉及到对去噪精度的评估。通过优化损失函数,模型能够更好地学习噪声和数据之间的映射关系。

在训练过程中,合理的损失函数设计可以显著提高模型的生成效果。通常采用的策略包括最小化噪声残差等。

常用的优化方法包括随机梯度下降等,通过有效的优化算法,模型能够快速收敛至理想状态。