DeepSeek Janus-Pro 应用代码与图片链接实践

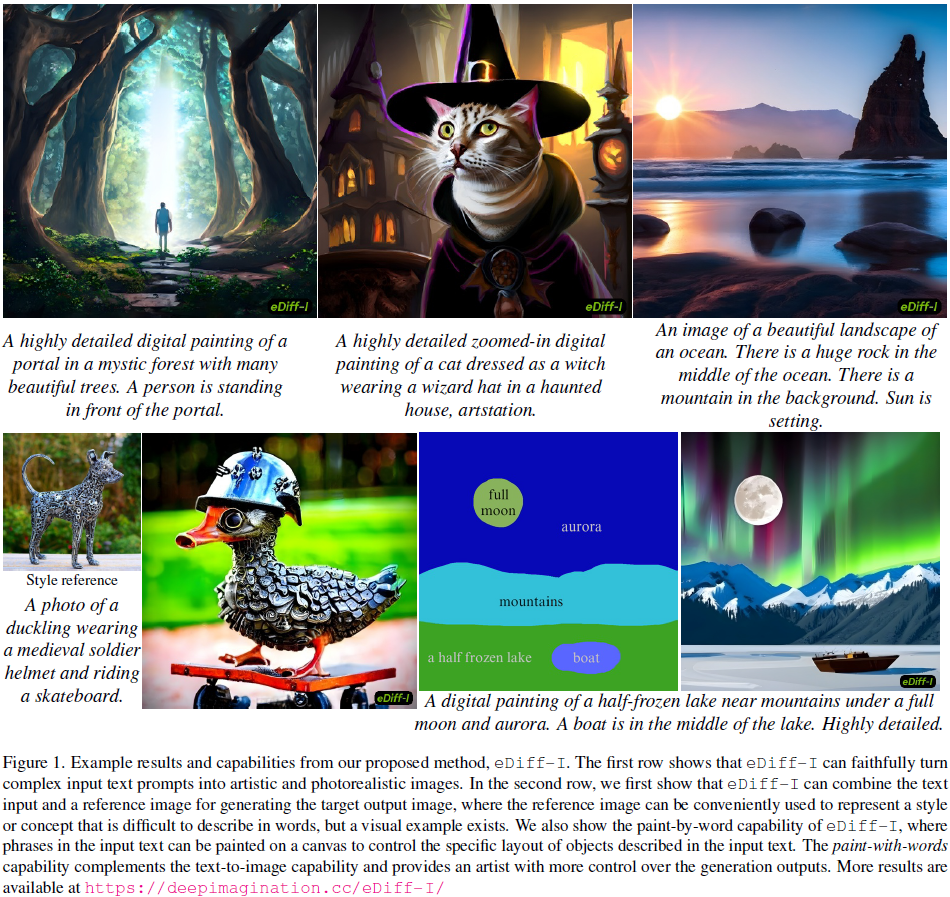

现代技术领域中,文本到图像的生成模型已经成为一种重要的创新工具。eDiff-I,作为一种先进的文本到图像扩散模型,通过组合多种专家去噪器和编码器,提供了卓越的图像生成能力。eDiff-I 的创新之处在于其对不同噪声水平的处理能力,使得生成的图像质量和文本对齐性得到了显著提升。

在 eDiff-I 中,专家去噪器是一种关键技术。通过在不同噪声水平下训练专门的去噪器,eDiff-I 能够更好地处理图像生成过程中的复杂动态变化。使用二叉树策略,模型首先在所有噪声水平上进行共享训练,然后逐步细化,训练出适用于特定噪声水平的专家去噪器。

这种训练方法不仅提高了模型的容量,还在不增加推理计算成本的情况下改进了生成质量。通过逐步微调,eDiff-I 能够在不同阶段优化生成过程中的文本对齐和视觉细节。

在 eDiff-I 中,T5 和 CLIP 文本编码器的结合使用,使得模型能够充分利用不同编码器的优势。T5 编码器提供了对文本更深层次的理解,而 CLIP 编码器则增强了图像生成的全局外观。

除了文本编码器,eDiff-I 还引入了 CLIP 图像嵌入,支持风格迁移功能。用户可以通过参考图像的风格影响生成图像的输出,进一步增强了图像的多样性和定制化能力。

“Paint-with-Words” 是 eDiff-I 的一项创新功能,允许用户通过简单的绘画操作控制生成图像的布局。这种方法无需复杂的训练,只需选择文本中的短语并在画布上指定位置,即可实现高质量的图像生成。

这种功能特别适合需要精确控制图像布局的应用场景。与传统的基于分割的图像生成方法相比,它更为简便,并且能够在短时间内生成包含多个概念的图像。

在一系列实验中,eDiff-I 显示出其强大的生成能力。在 MS-COCO 和 Visual Genome 数据集上的评估中,eDiff-I 在 FID 和 CLIP 分数上均优于现有的先进模型。

与 Stable Diffusion 和 DALL-E2 等模型相比,eDiff-I 在生成多实体图像和文本时显示出更高的准确性。其在长文本描述的处理上也表现出色,能够更好地捕捉复杂的长距离依赖关系。

eDiff-I 的架构设计中,Dhariwal 等人提出的 U-net 架构进行了多处修改。加入了池化的 CLIP 文本嵌入和图像嵌入,并在自注意力块后添加了交叉注意力块,支持更复杂的交互。

为了提升超分辨率生成能力,eDiff-I 使用了 Efficient U-net 的块结构。通过随机块训练,使得模型在 1024×1024 分辨率下的推理效率大大提高。

eDiff-I 在图像生成领域的突破,使得数字艺术创作更加自由。这种技术的普及有助于艺术表达的民主化,为设计师和创作者提供了强大的工具。

然而,eDiff-I 也可能被用于不当用途,如高级照片编辑或虚假信息的生成。因此,开发者和用户需对其潜在的社会影响保持警惕,并采取措施加以规避。

问:eDiff-I 如何实现高质量的图像生成?

问:如何使用 eDiff-I 的 Paint-with-Words 功能?

问:eDiff-I 的风格迁移功能如何工作?

问:eDiff-I 的社会影响有哪些?

问:eDiff-I 相较于其他模型的优势是什么?