PixVerse V3 API Key 获取:全面指南与实践

DreamBooth是由Google Research于2022年8月提出的一种针对文生图扩散模型的微调方法。这种方法的目的在于通过少量的训练数据实现模型的个性化调整,使其能够记住特定物体的特征并生成多样化的图像。由于该技术在保留原有模型能力的同时实现了个性化生成,DreamBooth迅速成为学术界和工业界关注的焦点,并成功入选CVPR 2023。

DreamBooth通过对现有的Text-to-Image扩散模型进行微调,使其能够在保持原有模型生成能力的同时,添加新的个性化特征。其核心在于使用少量样本来调整模型的权重和参数,从而在Prompt中加入特定标识符时生成特定的图像。

DreamBooth方法在生成相同物体的多样性和保真性上表现优异。通过少量的特定物体图像进行训练,模型能够精确再现物体的特征,同时生成出不同风格和背景的图像。

与Textual Inversion方法相比,DreamBooth能够更好地保持图像的细节和整体性。Textual Inversion更适用于风格迁移,而DreamBooth则在生成个性化特征图像方面具有明显优势。

DreamBooth的一个显著特点是其对小样本的高效利用。通过仅3-5张图像,模型即可实现个性化的微调。与传统方法相比,大大降低了数据和计算的需求。

在GAN训练中,模式坍塌是一个常见问题,即模型只能生成一种模式的数据。DreamBooth通过扩散模型的多样性特性,有效避免了这种情况,确保生成图像的多样性。

在DreamBooth中,提示词的设计至关重要。通过精确的提示词,模型可以更好地生成符合预期的图像。

DreamBooth建议使用稀有词作为标识符,以避免模型对常见词产生过拟合或词义漂移。这种方法确保了模型生成的图像与特定提示词高度相关。

语言漂移是指模型在微调过程中可能失去对自然语言的语法和语义理解。DreamBooth通过加入先验保持损失(Prior Preservation Loss)来解决这一问题,确保模型在生成新图像时不丢失原有的语言特性。

这种损失函数通过在模型训练时保持原有的类别特性来避免过拟合,确保模型在生成新图像时仍能保持多样性和保真度。

DreamBooth的实验数据集主要由少量图片组成,训练时长非常短。在Imagen模型上使用TPUv4进行训练仅需5分钟,而在Stable Diffusion上使用A100显卡的训练时间相近。

通过消融实验,研究人员验证了Prior Preservation Loss和正确使用类别标识词对生成图像质量的重要性。结果表明,加入PPL的模型在多样性和保真度上显著优于未加入PPL的模型。

通过Diffusers库提供的DreamBooth训练脚本,用户可以对自己的Stable Diffusion模型进行微调。尽管训练资源消耗较高,但通过调整学习率和训练步数,可以达到较好的效果。

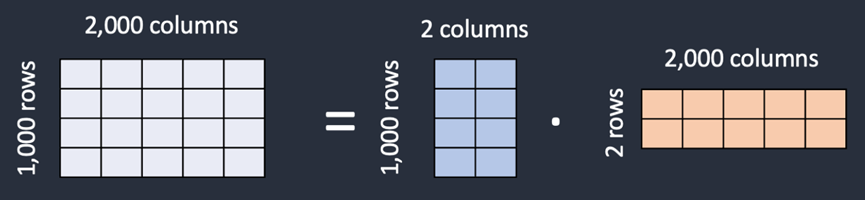

LoRA(Low-Rank Adaptation)是一种针对Stable Diffusion模型的训练技术,能够以较小的文件大小实现模型微调。与DreamBooth相比,LoRA在资源消耗上更具优势,同时保持了一定的生成质量。

DreamBooth为图像生成模型的个性化微调提供了一种高效的方法。随着技术的不断进步,未来或将看到更多关于DreamBooth在实际应用中的创新与发展。

问:DreamBooth需要多少图片进行训练?

问:如何选择DreamBooth的提示词?

问:DreamBooth与Textual Inversion有何不同?

问:什么是Prior Preservation Loss?

问:LoRA模型的优势是什么?