深入理解交叉熵:信息论与机器学习中的应用

交叉熵(Cross Entropy)在机器学习和信息论中扮演着重要角色,尤其是在评估预测模型性能时常被用作损失函数。理解交叉熵的概念对于从事机器学习工作的人士非常重要,它不仅帮助我们量化不确定性,还为模型优化提供了一个准确的指标。

信息论基础

在了解交叉熵之前,我们需要了解信息论的几个基本概念:信息量、熵和相对熵(KL散度)。这些概念为我们提供了理解信息和不确定性度量的工具。

信息量

信息量是对事件发生不确定性的度量。假设我们有两个事件:

- 事件A:某队进入世界杯决赛圈,发生概率较高。

- 事件B:另一队进入世界杯决赛圈,发生概率较低。

显然,事件B的信息量更大,因为它不太可能发生。信息量通常用对数表示,公式为:

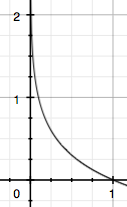

$$ I(x) = -log(p(x)) $$

熵

熵是对信息量的期望值的度量,表示一个系统的平均不确定性。对于一个离散型随机变量,其熵定义为:

$$ H(X) = -sum_{i=1}^{n} p(x_i) log(p(x_i)) $$

熵越大,系统的不确定性越高。

相对熵(KL散度)

相对熵度量两个概率分布之间的差异,常用于比较模型预测与真实数据之间的距离。公式为:

$$ D{KL}(P||Q) = sum{i=1}^{n} p(x_i) logleft(frac{p(x_i)}{q(x_i)}right) $$

交叉熵的定义与计算

交叉熵结合了熵和KL散度的思想,用于量化一个分布Q相对于分布P的平均描述长度。其公式为:

$$ H(p, q) = -sum_{i=1}^{n} p(x_i) log(q(x_i)) $$

在机器学习中,交叉熵被广泛用于分类问题的损失函数。它通过比较真实标签与预测标签之间的差异来评估模型性能。

机器学习中的交叉熵应用

单分类问题中的交叉熵

在单分类问题中,每个样本只对应一个类别,交叉熵作为损失函数的公式为:

$$ loss = -sum_{i=1}^{n} y_i log(hat{y}_i) $$

举例说明,假设有如下样本:

- 标签:青蛙

- 预测:猫(0.3),青蛙(0.6),老鼠(0.1)

其交叉熵损失为:

$$ loss = -log(0.6) $$

多分类问题中的交叉熵

多分类问题允许每个样本属于多个类别。此时,交叉熵的计算需要使用sigmoid函数处理每个类别的概率。

$$ loss = -ylog(hat{y}) – (1-y)log(1-hat{y}) $$

对于每个类别独立计算损失,并在批次内求平均。

交叉熵的优化与应用场景

在模型优化过程中,交叉熵是一个关键指标。它可以帮助我们找到模型参数的最优解,使得模型预测与真实标签之间的差距最小。

优化中的交叉熵

在深度学习中,交叉熵通常与反向传播算法结合使用,通过梯度下降来优化模型参数。这种方法可以有效减少预测误差,提高模型准确性。

实际应用场景

交叉熵广泛应用于图像分类、语音识别和自然语言处理等领域。在这些应用中,它帮助模型更好地拟合数据,提高预测精度。

结论

交叉熵是理解机器学习模型性能的关键工具。通过精确度量预测与真实数据之间的差异,交叉熵指导我们优化模型,提升其在实际应用中的表现。

FAQ

-

问:交叉熵与KL散度有何区别?

- 答:交叉熵度量一个分布相对于另一个分布的平均描述长度,而KL散度度量两个分布之间的差异。

-

问:为什么交叉熵适合用于分类问题?

- 答:交叉熵能够精确度量模型预测与真实标签之间的差异,有助于优化模型参数。

-

问:如何在实践中应用交叉熵?

- 答:在深度学习中,交叉熵通常作为损失函数,与梯度下降结合使用,以优化模型性能。

最新文章

- 如何使用OAuth作用域为您的API添加细粒度权限

- LLM API:2025年的应用场景、工具与最佳实践 – Orq.ai

- API密钥——什么是API Key 密钥?

- 华为 UCM 推理技术加持:2025 工业设备秒级监控高并发 API 零门槛实战

- 使用JSON注入攻击API

- 思维链提示工程实战:如何通过API构建复杂推理的AI提示词系统

- 短信验证码API在Java、Python、PHP中的使用指南

- 免费使用头条热榜API进行数据分析的教程

- 获取 YouTube API Key 密钥的教程与示例

- Python人工智能学习路线(长篇干货)

- 当中医遇上AI:探索“寻艾中医AI开放平台”的创新之旅

- 增值税发票OCR识别API在Java、Python、PHP中的使用教程