Stable Diffusion Agent 开发:技术解析与应用前景

在图像生成领域,Stable Diffusion API 提供了一种高效的方式来实现文本到图像的转换。与其他图像生成方法相比,Stable Diffusion API 的优势在于其灵活性和强大的自定义能力。用户可以通过简单的API调用,设置多种参数,生成高质量的图像。这种方法不仅适用于开发者,也为艺术家和设计师提供了新的创作工具。

Stable Diffusion API 是基于深度学习技术的文本到图像生成工具。它利用扩散模型,通过逐步添加噪声和去噪声的过程生成图像。与传统的生成对抗网络(GANs)相比,扩散模型在生成细节和处理复杂场景时表现更佳。Stable Diffusion API 的开放性使得用户可以轻松地在不同的开发环境中集成和使用。

在早期的图像生成尝试中,Diffusers 是一个常用的库。然而,Diffusers 在处理复杂功能时可能显得有些繁琐,特别是在采样器的添加和safetensors格式模型的读取方面。相比之下,Stable Diffusion 提供的API接口则显得更加简洁和直接,极大地提高了开发效率。

为了使用Stable Diffusion API,我们首先需要部署WebUI。WebUI提供了一种图形化的方式来管理和调用API接口,无论是自己从源码配置还是使用一键启动包,过程都相对简单且高效。

对于初学者来说,使用一键启动包是最简单的选择。通过访问一键启动包教程,用户可以快速安装并运行WebUI。

如果希望对WebUI有更多的控制,可以选择手动配置。以下是启动WebUI的基本命令:

bash webui.sh --nowebui或者使用Python脚本启动:

python launch.py --xformers --api一旦WebUI成功启动,用户可以通过API接口进行文生图的生成。以下是一个简单的Python示例,展示了如何调用API生成图像。

通过以下代码,我们可以实现从文本到图像的转换:

import json

import requests

import io

import base64

from PIL import Image

url = "http://127.0.0.1:7860"

prompt = "dog"

negative_prompt = ""

payload = {

"override_settings":{

"sd_model_checkpoint": "v1-5-pruned.ckpt",

"sd_vae": "animevae.pt",

"CLIP_stop_at_last_layers": 2,

},

"prompt": prompt,

"negative_prompt": negative_prompt,

"steps": 30,

"sampler_name": "Euler a",

"width": 512,

"height": 512,

"batch_size": 1,

"n_iter": 1,

"seed": 1,

"CLIP_stop_at_last_layers": 2,

"restore_faces": False,

}

response = requests.post(url=f'{url}/sdapi/v1/txt2img', json=payload)

r = response.json()

image = Image.open(io.BytesIO(base64.b64decode(r['images'][0])))

image.show()

image.save('output.png')除了文生图,Stable Diffusion API 还支持图生图功能,以下是相关示例代码:

import json

import requests

import io

import base64

from PIL import Image

import cv2

url = "http://127.0.0.1:7860"

prompt = "cat"

negative_prompt = ""

img = cv2.imread('image.jpg')

retval, bytes = cv2.imencode('.png', img)

encoded_image = base64.b64encode(bytes).decode('utf-8')

payload = {

"prompt": prompt,

"negative_prompt": negative_prompt,

"steps": 30,

"sampler_name": "Euler a",

"width": 512,

"height": 512,

"batch_size": 1,

"n_iter": 1,

"seed": 1,

"cfg_scale": 7,

"CLIP_stop_at_last_layers": 2,

"init_images": [encoded_image],

"restore_faces": False,

}

response = requests.post(url=f'{url}/sdapi/v1/img2img', json=payload)

r = response.json()

image = Image.open(io.BytesIO(base64.b64decode(r['images'][0])))

image.show()

image.save('output.png')在使用Stable Diffusion API时,可以通过带参数的方式启动WebUI,以便于调用不同的API接口。以下是相关操作步骤:

在WebUI启动脚本中添加API启动参数:

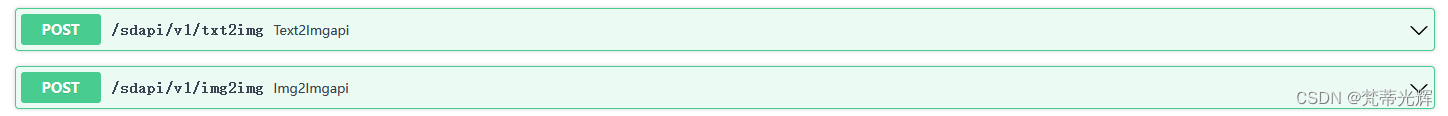

set COMMANDLINE_ARGS=--api完成设置后,运行webui-user.bat,然后访问http://127.0.0.1:7860/docs/以查看API列表。

除了直接调用官方API,用户还可以使用第三方库如sdwebuiapi来简化调用过程。这些库对API进行了封装,使得调用变得更为简单。

可以通过以下命令安装sdwebuiapi:

pip install sdwebuiapi以下代码展示了如何使用sdwebuiapi进行图像生成:

import webuiapi

def draw_expression(charactor_expression):

api = webuiapi.WebUIApi(host='127.0.0.1', port=7860, sampler='Euler a', steps=20)

prompt = "(masterpiece, best quality:1), 1girl, solo, arisu, halo,"

for e in charactor_expression:

prompt += e + ','

prompt += "white background , "

result1 = api.txt2img(prompt=prompt,

negative_prompt="noisy, blurry, grainy,text, graphite, abstract, glitch, deformed, mutated, ugly, disfigured, (realistic, lip, nose, tooth, rouge, lipstick, eyeshadow:1.0), low contrast",

seed=-1,

styles=["animate"],

cfg_scale=8)

save_file_name = './outputs/output'

for i in charactor_expression:

save_file_name += '_' + i.replace(" ", "_")

save_file_name += '.png'

result1.image.save(save_file_name)

return save_file_name

test_expression = ['Greet happily', 'Rub your hands']

img_file_Location = draw_expression(charactor_expression=test_expression)

print('output image saved to ' + img_file_Location)问:如何安装Stable Diffusion WebUI?

问:Stable Diffusion API 支持哪些功能?

问:如何提高生成图像的质量?

问:如何使用第三方库调用Stable Diffusion API?

sdwebuiapi等第三方库来简化API调用过程,这些库提供了封装好的接口,便于使用。问:API调用时遇到错误如何解决?

通过以上指导,用户可以更好地利用Stable Diffusion API进行图像生成,满足多样化的创作需求。