AI视频剪辑工具:解锁创作的无限可能

卷积神经网络(Convolutional Neural Networks,简称CNN)在图像识别和分类领域已经证明非常有效。CNN的起源可以追溯到1990年代,由Yann LeCun提出的LeNet网络,最初用于字符识别,如邮政编码和手写数字。随着深度学习的发展,CNN逐渐成为图像识别的主流技术。CNN的基本思想来源于生物学,实现靠数学,发展靠数据和算力,这的确是一件有趣的事情。

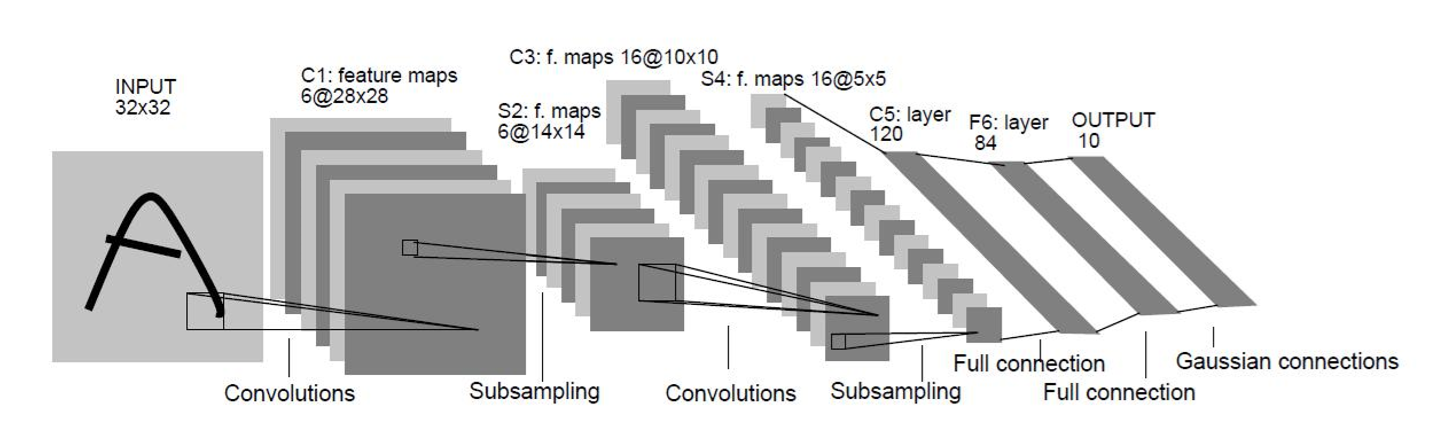

在图像识别任务中,我们必须认识过同类的物体才能准确地识别它,这与有监督学习的过程相似。Hubel和Wiesel在1962年进行的实验证明了大脑中的神经细胞对特定方向的边缘有反应,这为CNN的发展奠定了基础。后来,日本的科学家提出了神经认知模型,其中包括“S细胞”和“C细胞”,分别用于抽取局部特征和抽象容错。Yann LeCun在80年代末提出了卷积网络技术,并构建了LeNet-5,大幅度提高了手写识别能力,为后来的CNN发展奠定了基础。

随着新的模型不断被提出,网络层数逐渐加深,图像识别的准确率也不断提升,甚至超过了人类。CNN体系仍在不断完善与发展,其在图像识别、人脸识别、物体和交通标志识别等领域的应用越来越广泛。

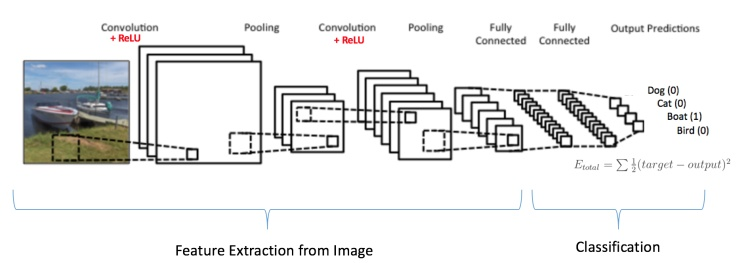

CNN的基本结构包括卷积层、激活层、池化层和全连接层。以LeNet-5为例,输入由多种通道构成的图像数据,经过多重卷积、池化和激活后,特征被提取出来,再通过全连接层输出。

卷积层通过滤波器提取图像的局部特征。每个滤波器对应一个特征图,多个滤波器生成多个特征图,这些特征图在深度方向堆叠形成输出。

感受野可以理解为神经元看到的视野。在CNN中,每个神经元只感受局部图像区域、提取局部特征,然后在更高的层次上汇总起来,形成对整个图像的认识。卷积则是通过点积形式的数学运算提取局部特征。

步幅(stride)是卷积窗滑动的单位,填充(padding)则是在图像边界加上一圈0,以扩展图像边界。填充的量可以通过公式计算得出,以确保输入输出尺寸相等。

激活层通常使用ReLU函数,引入非线性特征,增强模型的表达能力。同时,ReLU函数可以避免梯度消失的问题,加快收敛速度。

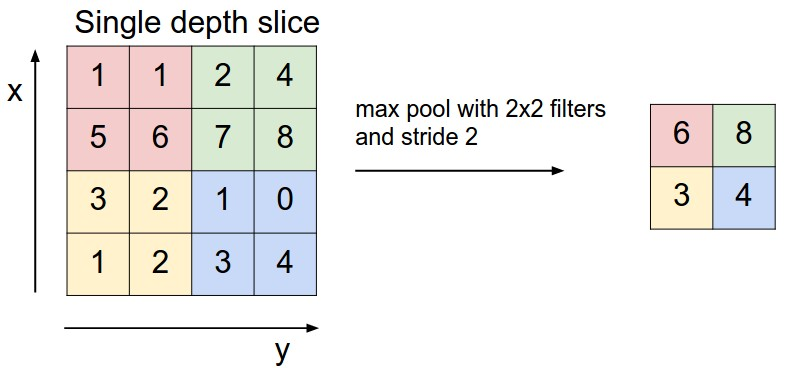

池化层通过抽象特征的过程来保留特征的同时减少参数。最大池化(max-pooling)是常用的池化方法,它取每个小区域中的最大值作为代表。

光栅化是将特征图中的像素依次取出,排列成一个向量,为全连接层的输入做准备。

全连接层将局部特征整合起来,进行分类。例如,找到了老鼠的屁股、眼睛和胡须等特征后,全连接层将这些特征综合起来,判断出这是一个老鼠。

CNN的训练过程包括不断卷积提取特征、前向传播暂定网络参数,反向传播更新参数,以达到在训练集上loss最小,在测试集上模型的准确率更高。

为了更好更快地训练出好的模型,我们使用了一些技巧,如批量正则化(batch normalization)、随机失活(dropout)和图像增广(image augmentation)。

本文详细介绍了CNN在图像领域的基本应用原理,希望能够帮助大家更好地理解和应用CNN。

问:CNN为什么在图像识别中效果这么好?

答:CNN通过模拟人脑处理图像的方式,逐层提取图像特征,每一层都对图像有更深入的理解,从而在图像识别中取得很好的效果。

问:卷积层和全连接层有什么区别?

答:卷积层主要负责提取局部特征,而全连接层则负责将这些局部特征整合起来,进行最终的分类判断。

问:ReLU激活函数有什么优点?

答:ReLU激活函数可以引入非线性特征,增强模型的表达能力,同时避免梯度消失的问题,加快收敛速度。

问:池化层的作用是什么?

答:池化层的作用是在保留特征的同时减少参数量,降低过拟合的风险,同时实现图像的不变性。

问:如何选择合适的CNN架构?

答:选择CNN架构时,需要考虑任务的复杂性、数据集的大小和计算资源等因素。可以参考已有的经典架构,如LeNet、AlexNet等,根据实际情况进行调整。