Optuna使用详解与案例分析

本篇文章主要帮助用户快速掌握如何在Chrome Canary浏览器中启用并使用内置的Gemini大模型。通过一系列简单易懂的步骤,您将学会如何配置浏览器设置、检查模型下载状态以及进行AI功能测试。这一过程将展示Gemini模型在提升用户体验和解决实际问题方面的强大潜力。

Gemini AI Nano 是一种由谷歌在其 Canary 版本的 Chrome 浏览器中引入的本地大模型。此模型的目的是利用用户设备上的计算资源来执行人工智能任务,而无需依赖云计算服务。这种方法不仅可以提高数据隐私性,还能减少延迟。

要使用 Gemini AI Nano,用户需要在 Canary 浏览器中启用特定的设置。首先,用户需要访问 Chrome Canary 下载页面,并确保安装版本高于 127.0.6512.0。

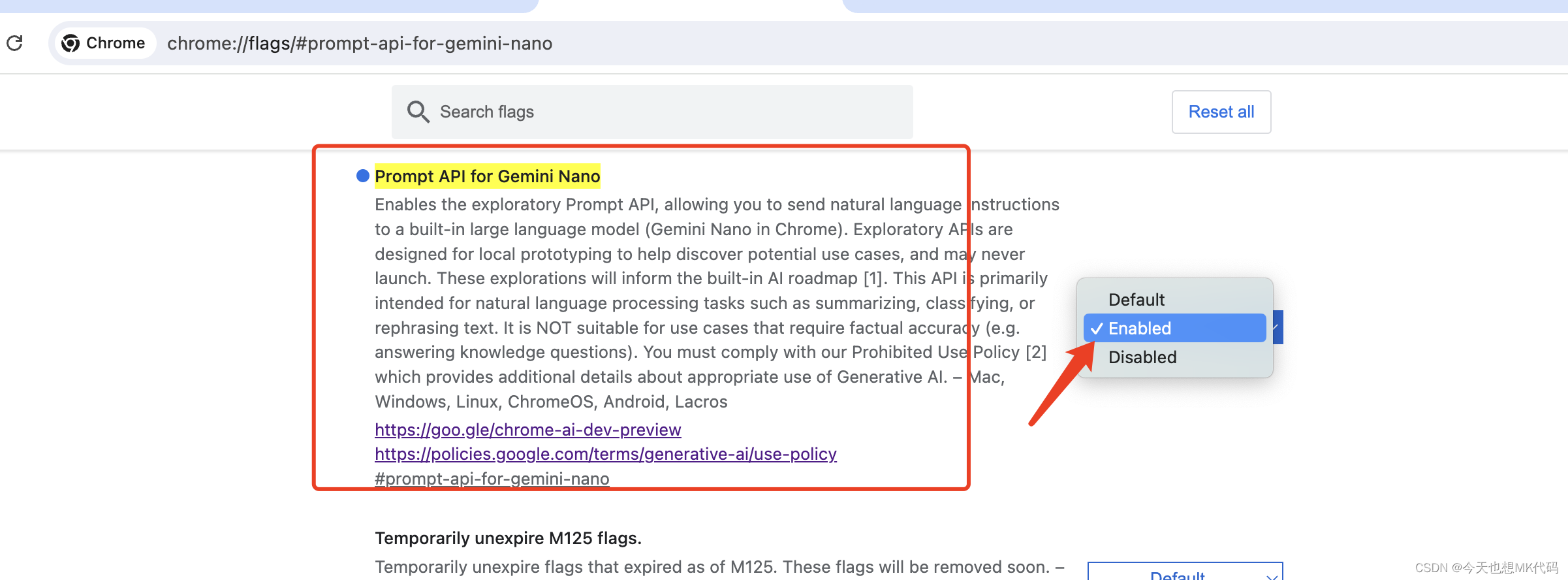

用户可以通过访问 chrome://flags 进行设置,将 ‘Prompt API for Gemini Nano’ 和 ‘Enables optimization guide on device’ 设置为 ‘Enable’。完成这些设置后,需要重启浏览器以生效。

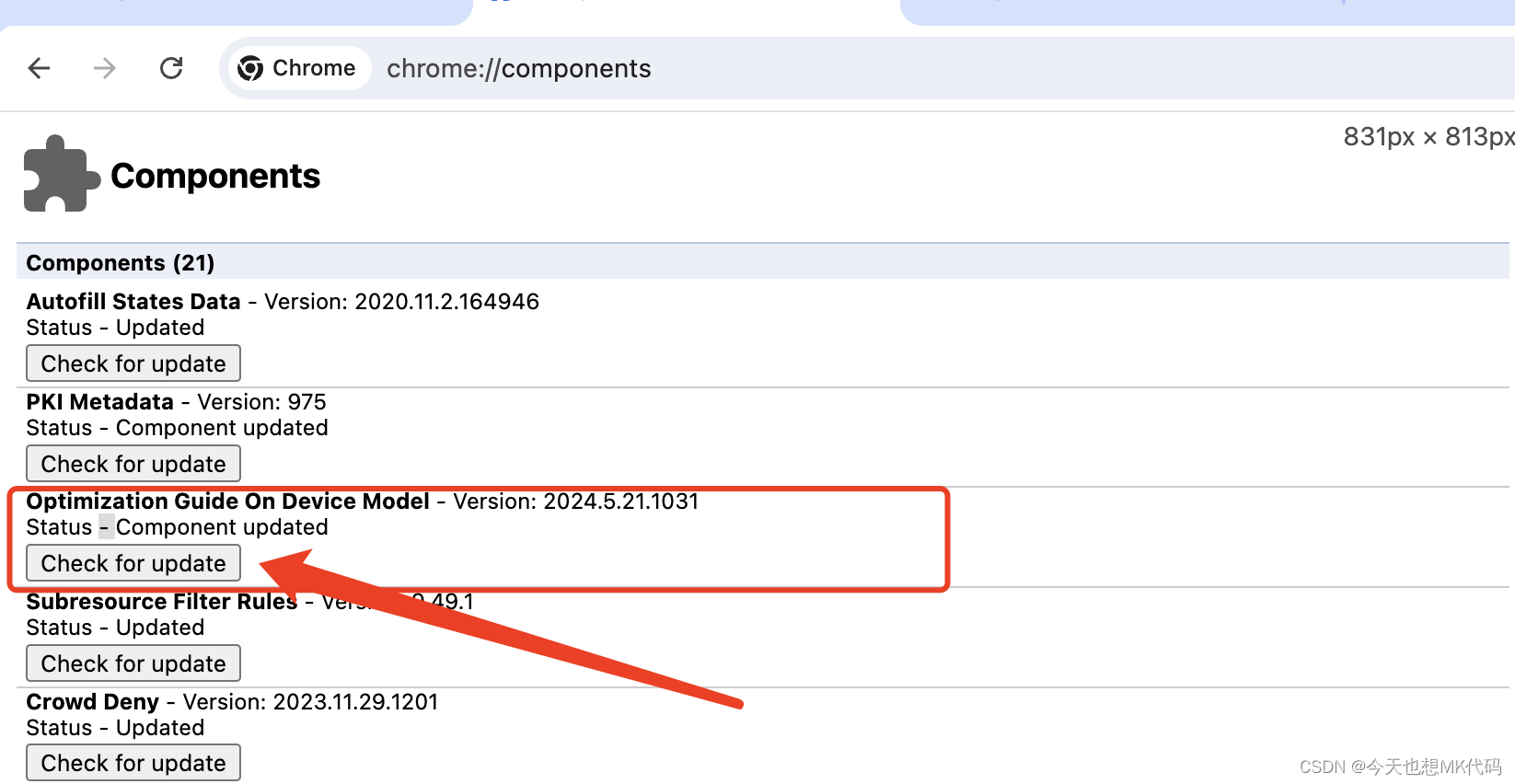

之后,用户可以在 chrome://components 检查是否出现 ‘Optimization Guide On Device Model’ 选项,并确认模型是否成功下载。模型文件通常存放在本地目录下,文件大小约为 1.78GB。

为了测试 Gemini AI Nano 的功能,用户可以在浏览器的控制台中输入以下代码:

const canCreate = await window.ai.canCreateGenericSession();

if (canCreate !== "no") {

const session = await window.ai.createTextSession();

const stream = session.promptStreaming("写一个短篇科幻小说!");

for await (const chunk of stream) {

console.log(chunk);

}

session.destroy();

} else {

console.error("Gemini Nano not ready yet.", canCreate);

}该代码用于创建文本会话,并通过 AI 模型生成指定内容。若模型尚未准备好,会返回错误信息。

通过这些步骤,用户可以在本地设备上体验 Gemini AI Nano 带来的强大 AI 功能,享受更私密和低延迟的人工智能服务。

Gemini AI Nano 是谷歌在 Canary 版本的 Chrome 浏览器中引入的一个重要功能,其主要特点包括以下几个方面:

本地大模型的计算能力:Gemini AI Nano 允许用户在本地设备上运行大型 AI 模型。这种方法有效地提高了数据的隐私性,因为所有计算都在用户的设备上进行,无需依赖云计算服务。这不仅保护了用户的数据隐私,还减少了因网络延迟带来的不便。

低延迟和高效能:由于所有的处理都是在本地设备上进行的,用户可以体验到更低的延迟和更高效的运算速度。这对于需要实时反馈的应用程序,如语音识别或实时翻译,尤为重要。

易于访问和使用:用户可以通过简单地下载 Canary 浏览器并启用相关设置来使用 Gemini AI Nano。这包括访问 Chrome Canary 下载页面,并在 chrome://flags 中启用 ‘Prompt API for Gemini Nano’ 和 ‘Enables optimization guide on device’。

模型管理和更新:用户可以在 chrome://components 页面检查和管理模型的下载和更新。模型文件通常存放在本地目录中,文件大小约为 1.78GB。

本地应用测试:用户可以通过下载 LocalhostAI 代码并在本地运行来测试 Gemini AI Nano 的功能。

通过这些特点,Gemini AI Nano 为用户提供了一种强大而灵活的方式来利用人工智能技术,同时确保了用户数据的安全性和私密性。

使用网页版的 Gemini 可能会面临一些挑战和限制。首先,网页版通常依赖于云计算,这意味着处理需要通过网络传输数据,这可能导致隐私问题,因为用户的数据需要上传到服务器进行处理。此外,依赖云计算还可能导致延迟增加,尤其是在网络连接不稳定或速度较慢的情况下。

其次,网页版的功能可能会受到浏览器支持的限制。某些功能可能需要特定版本的浏览器或插件支持,而这些要求不一定能在所有设备上得到满足。

最后,网页版的性能可能不如本地化版本。由于需要通过网络进行数据交换,网页版的响应速度和处理能力可能不如在本地设备上直接运行的 Gemini AI Nano。

通过选择使用 Chrome Canary 浏览器中的本地化版本,用户可以避免这些问题。通过在本地设备上运行 Gemini AI Nano,用户可以享受更快的处理速度,更高的隐私性,并且不依赖于网络连接的稳定性。这种方法不仅提供了更高效的 AI 体验,还确保了用户数据的安全性。

安装和使用Gemini AI Nano可以通过以下几个步骤来完成:

下载Chrome Canary或Dev版本:首先,确保您的操作系统语言设置为英语(美国),并将Chrome浏览器的语言更改为英语(美国)。接着,访问Chrome Canary下载页面,确保安装的版本高于127.0.6512.0。

启用相关设置:打开Chrome浏览器,输入 chrome://flags 进行设置。将 Prompt API for Gemini Nano 和 Enables optimization guide on device 设置为 Enable。重启浏览器使设置生效。

检查模型下载:访问 chrome://components ,查看是否出现 Optimization Guide On Device Model 选项。点击 Check for update 确认模型是否成功下载。模型文件通常存放在 ~/Library/Application Support/Google/Chrome Canary/OptGuideOnDeviceModel/ 目录下,文件大小约为1.78GB。

const canCreate = await window.ai.canCreateTextSession();

if (canCreate !== "no") {

const session = await window.ai.createTextSession();

const result = await session.prompt("为我写一首诗");

console.log(result);

} else {

console.error("Gemini Nano not ready yet.", canCreate);

}此代码用于创建文本会话并生成内容。如果返回状态为“readily”,则模型在设备上可用;如果为“after-download”,则会启动下载过程;“no”表示模型不适用于设备。

通过这些步骤,您可以在本地设备上体验Gemini AI Nano的强大功能,享受更私密和低延迟的人工智能服务。

体验Chrome内置的Gemini AI Nano需要通过几步简单的设置。首先,确保您下载并安装了Chrome Canary或Dev版本的浏览器,可以从这里下载。请确保您的Chrome版本高于127.0.6512.0。

接下来,您需要启用相关的实验性功能。打开Chrome浏览器并在地址栏中输入chrome://flags。然后,找到并启用以下两个设置:Prompt API for Gemini Nano和Enables optimization guide on device。之后,重启浏览器以应用更改。

接下来,访问chrome://components页面,检查是否出现Optimization Guide On Device Model选项。若出现此选项,请点击Check for update以确认模型是否成功下载。该模型文件位于本地目录,如~/Library/Application Support/Google/Chrome Canary/OptGuideOnDeviceModel/,并且文件大小约为1.78GB。

要测试Gemini AI Nano的功能,请打开浏览器的控制台(使用F12快捷键),并输入以下代码片段:

const canCreate = await window.ai.canCreateTextSession();

if (canCreate !== "no") {

const session = await window.ai.createTextSession();

const result = await session.prompt("为我写一首诗");

console.log(result);

} else {

console.error("Gemini Nano not ready yet.", canCreate);

}这段代码用于创建一个文本会话,并让Gemini AI Nano生成内容。如果模型已经在设备上可用,您将看到生成的文本输出。如果模型尚未准备好,您会收到错误信息提示。

通过这些步骤,您将能够在本地设备上体验Gemini AI Nano的强大功能,享受更私密和低延迟的人工智能服务。