文心一言写代码:代码生成力的探索

在本篇文章中,我们将详细探讨如何搭建和应用Kimi本地知识库。作为现代信息管理的一部分,本地知识库在保护数据隐私的同时,提供便捷的文档检索和管理功能,将极大提升工作效率。我们将介绍如何利用大语言模型,如GPT、Llama3等,在本地实现这一功能。

选择Kimi本地知识库的一个重要原因是其对数据隐私的保护。所有数据都存储在本地,避免了云端存储带来的潜在隐患。这意味着,无论是公司机密文件还是个人敏感信息,都不会因第三方服务而泄露。此外,Kimi支持多种大语言模型,使得知识库的能力得以大幅提升。

通过本地部署,Kimi本地知识库能够快速响应用户的搜索请求,并支持复杂的自然语言查询,使得用户可以更高效地获取所需信息,而不必担心隐私泄露。

为了在本地搭建Kimi知识库,首先需要使用Docker进行部署。Docker的优势在于其容器化技术,可以轻松实现软件的快速部署和管理。

在开始之前,请确保您的计算机上已经安装了Docker。如果尚未安装,可以通过访问Docker官方网站下载并安装Docker Desktop。安装过程中,确保启用了 "Use WSL 2 instead of Hyper-V (recommended)" 选项。

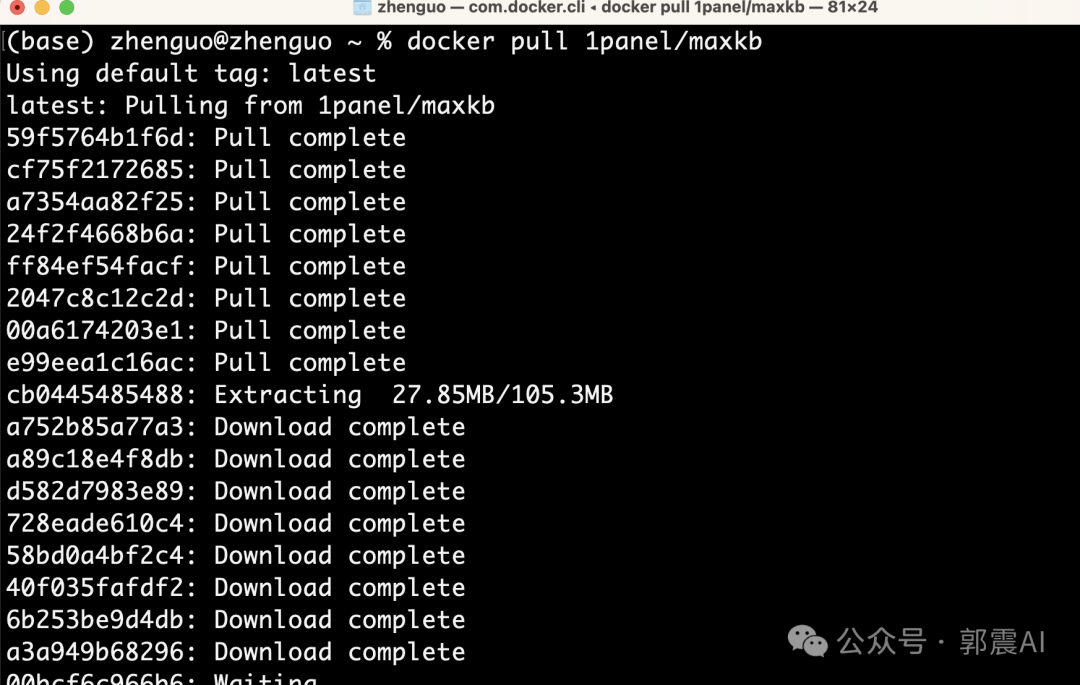

安装好Docker后,打开终端并输入以下命令以下载Kimi的Docker镜像:

docker pull kimi/maxkb下载完成后,您将拥有一个Kimi知识库的Docker镜像,接下来需要为其创建一个容器。

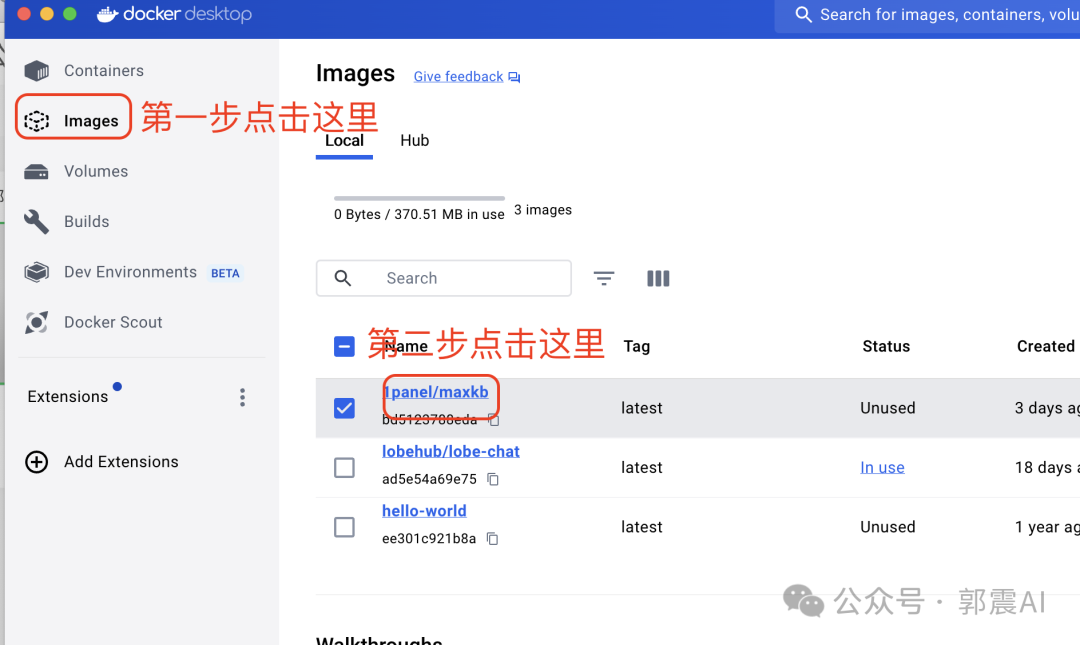

在成功下载镜像后,您需要通过Docker的图形界面来创建一个运行的容器。

容器成功运行后,您可以通过浏览器访问Kimi知识库的界面。打开浏览器,输入以下地址:

http://127.0.0.1:8080初次登录需要账号和密码,您可以通过关注相关公众号获取。

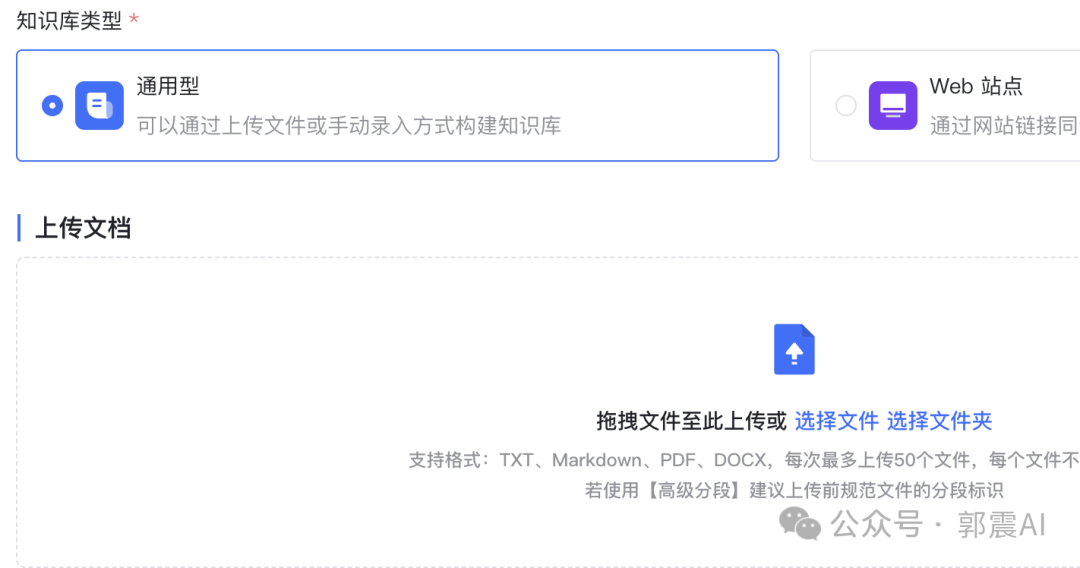

在成功登录Kimi后,您可以开始创建和管理您的知识库。Kimi支持多种数据格式和文档类型,包括txt、word、pdf、ppt等。

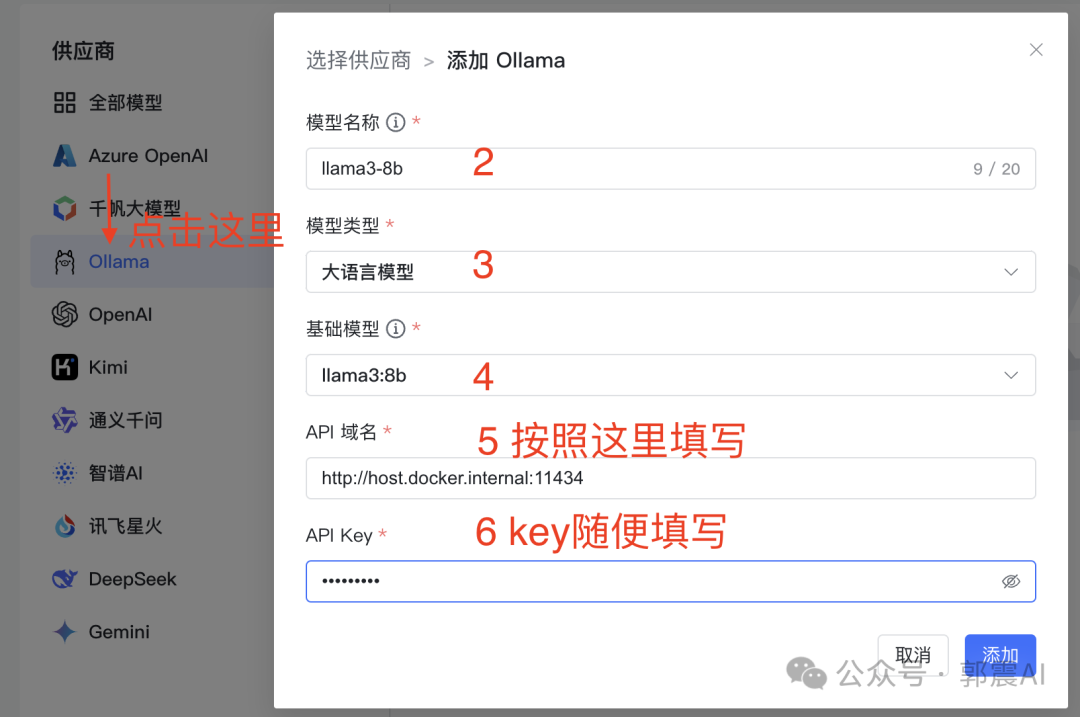

Kimi知识库支持多种大语言模型,如GPT、Llama3等。通过在本地配置这些模型,可以显著提升知识库的智能化水平。

ollama run llama3

接下来,我们将创建一个应用,以便将大语言模型与知识库结合使用。

使用Kimi本地知识库的优势在于数据的安全性和处理的效率。所有的操作都在本地完成,确保数据不会泄露。同时,得益于大语言模型的支持,Kimi可以实现高效的自然语言处理和智能问答功能。

Kimi本地知识库为用户提供了一个安全、高效的文档管理和智能问答平台。通过本地部署和大语言模型的集成,用户可以在保护数据隐私的同时,享受到现代化的知识管理和搜索体验。

Kimi本地知识库是一种在本地运行的知识管理系统,利用大语言模型进行文档搜索和问答,确保数据的隐私和安全。

您需要访问Docker官方网站下载Docker Desktop并进行安装,安装时需启用WSL 2选项。

Kimi支持多种大语言模型,如GPT、Llama3等,这些模型可以在本地配置使用。

所有数据都存储在本地,并且不需要通过云端传输,因此可以确保数据的隐私性。

您可以通过关注相关公众号并回复指定关键词获取登录信息。