大模型RAG技术:从入门到实践

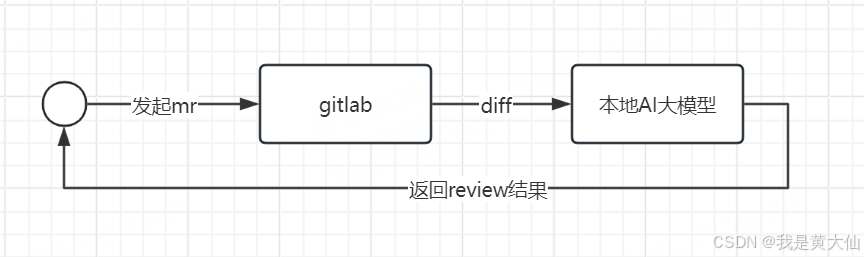

在现代软件开发中,代码审查(Code Review)不仅是提高代码质量的重要环节,也是团队协作和知识分享的关键过程。然而,传统的人工代码审查存在诸多挑战,如耗时长、主观性强、易于遗漏错误等。本文将介绍如何通过搭建AI Code Review系统,利用AI技术实现智能化的代码审查,从而提高代码质量和开发效率。

代码审查是软件开发生命周期中不可或缺的一部分,主要用于检测代码中的错误、改善代码质量和增强团队的知识共享。然而,传统的代码审查往往面临以下挑战:

通过引入AI技术,我们可以有效解决这些问题。AI可以自动化审查过程,提供一致性反馈,并快速识别潜在问题。

AI Code Review通过大模型的能力,提供了传统审查无法比拟的优势:

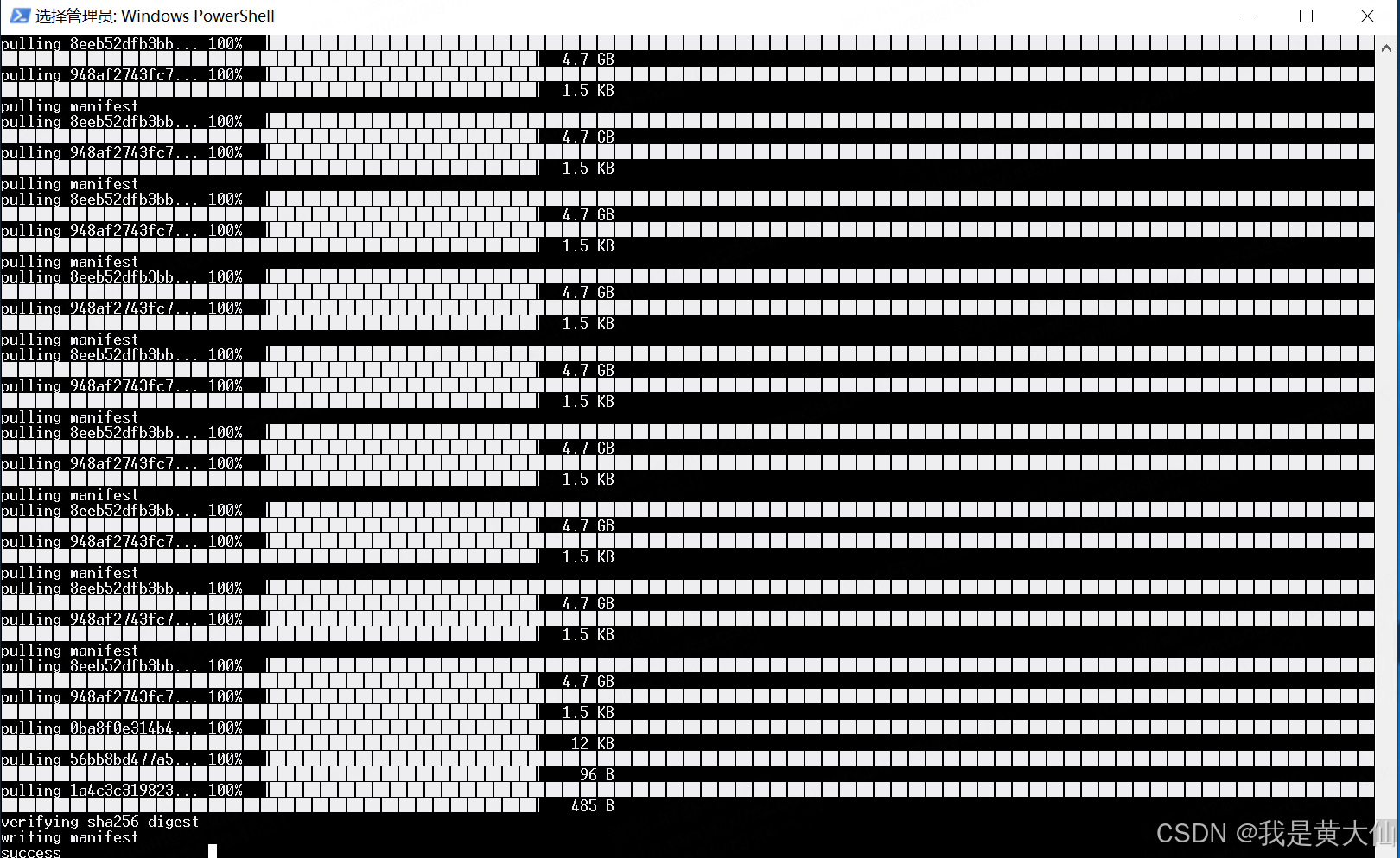

在安全性和数据隐私的考量下,许多团队选择在本地部署AI服务进行代码审查。以下是本地部署AI模型的一些步骤:

选择合适的AI模型是搭建AI Code Review的第一步。我们使用的是Llama 3.1:8b模型,因其资源占用少且易于部署。

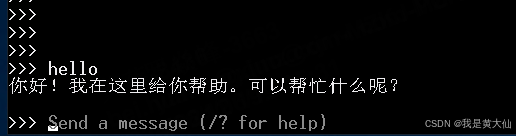

ollama run llama3.1:8b成功下载并启动后,模型即可用于互动。

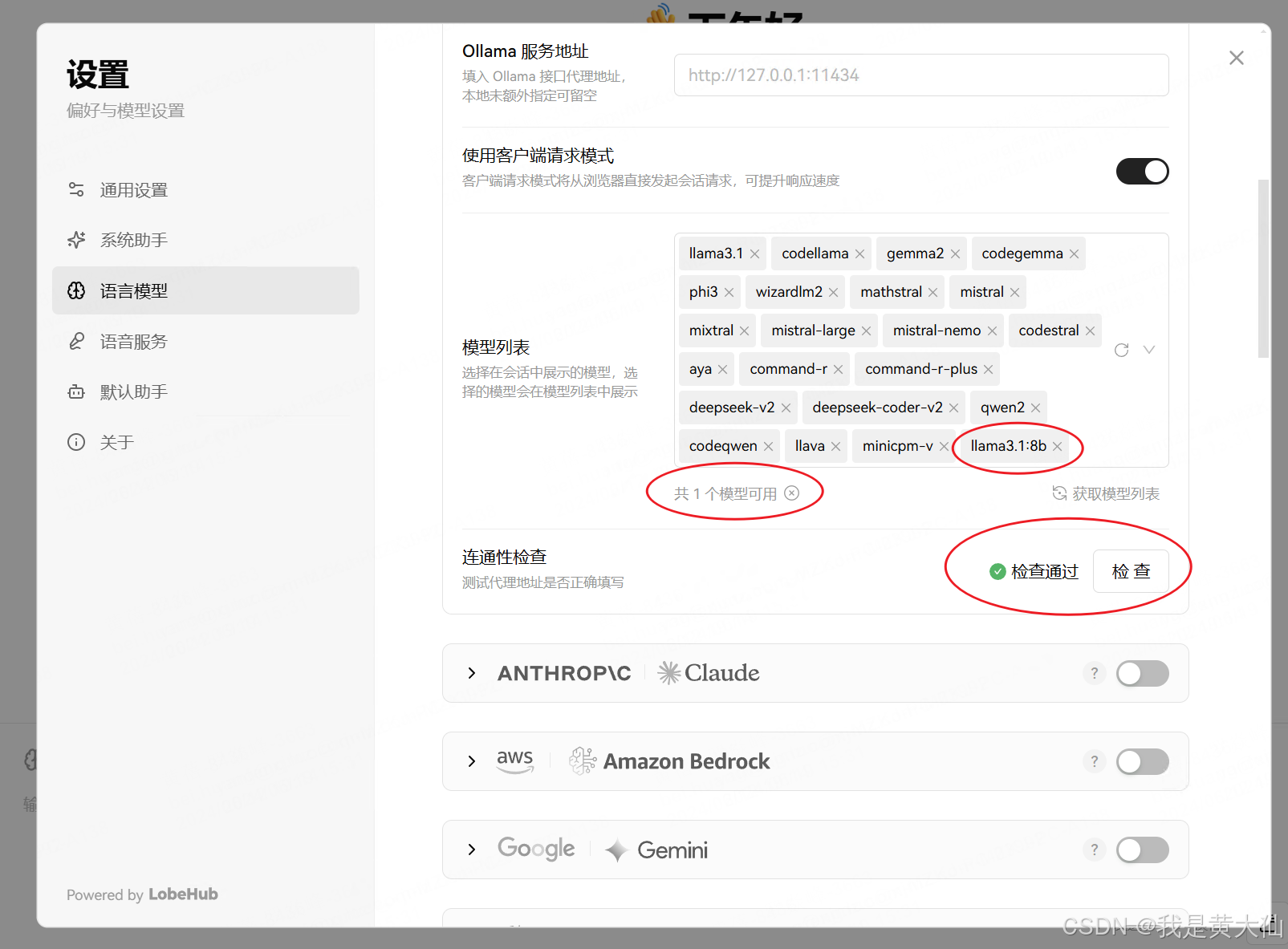

为了方便与AI模型交互,我们可以使用Lobe-chat工具,提供了便捷的测试和本地服务接口。

pnpm install

pnpm devhttp://localhost:3010/,即可看到Lobe-chat的界面,准备与本地模型交互。

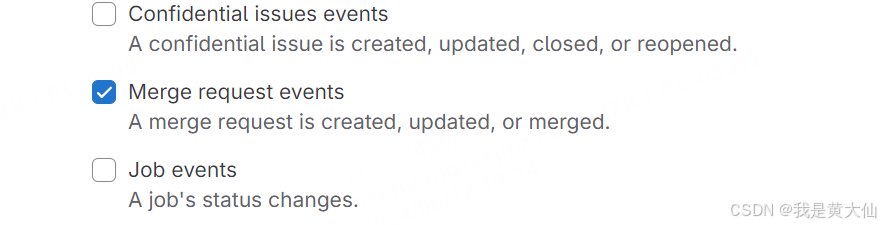

GitLab支持通过Webhook获取代码合并请求的Diff信息,为AI Code Review提供必要的数据输入。

def getDiff(project, mergeRequestId):

token = project['token']

projectId = project['projectId']

webhookUrl = "xxx"

headers = {

"PRIVATE-TOKEN": token

}

response = requests.get(webhookUrl, headers=headers)

text = response.json()

print(response.status_code)

print(response.text)

return text

通过将获取的Diff数据传递给AI模型,我们可以获取代码审查结果,并将其推送给相关人员。

在调用AI接口时,需注意调整以下参数以优化审查效果:

def aiCodeReview(language, diff):

print("start code review")

url = "http://localhost:11434/api/chat"

data = {

"messages": [

{

"content": "你是一个资深的开发人员,非常擅长代码的code review",

"role": "system"

},

{

"content": f"下面是gitlab中一次merge request的差异代码,使用的是{language}语言,请帮忙做一次code review,有问题可以直接指出问题,回答尽可能简洁。{diff}",

"role": "user"

}

],

"model": "llama3.1:8b",

"options": {

"frequency_penalty": 0.8,

"presence_penalty": 0.2,

"temperature": 0.3,

"top_p": 0.9

},

"stream": False

}

headers = {

"Content-Type": "application/json"

}

response = requests.post(url, headers=headers, data=json.dumps(data))

content = response.json()

suggest = content['message']['content']

print(suggest)

return suggest

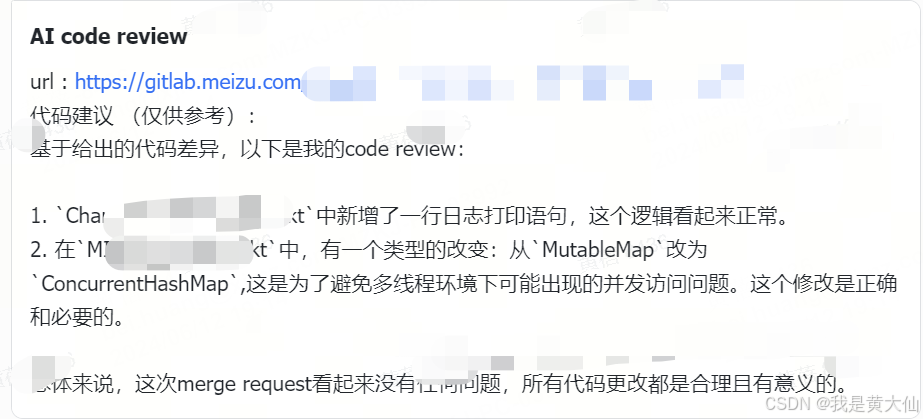

通过AI完成代码审查后,可以通过飞书机器人等工具将结果推送给开发人员,便于及时反馈和改进。

问:如何保证AI Code Review的准确性?

问:AI Code Review是否会对代码安全性造成威胁?

问:AI Code Review能否完全替代人工审查?