如何在Java、Python、GO程序中使用AI人脸识别API接口

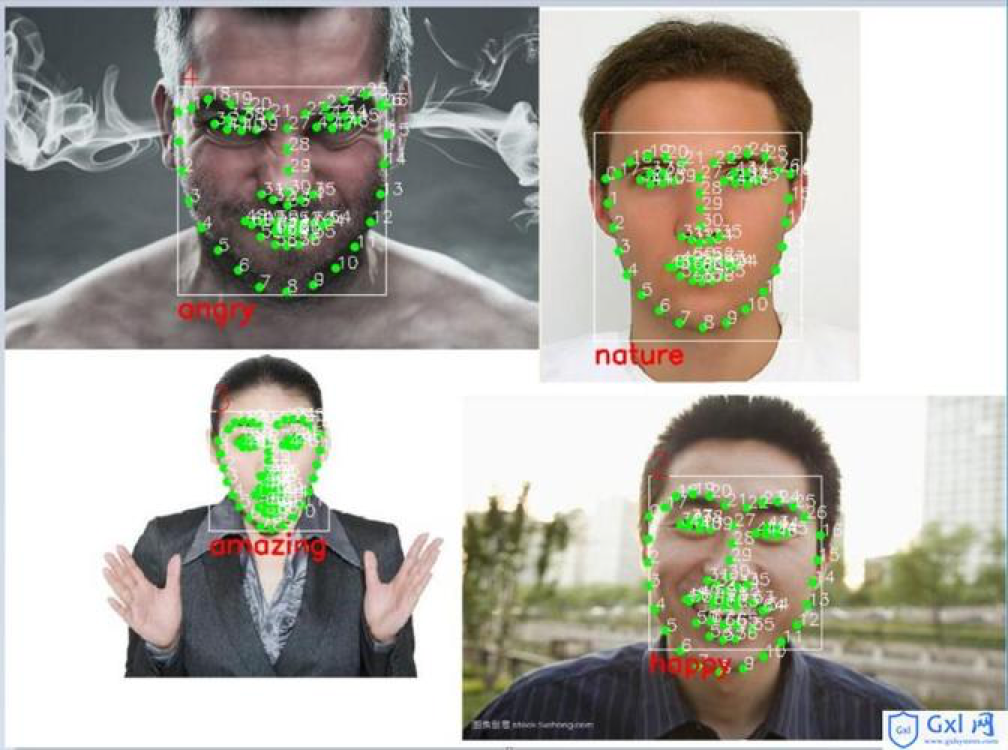

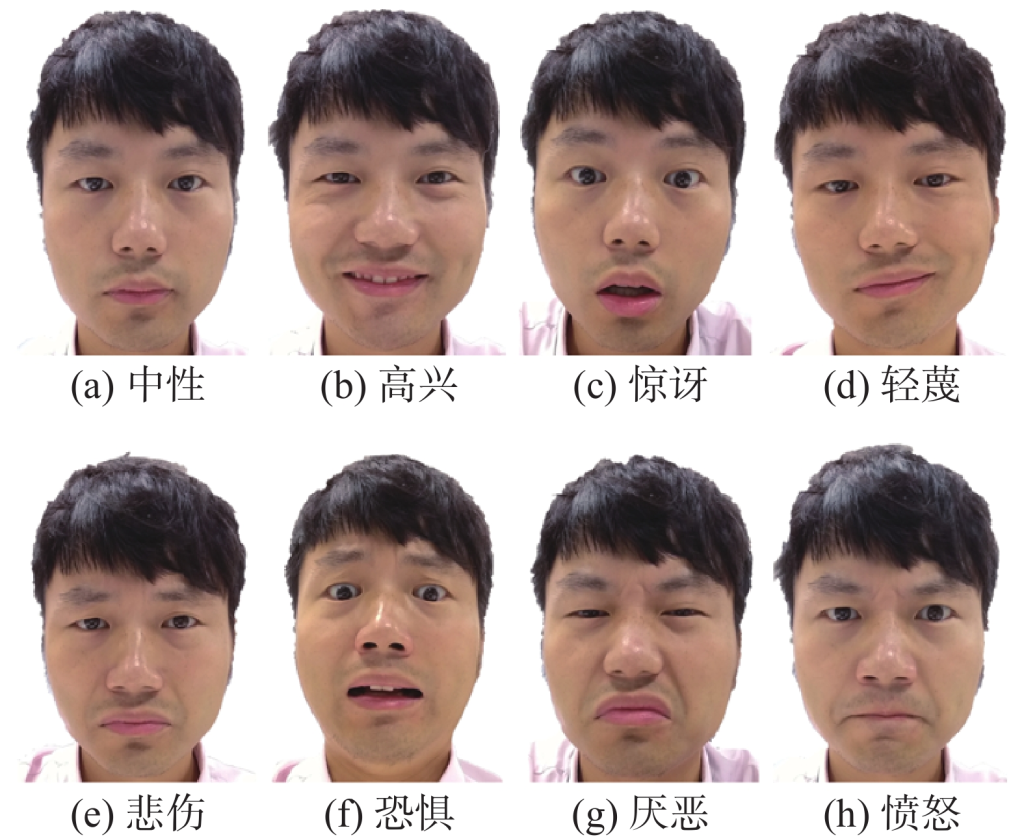

基于人工智能的面部情绪识别API在很多场景都得到了应用,在人们情绪化消费、兴趣化消费的当下,如何察言观色,洞察用户真实的心理活动非常必要,对于大多数的人来说,这事非常有挑战,好在以ChatGPT为代表的大语言模型涌现出了‘初级智慧’,叠加行业数据训练之后,在理解人类情绪也有着出色的表现。幂简集成开放API平台整理了一批AI大模型API、情绪分析API接口供大家使用。

如果开发者不想直接用开放API接口来实现 面部情绪识别 功能,希望自己用Python开发语言定制一个达到同样功能的 面部情绪识别 的简单代码,可以尝试以下步骤。

python -m venv emotion_recognition_env source emotion_recognition_env/bin/activate pip install numpy opencv-python tensorflow keras

face_cascade = cv2.CascadeClassifier('haarcascade_frontalface_default.xml')

这里有一个简单的示例来帮助你开始:

import cv2

from keras.applications.fer2013_mini import FER2013Mini, preprocess_input

from keras.preprocessing import image

import numpy as np

# 加载模型

model = FER2013Mini()

# 加载图像

img_path = 'path_to_your_image.jpg'

img = image.load_img(img_path, target_size=(48, 48))

x = image.img_to_array(img)

x = np.expand_dims(x, axis=0)

x = preprocess_input(x)

# 预测情绪

preds = model.predict(x)

print('预测情绪:', np.argmax(preds[0]))

# 加载面部检测模型

face_cascade = cv2.CascadeClassifier('haarcascade_frontalface_default.xml')

# 读取图像

img = cv2.imread(img_path)

gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)

# 检测面部

faces = face_cascade.detectMultiScale(gray, 1.3, 5)

for (x, y, w, h) in faces:

cv2.rectangle(img, (x, y), (x+w, y+h), (255, 0, 0), 2)

roi_gray = gray[y:y+h, x:x+w]

roi = roi_gray.copy()

roi = cv2.resize(roi, (48, 48))

roi = preprocess_input(roi)

roi = np.expand_dims(roi, axis=0)

preds = model.predict(roi)

cv2.putText(img, 'Emotion: ' + str(np.argmax(preds[0])), (x, y-10), cv2.FONT_HERSHEY_SIMPLEX, 0.9, (36,255,12), 2)

# 显示图像

cv2.imshow('Emotion Recognition', img)

cv2.waitKey(0)

cv2.destroyAllWindows()本案例只是用来学习,并无实际的商业应用价值,请开发者在幂简集成 的 API Hub上搜索’情绪识别’,直接使用这些成熟的商业api,例如: