大语言模型和机器翻译:超个性化时代

大型语言模型 (LLM) 已经风靡全球。

其中一些模型,例如OpenAI 的 GPT-4和谷歌的 PaLM2,已经在多语言数据集上进行了训练,并且至少在理论上也应该能够很好地完成机器翻译任务。

但事实真的如此吗?我们如何充分发挥大型语言模型在机器翻译中的潜力?在这次技术深入探讨中,我们将研究 LLM 在机器翻译环境中的工作原理以及如何将其集成到翻译管理系统 (TMS) 中。

当前的机器翻译模型

目前大多数商用机器翻译工具(例如 Google 翻译)都是基于具有 Transformer 架构的神经模型。这些模型专为一项任务而构建:机器翻译。开箱即用,它们在翻译通用内容所需的任务中已经表现得非常出色。然而,在专门的商业 环境中,它们可能会错过正确的词汇或使用次优风格。

因此,通过训练这些模型识别您的个性化术语和短语,使用额外的业务数据来定制这些模型是很有用的。使用各种定制技术,该模型可以“学习”使用您企业的语气和术语,从而产生更好的机器翻译结果

大型语言模型 (LLM)

大型语言模型通常也基于 Transformer 架构。然而,与上一节中的神经机器翻译 (NMT) 模型相比,它们在更大的文本主体上进行训练,包含更多的模型参数。LLM 包含数十亿个参数,而单任务双语 NMT 模型只有几亿个参数。这使得 LLM 模型在解释用户指令或“提示”时更加灵活和“智能”。这项新技术在使用业务数据进行模型定制方面开辟了许多新的可能性。由于这种方法非常强大,我更喜欢用“个性化”而不是“定制”来谈论。让我们来探索这种个性化是如何运作的。

个性化的双重方法

使用 LLM 时,基本上有两种方法可以对模型进行微调,以便它在推理时(即生成响应时)产生更好的质量。

- 在使用前调整模型的参数(又称“权重”),以便它学会适应您的需求。这是一项资源密集型操作,需要 AI 工程师准备模型的定制版本。

- 使用情境学习。这是一种更简单的技术,当模型通过特别设计的提示生成响应时,它会告知模型您的数据和偏好。

让我们首先研究一下参数调整。

更新 LLM 的参数可能是一项艰巨的任务。请记住,即使是小型 LLM 也有数十亿个参数。更新它们是一项计算成本非常高的任务,通常超出了普通消费者的承受能力,因为这样做的成本和复杂性实在太高了。

对于机器翻译 ,我们通常会从指令调整的 LLM 模型开始。这是一个经过微调的模型,它更有帮助,能够遵循指令,而不是简单地预测下一个单词。经过调整后,该模型将在总结、分类和机器翻译等各种任务上表现更好。我们将在本系列的未来博客文章中提供有关选择哪种模型的更多信息。

指令调优的 LLM 是进一步针对客户进行优化的良好起点。使用一种称为参数高效微调 (PEFT) 的方法,我们可以用客户数据以更短、更经济的方式对指令模型进行微调。

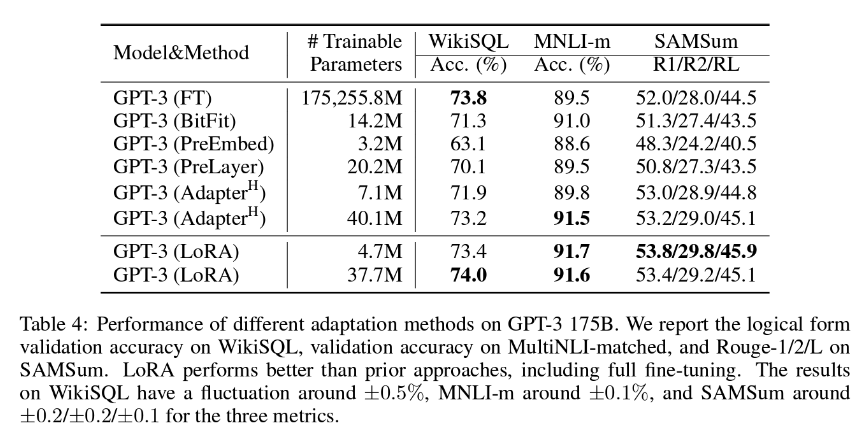

在 LanguageWire,我们首选的 PEFT 方法是 LoRA(低秩自适应),它通常涉及更新约 1.4 – 2.0% 的模型权重。这意味着定制工作是合理的,但也出奇地有效。正如您在下表中看到的,LoRA 论文的作者得出结论,LoRA 甚至比完全调整所有模型参数更有效!

为了从这种方法中获得最佳效果,我们需要访问大量具有匹配源文本和目标文本的高质量训练数据。如果您已经建立了相当大的翻译记忆库,那么它很可能可以用于此目的。LanguageWire AI 团队一直在努力确定 LoRA 调整的理想翻译记忆库大小。

现在让我们讨论第二种方法,即上下文学习或小样本学习。

情境学习是一种让模型根据专门设计的提示引入的少量示例进行动态学习的方法。这种方法也称为小样本学习。

在机器翻译的背景下,小样本学习的工作原理如下:

- 系统会分析传入的源内容。通常,源内容由一个或多个句子或片段组成。

- 系统尝试找到类似的源内容片段及其各自的翻译的例子。

- 系统创建一个提示,其中包括要翻译的源内容和以前翻译的示例。

- LLM 通过实例不断学习,创建高质量的原文翻译。

少样本学习对机器翻译的流畅性、语调和术语合规性有积极影响。它需要使用更少的示例,最多三到五个。事实上,样本量越大效率越低,因此将所有翻译记忆都包含在一个提示中对它没有好处。实验表明,LLM 不能很好地处理大型提示上下文,结果的质量甚至可能会下降!

通过结合 LoRA 和小样本学习的优势,我们可以在大型语言模型中实现强大的优化,最终实现超个性化、高质量的机器翻译。

您的语言数据是关键!

如果没有大量高质量、最新的各种语言对双语文本语料库,这些技术都无法发挥作用。您的翻译记忆库是此数据集的理想来源。

然而,在使用它之前,您必须考虑几个重要方面:

- 质量。所有数据都应是高质量的,最好由合格的人工翻译人员翻译,并在四人工作流程中验证,即由两个人批准。

- 噪音。翻译记忆库中的数据可能并非全部相关。部分数据可能较旧、不相关或涉及已丢弃的产品。定期清理翻译记忆库以删除不相关的材料非常重要。

- 大小。您需要一定的数据量来确保微调效果良好。如果质量保持不变,数据量越大越好。

如果您使用 LanguageWire 平台,自动化翻译记忆库管理模块将为您处理这些方面,无需任何手动操作。

如果您有现有的外部翻译记忆库,并希望将其用于我们的平台和机器翻译服务,我们的工程师可以帮您实现这一目标。LanguageWire 工程师创建了导入 API、清理脚本和语言质量评估工具,以帮助您充分利用最宝贵的语言资产。

LanguageWire 解决方案

那么,我们如何将所有这些整合到一个典型的翻译项目中呢?让我们来看一个例子。

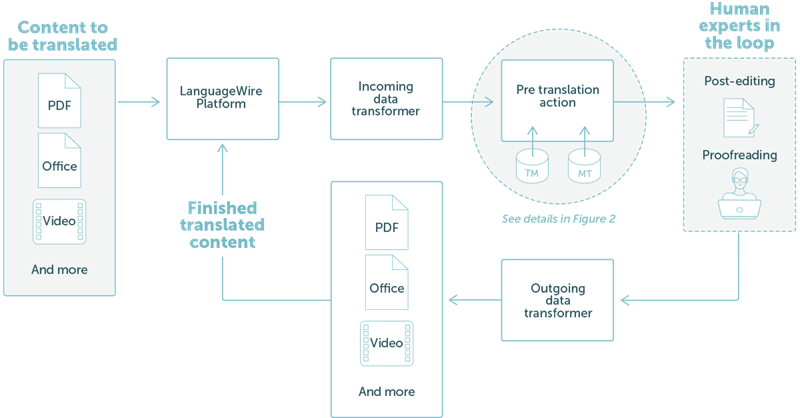

LanguageWire 提供的解决方案与我们的技术生态系统完全集成。下图 1 中高级步骤对此进行了演示。

在此示例中,我们采用了一个简单的工作流程,客户想要翻译 PDF 或办公文件。用户只需使用 LanguageWire 项目门户上传内容文件即可。从此,一切都自动安排好了:

- 对传入的数据进行分析并将其转换为 XLIFF 文件。

- 该系统根据翻译记忆库匹配和机器翻译创建预翻译。

- 我们的人工专家社区提供后期编辑和校对服务。

- 下一步,翻译后的 XLIFF 将被重新组合成输出文件,并保留布局。

- 最后,客户可以从门户网站下载翻译后的文件。

图 1:现有 LanguageWire 平台结果中的简单翻译项目

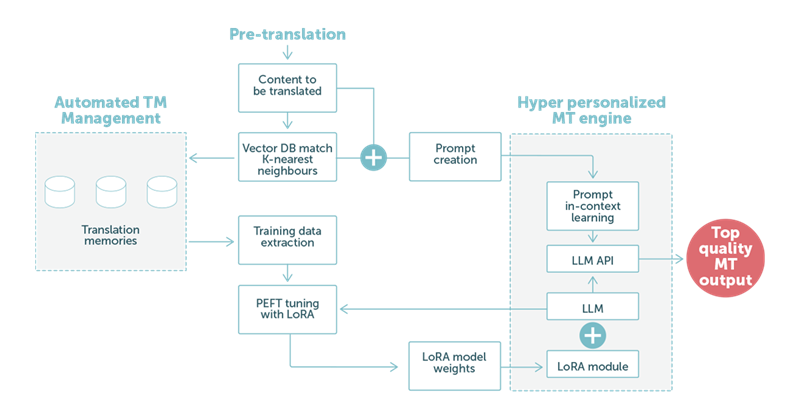

在示例 2 中,我们重点关注使用基于 LLM 技术的机器翻译的预翻译步骤。如下图 2 所示,客户的语言数据起着核心作用。

- 对于每段文本,LanguageWire 系统都会在翻译记忆库中找到“K 个最近邻” 。这些双语结果被用作特殊小样本学习提示的基础,并传递给 LLM 的机器翻译 API。

- 在模型层,我们加载了一个 LoRA 模块,该模块可根据客户的语调和词汇量定制 LLM。同样,这是基于从翻译记忆库编译的数据集。我们将该数据集应用于使用 LoRA 的 PEFT 调整,以创建加载到模型上下文中的新模型权重。这种调整可以定期进行,例如每两周一次,以反映 TM 中的新更新和内容。

图 2:使用大型语言模型、混合 LoRA 定制和优化的上下文学习提示的翻译示例。

当我们专门设计的提示由 LLM 处理时,LoRA 模块中的自定义权重将有助于获得高质量的机器翻译 输出。完成后,此输出将自动进入流程的下一步。通常,这将是一项后期编辑任务,由人类专家参与,以实现最高的最终质量。

这对我们的客户意味着什么?

简而言之:我们的客户可以期待更好的机器翻译。机器翻译可以自动适应不同的环境,例如不同的垂直行业,并与该垂直行业的预期语气和用词选择保持一致。

这不仅可以降低译后编辑的成本,还可以提高翻译的交付速度。它还将为直接使用机器翻译输出开辟更广泛的空间,而无需人工专家参与。

LanguageWire 还对 LLM 做了什么?

正如我们之前提到的,大型语言模型非常灵活。LanguageWire AI 团队正在研究许多其他可以从 LLM 技术中受益的领域。

我们目前正在研究:

自动语言质量评估。LLM 可以检查人类专家的翻译或另一个模型的机器翻译输出并给出质量评分。这可以大大降低校对成本。底层的机器翻译质量评估 (MTQE) 技术也可以应用于其他用例。

内容创作助手。通过结合使用 PEFT 与 LoRA 和少样本学习,我们可以个性化 LLM 模型,使其专注于内容创作任务。客户可以提供关键字和元数据,让模型生成使用业务定制的语气和词汇选择的文本。

最新文章

- API测试用例编写指南:示例与最佳实践

- 如何获取企查查开放平台 API Key 密钥(分步指南)

- 19个API安全最佳实践,助您实现安全

- 如何免费调用Kimi API实现项目集成

- 探索 Zomato API 的潜力

- 使用 ChatGPT 和 json-server 快速实现 mock API

- 使用NestJS和Prisma构建REST API:处理关系型数据

- 实时追踪风暴巨兽:台风信息API如何助你掌控自然之力

- 监控使用 Apollo 和 Express 构建的 GraphQL API

- 什么是SDK?避免技术沟通陷阱

- 如何获取天地图开放平台 API Key 密钥(分步指南)

- 什么是API测试?类型、工具及执行方法