如何获取ChatGLM API Key 密钥(分步指南)

文章目录

在自然语言处理和智能对话生成领域,ChatGLM API 提供了一种高效的解决方案,能够支持多样化的语言生成任务。通过使用 ChatGLM API,开发者可以轻松集成强大的对话生成功能,为用户提供更智能的交互体验。本指南将为你介绍如何获取 ChatGLM API 密钥,并进行初步的可用性测试,同时探讨在使用过程中需要考虑的其他关键因素。

1. 获取ChatGLM API秘钥步骤

获取ChatGLM API密钥的过程相对简单,只需几个步骤即可完成:

1.访问官方网站:https://open.bigmodel.cn/

2.“注册/登录”:点击智谱AI大模型开放平台页面右上角“注册/登录”按钮,注册并完善信息。(新用户享受 2000免费Tokens资源包400次图像和视频资源包)

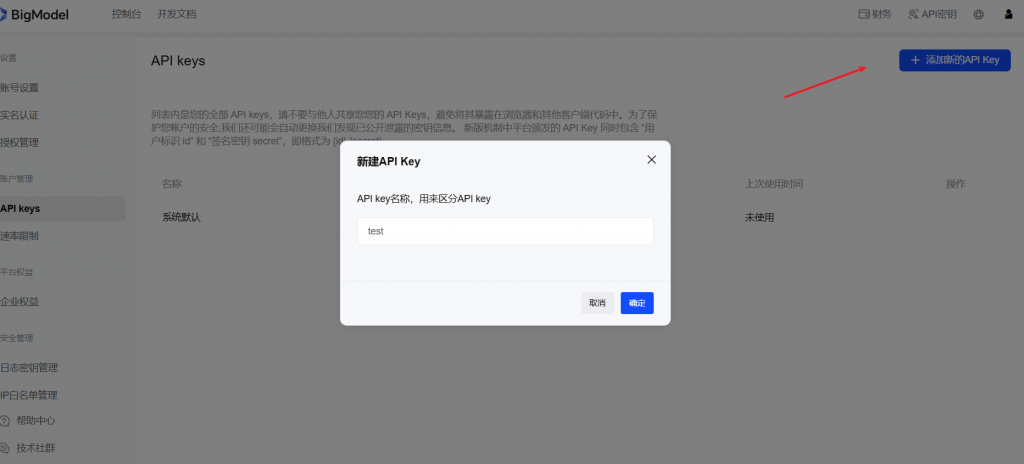

3.新建API密钥:点击页面右上角控制台>API密钥页面中右上角"添加新的API Key"

3.新建API密钥:点击页面右上角控制台>API密钥页面中右上角"添加新的API Key"

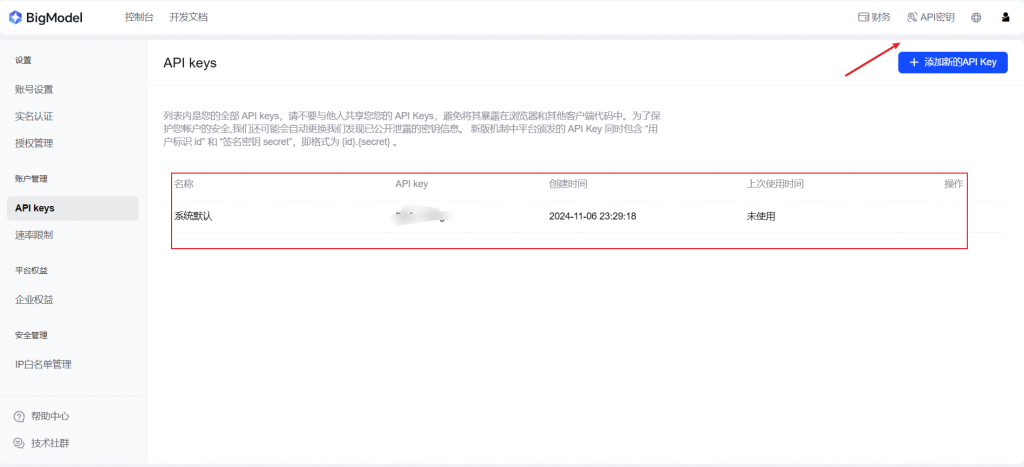

4.查看API密钥:点击页面右上角控制台>API密钥(注意:必须实名认证密钥才能生效)

4.查看API密钥:点击页面右上角控制台>API密钥(注意:必须实名认证密钥才能生效)

5.实名认证: 点击左侧导航栏中的实名认证,按照步骤提交个人或企业信息。认证通过以后API密钥就会生效

5.实名认证: 点击左侧导航栏中的实名认证,按照步骤提交个人或企业信息。认证通过以后API密钥就会生效

2. ChatGLM API秘钥可用性测试

在Python进行测试的一个案例:

输入:

import time

from zhipuai import ZhipuAI

client = ZhipuAI(api_key="")

# 请填写您自己的APIKey

response = client.chat.asyncCompletions.create(

model="glm-4",# 请填写您要调用的模型名称

messages=[

{

"role": "user",

"content": "

作为童话之王,请以始终保持一颗善良的心为主题,写一篇简短的童话故事。故事应能激发孩子们的学习兴趣和想象力,同时帮助他们更好地理解和接受故事中蕴含的道德和价值观。"

}

],

)

task_id = response.id

task_status = ''

get_cnt = 0

while task_status != 'SUCCESS' and task_status != 'FAILED' and get_cnt <= 40:

result_response = client.chat.asyncCompletions.retrieve_completion_result(id=task_id)

print(result_response)

task_status = result_response.task_status

time.sleep(2)

get_cnt += 1输出:

你将得到一个JSON格式的响应,其中包含了详细信息,如当前对话的模型输出内容、模型名称、用户输入的token数量、模型输出的token数量、搜索结果的网页链接、搜索结果的标题等。

示例输出:

{"id":"123456789","request_id":"123123123","model":null,"task_status":"PROCESSING"}

{"id":"123456789","request_id":"123123123","model":null,"task_status":"PROCESSING"}

... ...

{"id":"123456789","request_id":"123123123","model":null,"task_status":"PROCESSING"}

{

"id": "123456789",

"request_id": "123123123",

"model": "glm-4",

"task_status": "SUCCESS",

"choices": [

{

"index": 0,

"finish_reason": "stop",

"message": {

"content": "从前,有一个美丽的村庄,那里的孩子们都喜欢一起玩耍、学习和探索。其中有一个小男孩叫小明,他有一颗善良的心,总是乐于帮助别人。

一天,小明在森林里发现了一只翅膀受伤的小鸟,无法飞翔。小明心疼这只小鸟,便把它带回家,用温暖和爱心照顾它。在小明的细心照料下,小鸟的翅膀渐渐康复,开始在房间里飞来飞去。

看到小鸟奇迹般的康复,小明对鸟类产生了浓厚的兴趣,想要了解更多关于鸟类的知识。他开始阅读有关鸟类的书籍,学习它们的习性和生活方式。通过学习,小明对鸟类有了深刻的了解,他和那只小鸟也建立了深厚的友谊。

一天,小明在森林里散步时,发现了一只被困在猎人陷阱里的小兔子。小明毫不犹豫地救出了小兔子。小兔子感激地看着小明,并告诉他森林里有一个神秘的宝藏——一颗能实现愿望的魔法宝石。

充满好奇心的小明决定去寻找这颗宝石。他带着小鸟和小兔子踏上了冒险之旅。在旅途中,他们遇到了许多挑战,但小明始终保持着善良的心,勇敢地面对每一个困难。他不仅学会了如何与森林里的动物相处,还学会了许多生存技能。

经过一段时间的努力,小明终于找到了那颗魔法宝石。宝石发出耀眼的光芒,将小明和他的朋友们带到了一个美丽的世界。在那里,他们遇到了一位智慧的老人,老人告诉小明,宝石的力量来自于一个人的善良之心。只有拥有善良之心的人才能激活宝石的力量,实现自己的愿望。

小明明白了这个道理,感谢了老人,带着宝石回到了现实世界。他用宝石的力量帮助他人,让村庄变得更加美好。小明成为了村庄里的榜样,通过他的行动,孩子们明白了始终保持一颗善良的心的重要性。

从此以后,小明和村民们幸福地生活在一起。听过小明故事的孩子们明白了善良之心的重要性。他们以小明为榜样,努力成为一个有爱心、有责任感的人。在这个过程中,他们的学习兴趣和想象力也被激发,成长为优秀的孩子。

这个故事告诉我们,始终保持一颗善良的心,用我们的行动去影响周围的人。只有拥有善良之心的人,才能解锁自己的潜力,实现梦想。让我们都努力成为一个有善良之心的人。",

"role": "assistant",

"tool_calls": null

}

}

],

"usage": {

"prompt_tokens": 52,

"completion_tokens": 470,

"total_tokens": 522

}

}3. 使用ChatGLM API搭建应用的其他关键考虑因素

在使用ChatGLM API搭建应用时,除了获取和测试API密钥外,还需考虑以下因素:

内容安全

智谱AI致力于做到人工智能的安全可控、可审计、可监督、可追溯和可信赖。为此,我们内置了安全审核机制,旨在减少模型应用中违法及不良信息(包括但不限于违反法律法规、危害国家安全、恶意营销、涉黄、谩骂、暴恐违禁以及其它不良内容)的出现。当我们的内置安全审核机制识别到违法及不良信息时,将提供相应的提示信息或进行拦截处置,例如通过输入拦截、输出限制和终止内容生成。

速率限制

用户的API使用会受到速率限制,当前我们限制的维度是请求并发数量。我们基于用户的月度 API 调用消耗金额情况将速率控制分为6种等级。

消耗金额选取逻辑

我们会选取用户当前月份1号~t-1日的调用 API 推理消耗总金额和用户上个月的 API 调用消耗总金额做比较,取更高金额作为用户当前的 API 消耗金额。

说明:若您从未曾付费充值/购买过资源包,则会归为免费级别。

- 免费:api调用消耗0元-50元/每月(不含)

- 用量级别1:api调用消耗50元-500元/每月(不含)

- 用量级别2:api调用消耗500元-5000元/每月(不含)

- 用量级别3:api调用消耗5000元-10000元/每月(不含)

- 用量级别4:api调用消耗10000元-30000元/每月(不含)

- 用量级别5:api调用消耗30000元以上/每月

速率限制级别

语言模型

| 模型名称 | 免费 | 用量级别1 | 用量级别2 | 用量级别3 | 用量级别4 | 用量级别5 |

|---|---|---|---|---|---|---|

| GLM-4-Plus | 20 | 100 | 200 | 300 | 400 | 500 |

| GLM-4-0520 | 20 | 30 | 40 | 50 | 80 | 100 |

| GLM-4-Air | 100 | 150 | 200 | 500 | 1000 | 1500 |

| GLM-4-FlashX | 50 | 100 | 200 | 300 | 400 | 500 |

| GLM-4-Flash | 200 | 300 | 500 | 800 | 1000 | 1500 |

| GLM-3-Turbo | 5 | 50 | 70 | 150 | 300 | 1000 |

| GLM-4 | 5 | 10 | 20 | 30 | 100 | 200 |

| GLM-4-AllTools | 5 | 10 | 15 | 20 | 25 | 30 |

| GLM-4-Assistant | 5 | 10 | 15 | 20 | 25 | 30 |

| GLM-4-AirX | 5 | 10 | 15 | 20 | 25 | 30 |

| GLM-4-Long | 5 | 10 | 15 | 20 | 25 | 30 |

多模态模型

| 模型名称 | 免费 | 用量级别1 | 用量级别2 | 用量级别3 | 用量级别4 | 用量级别5 |

|---|---|---|---|---|---|---|

| GLM-4V-Plus | 2 | 10 | 15 | 20 | 25 | 30 |

| GLM-4V | 5 | 10 | 20 | 30 | 50 | 100 |

| CogView-3-Plus | 5 | 10 | 15 | 20 | 30 | 40 |

| CogView-3 | 5 | 10 | 15 | 20 | 30 | 40 |

| CogVideoX | 2 | 10 | 15 | 20 | 25 | 30 |

向量模型

| 模型名称 | 免费 | 用量级别1 | 用量级别2 | 用量级别3 | 用量级别4 | 用量级别5 |

|---|---|---|---|---|---|---|

| Embedding-2 | 5 | 10 | 20 | 30 | 40 | 50 |

| Embedding-3 | 50 | 100 | 200 | 300 | 400 | 500 |

模型工具

| 模型名称 | 免费 | 用量级别1 | 用量级别2 | 用量级别3 | 用量级别4 | 用量级别5 |

|---|---|---|---|---|---|---|

| Web-Search-Pro | 1 | 2 | 3 | 4 | 5 | 6 |

其他模型

| 模型名称 | 免费 | 用量级别1 | 用量级别2 | 用量级别3 | 用量级别4 | 用量级别5 |

|---|---|---|---|---|---|---|

| CharGLM-3 | 5 | 10 | 20 | 30 | 40 | 50 |

| CodeGeeX-4 | 5 | 10 | 20 | 30 | 100 | 200 |

4. ChatGLM API密钥申请和使用中的常见问题

在申请和使用 ChatGLM API密钥过程中,你可能会遇到以下常见问题:

1. 同步、异步、SSE调用方式有什么区别?

同步、异步、SSE调用是三种不同的 API 响应方式。

- SSE调用:客户发起请求后,可以流式的实时获取到模型生成的内容直到推理结束,类似于智谱清言APP上的打字机效果。该调用方式适用于对首响及响应时长要求较高的场景,如和用户直接进行交互的智能客服、对话闲聊等。我们推荐您使用SSE调用,用户体验更好。

- 同步调用:客户发起请求,模型完成推理后一次性返回全量生成结果。

- 异步调用:客户发起请求后,需要用户调用异步接口结果查询模型处理状态和推理结果,如处理完成,可通过结果查询接口获取到模型生成结果。该调用方式适用于对响应时间不敏感的业务场景,如批量处理数据、批量生成文章等。

2. 函数调用,知识库检索,网络搜索可以全部添加到tools参数里吗?

函数调用、知识库检索、网络搜索,3个功能互斥。如果同时使用,按照优先级只会生效一个。优先级顺序为:函数调用>知识库检索>网络搜索。

3.模型微调怎么做??

目前可通过提交 模型微调接口文档 开发者 Pro 版平台服务权益申请 获得 GLM-4-Flash 模型微调权限,其他模型的微调能力会陆续迭代。开通权限后可通过模型微调接口文档了解调用详情。

您也可以购买我们的云端私有化服务,获得私有化部署及模型微调服务,请随时 联系我们,我们的咨询顾问将为您详细介绍。

4.开放平台如何计费?

- 我们的计费方式是以 token 为单位(图像大模型按照模型产出的图片数量计费),每个 token 代表一个自然语言文本的基本单位,如“字”或“词”。

- 我们会根据您的模型输入和输出的总 token 数进行计费(向量大模型embedding-2仅按照输入token量计费)。如果您开启了搜索服务,搜索结果作为输入也会被计费。

- 我们支持两种扣减方式:费用扣减和资源包扣减。费用扣减是根据 token 使用量×模型单价从您的现金余额账户中扣除,模型单价可参考 产品定价。资源包扣减则是根据 token 使用量从您的资源包账户扣除。在扣除时,我们会优先扣除资源包账户,然后再扣除现金余额账户。

5. ChatGLM API进阶指引

在获得ChatGLM API密钥之后,即可开启API接口对接,本文整理了多篇使用ChatGLM-4 API的案例,帮助读者更有效地使用ChatGLM API:

通用搜索

__启用与禁用 web_search__

通用搜索 web_search 工具通过网络搜索获取信息,以增强语言模型输出的质量和时效性。

网络搜索功能默认为关闭状态(False)。当启用搜索(设置为 True)时,系统会自动判断是否需要进行网络检索,并调用搜索引擎获取相关信息。检索成功后,搜索结果将作为背景信息输入给大模型进行进一步处理。每次网络搜索大约会增加1000个 tokens 的消耗。

返回搜索来源

启用 search_result 参数允许用户获取详细的网页搜索来源信息,包括来源网站的图标、标题、链接、来源名称以及引用的文本内容。

自定义搜索内容

使用 search_query 参数可以自定义搜索内容,提升搜索结果的相关性和精确度。 如果不传 search_query 参数,系统将根据用户的消息自动进行网页检索。

以下是一段使用通用搜索的请求示例:

from zhipuai import ZhipuAI

client = ZhipuAI(api_key="您的APIKey")

tools = [{

"type": "web_search",

"web_search": {

"enable": True, #默认为关闭状态(False) 禁用:False,启用:True。

"search_result": True,

# 禁用False,启用:True,默认为禁用

"search_query": "自定义搜索的关键词"

}

}]

messages = [{

"role": "user",

"content": "中国 2024 年一季度的GDP是多少 "

}]

response = client.chat.completions.create(

model="glm-4",

messages=messages,

tools=tools

)

print(response.choices[0].message)6. 常见问题

问题1: 什么是幂简集成平台?

幂简集成是蜜堂有信在2023年打造的一款SAAS产品,建设着国内最全的API平台,为开发者提供全面、高效、易用的API集成管理方案,一站搜索、试用、集成国内和国外API。让用户在AI时代全方位接入互联网,用API连接一切服务和算力,实现价值倍增。

问题2:如何找到ChatGLM API

幂简API平台可以通过以下两种方式找到所需API:通过关键词搜索API(例如,输入’ChatGLM API‘这类品类词,更容易找到结果)、或者从API hub分类页进入寻找。

问题3:ChatGLM API的替代品有哪些?

市场上存在免费、付费两种替代者

例如

更多竞品可以在智谱AI开放平台找到。

7. 总结

本文为您详细介绍了如何获取 ChatGLM API 密钥,并提供了基于 Python 进行 API 可用性测试的示例代码。此外,还深入探讨了如何在使用过程中考虑其他关键因素,包括启用网络搜索功能、自定义搜索内容、以及确保内容的安全性。我们还介绍了 ChatGLM API 的速率限制、计费方式及常见问题,帮助您在使用过程中避免常见问题,并提高使用效率。

最新文章

- 通过 Python 集成 英语名言 API 打造每日激励小工具,轻松获取每日名言

- 来自 openFDA、DailyMed、RxNorm、GoodRx、DrugBank、First Databank 等的药物和药物数据 API

- API设计:从基础到最佳实践

- 实战 | Python 实现 AI 语音合成技术

- Snyk Learn 全新 API 安全学习路径:掌握 OWASP API 前十风险与防护策略

- Document Picture-in-Picture API 实战指南:在浏览器中实现浮动聊天窗口

- 什么是变更数据捕获?

- AI 推理(Reasoning AI):构建智能决策新时代的引擎

- Python应用 | 网易云音乐热评API获取教程

- 22条API设计的最佳实践

- 低成本航空公司的分销革命:如何通过API实现高效连接与服务

- 实时聊天搭建服务:如何打造令人着迷的社交媒体体验?